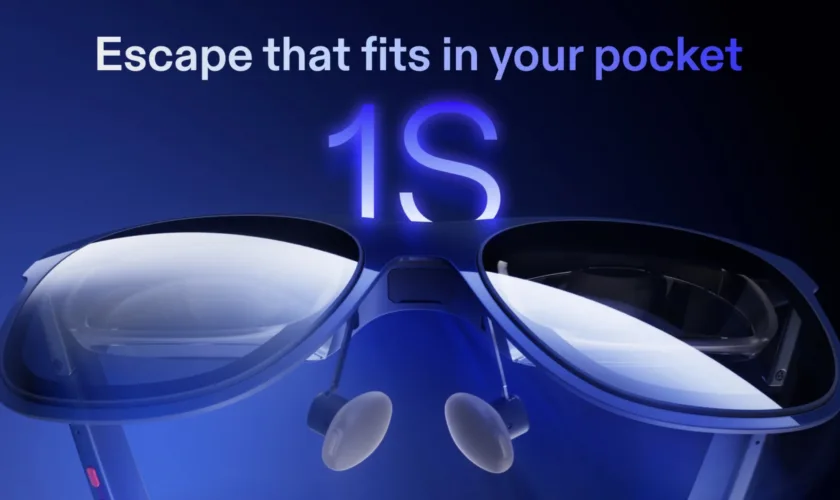

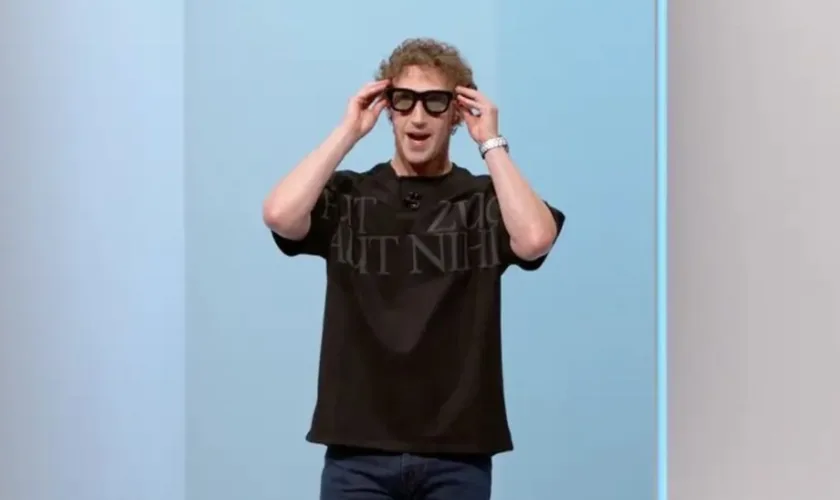

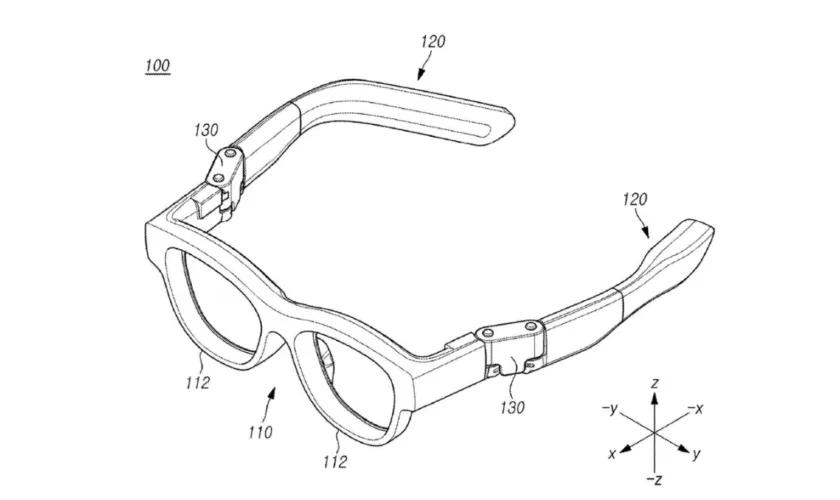

Et si votre moniteur de bureau devenait entièrement portable — et invisible pour les autres ? Avec ses nouvelles lunettes de réalité augmentée XREAL 1S et le hub externe Neo, la marque pousse encore plus loin sa vision d’un écran géant personnel, utilisable partout, avec n’importe quel appareil.

Présentée au CES 2026, cette évolution marque un tournant discret mais stratégique pour l’informatique nomade.

XREAL affine une idée déjà radicale

Révélées lors du CES 2026, les nouveautés de XREAL s’inscrivent dans la continuité d’un concept simple mais puissant : remplacer les écrans physiques par une dalle virtuelle projetée directement dans le champ de vision.

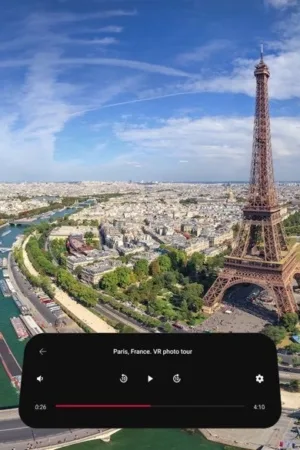

Le précédent modèle, le XREAL One, simulait déjà un écran de 147 pouces flottant devant l’utilisateur, connecté via USB-C à un PC, un MacBook, un smartphone, une tablette ou une console portable. Une solution idéale pour travailler, jouer ou regarder des films sans s’encombrer.

XREAL 1S : plus grand, plus lumineux, plus immersif

Le nouveau XREAL 1S apporte des améliorations mesurées mais significatives :

- Taille d’écran virtuelle par défaut portée à 171 pouces

- Format 16:10, plus adapté à la productivité

- Extension possible jusqu’à 500 pouces

- Formats ultra-larges disponibles : 21:9 et 32:9

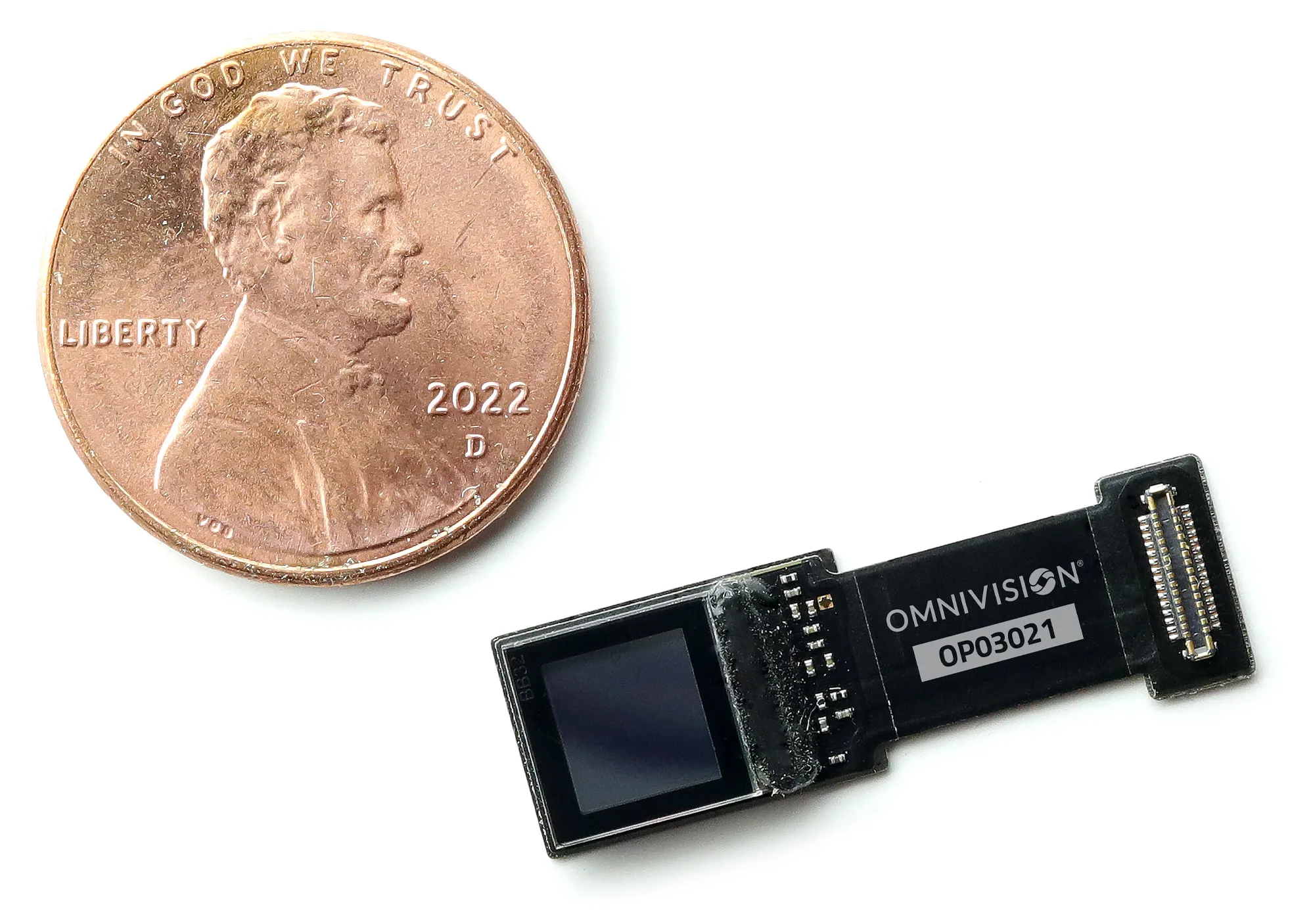

- Luminosité maximale de 700 nits (contre 600 auparavant)

- Résolution 1200p

- Taux de rafraîchissement inchangé à 120 Hz

À l’usage, cela se traduit par une image plus confortable, mieux définie et plus polyvalente, aussi bien pour le multitâche que pour le jeu ou le cinéma.

Du simple écran flottant à l’ancrage spatial

Les XREAL 1S ne se contentent pas d’afficher une image géante. Grâce au suivi 3DoF, l’écran peut être ancré dans l’espace, à la manière des fenêtres flottantes d’un Meta Quest, de l’Apple Vision Pro ou du futur Galaxy XR de Samsung.

En option, le module XREAL Eye ajoute un capteur caméra permettant un suivi 6DoF plus précis, la capture photo et vidéo, et une stabilité renforcée de l’écran virtuel dans l’environnement réel.

On se rapproche ici d’un usage mixte entre moniteur virtuel et informatique spatiale légère.

XREAL Neo : le chaînon manquant de l’écosystème

L’autre annonce clé concerne le XREAL Neo, un hub externe avec batterie intégrée de 10 000 mAh. Il répond à deux limites majeures des lunettes AR actuelles :

- L’autonomie : possibilité d’utiliser les lunettes pendant de longues sessions sans vider le smartphone ou la console connectée.

- La compatibilité vidéo : prise en charge des appareils dépourvus de DisplayPort Alt Mode natif.

Grâce à Neo, les XREAL 1S deviennent compatibles avec la Nintendo Switch (et Switch 2), sans station d’accueil. Résultat, des jeux affichés en 1080p jusqu’à 120 Hz, contre 720p sur l’écran intégré, et pour le Steam Deck, affichage jusqu’en 1200p à 120 Hz.

Un gain net en confort visuel et en immersion pour le jeu nomade.

Prix et disponibilité : une AR plus accessible

Bonne surprise : XREAL ajuste aussi sa politique tarifaire.

- XREAL 1S : 499 euros

- XREAL Neo : 100 dollars

Les deux produits sont disponibles immédiatement via Amazon, Best Buy et la boutique officielle XREAL.

Avec les XREAL 1S et Neo, la marque ne cherche pas à concurrencer frontalement les casques de réalité mixte lourds et coûteux. Elle affine au contraire une proposition plus discrète : un écran géant personnel, toujours disponible, compatible avec l’écosystème existant.

À mesure que les ordinateurs, consoles et smartphones deviennent plus puissants — mais aussi plus compacts — ce type d’affichage pourrait bien devenir la nouvelle norme pour le travail et le divertissement mobile. Sans casque, sans isolation complète, sans installation.

Et si, finalement, le futur de l’écran passait… par des lunettes presque ordinaires ?