Lors de l’événement Samsung Galaxy Unpacked à Paris, où ont été présentés de nouveaux gadgets comme le Samsung Galaxy Z Flip 6, le Galaxy Z Fold 6, la Galaxy Watch Ultra et la Galaxy Ring, Google a également été invité pour parler de l’IA Gemini.

Dans un moment presque furtif, Google a réaffirmé ses projets pour sa plateforme XR, englobant la réalité virtuelle (VR), la réalité augmentée (AR) et la réalité mixte (MR). Le président de Samsung et responsable de la division Mobile Experience (MX),TM Roh, a annoncé que les fruits du partenariat entre Samsung et Google dans le domaine de la XR seront dévoilés « cette année ».

Dans les derniers instants de la diffusion, le président de la division mobile de Samsung est monté sur scène pour clôturer le spectacle. Roh a commencé par remercier Rick Osterloh de Google et son équipe pour leur partenariat continu. C’est à ce moment-là que Roh a révélé que la plateforme XR de Samsung serait lancée plus tard dans l’année :

J’apprécie Rick et son équipe chez Google pour leur partenariat constant qui alimente l’innovation et ouvre de nouvelles possibilités, comme notre nouvelle plateforme XR qui sera lancée cette année.

Étant donné que nous sommes déjà à plus de la moitié de l’année 2024, Samsung et Google doivent accélérer le rythme. On peut estimer que des annonces seront faites lors de la Samsung Developer Conference (SDC) prévue le 3 octobre 2024. Mais que pouvons-nous attendre de cet événement ?

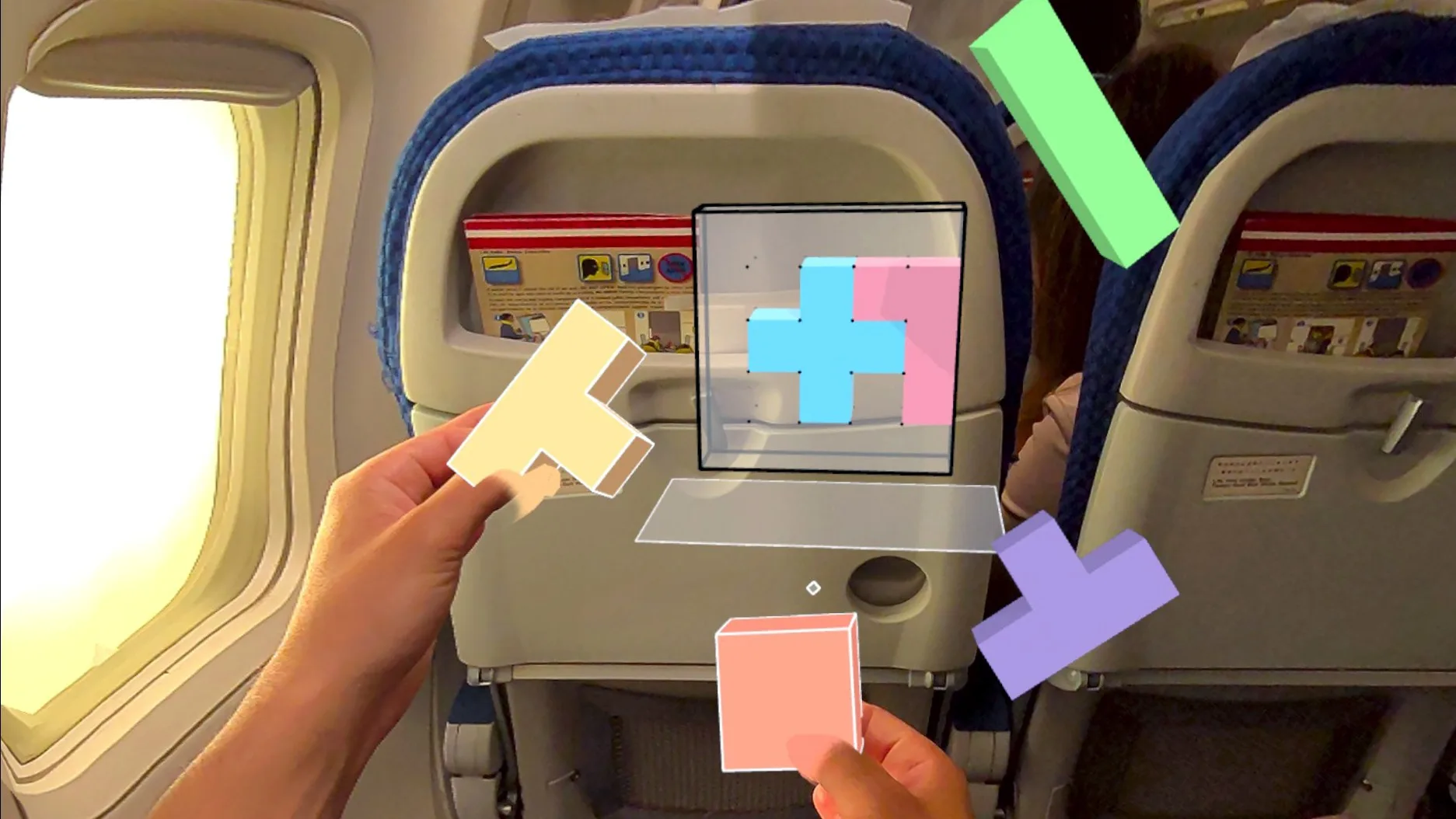

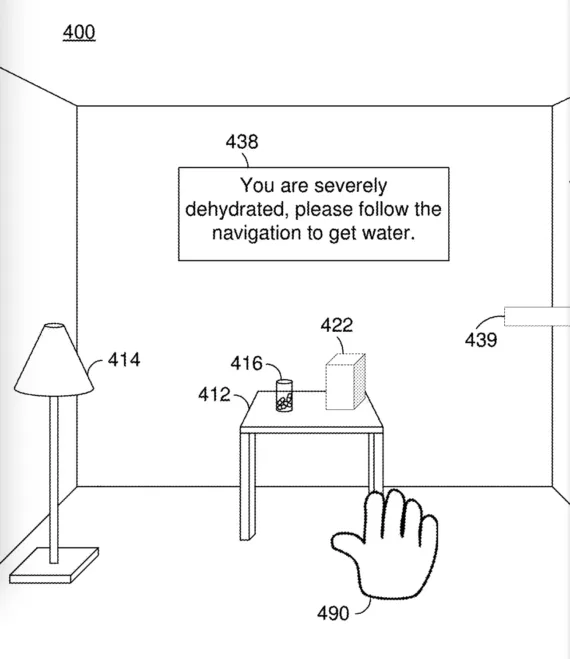

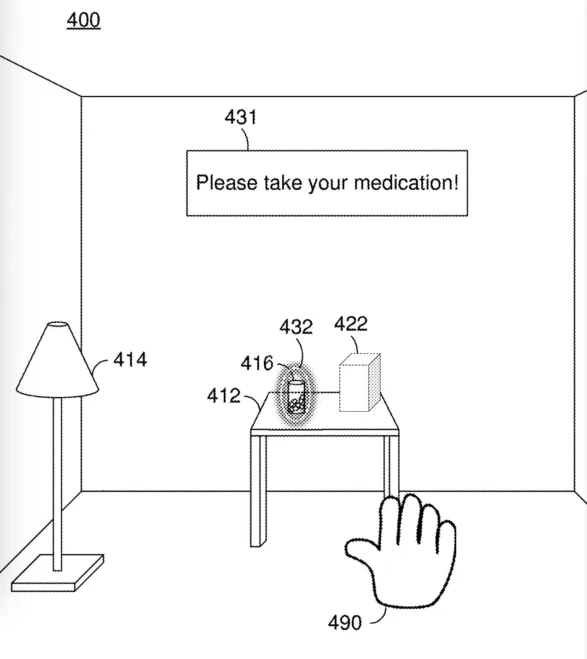

Google et Samsung ont précédemment suggéré la sortie d’un appareil physique axé sur la XR, ce qui semble logique. Une nouvelle plateforme XR nécessite un dispositif pour l’utiliser. Cela pourrait être un casque XR Samsung, voire des lunettes.

Une réponse à VisionOS et HorizonOS par Samsung et Google ?

En ce qui concerne la plateforme XR elle-même, on peut imaginer qu’elle sera la réponse d’Android à VisionOS d’Apple et à HorizonOS de Meta. Ce dernier est un concurrent particulièrement redoutable ; Meta a passé des années à peaufiner ce qui est facilement le meilleur système d’exploitation XR en termes de logiciel et d’utilisabilité. Meta a également annoncé que HorizonOS apparaîtra bientôt sur des casques non-Meta Quest, notamment ceux d’Asus, Lenovo et Xbox.

Samsung et Google devront donc présenter quelque chose de spécial tant sur le plan matériel que logiciel. Sinon, toute cette montée en puissance depuis la première annonce de la plateforme XR en février 2023 n’aura servi à rien.