Google vient d’annoncer plusieurs mises à jour pour la version gratuite de son chatbot Gemini, avec notamment l’intégration de son modèle multimodal à faible latence, Gemini 1.5 Flash, et l’ajout de liens sources pour réduire les hallucinations.

Précédemment réservé aux développeurs, Gemini 1,5 Flash est désormais accessible au grand public dans la version gratuite de Gemini, dans l’application mobile et dans l’interface Web à l’adresse gemini.google.com. Ce modèle est idéal pour les tâches nécessitant des réponses rapides, comme les questions des clients. Présenté lors de la conférence annuelle Google I/O en mai, il se distingue par sa grande fenêtre de contexte, capable de traiter environ 1 million de tokens.

Sur le chatbot Gemini, cette fenêtre de contexte est de 32K tokens, permettant ainsi de répondre à des questions plus complexes et de maintenir des conversations prolongées.

Google a déclaré dans un billet de blog : « Cela signifie que vous pouvez avoir des conversations plus longues et poser des questions plus complexes à Gemini, le tout gratuitement ». L’entreprise précise également que vous devriez constater « des améliorations générales en termes de qualité et de temps de latence, notamment en ce qui concerne le raisonnement et la compréhension des images ».

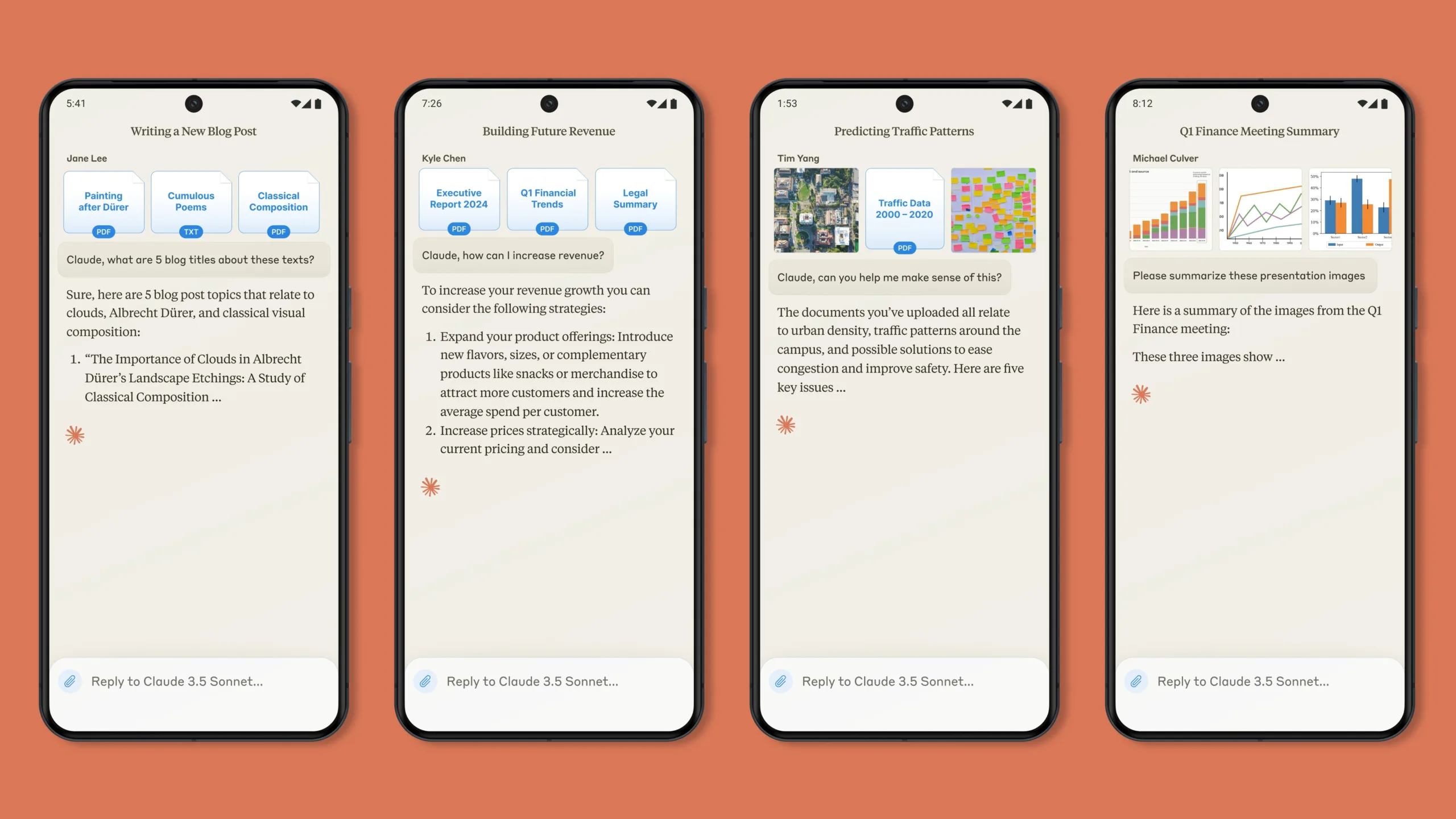

Afin de tirer pleinement parti des capacités de Gemini 1.5 Flash, Google a ajouté la possibilité de gérer les téléchargements de fichiers depuis Google Drive ou des appareils personnels, une fonctionnalité auparavant réservée à Gemini Advanced, la version payante du chatbot.

Un autre ajout notable est la fonction « contenu connexe », qui affiche des liens vers des sites Web ou des e-mails pertinents dans les réponses de Gemini. Google a également introduit une fonction de double vérification qui utilise Google Recherche pour vérifier les réponses, mettant en évidence les déclarations corroborées ou contredites sur le Web. Bien que Google ne soit pas la seule entreprise à ajouter des liens pour l’attribution des réponses, il a été constaté que certains chatbots, comme ChatGPT et Perplexity, hallucinaient parfois des liens, associant des liens à des articles inexistants ou sans rapport.

Vitesse et disponibilité de Gemini 1.5 Flash

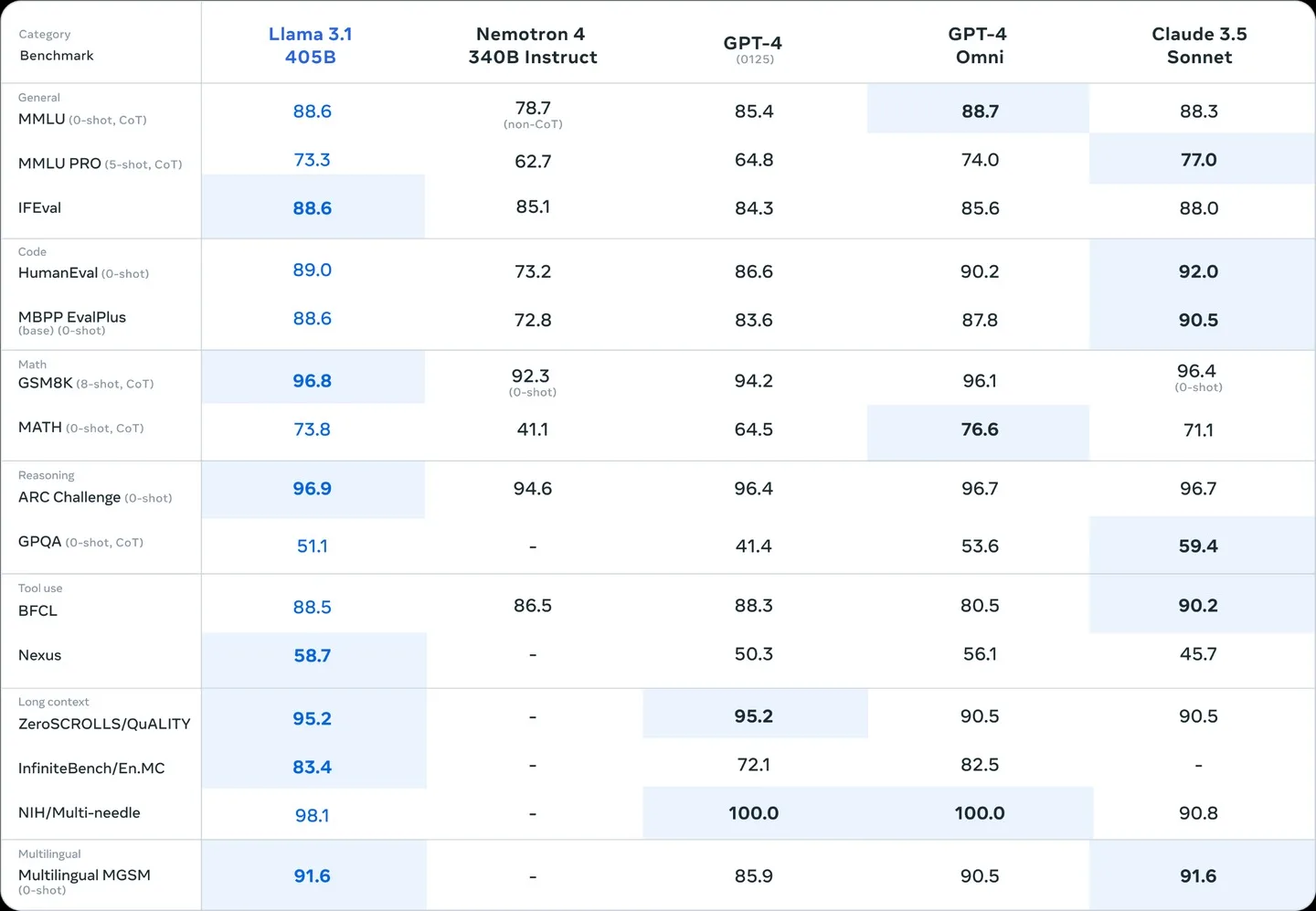

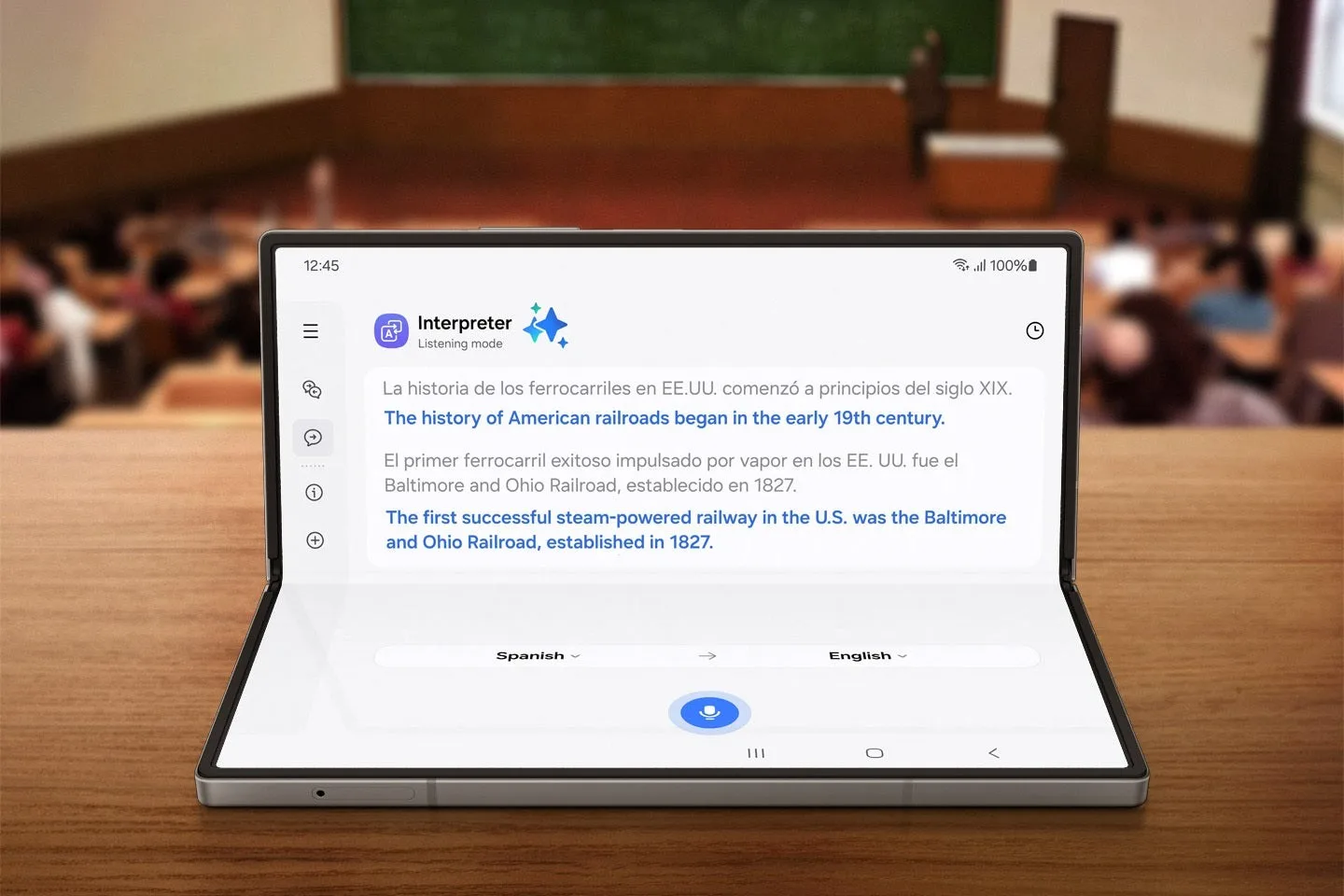

À son lancement, Google a affirmé que Gemini 1,5 Flash était 40 % plus rapide que le modèle rapide GPT-3.5 Turbo d’OpenAI. Bien que ce modèle ne soit pas de petite taille, comme ceux de la famille Gemma, il a été entraîné avec les mêmes données que Gemini 1,5 Pro. Disponible sur les versions mobiles et desktop, Gemini 1,5 Flash est accessible dans plus de 230 pays et territoires et prend en charge 40 langues.

Comme indiqué précédemment, les hallucinations restent un défi pour les modèles d’IA. Pour y remédier, Google a décidé d’ajouter des liens pertinents aux réponses du chatbot. Cela permet de montrer que les informations fournies ne sont pas créées sans référence. Désormais, pour les requêtes en anglais dans certains pays, les utilisateurs peuvent cliquer sur une puce à la fin d’un paragraphe pour voir les sites Web de référence.

D’autres nouvelles sur Gemini

Google prévoit de communiquer d’autres informations sur Gemini lors de son événement Made by Google, le mois prochain, en même temps que le lancement de ses nouveaux appareils. En attendant, vous pouvez essayer gratuitement toutes ces nouvelles fonctionnalités de Gemini dès aujourd’hui.

Gemini est déjà disponible sur iOS, Android et le Web, mais il arrive enfin sur Google Messages en Europe, au Royaume-Uni et en Suisse. Si vous l’avez déjà, appuyez sur « Démarrer le chat » dans Google Messages et sélectionnez « Gemini » pour commencer à discuter. Autre chose : Gemini dans Messages prend désormais en charge davantage de langues, notamment le français, le polonais et l’espagnol.