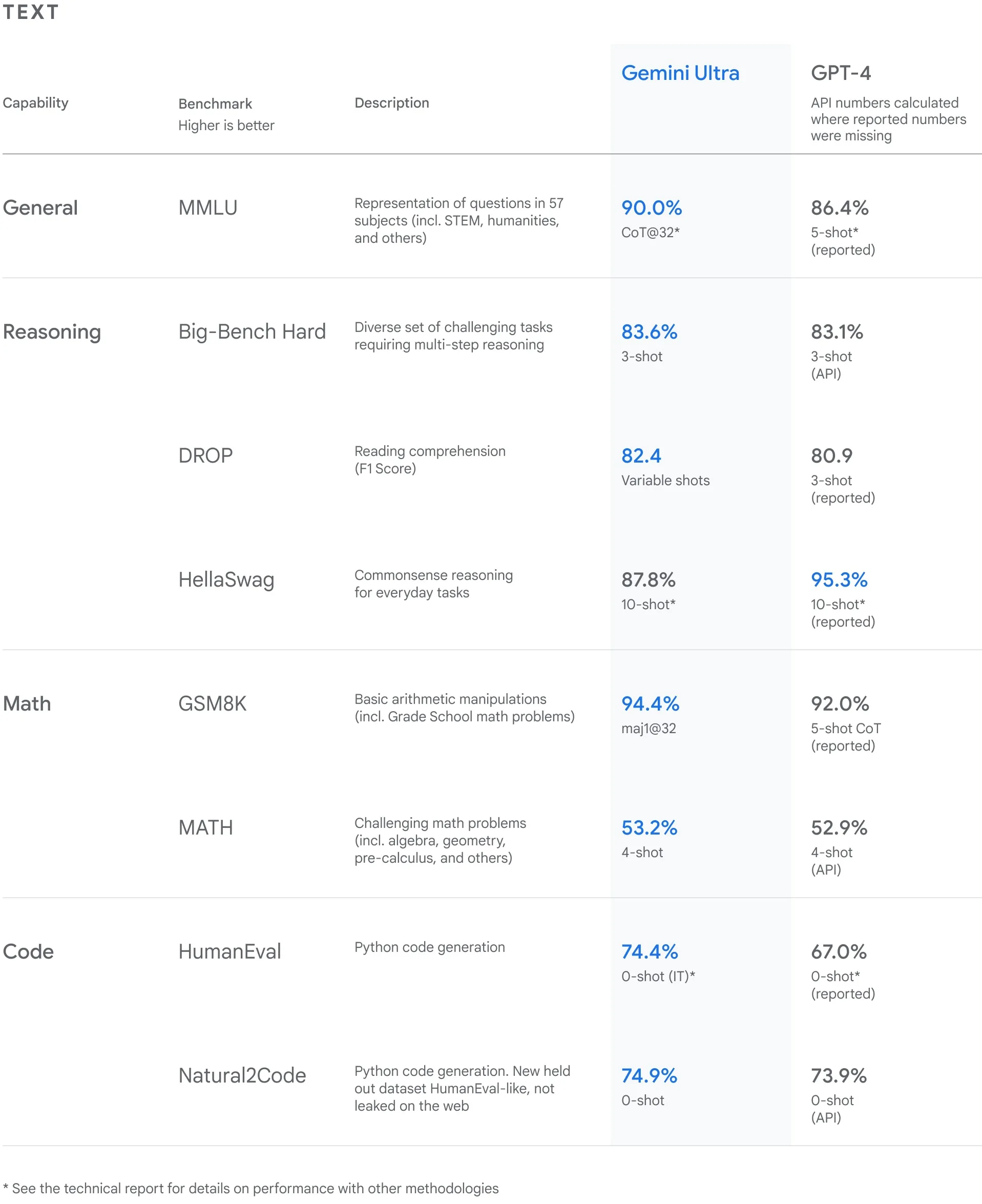

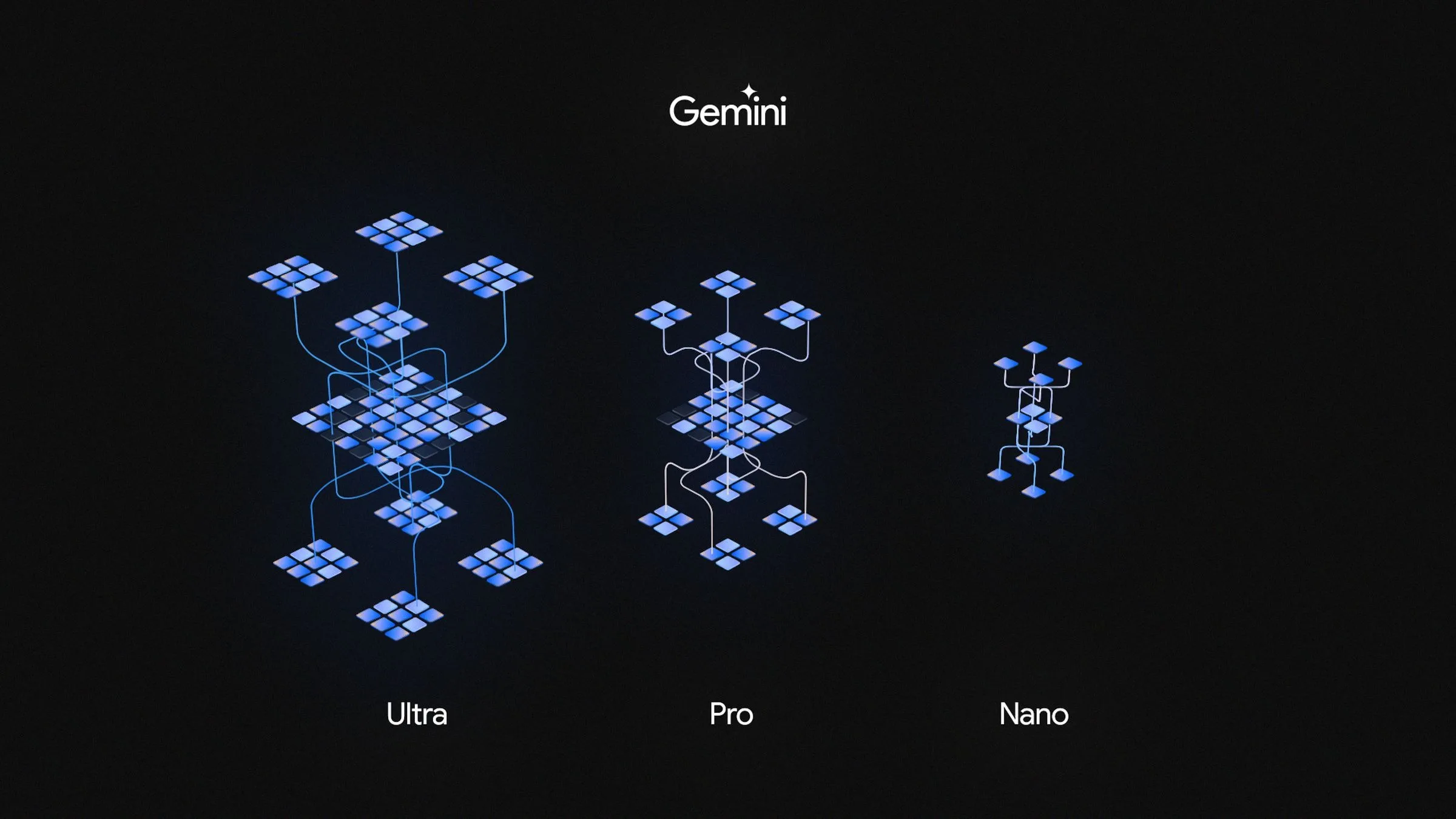

Google vient d’annoncer Gemini, sa suite de modèles d’IA la plus puissante à ce jour, et l’entreprise a déjà été accusée de mentir sur ses performances. Et, Google compte tellement sur son propre concurrent GPT-4, qu’il a mis en scène certaines parties d’une récente vidéo de démonstration.

Un article d’opinion de Bloomberg affirme que Google a mal présenté la puissance de Gemini dans une récente vidéo. Google a diffusé une impressionnante vidéo intitulée « Hands-on with Gemini: Interacting with multimodal AI » lors de son annonce en début de semaine, et l’éditorialiste Parmy Olson affirme que Gemini semblait remarquablement performant dans la vidéo – peut-être trop performant.

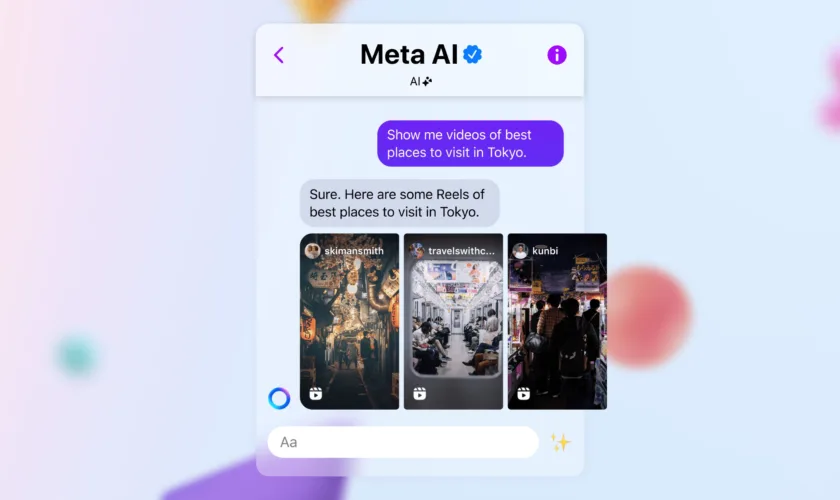

La vidéo de 6 minutes montre les capacités multimodales de Gemini (messages conversationnels vocaux combinés à la reconnaissance d’images, par exemple). Il semble que Gemini reconnaisse rapidement les images, même les images à points, qu’il réponde en quelques secondes et qu’il suive en temps réel une liasse de papier dans un jeu de gobelets et de balles. Bien sûr, les humains peuvent faire tout cela, mais il s’agit d’une IA capable de reconnaître et de prédire ce qui va se passer ensuite.

Mais en cliquant sur la description de la vidéo sur YouTube, Google affiche une importante clause de non-responsabilité :

Pour les besoins de cette démonstration, le temps de latence a été réduit et les sorties de Gemini ont été raccourcies pour plus de concision.

C’est ce que Olson conteste. Selon l’article de Bloomberg, Google a admis, lorsqu’on lui a demandé un commentaire, que la démonstration vidéo ne s’est pas déroulée en temps réel avec des messages vocaux, mais qu’elle a utilisé des images fixes provenant de séquences brutes, puis a rédigé des messages textuels auxquels Gemini a répondu. « C’est très différent de ce que Google semblait suggérer, à savoir qu’une personne pouvait avoir une conversation vocale fluide avec Gemini pendant que celui-ci observait le monde qui l’entourait et y répondait en temps réel », écrit Olson.

Pour être honnêtes avec Google, les entreprises modifient souvent les vidéos de démonstration, notamment parce qu’elles veulent éviter les problèmes techniques liés aux démonstrations en direct. Il est courant de modifier légèrement les choses. Dans une situation comme celle-ci, Olson estime que Google « fait de l’esbroufe » afin d’induire les gens en erreur sur le fait que Gemini est plus rapide que GPT d’OpenAI.

Il n’est pas surprenant que Google nie tout acte répréhensible, en renvoyant à The Verge à un post X écrit par le co-directeur de Gemini, Oriol Vinyals, qui affirme que « toutes les invites et sorties de l’utilisateur dans la vidéo sont réelles » et que son équipe a réalisé la vidéo « pour inspirer les développeurs ». Étant donné l’attention portée par l’industrie et les autorités à l’IA ces derniers temps, le géant de la technologie devrait peut-être faire preuve de plus de tact dans ses présentations dans ce domaine.

Really happy to see the interest around our “Hands-on with Gemini” video. In our developer blog yesterday, we broke down how Gemini was used to create it. https://t.co/50gjMkaVc0

We gave Gemini sequences of different modalities—image and text in this case—and had it respond … pic.twitter.com/Beba5M5dHP

—Oriol Vinyals (@OriolVinyalsML) December 7, 2023