Google avance rarement à découvert. Ses révolutions arrivent souvent masquées par de « petits tests », de « simples intégrations », de « bêtas limitées ». Mais derrière ces euphémismes se cache parfois un changement de paradigme.

C’est exactement ce qui est en train de se jouer avec la fusion progressive entre Gemini et NotebookLM — une expérimentation discrète, repérée par des portions de code et confirmée par plusieurs médias spécialisés, qui pourrait bouleverser la manière dont étudiants, chercheurs, créateurs et professionnels utilisent les outils d’IA.

Car il ne s’agit pas seulement d’importer un carnet de notes dans un chatbot. C’est la première étape visible du grand projet de Google : unifier ses intelligences artificielles en un seul espace cognitif fluide, interconnecté, sans friction.

NotebookLM + Gemini : Google réunit enfin deux super-pouvoirs complémentaires

NotebookLM était un OVNI : un outil académique à mi-chemin entre assistant de recherche, agrégateur documentaire et machine à synthèse, capable de transformer des dossiers PDF en résumés audio façon podcasts.

Gemini, lui, est la couche universelle : le moteur qui raisonne, crée, discute, planifie et s’interface avec les apps Google via ses Extensions.

Google a longtemps traité les deux comme des entités séparées. Jusqu’à maintenant.

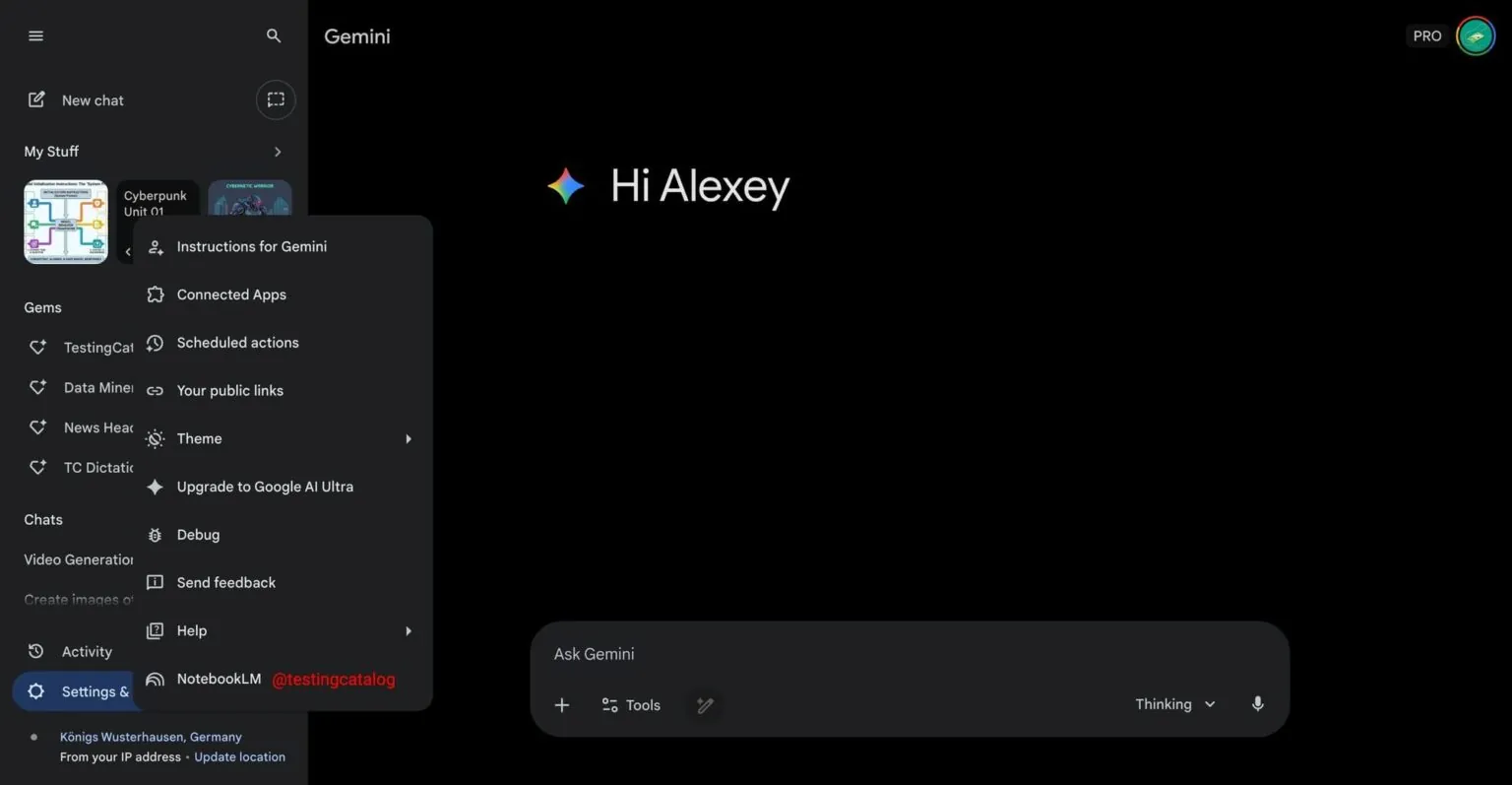

Selon Android Authority, certains utilisateurs voient apparaître un bouton « NotebookLM » directement dans Gemini. En un clic, importer un notebook, interroger son contenu, générer des analyses, et créer des synthèses en contexte.

Ce n’est pas un gadget. C’est une fusion de données + raisonnement. Un rapprochement qui annonce un futur très clair : Google prépare une IA personnelle totalement unifiée.

L’origine : NotebookLM, l’IA qui comprend vos connaissances privées

NotebookLM s’est taillé une réputation culte. Sa promesse : aider les humains à dompter l’information, qu’elle soit dans un PDF de 200 pages, un rapport scientifique ou un syllabus universitaire.

Avec l’arrivée du contexte géant (jusqu’à 1 million de tokens), NotebookLM est devenu une sorte d’IA-spécialiste capable d’avaler des bibliothèques entières. Jusqu’ici, l’utilisateur devait jongler entre deux interfaces : NotebookLM pour comprendre, Gemini pour construire.

L’intégration des deux abolit ce mur. Le travail intellectuel devient continu, sans frontière.

Gemini évolue : l’assistant conversationnel devient un « navigateur de connaissances »

Depuis Bard, Google a multiplié les itérations : multimodalité, raisonnement profond, Agent Mode, intégration Workspace…

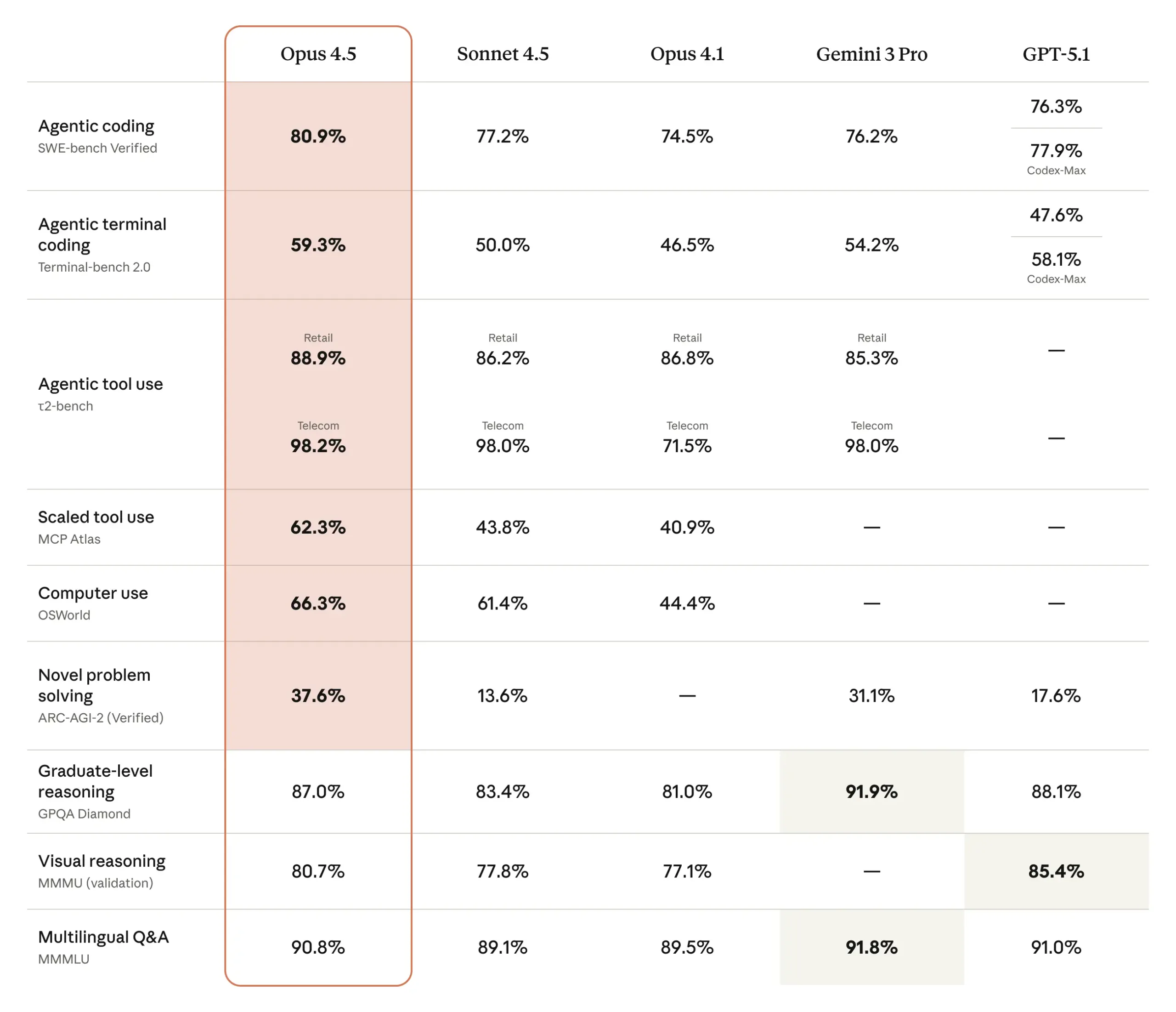

Gemini 3 a accéléré cette trajectoire avec moins besoin de prompt, plus de logique, une capacité à manipuler fichiers, images et données, et une exécution de tâches en autonomie.

L’import NotebookLM ajoute une nouvelle dimension : Gemini n’est plus seulement un assistant généraliste, mais un analyste qui comprend votre corpus personnel.

Vos notes de cours ? Vos documents de travail ? Vos guidelines internes ? Vos sources journalistiques ? Gemini peut maintenant tout digérer, tout connecter, tout explorer.

Une intégration encore discrète… mais qui dit tout de la stratégie Google

La fonctionnalité reste « en test », cachée derrière un bouton dans une interface que seuls quelques utilisateurs voient. Mais, les indices techniques sont là : appels API dédiés, chaînes de code indiquant des requêtes contextuelles dans les notebooks, et options de synthèse et de résumé dans la fenêtre de chat.

Google ne teste jamais au hasard. Ce type d’intégration préfigure toujours un lancement public — une fois l’ergonomie affinée et les risques bien cernés.

Une révolution silencieuse pour les étudiants, chercheurs et knowledge workers

Dans la pratique, l’impact peut être colossal.

Exemples concrets :

- Un journaliste importe ses interviews dans NotebookLM → demande à Gemini d’en extraire des angles, contradictions, citations clés.

- Un étudiant en droit charge 300 pages de jurisprudence → demande à Gemini de créer un plan de dissertation à partir du corpus.

- Un chercheur combine publications, notes de labo et données → utilise Gemini pour générer une revue de littérature.

- Une équipe produit injecte études utilisateurs + feedbacks → demande à Gemini de générer une roadmap hiérarchisée.

Avant : 3 outils, 4 onglets, du copier-coller. Maintenant : une seule interface qui comprend et travaille avec votre contenu.

Face à OpenAI et Microsoft : Google joue enfin la carte de l’écosystème unifié

OpenAI pousse ses custom GPTs. Microsoft marie Copilot + OneNote + Edge. Google devait répondre.

En intégrant NotebookLM à Gemini, Google crée sa version d’un « super-app » où vos fichiers (Drive), vos notes (NotebookLM), vos calendriers, mails, photos (Extensions Gemini), vos requêtes Web (Search + RAG temps réel) ne forment plus qu’une seule couche cognitive.

C’est précisément là que Google peut battre OpenAI : dans la distribution et l’intégration. Gemini est déjà partout : Android, Chrome, Workspace, Search, YouTube, et plus récemment dans Google Home et Google Maps.

OpenAI, sans OS ni écosystème natif, ne peut pas offrir cette fluidité.

Mais, l’intégration ouvre aussi des défis : confidentialité, biais, hallucinations

Cette fusion n’est pas sans questions. Beeps de prudence :

- Les données sensibles seront-elles cloisonnées ? Google promet chiffrement & opt-in strict. Mais, l’historique de l’industrie pousse à la vigilance.

- Que faire si Gemini hallucine à partir de notes personnelles ? Un risque réel : notamment si le contenu source est incomplet, biaisé ou obsolète.

- Comment éviter l’effet « Google ecosystem lock-in » ? L’intégration rapprochée soulève des questions antitrust, surtout en Europe.

- Le mélange AI + documents privés peut-il devenir une « boîte noire cognitive » ? De plus en plus de chercheurs plaident pour des modèles explainable-by-design.

Ce que prépare Google : vers une IA personnelle qui comprend tout votre contexte

L’intégration NotebookLM n’est qu’une étape. Les insiders imaginent déjà les prochains niveaux :

- synchronisation bidirectionnelle : vos conversations Gemini créent automatiquement de nouveaux notebooks ;

- connexion avec Drive : importer des dossiers entiers ;

- mode « conférence » : Gemini analyse vos notes de réunion en temps réel ;

- mode collaboratif : plusieurs utilisateurs construisent un notebook partagé, interrogé par Gemini ;

- raisonnement multi-corpus : croiser plusieurs notebooks pour créer des insights transversaux.

Google veut transformer ses IA en mémoire externe augmentée, un prolongement de l’esprit humain. Un espace où vos connaissances, vos sources et vos questions fusionnent sans effort.

Une petite intégration… pour une grande vision

À première vue ? Un bouton. Un test limité. Une option alpha. En réalité ? Une mutation profonde de la manière dont Google conçoit l’IA avec un assistant qui connaît vos documents, qui comprend vos projets, qui poursuit vos recherches, qui devient votre partenaire intellectuel, et qui réunit toutes les briques d’un écosystème cohérent.

Si Google pousse cette fusion jusqu’au bout, Gemini ne sera plus seulement un chatbot. Ni un moteur de recherche augmenté.

Ce sera l’interface principale de notre cognition numérique. La porte d’entrée vers un futur où l’IA n’est plus un outil… mais une extension naturelle du travail intellectuel humain.