Il aura suffi d’un simple papier de prédictions pour 2026 pour déclencher un mini-séisme culturel : l’idée que OpenAI puisse racheter Pinterest. Aucun communiqué, aucun « on en parle », aucun indice public — et pourtant, en quelques heures, la spéculation a pris la forme d’une menace existentielle pour une partie des utilisateurs.

Une origine : une « prédiction », pas une information

À l’origine, il ne s’agit pas d’un scoop fondé sur des sources internes, mais d’une projection publiée par The Information dans une liste de paris éditoriaux sur 2026. Plusieurs reprises de presse ont ensuite amplifié l’hypothèse, parfois avec des titres plus affirmatifs que le contenu réel.

Sur les marchés, l’effet a été immédiat : Pinterest a grimpé d’environ 3 % après la publication, selon des reprises financières de la prédiction. Et au moment où j’écris ces lignes, l’action évolue autour de 26,5 dollars.

Ce contraste dit tout de l’époque : la Bourse récompense l’idée d’un « deal » stratégique, tandis qu’une partie du public lit la même hypothèse comme une annexion.

Pourquoi Pinterest « fait sens » sur le papier (si OpenAI veut accélérer le commerce)

La logique avancée par plusieurs analystes est assez simple : Pinterest, c’est à la fois un moteur de découverte visuelle, une machine à intention d’achat (design, déco, mode, recettes, projets) et une plateforme qui sait déjà connecter l’inspiration à la transaction via la pub et le shopping.

Du côté d’OpenAI, la trajectoire « commerce » devient de plus en plus lisible :

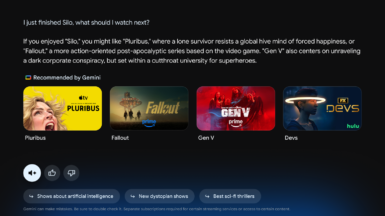

- OpenAI a déjà déployé des fonctionnalités shopping dans l’écosystème ChatGPT (recommandations produits, visuels, liens d’achat) via des mises à jour de recherche.

- L’entreprise a aussi publié des briques orientées agentic commerce (protocoles et parcours d’achat assistés), signe qu’elle veut industrialiser le passage de la conversation à l’action.

Dans ce cadre, Pinterest apparaît comme une potentielle accélération : un gigantesque graphe de goûts, de tendances et de « projets de vie » — le carburant rêvé pour des assistants capables de suggérer, composer, puis acheter.

Pourquoi les utilisateurs paniquent : contrôle, propriété, et « AI slop »

Sauf que Pinterest n’est pas vécu comme un réseau social classique. Pour beaucoup, c’est un carnet d’inspiration personnel, un espace d’archivage intime, parfois vieux de dix ans, qui repose sur un principe central : je choisis ce qui entre dans mon tableau.

Sur Reddit, la réaction a été brutale, avec un rejet qui vise moins l’opération financière que ce qu’elle symbolise : l’IA qui s’invite dans le dernier espace perçu comme « manuel ». On voit revenir des formules comme : « I hate AI being shoved into every corner of my life ». D’autres annoncent vouloir tout télécharger et partir si l’acquisition devenait réelle — par peur que leurs tableaux deviennent un gisement d’entraînement, ou que l’expérience se transforme en flux de contenus générés.

C’est là le cœur du malaise : la promesse de Pinterest, c’est la curation humaine. La promesse d’une partie de l’IA grand public, c’est l’automatisation. Même si les deux peuvent cohabiter, l’imaginaire collectif, lui, a déjà tranché.

Ce qui manque à la rumeur : un fait… et une stratégie de confiance

Rappel essentiel : il n’y a aucun deal annoncé, et rien n’indique publiquement que les deux entreprises sont en discussion. Mais, la séquence révèle autre chose : en 2026, le sujet n’est plus « l’IA est-elle utile ? », c’est où place-t-on la frontière.

Si un scénario de rachat devait un jour devenir crédible, l’enjeu ne serait pas d’ajouter des fonctionnalités. Ce serait de définir des règles lisibles : opt-out clair, limites d’usage des données, garanties sur la visibilité des contenus humains, et une gouvernance qui prouve que les tableaux ne sont pas une simple matière première.

Parce qu’au fond, cette flambée de colère n’est pas une hystérie : c’est un signal. Les utilisateurs ne fuient pas la technologie. Ils fuient la sensation de ne plus être chez eux.