Les spéculations vont bon train sur le fait que OpenAI se prépare à lancer ce qui pourrait être ChatGPT-5, bien que l’on ne sache pas encore s’il s’appellera réellement GPT-5 ou quelque chose d’autre.

Tout le monde s’attend à ce que OpenAI publie une nouvelle mise à jour majeure de son Large Language Model ChatGPT. Mais ce lancement imminent a suscité l’enthousiasme de la communauté technologique, car il promet de transformer le mode de fonctionnement des grands modèles linguistiques et des entreprises, en remodelant les stratégies de gestion des données et de la protection de la vie privée.

ChatGPT-5 bientôt disponible

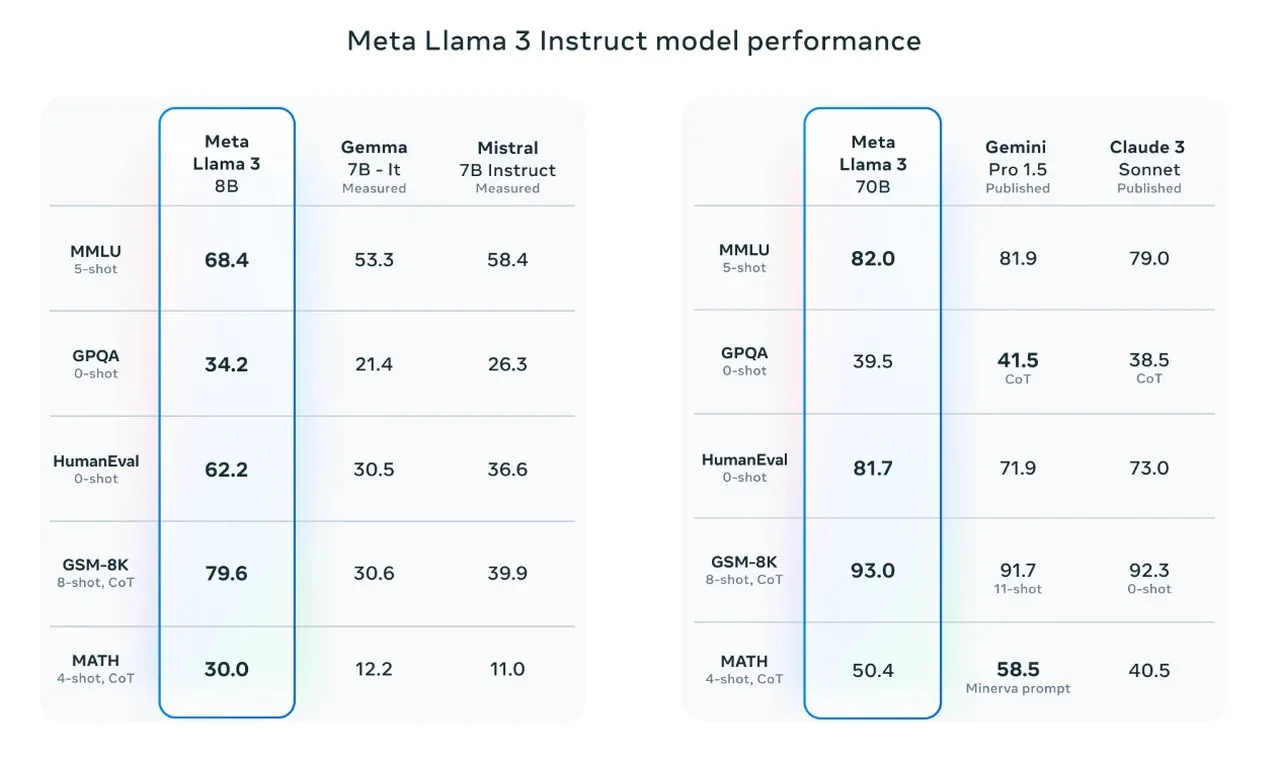

À l’avant-garde de cette révolution de l’IA, on trouve des entreprises comme Meta et OpenAI, qui sont le fer de lance de l’intégration de modèles d’IA sophistiqués sur le marché. Meta, par exemple, a progressivement déployé son modèle avancé Llama 3, signalant une évolution vers des fonctionnalités d’IA plus complexes et plus performantes. Ces développements sont des étapes cruciales dans l’intégration de l’IA dans le tissu des activités commerciales quotidiennes et dans l’amélioration des processus de prise de décision dans tous les secteurs.

Avant d’être mis à la disposition du public, tout modèle d’IA doit être soumis à des tests de pré-déploiement rigoureux afin d’en garantir la fiabilité, la sécurité et l’efficacité. Toutefois, cette phase critique présente souvent des difficultés, car l’accès à ces modèles innovants peut être limité. Google DeepMind a été un précurseur dans ce domaine, en autorisant un certain degré de test pour vérifier que ses modèles sont robustes et prêts à être utilisés à grande échelle. Cette approche souligne l’importance de tests et de validations approfondis avant que les systèmes d’IA ne soient déployés dans des scénarios réels.

L’IA catalyseur de l’innovation commerciale

Dans le domaine des affaires, l’IA est de plus en plus reconnue comme un outil indispensable pour stimuler l’innovation et rester compétitif. Ces systèmes intelligents sont conçus pour effectuer des tâches qui requièrent généralement une intelligence de type humain, tels que la résolution de problèmes complexes, la reconnaissance de formes et la prise de décision.

En intégrant l’IA dans leurs opérations, les entreprises ne se contentent pas de stimuler la productivité et l’efficacité, mais favorisent également un environnement propice à l’innovation et à l’adaptabilité. Alors que l’IA continue d’évoluer, les entreprises qui adoptent ces technologies seront mieux placées pour relever les défis de l’avenir et saisir de nouvelles opportunités de croissance.

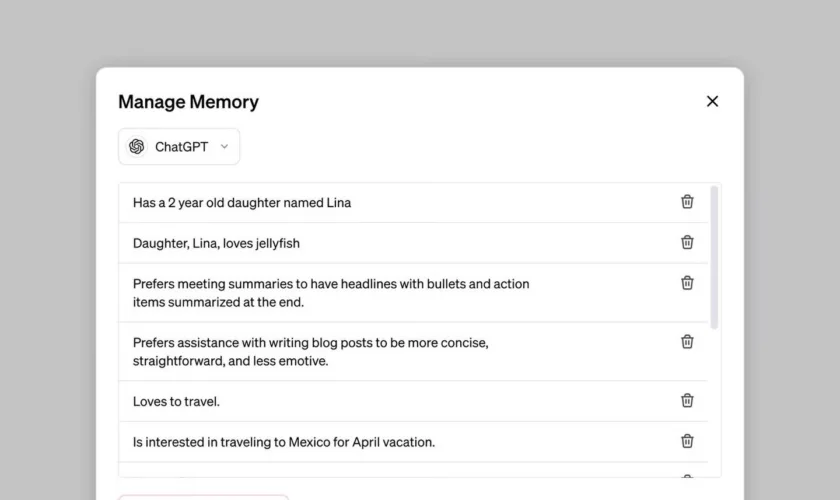

Prise en compte des implications en matière de protection de la vie privée

Si la puissance de l’IA recèle un immense potentiel, elle soulève également d’importantes préoccupations en matière de protection de la vie privée, d’autant plus que les modèles sont de plus en plus capables d’effectuer des tâches telles que l’analyse d’images pour la détection de l’emplacement d’une personne.

De telles capacités, si elles ne sont pas correctement réglementées, pourraient être utilisées à des fins malveillantes telles que le cyberharcèlement, ce qui souligne l’importance cruciale de la mise en œuvre de mesures strictes de protection de la vie privée lors du développement et du déploiement des systèmes d’IA.

L’IA s’intégrant de plus en plus dans notre vie quotidienne, il est essentiel que les développeurs, les décideurs politiques et les utilisateurs travaillent ensemble pour établir des lignes directrices claires et des bonnes pratiques afin de protéger les droits individuels à la vie privée.

L’avenir de l’IA et l’indépendance matérielle

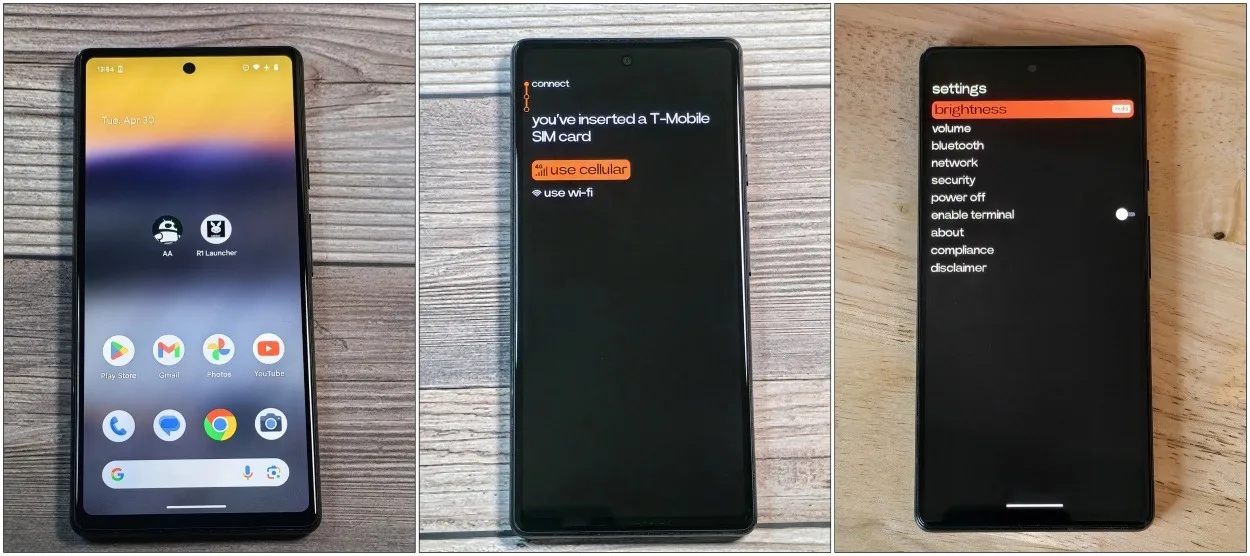

Alors que la technologie de l’IA continue de progresser, les experts s’accordent de plus en plus à dire que les futurs modèles d’IA pourraient ne pas nécessiter de matériel spécialisé pour fonctionner efficacement. Cette potentielle évolution vers l’indépendance matérielle pourrait rendre l’IA plus accessible à un public plus large, en démocratisant ses avantages et ses applications.

Malgré cette tendance, le paysage actuel comprend également des avancées passionnantes dans la technologie de l’IA portable, qui continue de susciter des débats sur sa praticité, son impact potentiel et ses implications pour la vie privée.

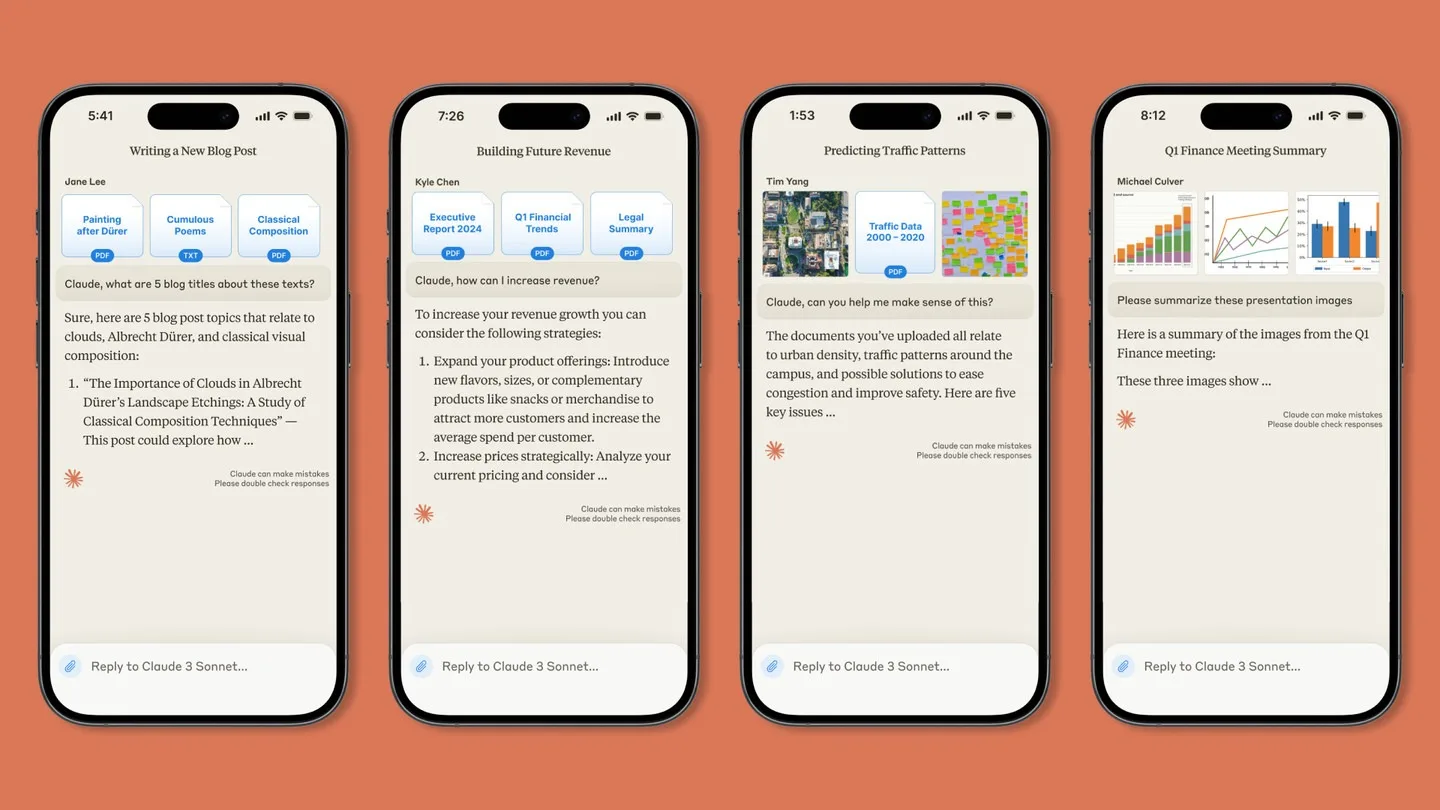

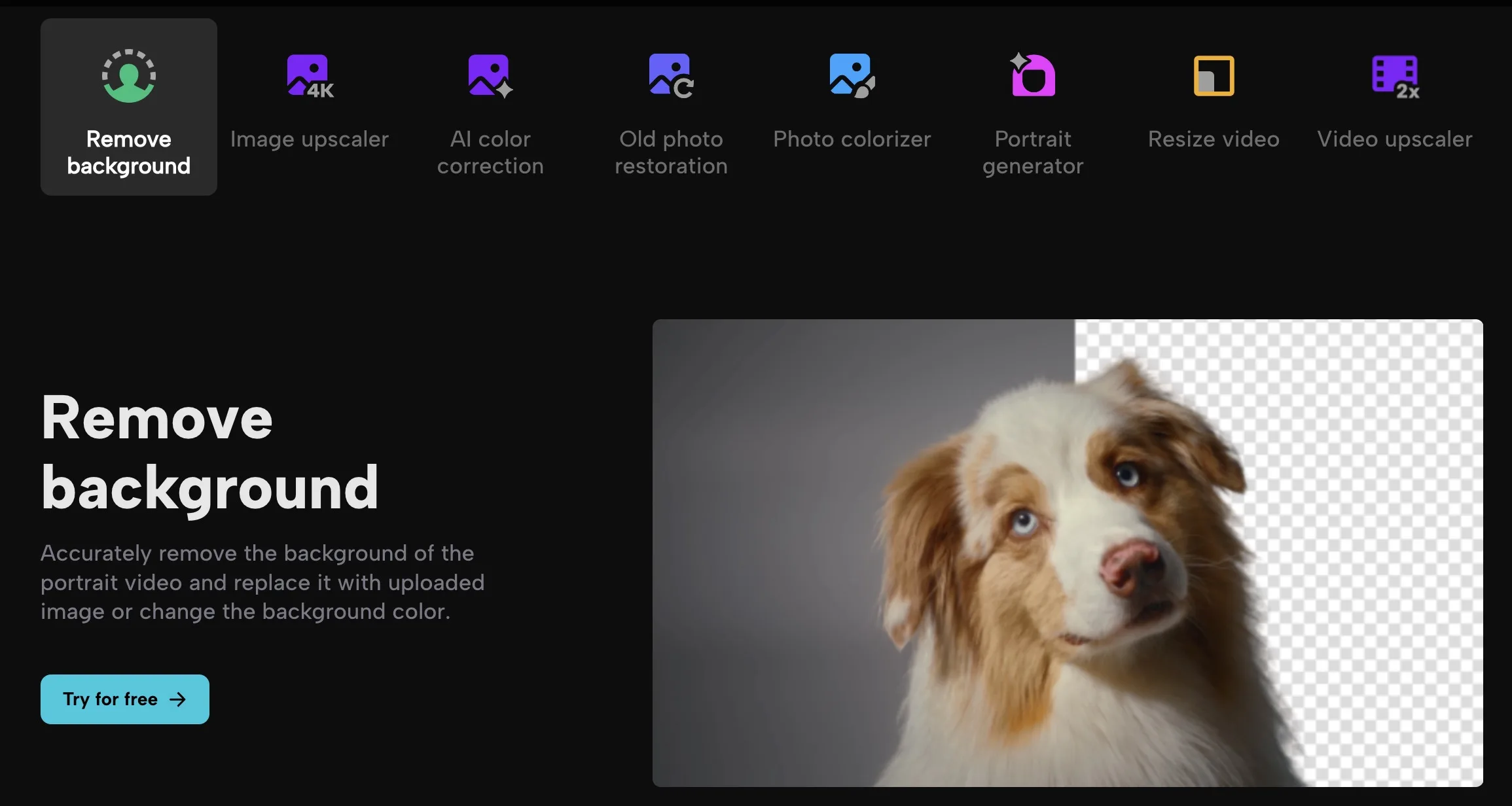

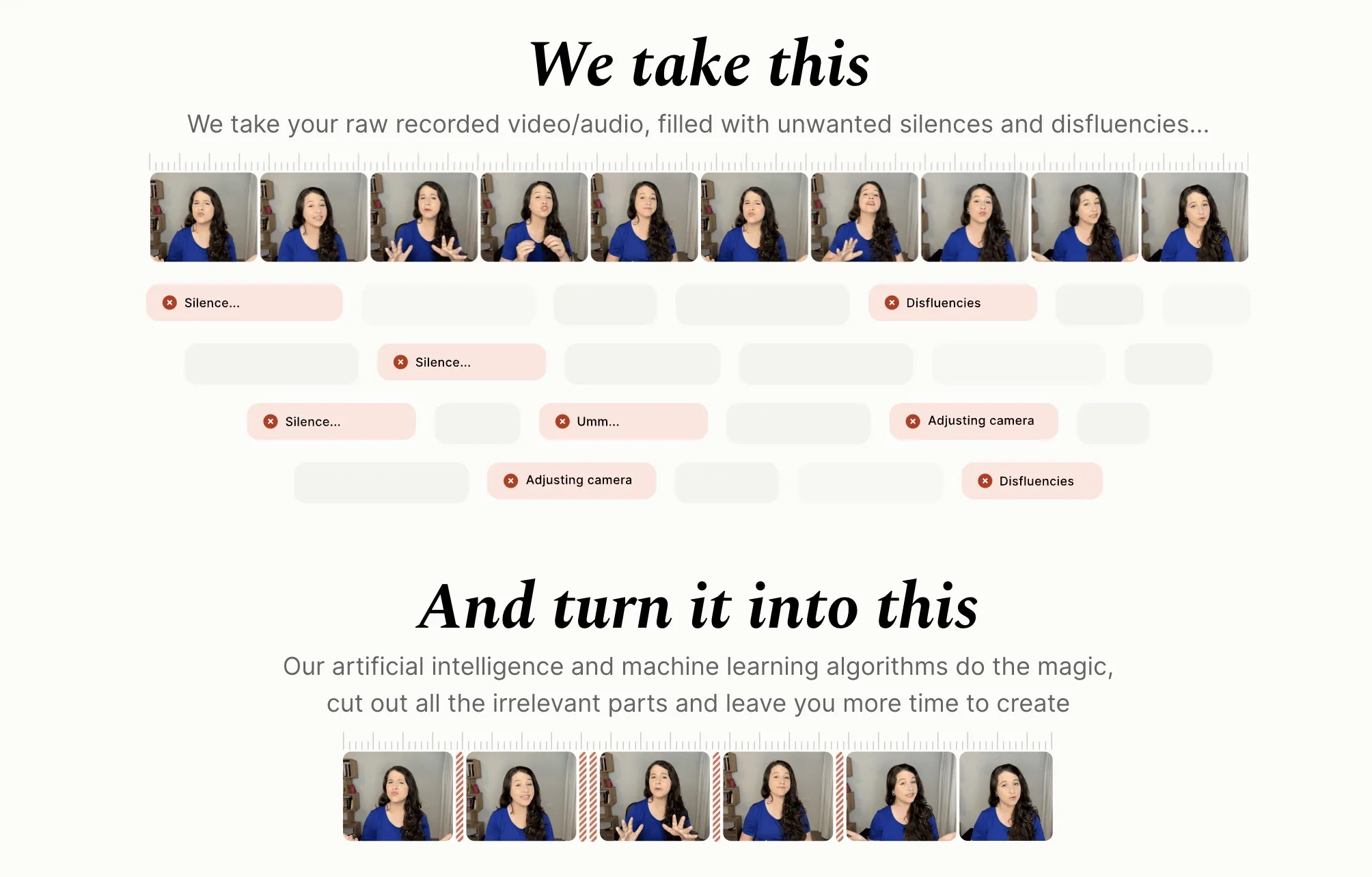

Au-delà du développement des modèles d’IA eux-mêmes, les entreprises se concentrent également sur la manière dont elles interagissent avec le public et les entreprises par le biais d’interfaces et de plateformes alimentées par l’IA. Des efforts sont faits pour repenser ces plateformes afin d’offrir des expériences plus conviviales et intuitives, rendant les technologies de l’IA plus accessibles et plus faciles à intégrer dans l’utilisation quotidienne. En donnant la priorité à l’engagement des utilisateurs et en simplifiant les interactions avec l’IA, les organisations peuvent contribuer à combler le fossé entre la technologie et les utilisateurs visés, ce qui favorise une adoption plus large et libère tout le potentiel de l’IA dans divers secteurs.

La sortie imminente de ChatGPT-5 d’OpenAI marque une étape importante dans l’évolution de l’intelligence artificielle, repoussant les limites de ce que l’IA peut accomplir et annonçant une nouvelle ère de possibilités. Alors que des organisations comme OpenAI et Meta continuent d’innover et d’affiner leurs modèles d’IA, l’accent reste mis sur la garantie que ces puissantes technologies sont développées et déployées d’une manière qui donne la priorité à la sécurité, respecte la vie privée des individus et apporte une valeur ajoutée tangible dans le monde des affaires.