Au MWC 2026, RayNeo (TCL) pousse encore plus loin l’idée de lunettes-écran : un accessoire léger, branché en USB-C, qui transforme n’importe quel smartphone ou PC en salle obscure personnelle. Avec les Air 4 Pro, la marque mise sur un triptyque simple — image HDR, audio « sans casque » et 3D à la volée — et ajoute une édition Batman qui ne se contente pas d’un habillage.

Une promesse « display first » : HDR10, 1 200 nits et 10,7 milliards de couleurs

Le point central, c’est l’affichage. RayNeo présente les Air 4 Pro comme les premières lunettes AR grand public avec HDR10, pilotées par une puce maison Vision 4000. La marque revendique 10,7 milliards de couleurs et une luminosité jusqu’à 1 200 nits, avec un gain de dynamique par rapport aux générations précédentes.

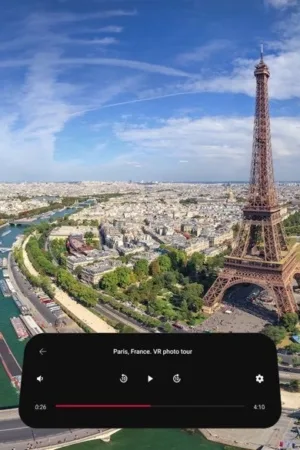

Dans la pratique, RayNeo vend surtout une expérience : un écran virtuel géant — jusqu’à 201 pouces « perçus » — qui suit votre mobilité (train, avion, bureau, canapé).

– RayNeo (@rayneo_global) February 28, 2026

La puce Vision 4000 : de la 2D qui devient 3D, et du SDR boosté en HDR

Au-delà du HDR natif, RayNeo met en avant des traitements temps réel : upscaling SDR vers HDR et conversion 2D vers 3D via algorithmes propriétaires. L’idée est de rendre plus immersif du contenu standard, sans fichiers 3D spécifiques. C’est typiquement le genre de fonction qui fera la différence au quotidien si l’exécution est propre : une 3D « facile », sans friction, qui transforme Netflix/YouTube/jeux en expérience plus enveloppante.

RayNeo insiste aussi sur l’audio : quatre haut-parleurs et une architecture de « sound tubes » pour diriger le son vers l’oreille en limitant les fuites. Le tout est co-réglé par Bang & Olufsen, avec des modes visant à réduire le leakage en environnement partagé.

Compatibilité : l’approche pragmatique de la « lunette-écran »

Les Air 4 Pro se branchent à tout appareil USB-C avec sortie DisplayPort (téléphones, PC, consoles compatibles), ce qui en fait un produit moins « lunettes intelligentes » que moniteur portable à porter.

La version « Batman Edition » (déclinée en Justice et Chaos/Joker) ajoute un élément très concret : des nuances interchangeables, conçus pour bloquer davantage la lumière ambiante et renforcer l’effet « salle noire ». RayNeo la présente comme un set collector, mais avec un bénéfice d’usage évident si vous regardez beaucoup de contenu en extérieur.

Prix et disponibilité : une stratégie « early bird » assumée

RayNeo annonce un positionnement agressif pour la catégorie :

- Air 4 Pro Standard : 249 dollars en early bird (prix de vente 299 dollars)

- Batman Limited Edition : 269 dollars en early bird (prix de vente 319 dollars)

Le marché des lunettes-écrans avance par itérations : plus léger, plus lumineux, plus confortable. Le HDR10 est un signal fort parce qu’il parle immédiatement aux usages « cinéma » — contrastes, hautes lumières, profondeur — là où beaucoup de produits restent cantonnés à une image flatteuse mais limitée.

La recette RayNeo est cohérente : éviter la complexité des « vraies » smart glasses (caméras, IA sociale, contraintes légales), et se concentrer sur ce que l’utilisateur ressent en 10 secondes : « je viens d’installer un écran géant devant mes yeux. » Si l’optique, le confort (76 g annoncés) et la gestion des reflets tiennent leurs promesses, l’Air 4 Pro peut devenir l’un de ces gadgets qui quittent le tiroir pour le sac.