À mesure que les assistants IA deviennent des « interfaces de confiance » — capables de conseiller, d’arbitrer et parfois d’agir —, la question de la monétisation n’est plus secondaire. Elle touche au cœur du produit. Et, à Davos, Google a choisi d’envoyer un message très clair : pas de publicité dans Gemini… pour l’instant, au moment même où OpenAI officialise l’arrivée de publicités dans ChatGPT.

Lors du World Economic Forum 2026 à Davos, Demis Hassabis (CEO de Google DeepMind) a expliqué qu’il n’y avait « aucun plan » pour intégrer des publicités dans Gemini à ce stade, tout en soulignant le risque de casser la confiance dans un assistant censé agir au nom de l’utilisateur.

Ce n’est pas un « one-off ». En décembre 2025 déjà, Dan Taylor, VP Global Ads chez Google, avait publiquement démenti un article affirmant que des pubs arriveraient dans Gemini en 2026, en rappelant qu’il n’y avait pas de pubs dans l’app Gemini et pas de plan actuel pour en ajouter.

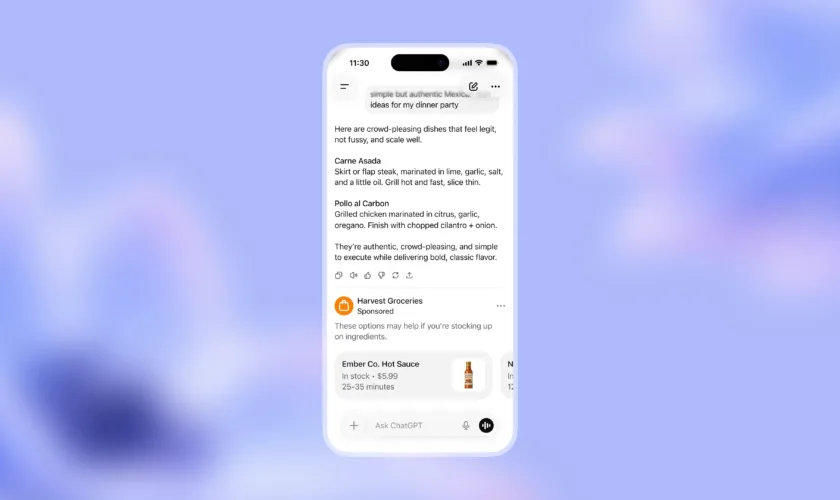

Ce que fait OpenAI : des pubs… mais cadrées, testées et cantonnées à certains plans

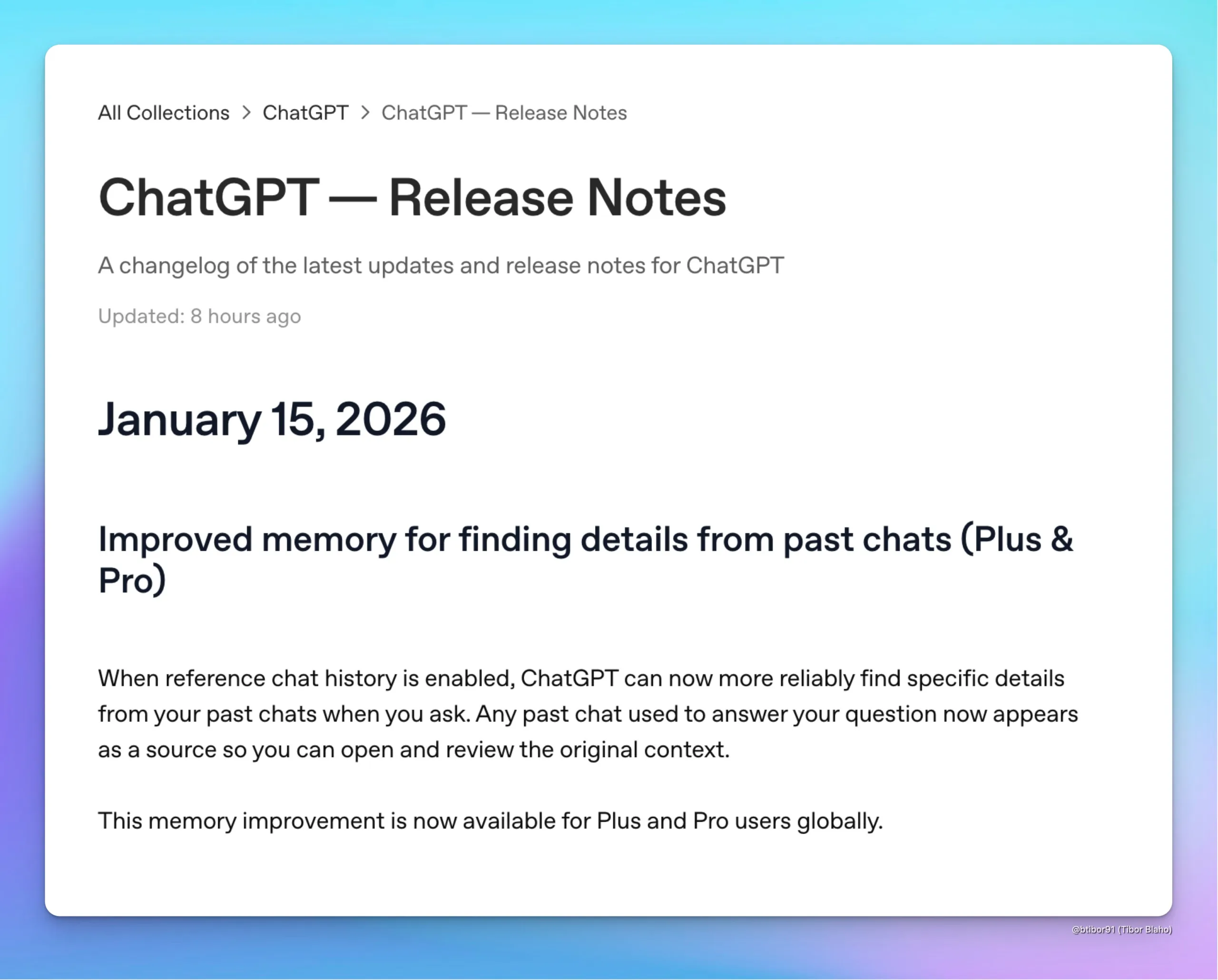

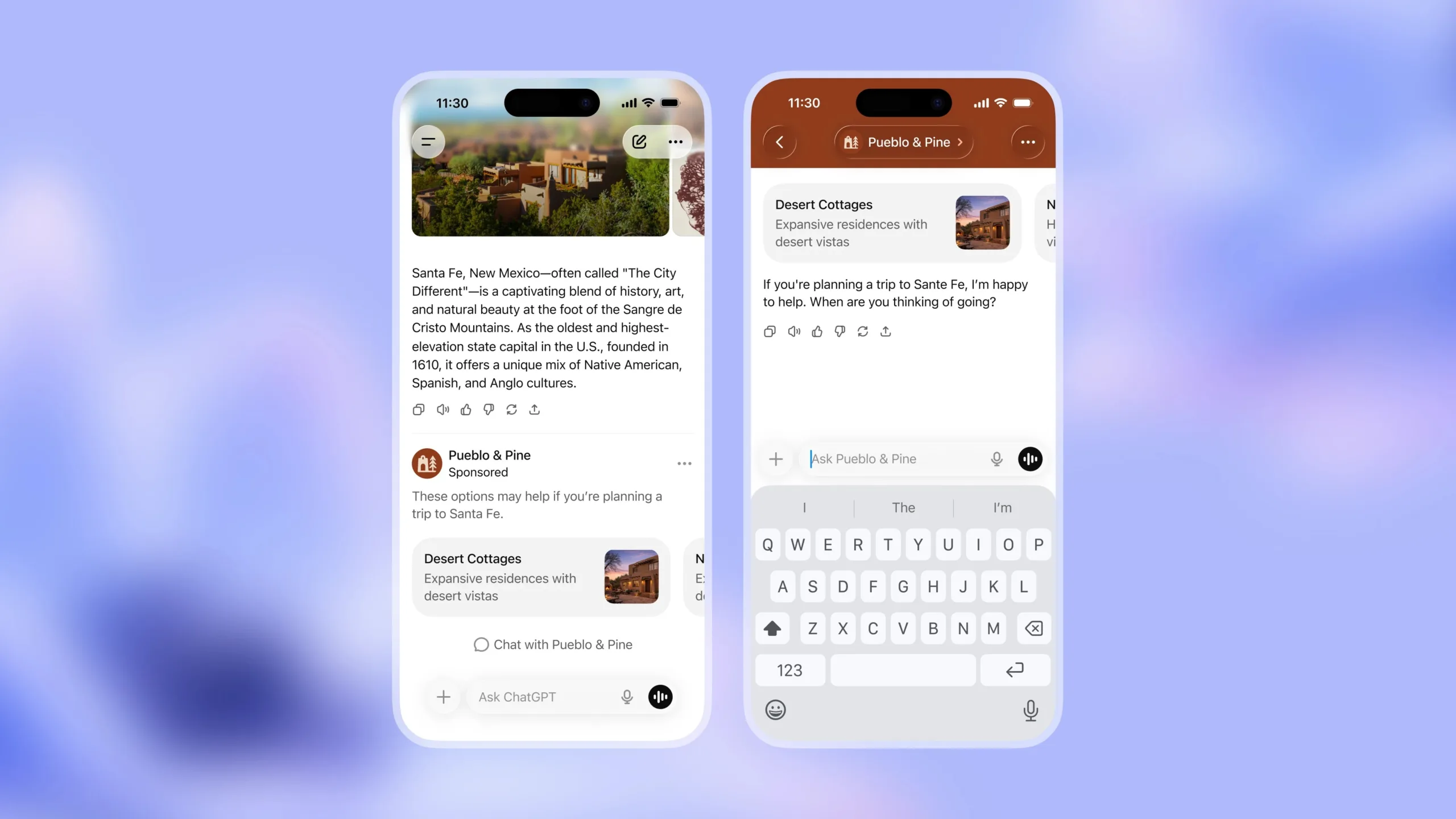

De son côté, OpenAI a publié une note de cadrage : la société prévoit de tester des publicités aux États-Unis « dans les prochaines semaines », pour des adultes connectés, sur les offres Free et ChatGPT Go. Les annonces seraient affichées en bas des réponses, clairement étiquetées et séparées du contenu organique, avec la possibilité de comprendre pourquoi on voit une pub et de la masquer.

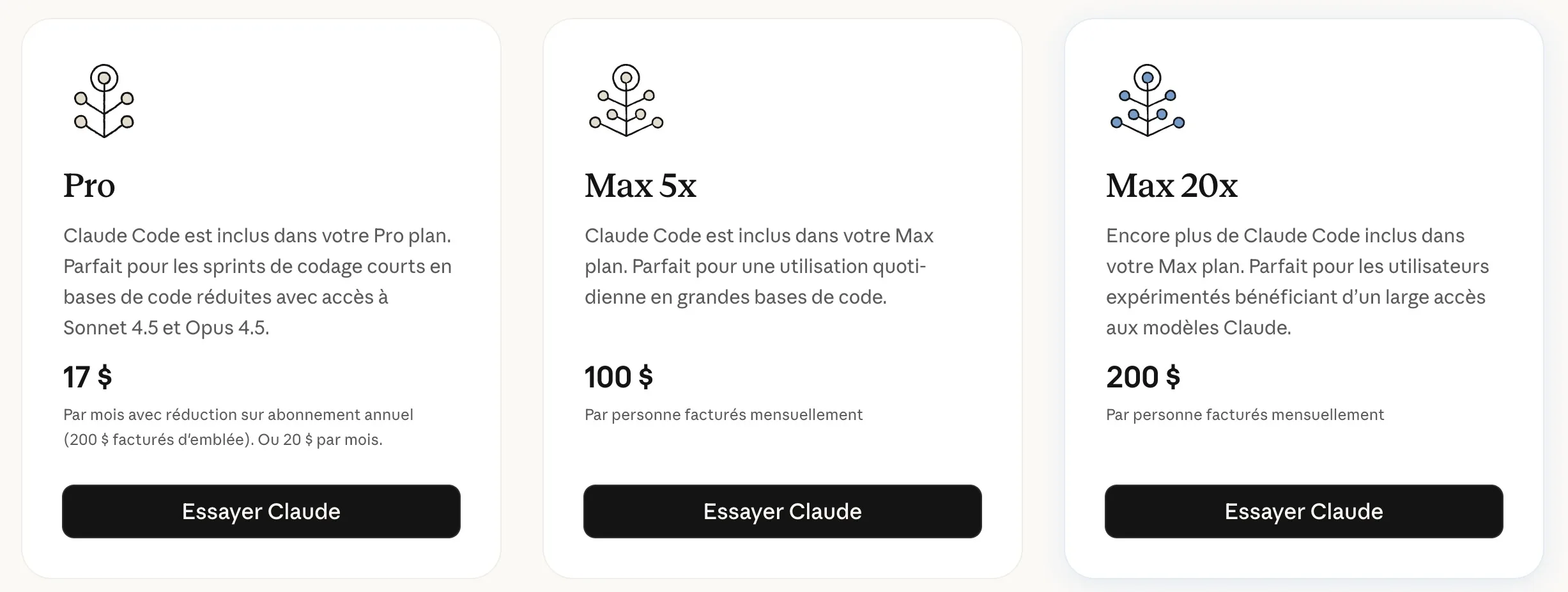

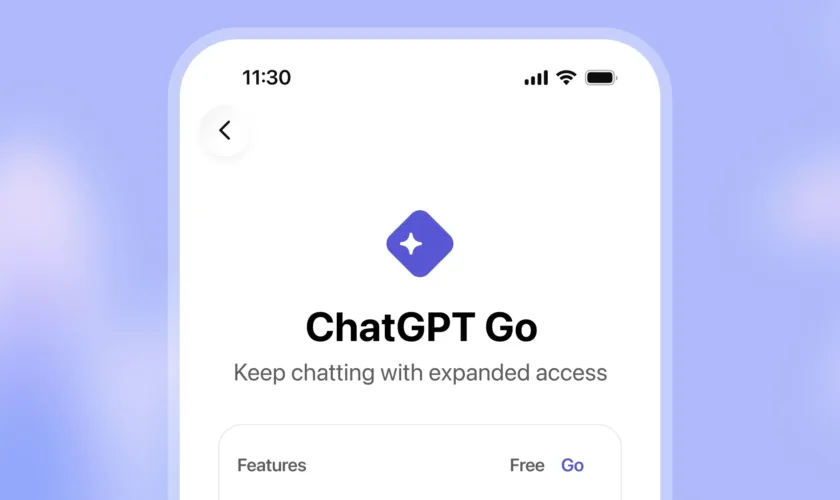

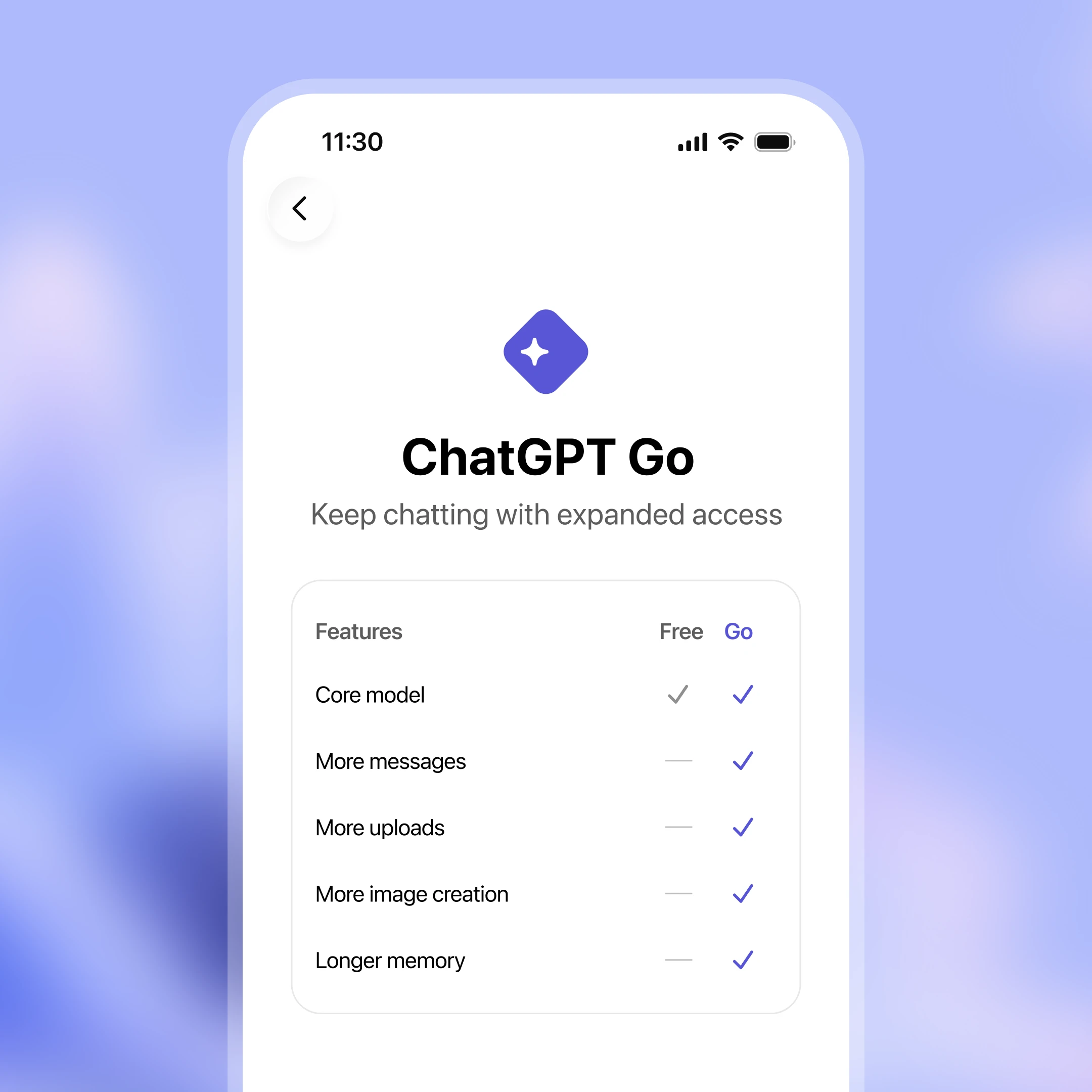

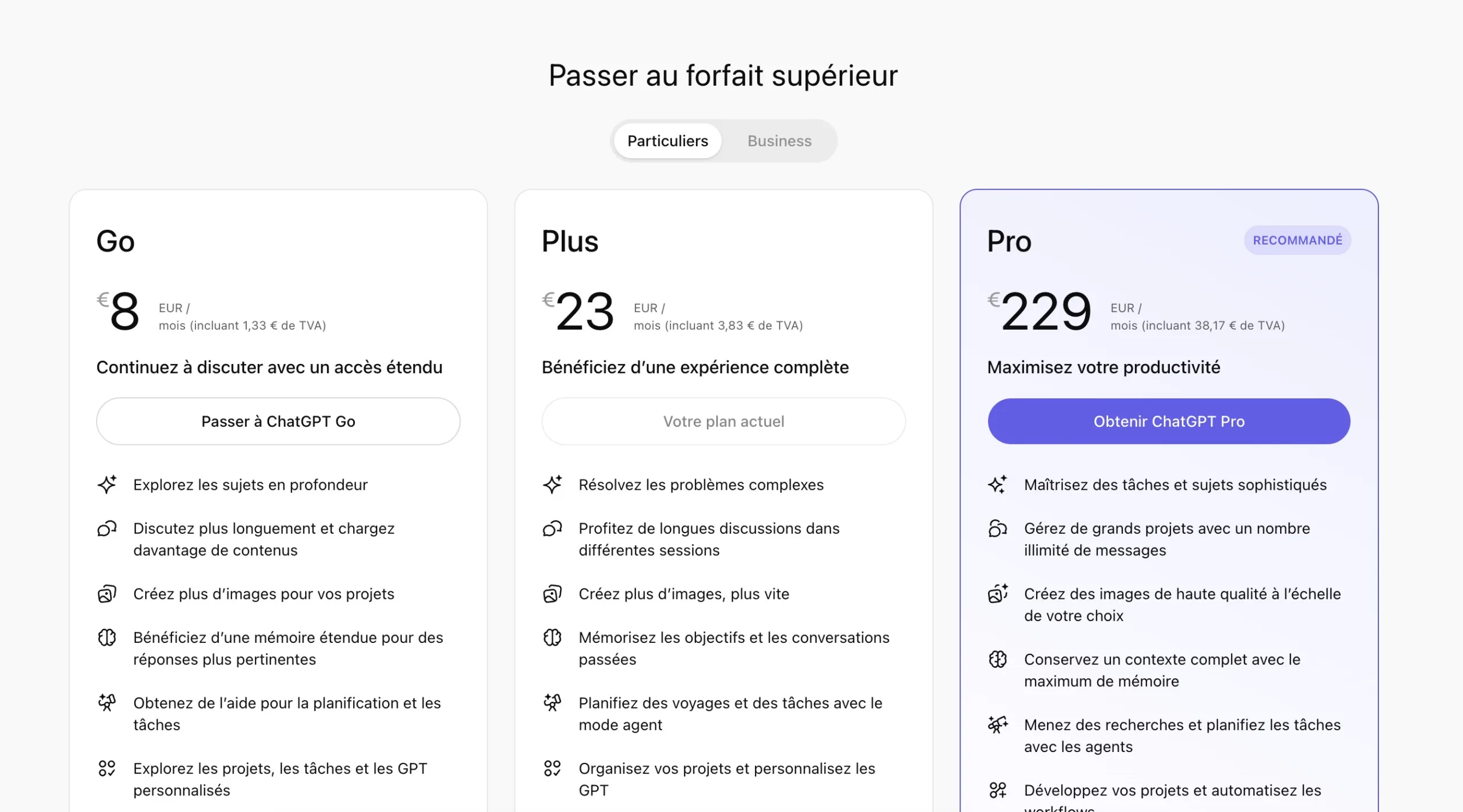

OpenAI a aussi récemment élargi ChatGPT Go à l’échelle mondiale (formule intermédiaire entre le gratuit et Plus), ce qui donne un sens économique au modèle « ads + abonnement abordable », sans toucher aux offres premium « sans pubs ».

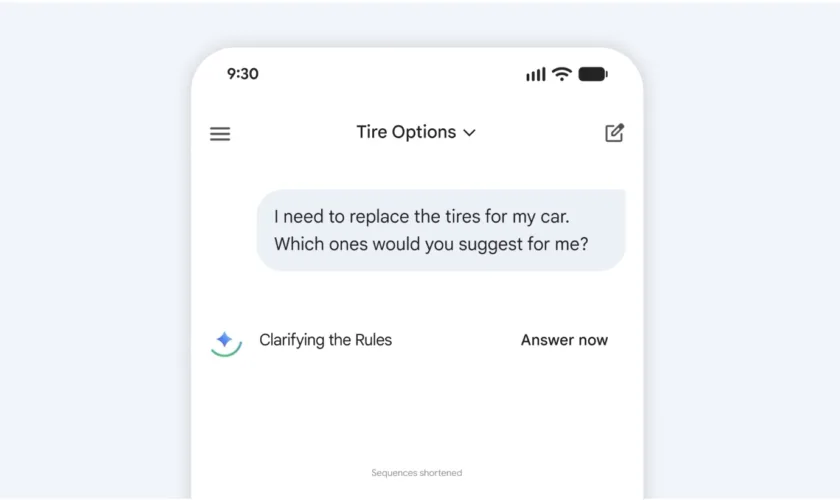

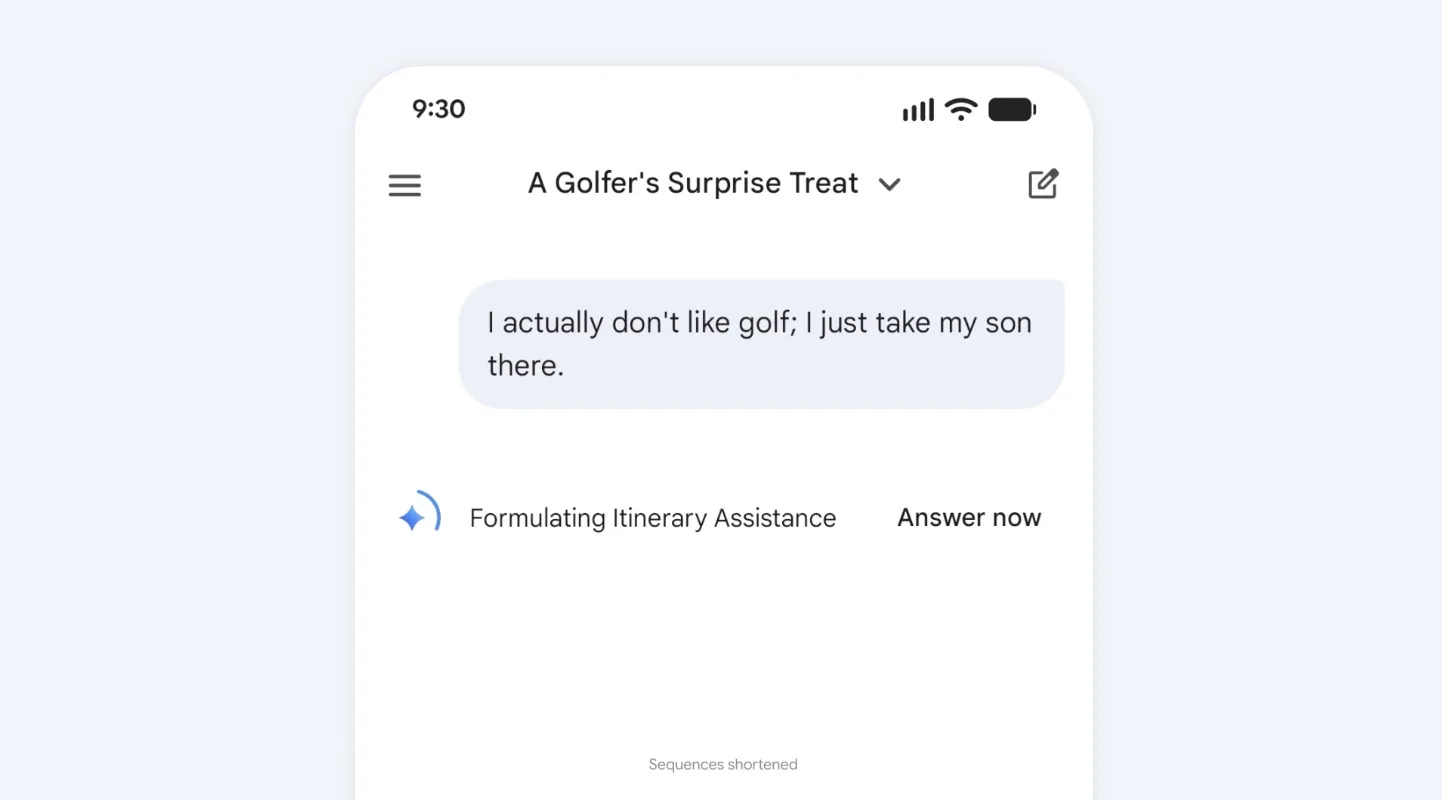

La pub dans un assistant n’est pas la pub dans un moteur de recherche

Le point soulevé par Hassabis est central : dans la recherche, l’utilisateur formule une intention (« acheter X », « comparatif Y »), et la pub s’insère dans une logique transactionnelle. Dans un assistant, la frontière est plus floue : on demande un conseil, on délègue une décision, on s’appuie sur une recommandation — et la suspicion d’influence devient immédiatement toxique, même si la pub est « bien séparée ».

C’est probablement pour cela que Google temporise : Gemini est encore en phase d’installation (produit, usages, fiabilité), et la publicité est un amplificateur de méfiance si le socle n’est pas perçu comme solide. À l’inverse, OpenAI assume une stratégie de financement plus hybride, poussée par l’échelle d’usage (des centaines de millions d’utilisateurs) et le coût de l’infrastructure.

Une « guerre du confort » et de la confiance

À court terme, l’écart est limpide :

- Gemini : pas de pubs annoncées « pour le moment », focus sur l’expérience et la confiance.

- ChatGPT : arrivée progressive d’annonces sur les offres gratuites/abordables (Free + Go), avec un test d’abord limité aux États-Unis.

La suite dépendra d’une seule variable : la tolérance du public. Si les pubs restent rares, pertinentes, et réellement séparées de la réponse, OpenAI peut créer un précédent « acceptable ». Si elles deviennent intrusives, elles offriront à Google un argument marketing en or : l’assistant premium, c’est celui qui ne vous vend rien.