Après l’image (et le phénomène viral autour de Nano Banana), Google pousse Gemini un cran plus loin : Lyria 3, le modèle de génération musicale de DeepMind, débarque dans l’app Gemini avec une promesse très grand public — créer des morceaux de 30 secondes à partir d’un simple texte… ou carrément d’une photo et même d’une vidéo.

L’objectif est limpide : faire de Gemini un atelier créatif tout-en-un où l’on passe de l’idée au contenu partageable sans quitter la conversation.

Introducing Lyria 3, our new music generation model in Gemini that lets you turn any idea, photo, or video into a high-fidelity track with custom lyrics.

From funny jingles to lo-fi beats, you can create custom 30-second soundtracks for any moment.

See how it works. 🧵

– Google Gemini (@GeminiApp) February 18, 2026

Lyria 3, c’est quoi exactement ?

Lyria 3 est présenté par Google DeepMind comme son modèle de génération musicale le plus avancé, conçu pour produire des pistes « haute fidélité » et couvrir de nombreux styles, avec la possibilité d’ajouter paroles et voix (lyrics & vocals) selon les cas d’usage.

Dans Gemini, l’usage est pensé comme un « outil » : vous décrivez un genre, une ambiance, un tempo, un thème — et le modèle génère une boucle/morceau court que vous pouvez réutiliser comme jingle, fond sonore ou « mini-track » pour un post.

Ce qui distingue Lyria 3 dans Gemini, c’est le côté vibe-matching :

- prompt texte → musique

- image ou vidéo → musique qui colle à l’atmosphère visuelle, avec des paroles si vous le souhaitez (ou instrumentale).

C’est une bascule : on ne demande plus seulement à l’IA de « composer », on lui demande de traduire une scène en bande-son. Et c’est exactement le type de feature qui alimente les usages TikTok/Shorts/Reels.

Disponibilité : déploiement global, mais cadré

1) Text to Tracks:

Describe a specific genre, mood, or topic to create unique tracks with lyrics or instrumental audio that fits your vibe.

For example, you could prompt, “Create a 90’s skate punk rock track to tell my roommate Ryan to wash the dishes, high energy, fast drums.”

– Google Gemini (@GeminiApp) February 18, 2026

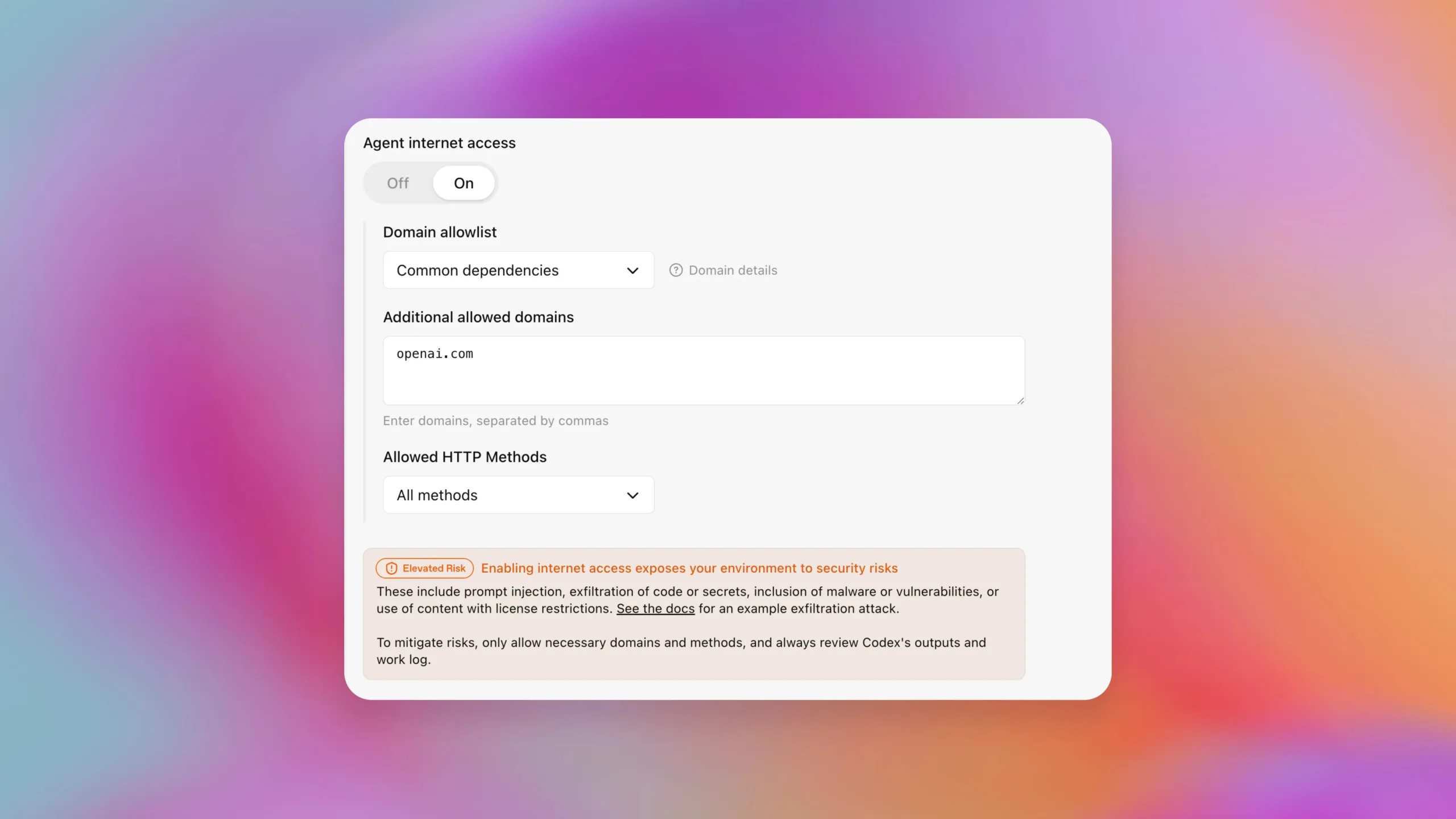

Google indique que la fonctionnalité arrive en bêta dans Gemini, avec un déploiement large accessible aux utilisateurs 18+, et disponible « globalement », avec une première liste de langues (dont le français).

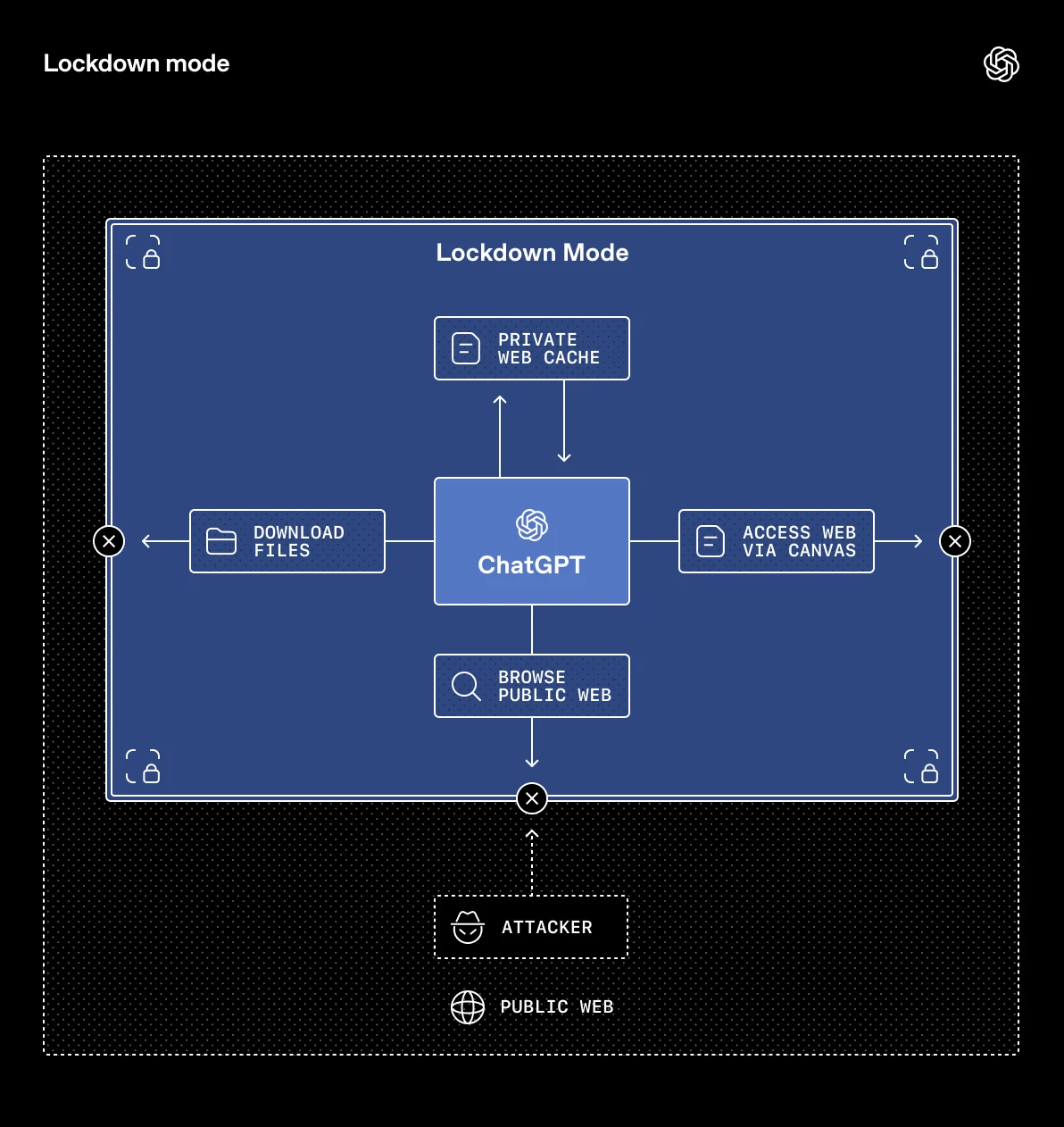

Google sait que la musique générée est un terrain miné. Sa réponse : SynthID, un watermark imperceptible intégré aux contenus, ici appliqué à l’audio généré via Gemini. Google affirme que toutes les pistes créées via cette fonction sont marquées, et Gemini peut aussi aider à détecter si un fichier audio contient ce watermark. DeepMind détaille d’ailleurs que SynthID vise à rester robuste face à des transformations courantes (compression, bruit, changement de vitesse).

Côté garde-fous, Google dit aussi chercher à éviter l’imitation directe d’artistes, un sujet qui a déjà explosé avec d’autres acteurs de la génération musicale.

Google vise l’usage « social » plus que la production pro

Le format 30 secondes est un indice fort : ce n’est pas une DAW, c’est un générateur de morceaux courts, réutilisables, shareables. Autrement dit, Google courtise moins les compositeurs que les créateurs de contenus, les petites équipes marketing, et tous ceux qui veulent une musique « à moi » sans passer par une librairie.

Et c’est aussi une façon de repositionner Gemini : plus qu’un assistant, un studio multimodal, où texte + image + vidéo + audio deviennent des matières interchangeables.