Le marché de la vidéo générative a changé de rythme : on n’y « teste » plus des démos, on y industrialise des workflows. Avec Grok Imagine 1.0, xAI annonce une mise à jour majeure axée sur trois obsessions très produit — qualité, latence, coût — et revendique un chiffre destiné à marquer les esprits : 1,245 milliard de vidéos générées en 30 jours.

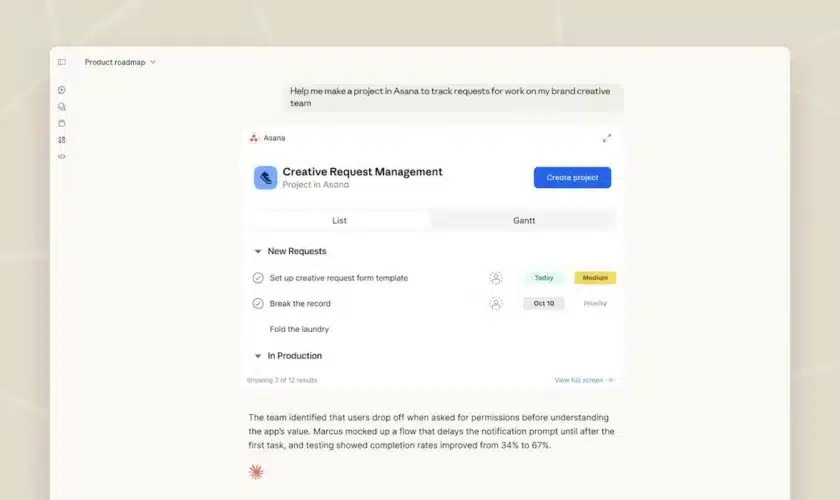

L’enjeu n’est plus de produire un clip impressionnant une fois sur dix. C’est de répéter, d’itérer, d’éditer — comme on le ferait dans un pipeline créatif. C’est exactement la promesse mise en avant dans l’annonce « wide release » : un Grok Imagine 1.0 « plus rapide », « plus efficace » et plus agréable à faire boucler pour les créateurs comme pour les développeurs.

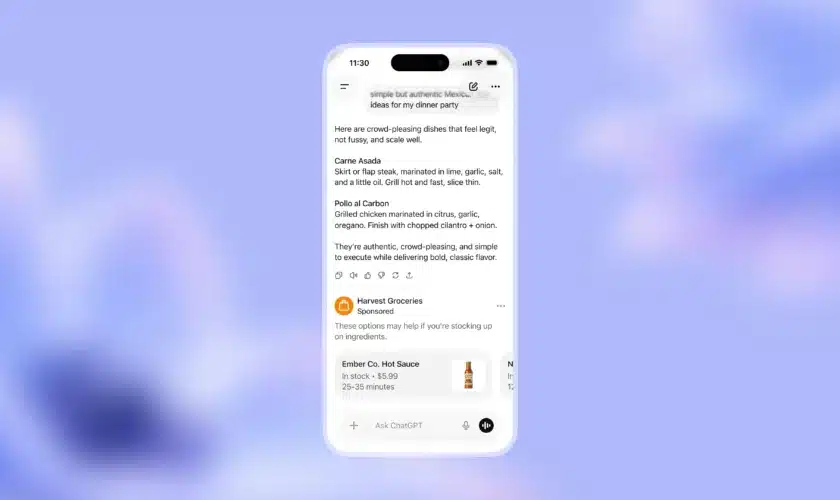

Cette stratégie, xAI la pousse aussi côté intégration : la génération n’est plus un gadget isolé dans une app, elle devient un service — via une API pensée comme un point d’entrée unique.

Introducing Grok Imagine 1.0, our biggest leap yet.

1.0 unlocks 10-second videos, 720p resolution, and dramatically better audio.

Imagine has generated 1.245 billion videos in the last 30 days alone.

Try it now: https://t.co/zGhs9czkC5 pic.twitter.com/7FPxm7H059

— xAI (@xai) February 2, 2026

Ce que Grok Imagine 1.0 apporte concrètement

Sur la fiche « capabilities », Grok Imagine 1.0 vise un format court mais exploitable :

- Jusqu’à 10 secondes de vidéo en 720p.

- Audio amélioré, présenté comme « dramatiquement meilleur » (xAI insiste beaucoup sur la synchro et le rendu).

- Text-to-video et image-to-video, avec une meilleure gestion du mouvement, des interactions d’objets et de la continuité visuelle.

- Accès direct via l’interface Grok Imagine (web/app).

Ce n’est pas le format « film » — c’est le format réseaux, le format storyboard, le format itération rapide. Dit autrement : xAI semble parier que la valeur se trouve moins dans la durée que dans le débit créatif.

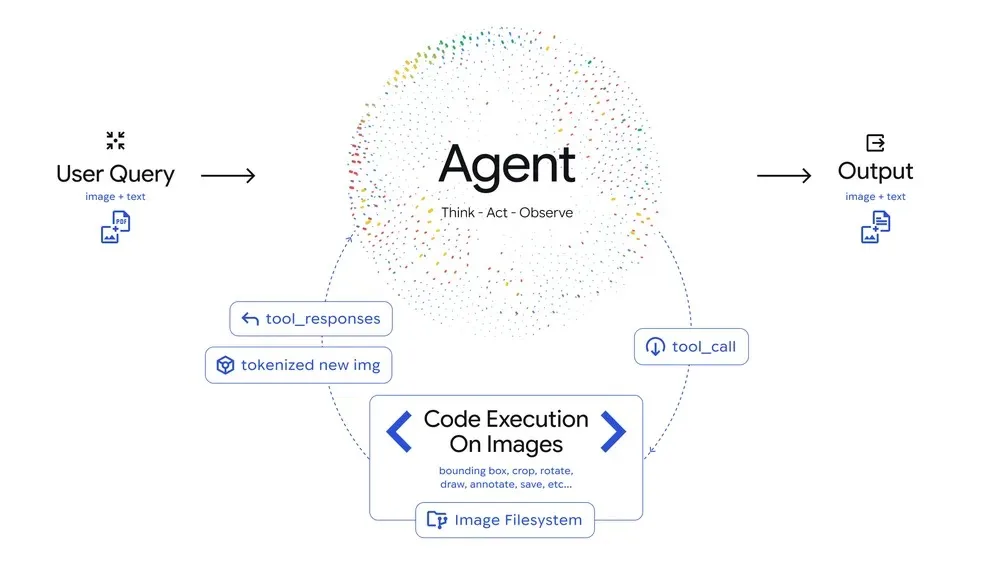

Grok Imagine API, l’édition intégrée comme différenciateur

Le vrai mouvement stratégique est peut-être là. L’API Grok Imagine est décrite par xAI comme un bundle unifié pour des workflows « end-to-end », où la génération et l’édition cohabitent.

L’idée : éviter le ping-pong entre outils (génération → export → éditeur → retouches → re-export), et permettre dans un même flux :

- générer une séquence à partir d’un prompt ou d’une image,

- raffiner une scène « cinématique »,

- éditer (ajouter/retirer/remplacer des éléments, changer l’ambiance, restyler),

- et repartir immédiatement en itération.

Côté développeurs, xAI met aussi en avant une intégration « API-first » plus large : la plateforme indique une compatibilité avec les SDKs type OpenAI/Anthropic via changement d’URL/base, ce qui vise à réduire la friction d’adoption.

L’adoption « à grande échelle » aura un prix — et pas seulement en dollars

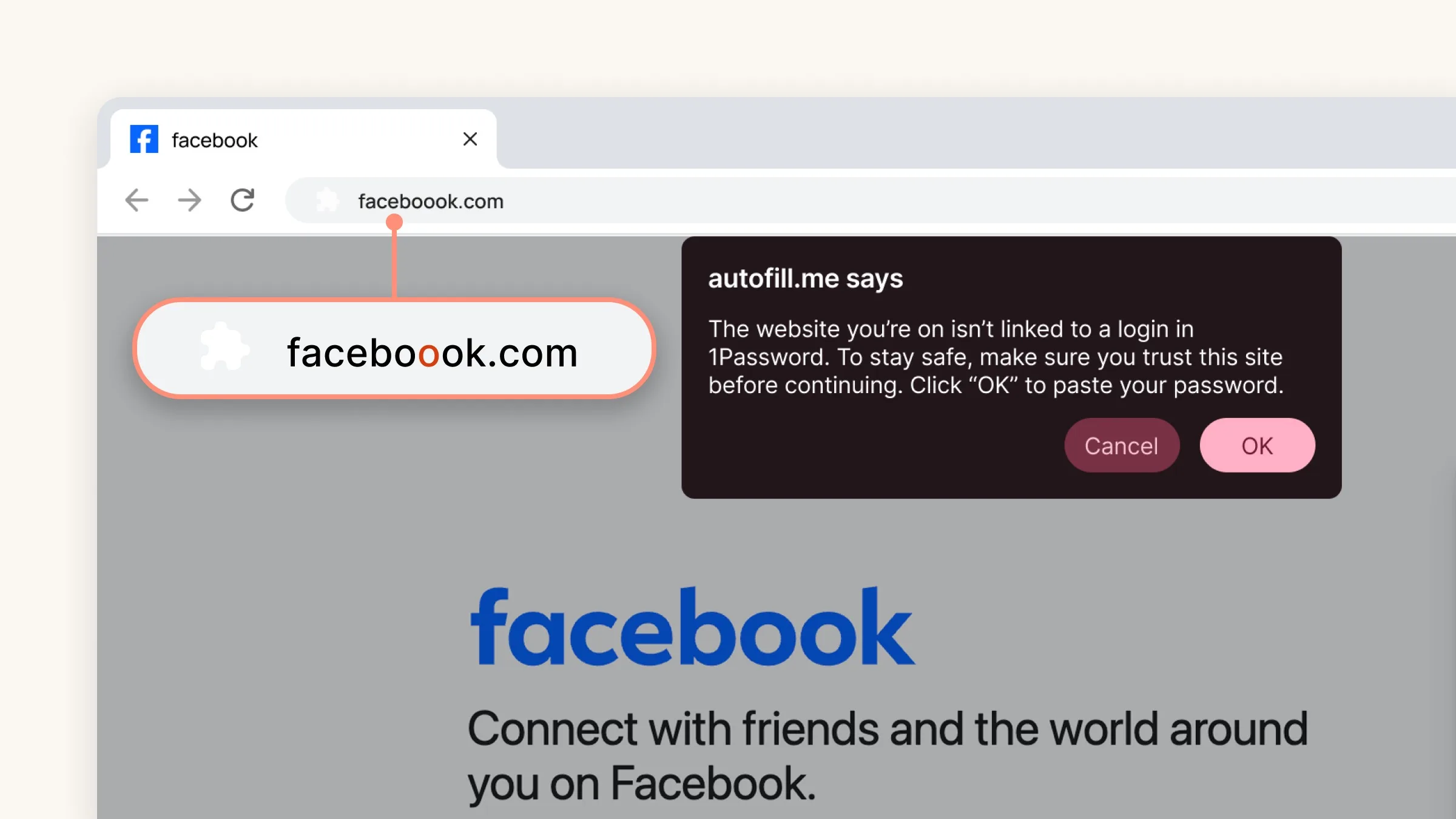

Revendiquer 1,245 milliard de vidéos en 30 jours, c’est installer une narration : « nous sommes déjà en production massive ». Mais, cette montée en puissance remet aussi au centre une question que la vidéo générative rend impossible à esquiver : la sécurité et l’abus.

Ces dernières semaines, Grok et ses outils d’édition d’image ont été au cœur de controverses liées à la génération de contenus non consensuels et sexualisés, avec des réactions politiques et réglementaires rapportées par plusieurs médias. Et la vidéo, par nature, augmente encore l’impact : elle rend le faux plus « vivant », plus viral, plus difficile à contester.

C’est là que la stratégie d’xAI sera jugée au-delà des benchmarks : qualité + vitesse ne suffisent plus. Le marché attend aussi des garde-fous crédibles, des politiques de modération, des mécanismes d’empreinte/traçabilité — bref, une maturité produit à la hauteur de l’ambition.

Face à OpenAI et Google (qui poussent eux aussi leurs modèles vidéo), xAI joue une carte très « plateforme » : du contenu court, vite produit, et désormais pilotable via API avec de l’édition intégrée.