OpenAI vient de publier des chiffres qui ressemblent moins à un point d’étape qu’à un changement d’échelle. ChatGPT revendique désormais plus de 900 millions d’utilisateurs actifs par semaine et plus de 50 millions d’abonnés payants, à quelques encablures du seuil symbolique du milliard.

Dans le même mouvement, l’entreprise annonce 110 milliards de dollars de financement privé sur une base de valorisation pré-money à 730 milliards, l’une des opérations les plus massives de l’histoire du capital privé tech.

ChatGPT : La croissance « produit » devient une croissance « infrastructure »

La progression est brutale : OpenAI parlait d’environ 800 millions de WAU en octobre 2025 ; elle ajoute donc 100 millions en quelques mois. Dans son annonce, OpenAI insiste sur un narratif très « industrie » : plus l’usage monte, plus l’expérience s’améliore « immédiatement » (rapidité, fiabilité, sécurité, constance).

Et surtout : janvier et février seraient en passe d’être les meilleurs mois historiques en nouveaux abonnés.

Ce renversement est clé : à ce stade, l’enjeu n’est plus seulement d’attirer, mais de tenir la charge. D’où la cohérence du timing entre chiffres d’usage et annonce financière.

Les chiffres qui comptent : abonnés, usage… et le carburant derrière

Sur le financement, trois noms structurent l’opération :

- Amazon : 50 milliards de dollars

- Nvidia : 30 milliards de dollars

- SoftBank : 30 milliards de dollars

- … pour 110 milliards de dollars au total, sur une valorisation pré-money de 730 milliards de dollars (round encore ouvert).

Plus intéressant encore : Reuters indique une valorisation post-money évoquée à 840 milliards $, et détaille des ramifications industrielles (capacité de calcul, systèmes Nvidia de nouvelle génération, et rôle accru d’AWS) tout en rappelant que le partenariat Azure de Microsoft demeure central pour l’API.

OpenAI verrouille la chaîne de valeur… du produit jusqu’au silicium

Cette annonce dit quelque chose de très précis sur la nouvelle bataille de l’IA :

- La différenciation ne se joue plus uniquement sur le modèle, mais sur l’accès stable et massif au calcul (puces, data centers, énergie) — autrement dit, l’IA comme industrie lourde.

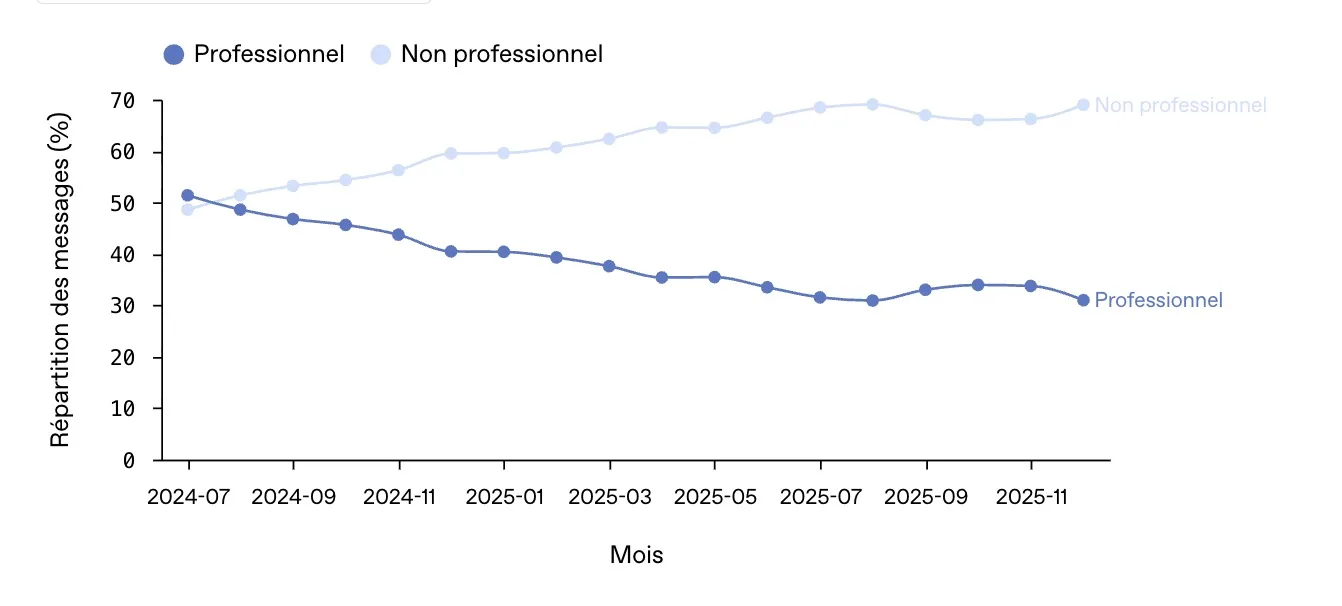

- Le passage de « l’outil » à « l’infrastructure » : 50 millions d’abonnés, c’est un plancher de revenus et une preuve de traction de clients qui rassure les investisseurs sur la durée, pas seulement sur l’effet de mode.

- L’équilibre géopolitique du cloud : l’entrée d’Amazon comme « fournisseur de cloud tiers exclusif » pour certains volets ressemble à une diversification assumée, sans rupture affichée avec Microsoft. Traduction : OpenAI veut réduire le risque de dépendance tout en sécurisant des volumes de compute.

Au fond, OpenAI achète une chose : du temps. Du temps de calcul, du temps d’exécution, du temps de disponibilité. Et dans l’ère agentique (où l’IA agit, pas seulement répond), le temps devient la ressource la plus chère.

Ce que ça change pour le marché : le « milliard » n’est pas qu’un trophée

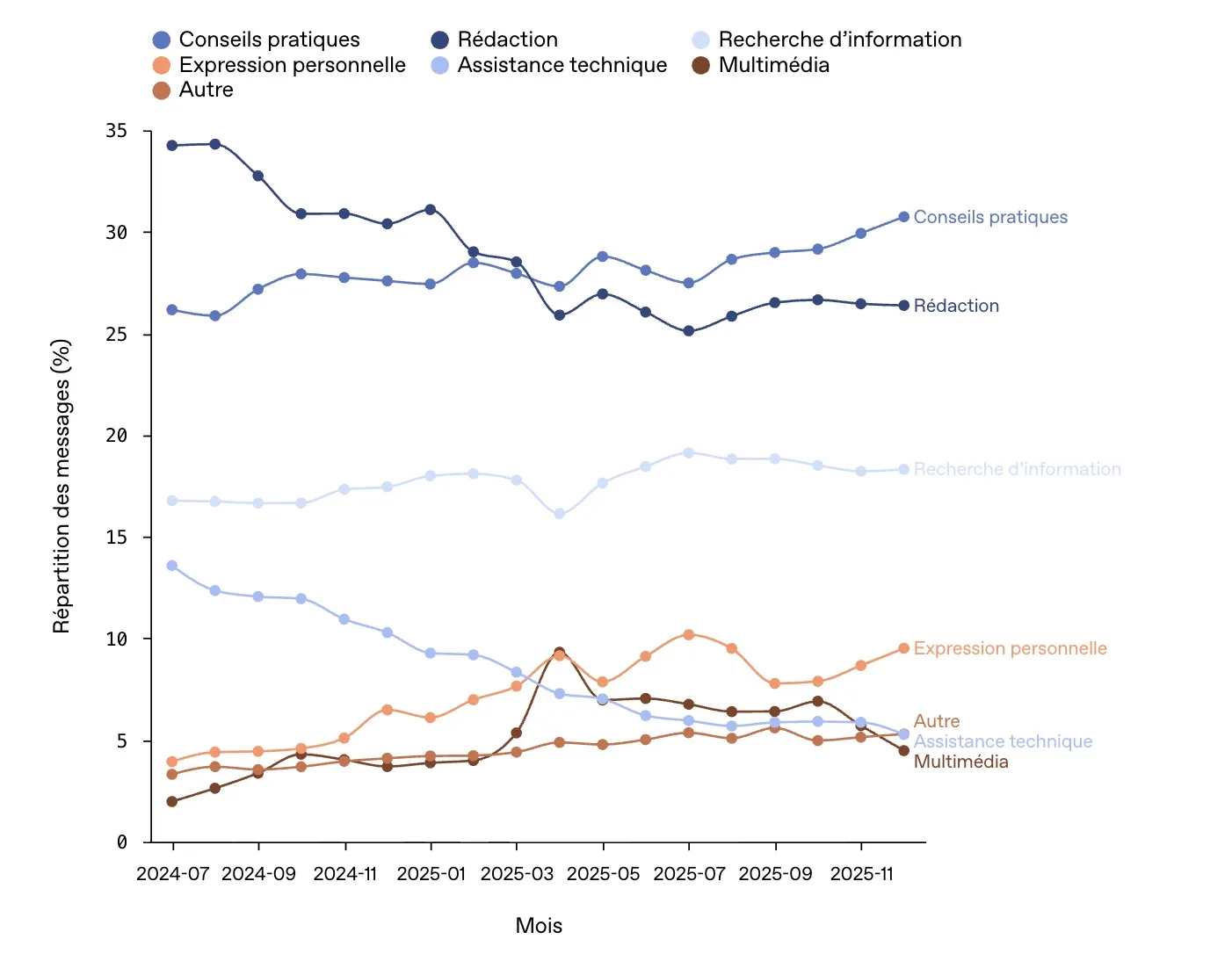

Atteindre 1 milliard d’utilisateurs hebdomadaires, ce serait plus qu’un record : ce serait un signal de plateforme universelle, comparable aux plus gros produits de clients mondiaux. Mais même avant ce cap, un fait ressort : OpenAI se positionne comme une couche transversale — apprentissage, écriture, planification, construction — avec une monétisation qui accélère.

Reste l’autre lecture, plus froide : ce niveau de valorisation et de financement intensifie la pression sur la fiabilité, la sécurité et les coûts. Plus la base d’utilisateurs grossit, plus la promesse doit être tenue — partout, tout le temps.