On l’attendait comme le « moment iPhone » de l’IA grand public : un objet pensé par Jony Ive, porté par OpenAI, capable de faire oublier le smartphone pendant quelques minutes — voire plus.

Sauf que la réalité rattrape le mythe : OpenAI ne prévoit pas d’expédier son premier appareil hardware avant la fin février 2027, selon une déclaration de Peter Welinder (VP & GM chez OpenAI) dans un document judiciaire repéré par WIRED.

Derrière cette date, il y a un détail révélateur : l’appareil reste suffisamment secret pour que l’entreprise affirme ne pas avoir encore produit de packaging ni de supports marketing.

Une affaire de marque (« io ») qui force OpenAI à clarifier le calendrier

La précision « fin février 2027 » n’est pas sortie d’un événement produit, mais d’un litige de marque : la startup audio iyO a attaqué OpenAI après l’acquisition de la startup de Jony Ive, io, entraînant un bras de fer autour de noms jugés trop proches.

Dans le même dépôt, Welinder indique que OpenAI a décidé de ne pas utiliser « io », « IYO » ni aucune variation de capitalisation pour ses produits.

En clair : non seulement le produit prend du retard, mais l’identité sous laquelle il devait naître est officiellement abandonnée.

Un « compagnon sans écran » plutôt qu’un pin ou des écouteurs

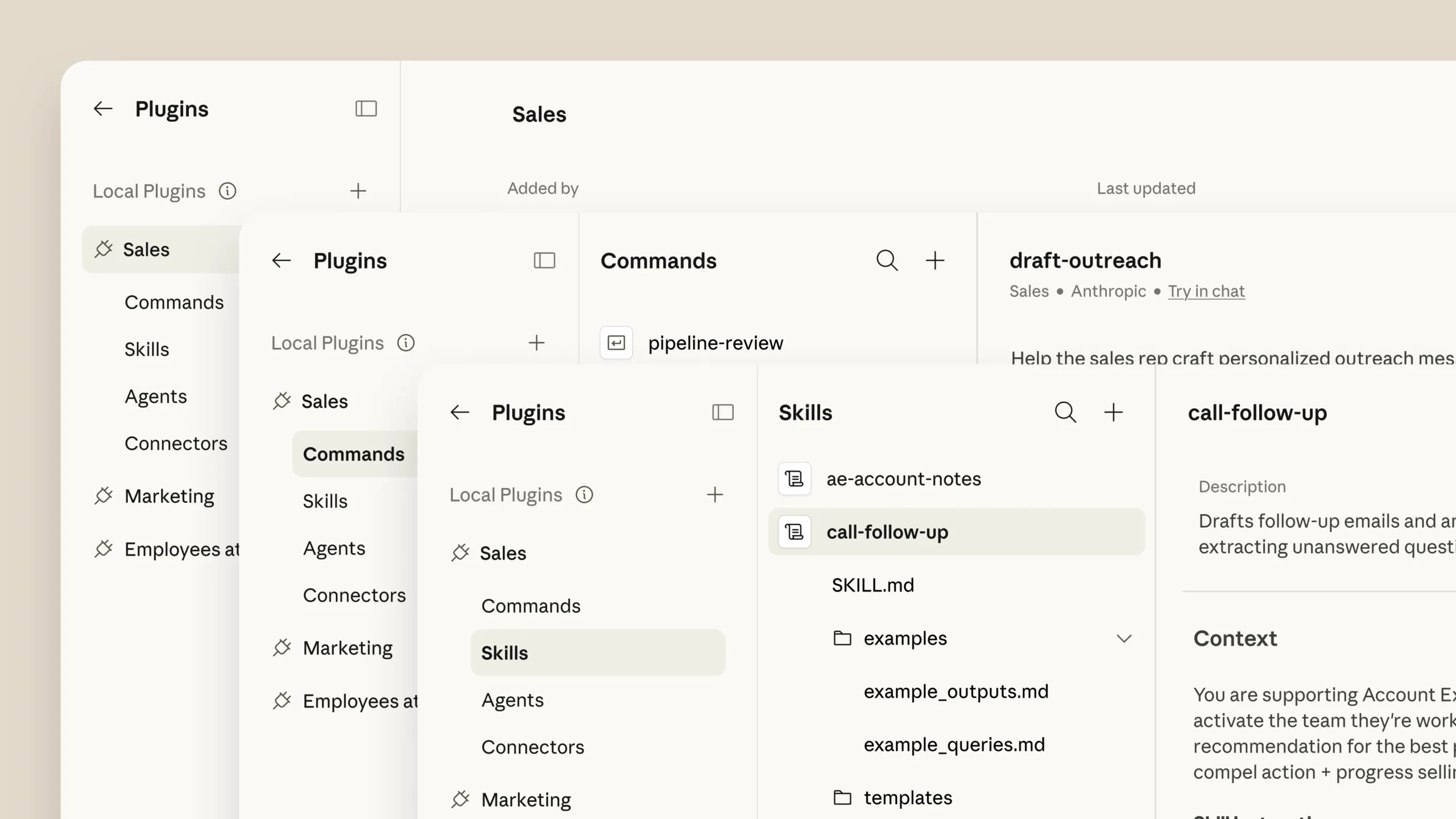

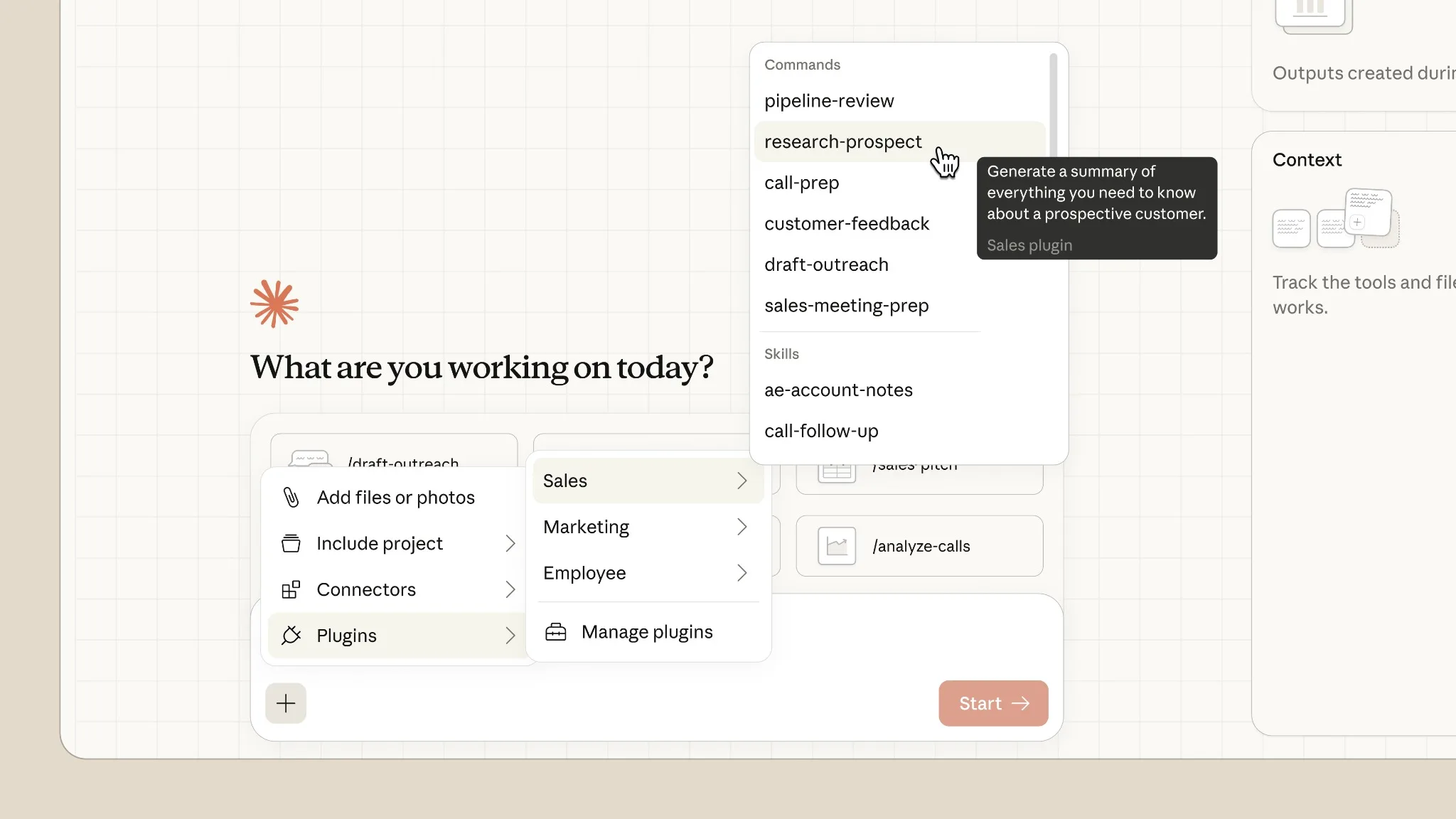

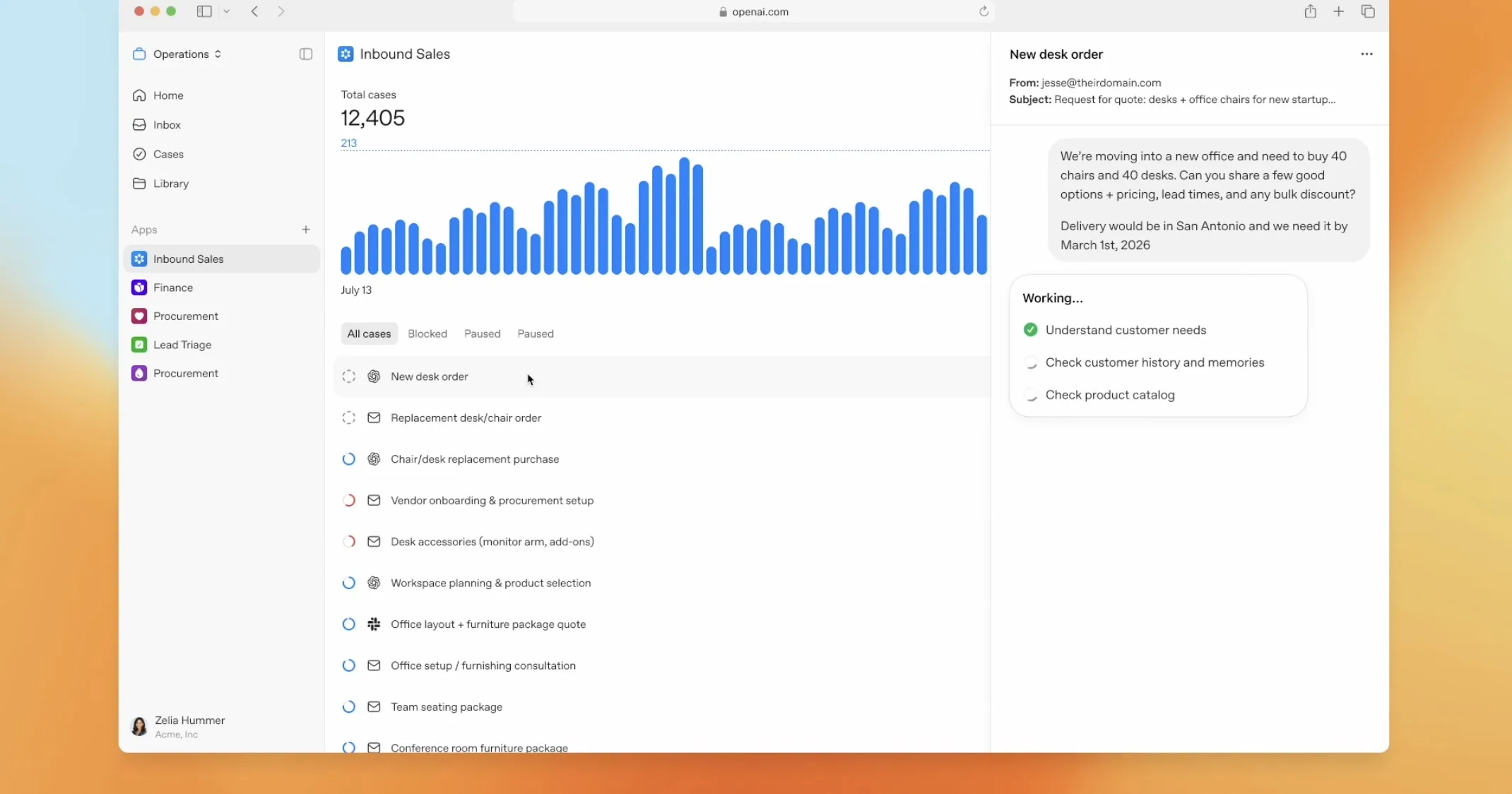

Selon WIRED, OpenAI viserait un appareil compagnon sans écran, conçu pour fonctionner aux côtés des téléphones et des ordinateurs — une approche qui tranche avec les « AI gadgets » façon pin, souvent mal reçus car redondants ou trop limités.

Et, cela colle à la ligne officielle d’OpenAI au moment où Sam Altman et Jony Ive évoquaient l’ambition de créer « une famille d’appareils IA » (sans jamais détailler la forme).

Ce report à 2027 dit trois choses :

- Le hardware ne pardonne pas. Contrairement aux modèles, on ne « ship » pas une itération toutes les deux semaines. Un nouvel objet impose industrialisation, chaîne d’approvisionnement, conformité, SAV… et tout ce qui fait l’ADN d’Apple.

- L’IA grand public doit gagner sa place. Les échecs récents ont montré qu’un « assistant » dédié ne suffit pas : il faut un usage quotidien évident, pas une démo.

- OpenAI apprend à parler comme une entreprise produit. La mention « pas de packaging » ressemble à une façon de dire : on n’est pas encore au stade où l’on vend une histoire — on construit encore la machine.

Ce qu’il faut surveiller maintenant

Une annonce (ou démo) en 2026 reste possible, même si les expéditions glissent à 2027 — Business Insider note que le calendrier public reste flou. Le nouveau nom : OpenAI ayant renoncé à « io », toute la stratégie de branding est à réinventer. Le positionnement : « compagnon sans écran » peut être un coup de génie… ou un piège si l’expérience n’est pas radicalement meilleure que celle d’un smartphone + AirPods.

OpenAI veut entrer dans le matériel, mais le dossier judiciaire rappelle une vérité brutale : avant de réinventer l’informatique personnelle, il faut déjà pouvoir l’expédier.