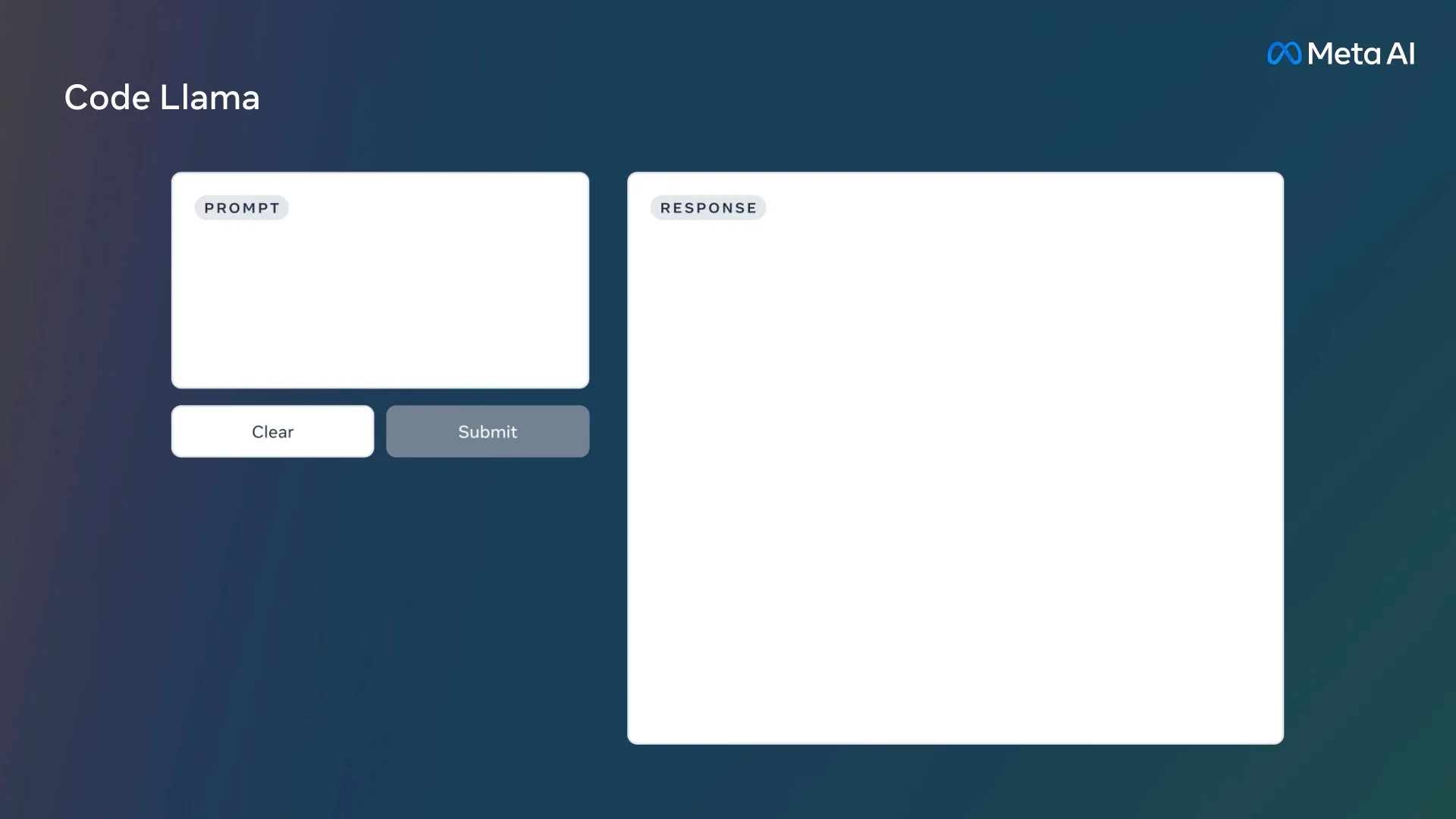

Après avoir publié des modèles d’IA générative capables de traiter le contenu textuel, l’audio et la traduction, Meta s’intéresse désormais au code. L’entreprise a lancé Code Llama, une version de son grand modèle linguistique spécialement conçu pour le codage, et construit à partir de son modèle de langage Llama 2. À la base, ce modèle prend des invites textuelles et les transforme en code de la même manière que ChatGPT et DALL-E2 répondraient si on leur demandait respectivement d’écrire quelques paragraphes ou de créer une image.

Meta ne sera pas le premier acteur à pousser les intelligences de l’IA générative dans le monde du codage. Par exemple, Microsoft a récemment intégré des capacités GPT-4 dans le système GitHub Copilot pour aider les développeurs. En avril 2023, Google a également doté son IA Bard de capacités de raisonnement et de mathématiques avancées, ce qui lui permet de contribuer à des tâches de programmation telles que la génération de code. Avec Code Llama, Meta souhaite permettre aux utilisateurs de générer du code original et d’obtenir de l’aide pour corriger leur code existant.

« Il a le potentiel de rendre les workflows plus rapides et plus efficaces pour les développeurs et d’abaisser la barrière à l’entrée pour les personnes qui apprennent à coder », explique Meta. Il est intéressant de noter que les invites données par les utilisateurs peuvent être soit en langage naturel, soit sous forme d’extraits de code.

Selon la nature de l’invite, Code LLama peut générer du nouveau code, agir comme une sorte de moteur d’auto-complétion (comme GitHub Copilot) et aider à résoudre les bogues. Pour l’instant, Code LLama prend en charge certains des langages de programmation les plus courants, notamment C++, Python, JavaScript et PHP.

Meta a entraîné Code Llama sur des ensembles de données comprenant, comme on peut s’y attendre, des extraits de code. L’entreprise affirme que Code Llama a devancé ses concurrents dans des tests de codage populaires tels que HumanEval. Meta commercialise Code Llama en trois tailles : 7 milliards de paramètres, 13 milliards de paramètres et 34 milliards de paramètres. Le modèle bas de gamme sera utile pour les tâches moins exigeantes, tandis que le modèle haut de gamme a des besoins matériels plus exigeants, mais aussi de plus grandes capacités.

Par exemple, le niveau de base 7B peut être exécuté sur une machine dotée d’un seul GPU ; il convient aux tâches à faible latence telles que la complétion de code. Le modèle 13B offre une capacité de remplissage au milieu (FIM) légèrement plus puissante, tandis que la variante 34B est destinée aux experts qui recherchent une assistance au code avancée avec la génération de code lourd, l’insertion de blocs et le débogage — à condition qu’ils disposent du matériel nécessaire pour le gérer.

En outre, Meta a créé deux autres variantes de Code Llama en fonction de l’environnement de codage. Code Llama Python cible Python, qui est l’un des langages de programmation les plus efficaces et les plus largement utilisés pour les tâches d’IA et d’apprentissage automatique. L’autre itération est Code Llama — Instruct, qui convient mieux aux invites en langage naturel et s’adresse aux non-experts qui cherchent à générer du code. Bien sûr, il n’est pas parfait, mais Meta affirme qu’il fournit des réponses plus sûres que ses concurrents.

Meta a publié Code Llama sur GitHub en même temps qu’un document de recherche qui offre un aperçu plus approfondi de l’outil d’IA générative spécifique au code.