L’ère de l’intelligence artificielle est arrivée, et l’IA générative joue un rôle essentiel en apportant des avancées sans précédent à la technologie quotidienne. Il existe déjà plusieurs outils d’IA gratuits qui peuvent vous aider à générer des images, des textes, de la musique, des vidéos et bien d’autres choses encore en quelques secondes. Le remplissage génératif AI d’Adobe dans Photoshop et les capacités étonnantes de Midjourney nous ont en effet surpris.

Mais qu’est-ce que l’IA générative et comment alimente-t-elle une innovation aussi rapide ?

Comme son nom l’indique, l’IA générative désigne un type de technologie d’IA capable de générer un nouveau contenu à partir des données sur lesquelles elle a été formée. Elle peut générer des textes, des images, des sons, des vidéos et des données synthétiques. L’IA générative peut produire un large éventail de résultats sur la base des entrées de l’utilisateur ou de ce que nous appelons des « invites ». L’IA générative est essentiellement un sous-domaine de l’apprentissage automatique qui peut créer de nouvelles données à partir d’un ensemble de données donné.

Si le modèle a été entraîné sur de grands volumes de texte, il peut produire de nouvelles combinaisons de textes à consonance naturelle. Plus les données sont importantes, meilleur sera le résultat. Si l’ensemble de données a été nettoyé avant l’entraînement, vous obtiendrez probablement une réponse nuancée.

Qu’est-ce que l’IA générative et pourquoi est-elle importante ?

De même, si vous avez entraîné un modèle à l’aide d’un vaste corpus d’images comportant un label, des légendes et de nombreux exemples visuels, le modèle d’IA peut apprendre à partir de ces exemples et procéder à la classification et à la génération d’images. Ce système sophistiqué d’IA programmé pour apprendre à partir d’exemples s’appelle un réseau neuronal.

Cela dit, il existe différents types de modèles d’IA générative. Il s’agit des GAN, Generative Adversarial Network (réseau antagoniste génératif), des autoencodeurs variationnels (VAE), des transformateurs génératifs pré-entrainés (GPT), des modèles autorégressifs, et bien d’autres encore. Je vais brièvement évoquer ces modèles génératifs ci-dessous.

Actuellement, les modèles GPT sont devenus populaires après la publication de GPT-4/3.5 (ChatGPT), PaLM 2 (Google Bard), GPT-3 (DALL – E), LLaMA (Meta), Stable Diffusion, et d’autres. Toutes ces interfaces d’IA conviviales sont construites sur l’architecture Transformer. Dans cet article, nous allons donc nous concentrer sur l’IA générative et GPT (Generative Pretrained Transformer).

Quels sont les différents types de modèles d’IA générative ?

Parmi tous les modèles d’IA générative, GPT est privilégié par beaucoup, mais commençons par le GAN.

Dans une architecture GAN, deux réseaux parallèles sont formés, dont l’un est utilisé pour générer du contenu (appelé générateur) et l’autre évalue le contenu généré (appelé discriminateur). Fondamentalement, l’objectif est d’opposer deux réseaux neuronaux afin d’obtenir des résultats qui reflètent les données réelles. Les modèles basés sur les GAN ont été principalement utilisés pour les tâches de génération d’images.

Ensuite, nous avons l’autoencodeur variationnel (VAE), qui implique le processus d’encodage, d’apprentissage, de décodage et de génération de contenu. Par exemple, si vous avez l’image d’un chien, l’autoencodeur décrit la scène (couleur, taille, oreilles, etc.), puis apprend les caractéristiques d’un chien. Ensuite, il recrée une image approximative à l’aide de points clés, ce qui donne une image simplifiée. Enfin, il génère l’image finale après avoir ajouté davantage de variété et de nuances.

En ce qui concerne les modèles autorégressifs, ils sont proches du modèle T et Transformer mais manquent d’auto-attention. Il est principalement utilisé pour générer des textes en produisant une séquence, puis en prédisant la partie suivante sur la base des séquences qu’il a générées jusqu’à présent. Ensuite, nous avons les modèles de normalisation des flux et les modèles basés sur l’énergie.

Qu’est-ce qu’un modèle GPT (Generative Pretrained Transformer) ?

Avant l’arrivée de l’architecture Transformer, les réseaux neuronaux récurrents (RNN) et les réseaux neuronaux convolutifs (CNN) comme les GAN et les VAE étaient largement utilisés pour l’IA générative. En 2017, des chercheurs travaillant chez Google ont publié un article fondateur intitulé « Attention is all you need » (Vaswani, Uszkoreit, et al., 2017) pour faire progresser le domaine de l’IA générative et créer quelque chose comme un grand modèle de langage (LLM).

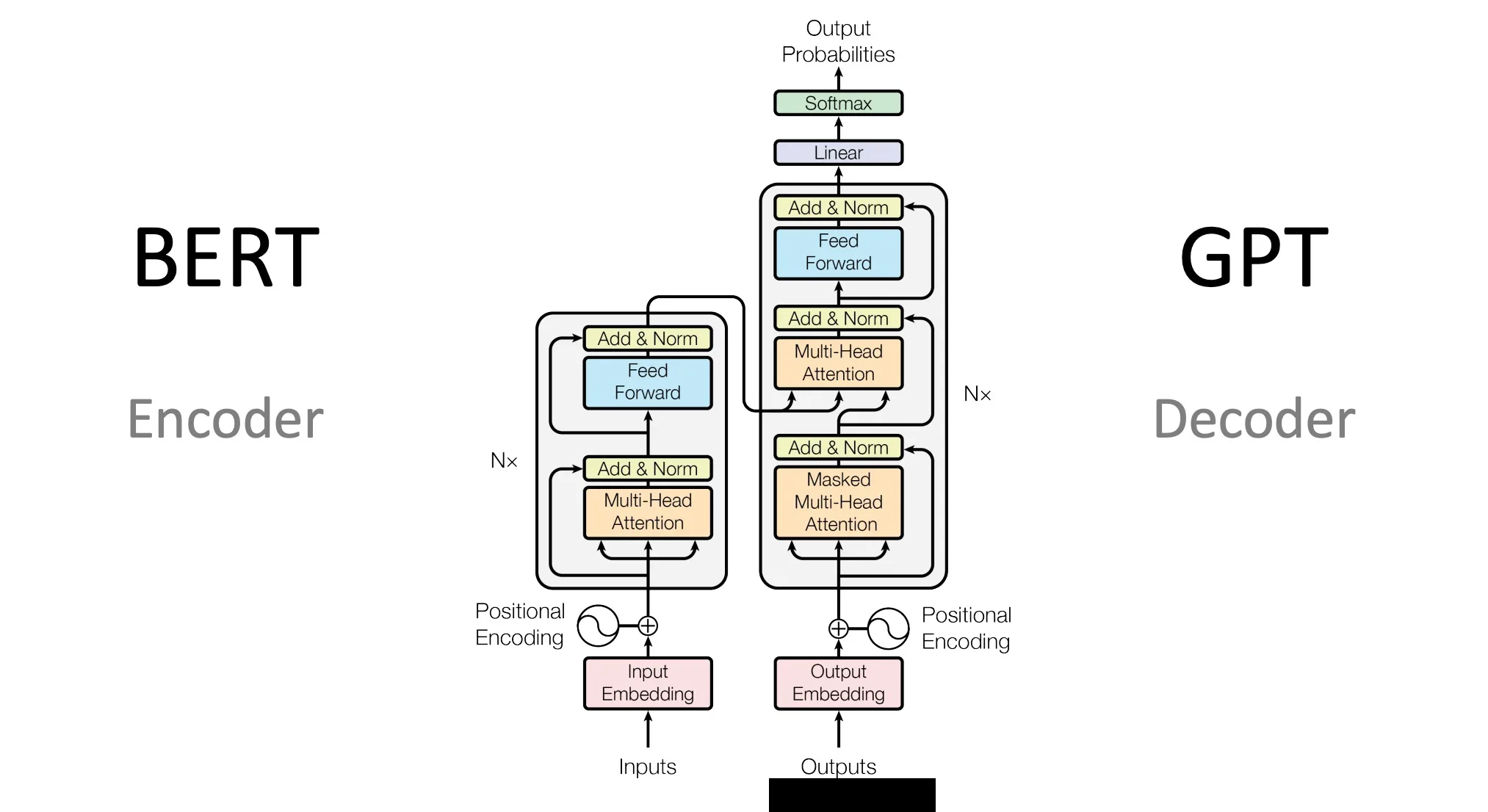

Google a ensuite publié le modèle BERT (Bidirectional Encoder Representations from Transformers) en 2018, qui met en œuvre l’architecture Transformer. Au même moment, OpenAI a publié son premier modèle GPT-1 basé sur l’architecture Transformer.

Quel est donc l’ingrédient clé de l’architecture Transformer qui en a fait un favori pour l’IA générative ? Comme l’article l’a justement intitulé, elle a introduit l’auto-attention, qui faisait défaut dans les architectures de réseaux neuronaux antérieures. Cela signifie qu’elle prédit le mot suivant dans une phrase à l’aide d’une méthode appelée Transformer. Il accorde une attention particulière aux mots voisins afin de comprendre le contexte et d’établir une relation entre les mots.

Grâce à ce processus, le Transformer développe une compréhension raisonnable de la langue et utilise ces connaissances pour prédire le mot suivant de manière fiable. L’ensemble de ce processus est appelé mécanisme d’attention.

« Pré-entraîné »

Ceci dit, il faut garder à l’esprit que les LLM sont appelés avec mépris perroquets stochastiques (Bender, Gebru, et al., 2021) parce que le modèle imite simplement des mots aléatoires sur la base de décisions probabilistes et de modèles qu’il a appris. Il ne détermine pas le mot suivant sur la base de la logique et n’a pas de véritable compréhension du texte.

Pour ce qui est du terme « pré-entraîné » dans GPT, il signifie que le modèle a déjà été entraîné sur une quantité massive de données textuelles avant même d’appliquer le mécanisme d’attention. En pré-entraînant les données, il apprend ce qu’est une structure de phrase, des modèles, des faits, des phrases, etc. Cela permet au modèle de bien comprendre le fonctionnement de la syntaxe du langage.

Comment Google et OpenAI abordent-ils l’IA générative ?

Google et OpenAI utilisent tous deux des modèles basés sur des Transformers respectivement dans Google Bard et ChatGPT. Cependant, il existe des différences majeures dans l’approche. Le dernier modèle PaLM 2 de Google utilise un encodeur bidirectionnel (mécanisme d’auto-attention et réseau neuronal de type feed-forward), ce qui signifie qu’il prend en compte tous les mots environnants. Il essaie essentiellement de comprendre le contexte de la phrase et génère ensuite tous les mots à la fois. L’approche de Google consiste essentiellement à prédire les mots manquants dans un contexte donné.

En revanche, ChatGPT d’OpenAI s’appuie sur l’architecture Transformer pour prédire le mot suivant dans une séquence — de gauche à droite. Il s’agit d’un modèle unidirectionnel conçu pour générer des phrases cohérentes. Il continue la prédiction jusqu’à ce qu’il ait généré une phrase complète ou un paragraphe. C’est peut-être la raison pour laquelle Google Bard est capable de générer des textes beaucoup plus rapidement que ChatGPT. Néanmoins, les deux modèles s’appuient sur l’architecture Transformer pour offrir des frontaux d’IA générative.

Applications de l’IA générative

Nous savons tous que l’IA générative a d’énormes applications non seulement pour le texte, mais aussi pour les images, les vidéos, la génération audio et bien d’autres choses encore. Les chatbots comme ChatGPT, Google Bard, Bing Chat, etc., tirent parti de l’IA générative. L’IA générative peut également être utilisée pour l’autocomplétion, le résumé de texte, l’assistant virtuel, la traduction, etc. Pour générer de la musique, nous avons vu des exemples comme Google MusicLM et récemment Meta a lancé MusicGen pour la génération de musique.

Par ailleurs, de DALL-E 2 à Stable Diffusion, tous utilisent l’IA générative pour créer des images réalistes à partir de descriptions textuelles. Dans la génération de vidéos également, les modèles Runway’s Gen-1, StyleGAN 2 et BigGAN s’appuient sur des réseaux adversoriels génératifs pour générer des vidéos réalistes. En outre, l’IA générative trouve des applications dans la génération de modèles 3D et certains des modèles les plus populaires sont DeepFashion et ShapeNet.

L’IA générative peut également être d’une aide précieuse dans la découverte de médicaments. Elle peut concevoir de nouveaux médicaments pour une maladie spécifique. Nous avons déjà vu des modèles de découverte de médicaments comme AlphaFold, développé par Google DeepMind. Enfin, l’IA générative peut être utilisée pour la modélisation prédictive afin de prévoir des événements futurs dans les domaines de la finance et de la météorologie.

Limites de l’IA générative

Si l’IA générative possède d’immenses capacités, elle n’est pas exempte de défauts. Tout d’abord, elle nécessite un large corpus de données pour entraîner un modèle. Pour de nombreuses petites startups, des données de haute qualité peuvent ne pas être facilement disponibles. Nous avons déjà vu des entreprises telles que Reddit, Stack Overflow et Twitter fermer l’accès à leurs données ou facturer des frais d’accès élevés. Récemment, The Internet Archive a signalé que son site Web était devenu inaccessible pendant une heure parce qu’une startup d’IA avait commencé à le harceler pour obtenir des données d’entraînement.

Par ailleurs, les modèles d’IA générative ont également été fortement critiqués pour leur manque de contrôle et leur partialité. Les modèles d’IA formés à partir de données biaisées provenant de l’Internet peuvent surreprésenter une partie de la communauté. Nous avons vu que les générateurs de photos de l’IA rendent principalement des images avec des tons de peau plus clairs. Ensuite, il y a un énorme problème de génération de vidéos et d’images « deepfake » à l’aide de modèles d’IA générative. Comme indiqué précédemment, les modèles d’IA générative ne comprennent pas le sens ou l’impact de leurs mots et imitent généralement des résultats basés sur les données sur lesquelles ils ont été formés.

Il est fort probable qu’en dépit des meilleurs efforts et de l’alignement, de la désinformation, de la génération de deepfakes, du jailbreaking et des tentatives sophistiquées de phishing utilisant sa capacité persuasive de langage naturel, les entreprises auront du mal à dompter les limites de l’IA générative.