Google Cloud a annoncé aujourd’hui une nouvelle génération de technologies de calcul destinées à soutenir la montée en puissance de l’intelligence artificielle, avec notamment le TPU de 7ᵉ génération « Ironwood », de nouvelles machines virtuelles Axion basées sur Arm, et des améliorations logicielles dans son écosystème cloud.

L’objectif : fournir une infrastructure complète pour une nouvelle phase de l’IA, où la priorité passe de l’entraînement des modèles à leur déploiement massif auprès de milliards d’utilisateurs.

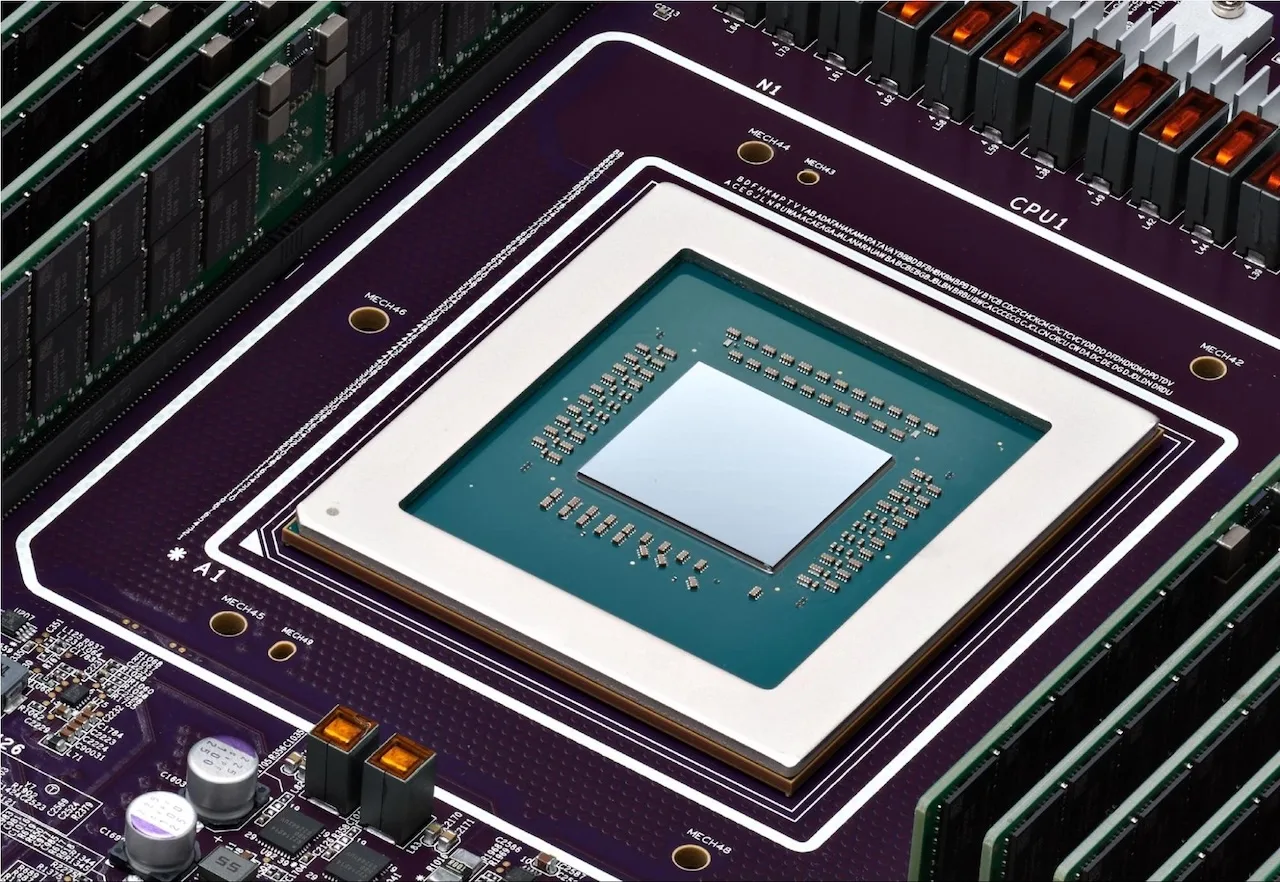

Ironwood: le TPU le plus puissant jamais conçu par Google

Bientôt disponible pour les clients de Google Cloud, Ironwood marque une avancée majeure dans les accélérateurs d’IA de Google.

Ce nouveau Tensor Processing Unit offre :

- x4 les performances du TPU v6 (Cloud TPU v6p) en entraînement et inférence,

- une efficacité énergétique record,

- 1,77 pétaoctet de mémoire HBM partagée sur un seul cluster (“Pod”),

- Une interconnexion optique à 9,6 Tb/s entre jusqu’à 9 216 puces, fonctionnant comme un seul superordinateur.

Ironwood combine puissance de calcul, mémoire ultrarapide et fiabilité : sa conception en réseau maillé dynamique lui permet de continuer à fonctionner même en cas de défaillance d’un composant, sans interruption perceptible.

Disponibilité : lancement mondial dans les prochaines semaines.

Anthropic s’engage à utiliser jusqu’à 1 million de TPUs Ironwood

Dans un partenariat historique, Anthropic, la société derrière Claude, a confirmé un accord avec Google pour accéder à jusqu’à 1 million de puces Ironwood d’ici 2026 — une commande estimée à plusieurs dizaines de milliards de dollars.

« Ce partenariat nous permet d’étendre massivement notre capacité de calcul et de répondre à la demande exponentielle de nos clients », a déclaré Krishna Rao, CFO d’Anthropic.

Anthropic cite la performance-prix et la fiabilité énergétique des TPUs comme des raisons majeures de ce choix.

Cette annonce est l’une des plus grandes commandes d’infrastructure d’IA jamais enregistrées, confirmant la stratégie de Google de miser sur son propre silicium plutôt que sur les GPU Nvidia.

Les processeurs Axion Arm : performance, efficacité et flexibilité

En parallèle, Google étend sa gamme de processeurs Axion, conçus en interne sur l’architecture Arm.

Nouveautés principales :

- Instances N4A (preview) :

- Optimisées pour les microservices, bases de données, workloads web et data analytics

- Jusqu’à 2x meilleur rapport prix/performance que les VM x86 actuelles

- Instances C4A Metal (bare metal) :

- Serveurs physiques dédiés pour le développement Android, automobile et workloads à licences spécifiques

Les premiers tests montrent déjà des gains importants :

- +30 % de performance sur les workloads de transcodage chez Vimeo,

- +60 % d’efficacité prix/performance sur les pipelines de données chez ZoomInfo.

L’objectif : compléter les TPUs dédiés à l’IA par des processeurs efficaces pour les tâches de support (préparation de données, API, microservices, etc.).

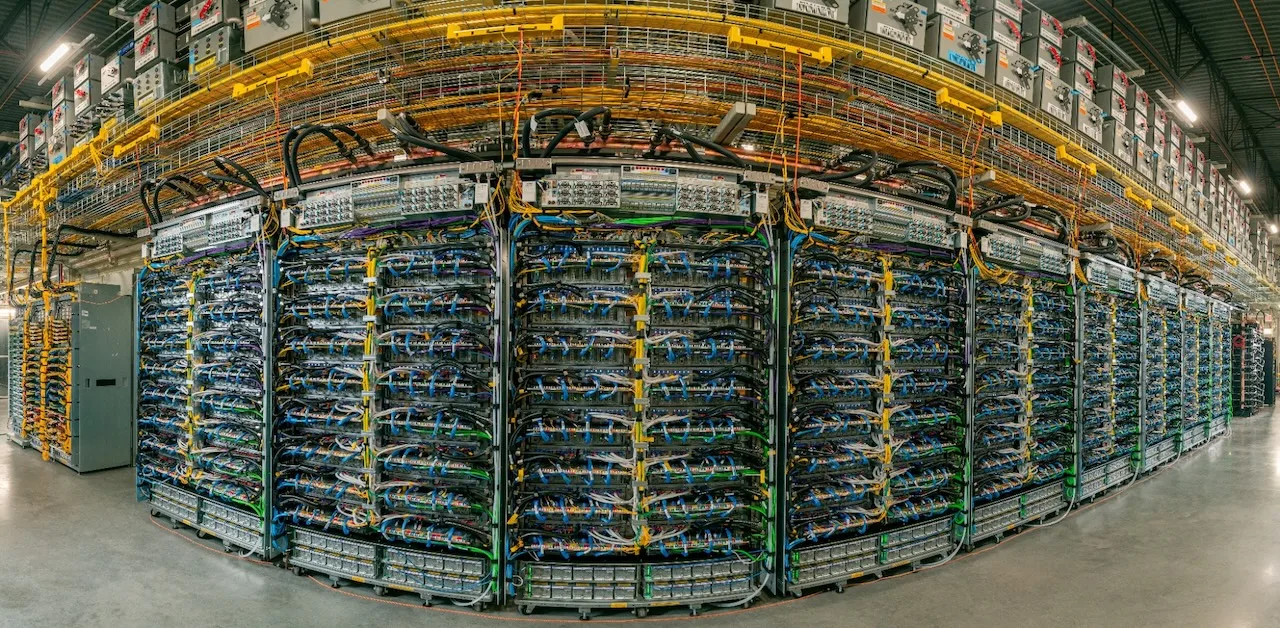

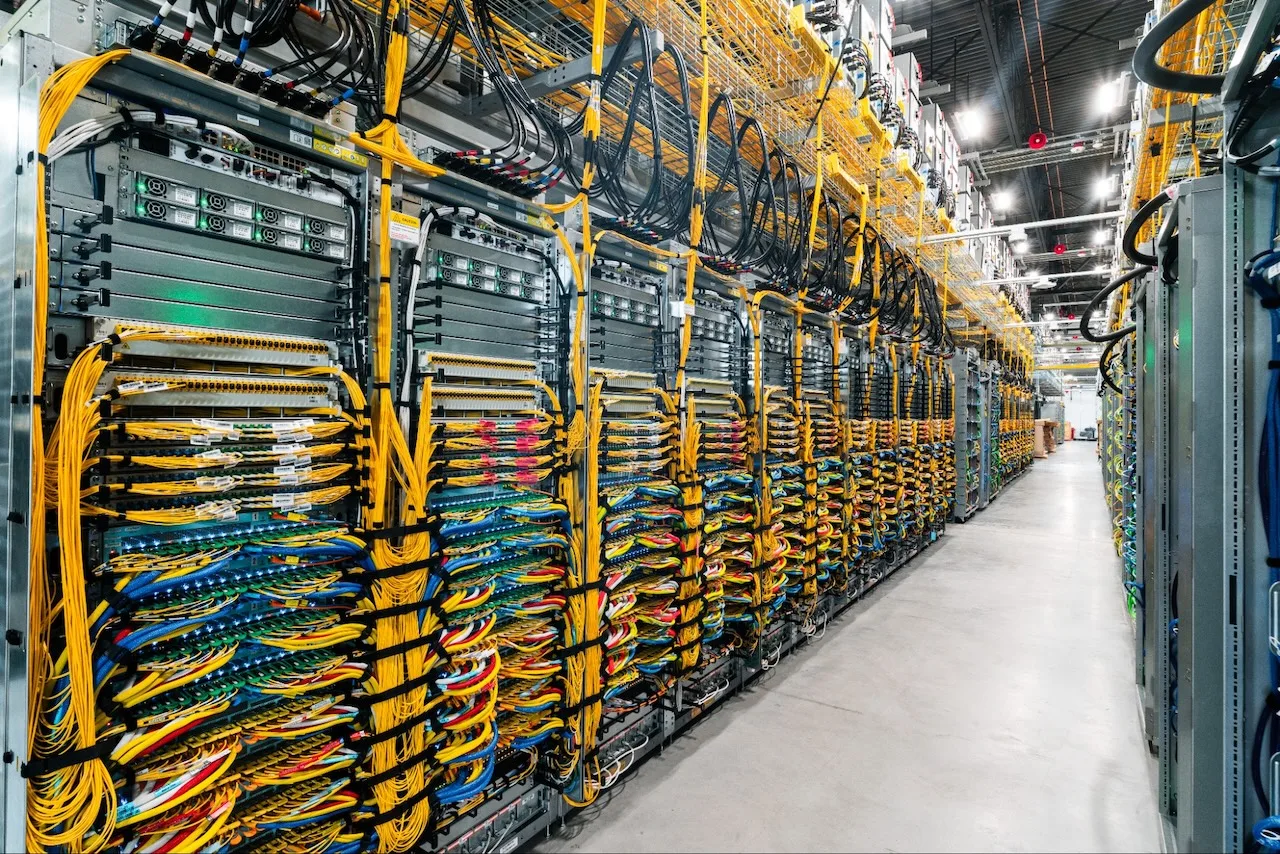

Intégration dans l’AI Hypercomputer

Les nouvelles puces Ironwood et Axion sont intégrées dans l’architecture AI Hypercomputer de Google Cloud — une infrastructure qui combine calcul, stockage, réseau et logiciels, orchestration intelligente via Google Kubernetes Engine, et équilibrage automatique des requêtes IA grâce à Inference Gateway.

Résultats selon IDC (2025) :

- ROI moyen sur 3 ans : +353 %,

- Coûts IT : –28 %,

- Efficacité des équipes IT : +55 %.

Le nouveau Inference Gateway permet notamment de réduire de 96 % la latence du premier token et de 30 % les coûts de service, en répartissant intelligemment les requêtes entre les serveurs IA selon leur charge et leur cache contextuel.

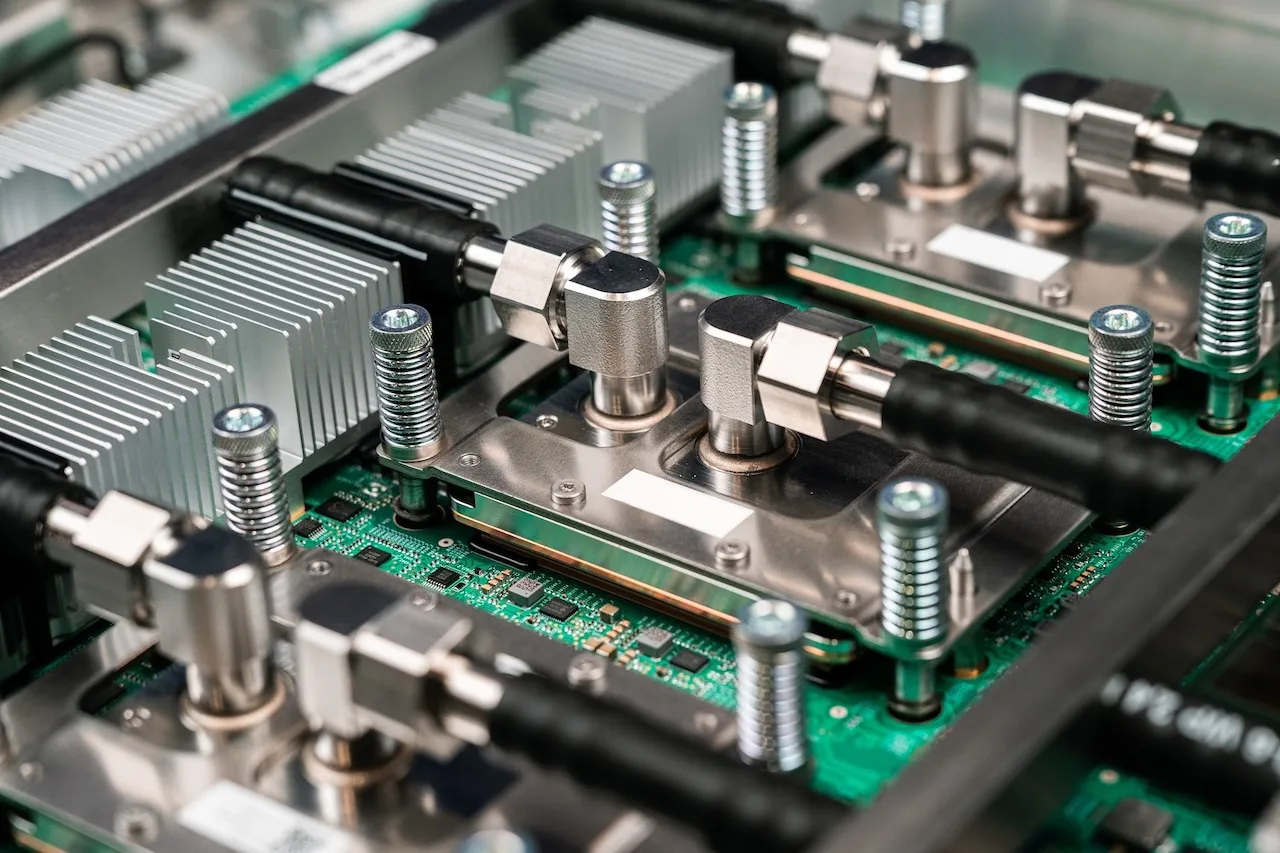

Puissance, refroidissement et durabilité

Pour soutenir ces charges colossales, Google met en place une infrastructure électrique et thermique de nouvelle génération :

- 400 VDC d’alimentation directe, jusqu’à 1 MW par rack,

- Refroidissement liquide généralisé à l’échelle du gigawatt,

- Disponibilité moyenne : 99,999 %, soit moins de 6 minutes d’arrêt par an.

L’entreprise collabore avec Meta et Microsoft au sein de l’Open Compute Project pour standardiser les interfaces électriques haute tension et les systèmes de refroidissement liquide de prochaine génération.

MaxText, GKE et Cluster Director : les outils logiciels à jour

Google annonce également plusieurs avancées logicielles pour maximiser les performances des nouvelles infrastructures :

- MaxText, son framework open source LLM, prend désormais en charge :

- le Supervised Fine-Tuning (SFT),

- le Generative Reinforcement Policy Optimization (GRPO).

- Cluster Director arrive sur Google Kubernetes Engine (GKE) :

- reconnaissance topologique des TPU Pods,

- maintenance proactive,

- planification intelligente des ressources pour une résilience accrue.

Un pari stratégique contre Nvidia

Google confirme ainsi sa stratégie de silicium personnalisé, face à la domination de Nvidia (80–95 % du marché des accélérateurs IA).Comme AWS avec ses Graviton et Trainium, ou Microsoft avec ses Cobalt et Maia, Google mise sur une approche verticalement intégrée, du matériel au logiciel.

Mais cette approche a un coût :

- investissements initiaux colossaux (plusieurs milliards par génération),

- écosystème logiciel encore en construction face à CUDA de Nvidia,

- risques d’obsolescence rapide selon l’évolution des architectures IA.

Malgré tout, Google reste confiant : « C’est avec la première TPU que nous avons pu inventer le Transformer — le moteur de l’IA moderne ».

Avec Ironwood, Axion, et son AI Hypercomputer, Google Cloud se positionne comme le concurrent le plus sérieux de Nvidia et AWS dans la course à l’infrastructure d’IA.

L’entreprise mise sur une intégration complète — du silicium à l’orchestration logicielle — pour répondre à la demande explosive de l’ère de l’inférence, où l’IA n’est plus seulement entraînée, mais déployée massivement dans les produits du quotidien.