Apple a annoncé une multitude de nouvelles fonctionnalités logicielles pour ses appareils les plus populaires — ordinateurs, iPhone, iPad, Apple Watch, Apple TV, AirPods et le nouveau casque Apple Vision Pro – lors de sa conférence mondiale des développeurs WWDC 2023.

Mais au milieu de ses nouveaux produits notables, les présentateurs d’Apple n’ont pas mentionné une seule fois le terme « IA », une omission notable étant donné que ses concurrents comme Microsoft et Google se sont fortement concentrés sur l’IA générative à l’heure actuelle. L’IA a tout de même fait partie de la présentation d’Apple, mais sous d’autres noms.

Comme on s’y attendait d’après les rapports et les rumeurs antérieurs à l’événement, bon nombre des nouvelles fonctionnalités du géant technologique ont fait appel à l’intelligence artificielle (IA), ou à « l’apprentissage automatique » (ML), comme les présentateurs d’Apple ont pris soin de le dire. Alors que le terme « IA » est très ambigu de nos jours, entouré à la fois d’avancées stupéfiantes et d’une médiatisation extrême, Apple a choisi d’éviter cette association et s’est plutôt concentré sur des termes tels que le « machine learning » et « ML ».

Conformément aux engagements pris par Apple en matière de confidentialité et de sécurité des utilisateurs, ces nouvelles fonctionnalités d’intelligence artificielle semblent largement éviter la connexion et le transfert des données des utilisateurs vers le cloud, et s’appuient plutôt sur la puissance de traitement de l’appareil — ce qu’Apple appelle son « moteur neuronal ».

Voici un aperçu de quelques-unes des fonctionnalités les plus intéressantes des appareils Apple alimentés par l’IA.

Persona pour Vision Pro

La star de l’événement d’Apple, comme c’est souvent le cas dans l’histoire de l’entreprise, a été la « one more thing » dévoilée à la fin : Apple Vision Pro. Ce nouveau casque de réalité augmentée ressemble à un gros masque de ski que l’utilisateur porte sur les yeux et qui lui permet de voir des graphiques superposés à sa vision du monde réel.

Le nouveau casque, qu’Apple qualifie de premier appareil « d’informatique spatiale », ne sera pas disponible avant le début de l’année 2024 et sera proposé au prix de départ de 3 499 dollars — uniquement outre-Atlantique pour débuter. Il prend notamment en charge de nombreuses applications mobiles existantes d’Apple et permet même de déplacer les interfaces des ordinateurs Mac dans des fenêtres numériques flottantes en plein vol.

L’une des principales innovations présentées par Apple sur le Vision Pro dépend fortement de la ML connue sous le nom de Persona. Cette fonction utilise des caméras intégrées pour scanner le visage d’un utilisateur afin de créer rapidement un sosie numérique interactif et réaliste. Ainsi, lorsqu’un utilisateur enfile l’appareil et participe à un appel FaceTime ou à une autre vidéoconférence, un jumeau numérique apparaît à sa place dans le casque encombrant, reproduisant ses expressions et ses gestes en temps réel.

Selon Apple, Persona est une « représentation numérique » de l’utilisateur « créée à l’aide des techniques de ML les plus avancées d’Apple ».

Un meilleur correcteur automatique

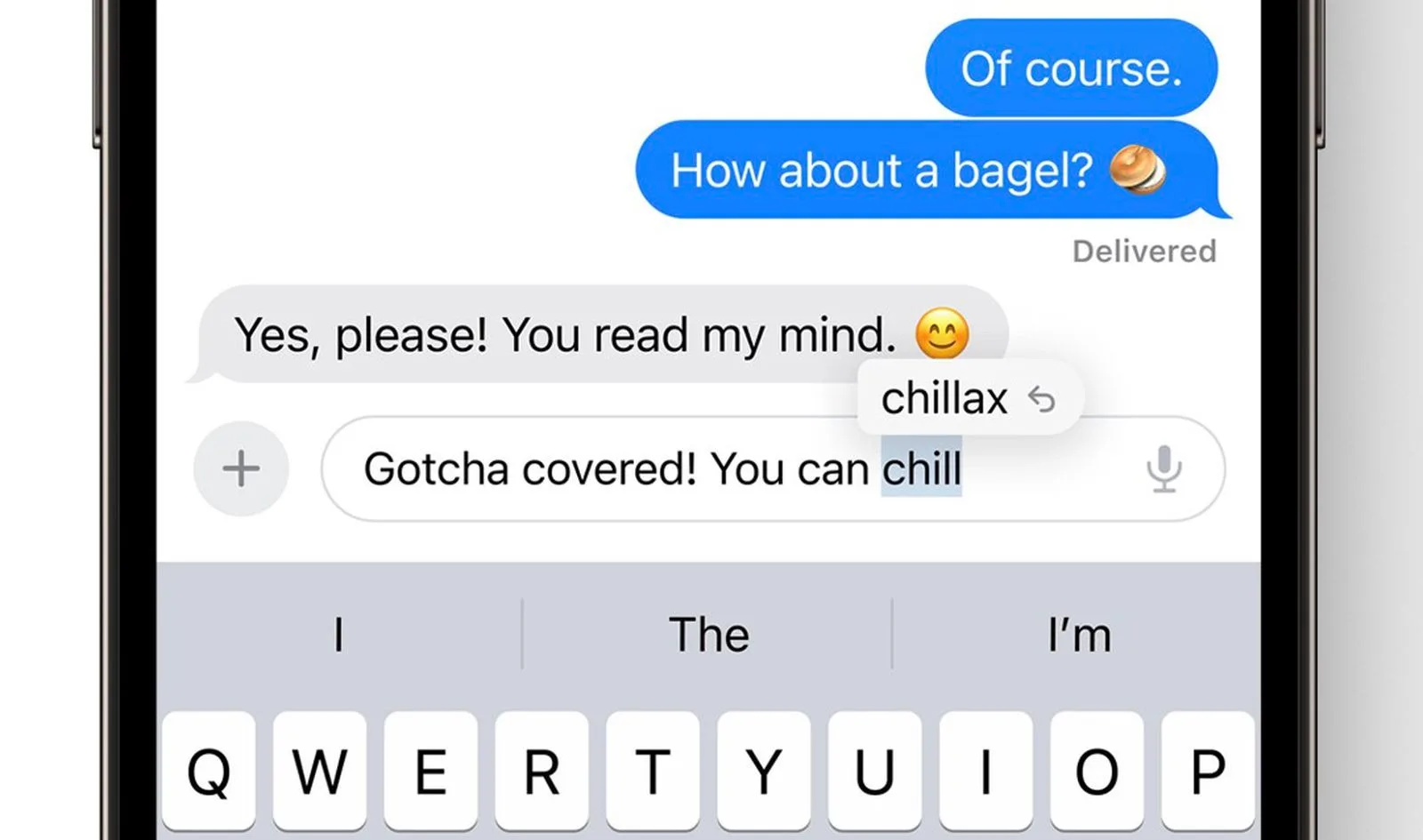

Comme les utilisateurs d’iPhone le savent bien, les fonctions de correction automatique intégrées d’Apple pour les textes et la saisie peuvent parfois être erronées et peu utiles, suggérant des mots qui sont loin de correspondre à l’intention de l’utilisateur. Tout cela change avec iOS 17, du moins selon Apple.

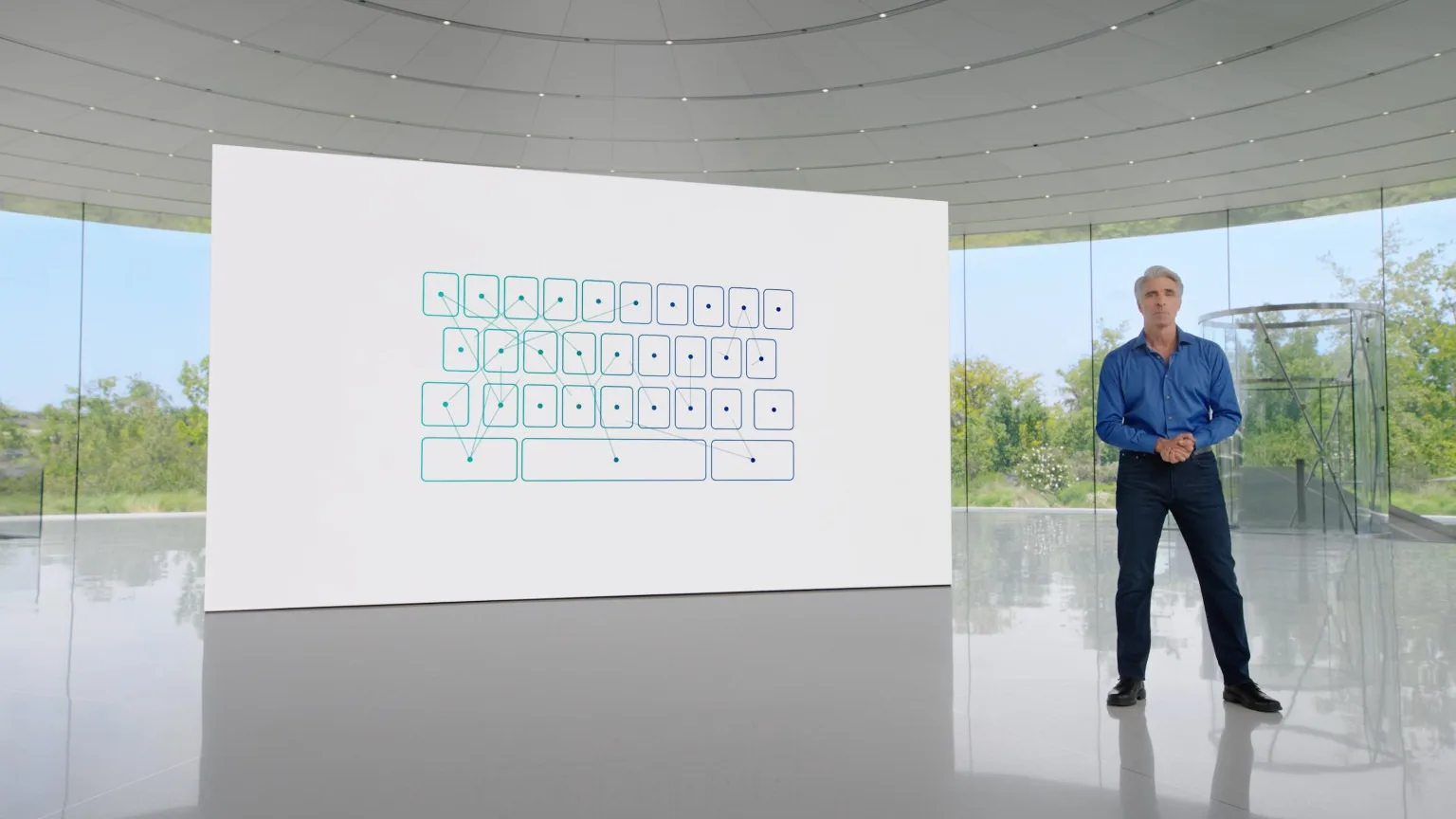

La dernière mise à jour majeure annuelle du système d’exploitation de l’iPhone contient un nouveau correcteur automatique qui utilise un « modèle transformateur » — la même catégorie de programme d’IA que GPT-4 et Claude — spécifiquement pour améliorer les capacités de prédiction de mots du correcteur automatique. Ce modèle fonctionne sur l’appareil, ce qui préserve la vie privée de l’utilisateur lorsqu’il compose.

L’autocorrection propose désormais des suggestions pour des phrases entières et présente ses suggestions en ligne, à l’instar de la fonction de composition intelligente de Gmail de Google.

Messagerie vocale en direct

L’une des nouvelles fonctionnalités apparemment les plus utiles présentées par Apple est le nouveau « Live Voicemail » pour l’application Téléphone par défaut de l’iPhone. Cette fonction intervient lorsque quelqu’un appelle un destinataire équipé d’un iPhone, ne parvient pas à le joindre et commence à laisser un message vocal.

L’application Téléphone affiche alors sur l’écran du destinataire une transcription textuelle du message vocal en cours, mot par mot, au fur et à mesure que l’appelant parle. Il s’agit essentiellement de transformer le son en texte, en direct et à la volée. Apple a déclaré que cette fonction était alimentée par son moteur neuronal et « se produit entièrement sur l’appareil… cette information n’est pas partagée avec Apple ».

Dictée améliorée

La fonction de dictée existante d’Apple permet aux utilisateurs de toucher la petite icône du microphone sur le clavier par défaut de l’iPhone et de commencer à parler pour transformer les mots en texte écrit, ou d’essayer de le faire. Bien que cette fonction ait un taux de réussite mitigé, Apple affirme qu’iOS 17 inclut un « nouveau modèle de reconnaissance vocale », utilisant probablement le ML sur l’appareil, qui rendra la dictée encore plus précise.

Mode présentateur FaceTime

Apple n’a pas annoncé de nouveau boîtier physique pour l’Apple TV, mais a dévoilé une nouvelle fonctionnalité majeure : FaceTime pour Apple TV, qui tire parti de l’iPhone ou de l’iPad d’un utilisateur (à condition qu’il en ait un) et l’utilise comme caméra vidéo entrante tout en affichant les autres participants à l’appel FaceTime sur le téléviseur de l’utilisateur.

Un autre nouvel aspect de l’expérience FaceTime est le mode présentation. Il permet aux utilisateurs de présenter une application ou l’écran de leur ordinateur aux autres participants d’un appel FaceTime, tout en affichant une vue en direct de leur propre visage ou de leur tête et de leurs épaules devant l’écran. L’une des vues réduit le visage du présentateur à un petit cercle qu’il peut repositionner autour du matériel de présentation, tandis que l’autre place la tête et les épaules du présentateur devant son contenu, ce qui lui permet de faire des gestes comme s’il était un météorologue à la télévision pointant une carte météo numérique.

Apple a déclaré que le nouveau mode de présentation est alimenté par son moteur neuronal.

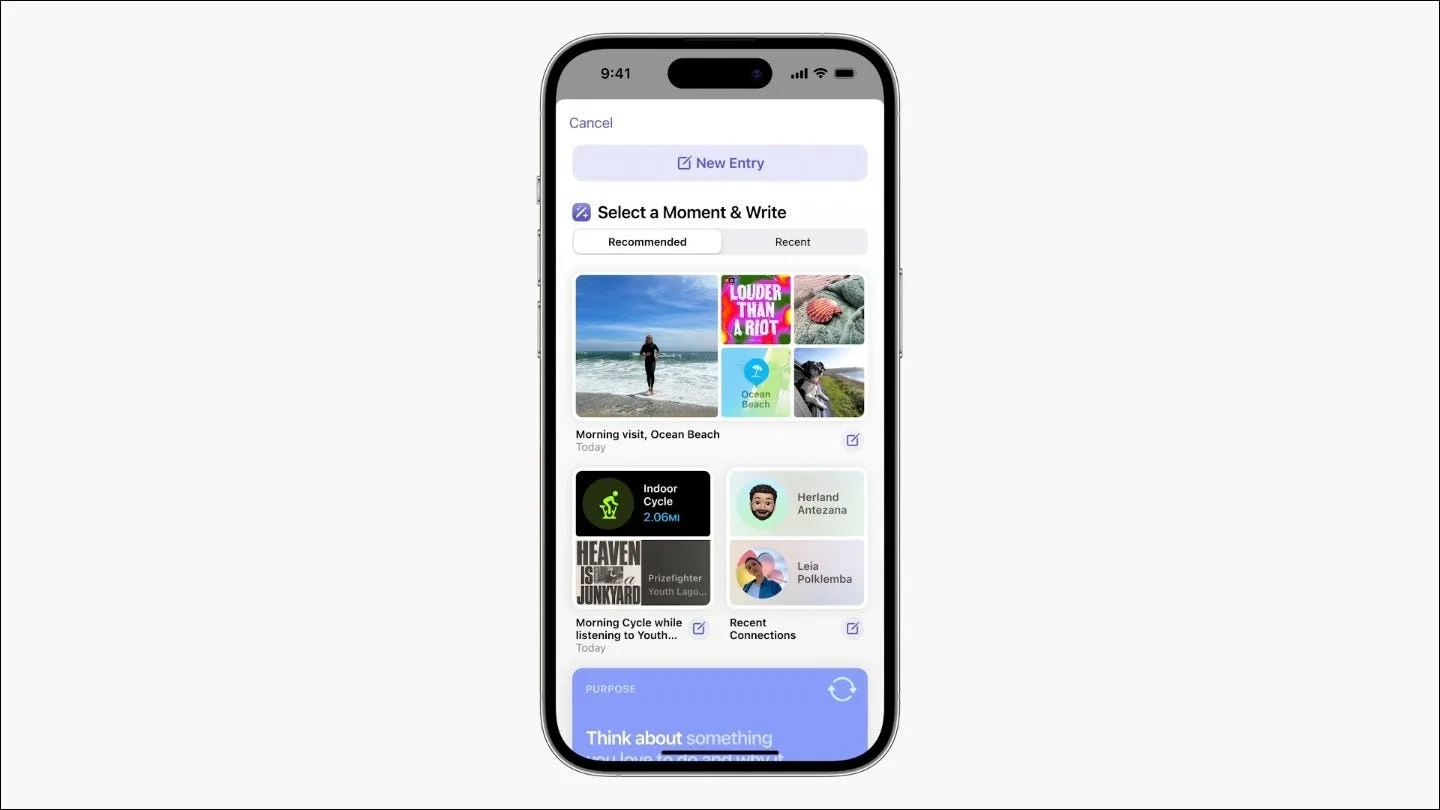

Journal pour iPhone

Tenez-vous un journal ? Si ce n’est pas le cas, ou même si vous en tenez déjà un, Apple pense avoir trouvé un meilleur moyen de vous aider à « réfléchir et à pratiquer la gratitude », grâce au « ML on-device ». La nouvelle application Journal d’iOS 17 récupère automatiquement les photos récentes, les séances d’entraînement et autres activités du téléphone de l’utilisateur et les présente sous la forme d’un journal numérique inachevé, permettant aux utilisateurs de modifier le contenu et d’ajouter du texte et de nouveaux éléments multimédias comme bon leur semble.

Important pour les développeurs d’applications, Apple publie également une nouvelle API Journaling Suggestions, qui leur permet de coder leurs applications de manière à ce qu’elles apparaissent également comme du contenu de journal possible pour les utilisateurs. Cela pourrait s’avérer particulièrement utile pour les applications de fitness, de voyage et de restauration, mais il reste à voir quelles entreprises l’appliqueront et avec quelle élégance elles le feront.

Volume personnalisé

Apple a présenté le volume personnalisé, une fonctionnalité des AirPods qui « utilise la ML pour comprendre les conditions environnementales et les préférences d’écoute au fil du temps » et ajuste automatiquement le volume en fonction de ce qu’elle pense que les utilisateurs souhaitent.

Les photos peuvent désormais identifier vos chats et vos chiens

Les précédents systèmes de ML d’Apple pour iPhone et iPad permettaient à l’application Photos, qui organise les photos par défaut, d’identifier différentes personnes en fonction de leur apparence. Par exemple, vous voulez voir une photo de vous, de votre enfant ou de votre conjoint ? Ouvrez l’application Photos de l’iPhone, naviguez jusqu’à la section « personnes et lieux » et vous verrez apparaître des mini-albums pour chacun d’entre eux.

Aussi utile et agréable que soit cette fonctionnalité, elle a manifestement laissé quelqu’un de côté : Nos compagnons à poils. Eh bien, ce n’est plus le cas. Lors de la WWDC 2023, Apple a annoncé que, grâce à un programme ML amélioré, la fonction de reconnaissance des photos fonctionne désormais aussi pour les chats et les chiens.