L’un des métiers les plus méconnus de l’ère Internet est celui de modérateur de contenu. OpenAI est convaincue que sa technologie peut contribuer à résoudre l’un des problèmes les plus difficiles de la technologie : la modération de contenu à grande échelle.

Beaucoup de personnes ont déjà décrit de manière éloquente et poignante le sort de ces employés, qui se comptent par milliers et sont chargés par de grands réseaux sociaux tels que Facebook d’examiner des tonnes de contenus générés par les utilisateurs afin d’y déceler des violations et de les retirer de ces plateformes.

Le contenu auquel ils sont exposés comprend souvent des descriptions détaillées et des preuves photographiques ou vidéo de l’humanité dans ce qu’elle a de pire — comme des représentations d’abus sexuels sur des enfants — sans parler de divers autres crimes, atrocités et horreurs.

Les modérateurs chargés d’identifier et de supprimer ces contenus ont déclaré souffrir de stress post-traumatique, d’anxiété et de diverses autres maladies mentales et psychologiques en raison de leur exposition.

L’IA prend en charge la modération des contenus

Ne serait-ce pas une amélioration si un programme d’intelligence artificielle (IA) pouvait prendre en charge une partie, voire la plus grande partie, de la modération de contenu en ligne ?

C’est ce qu’espère OpenAI, qui a publié aujourd’hui un article de blog détaillant ses conclusions selon lesquelles GPT-4 — son dernier grand modèle de langage (LLM) accessible au public, qui constitue l’épine dorsale d’une version de ChatGPT — peut être utilisé efficacement pour modérer du contenu pour d’autres entreprises et organisations.

« Nous pensons que cela offre une vision plus positive de l’avenir des plateformes numériques, où l’IA peut aider à modérer le trafic en ligne conformément à la politique spécifique de la plateforme et soulager la charge mentale d’un grand nombre de modérateurs humains », écrivent les auteurs de OpenAI Lilian Weng View, Vik Goel et Andrea Vallone.

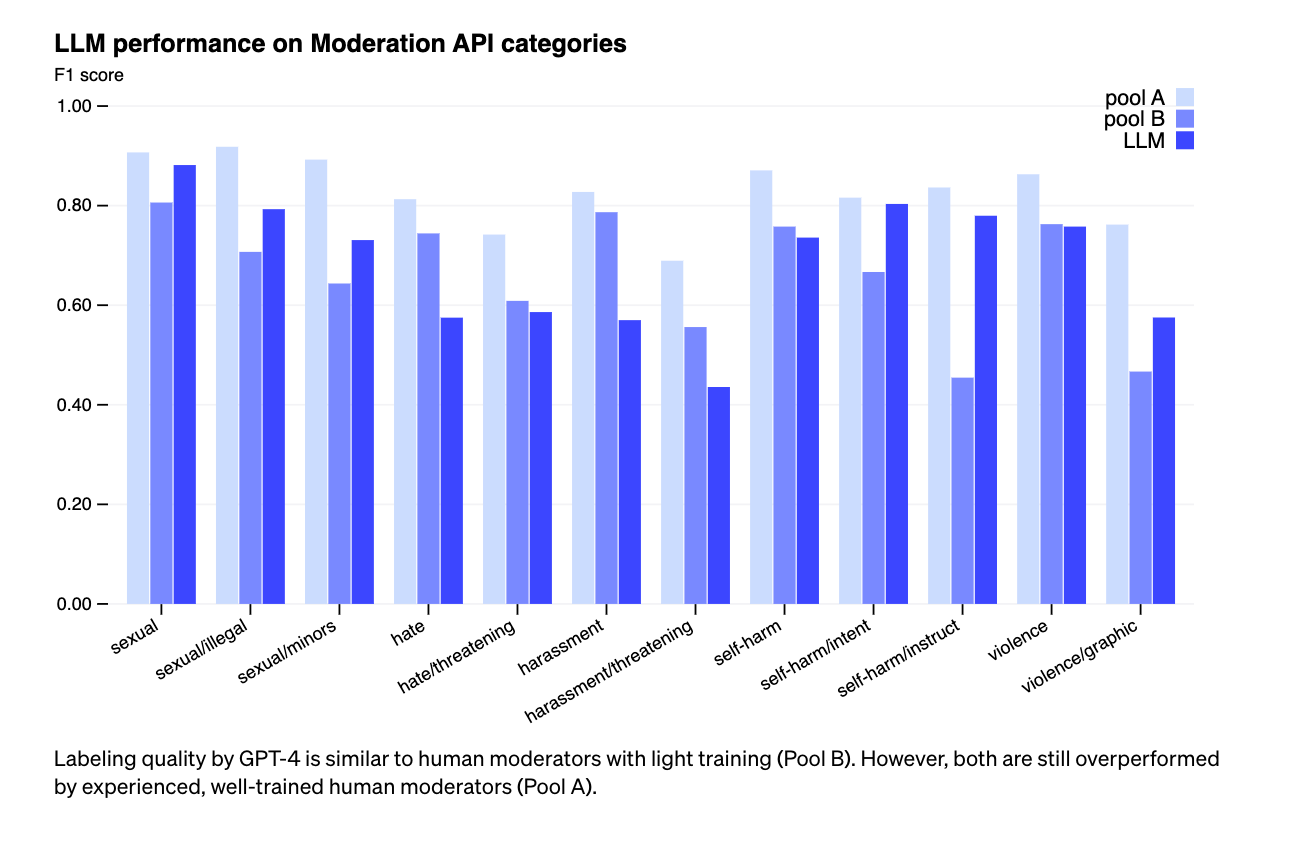

En fait, selon les recherches de OpenAI, les GPT-4 formés à la modération de contenu obtiennent de meilleurs résultats que les modérateurs humains ayant reçu une formation minimale, bien que les deux soient toujours surpassés par des modérateurs humains hautement qualifiés et expérimentés.

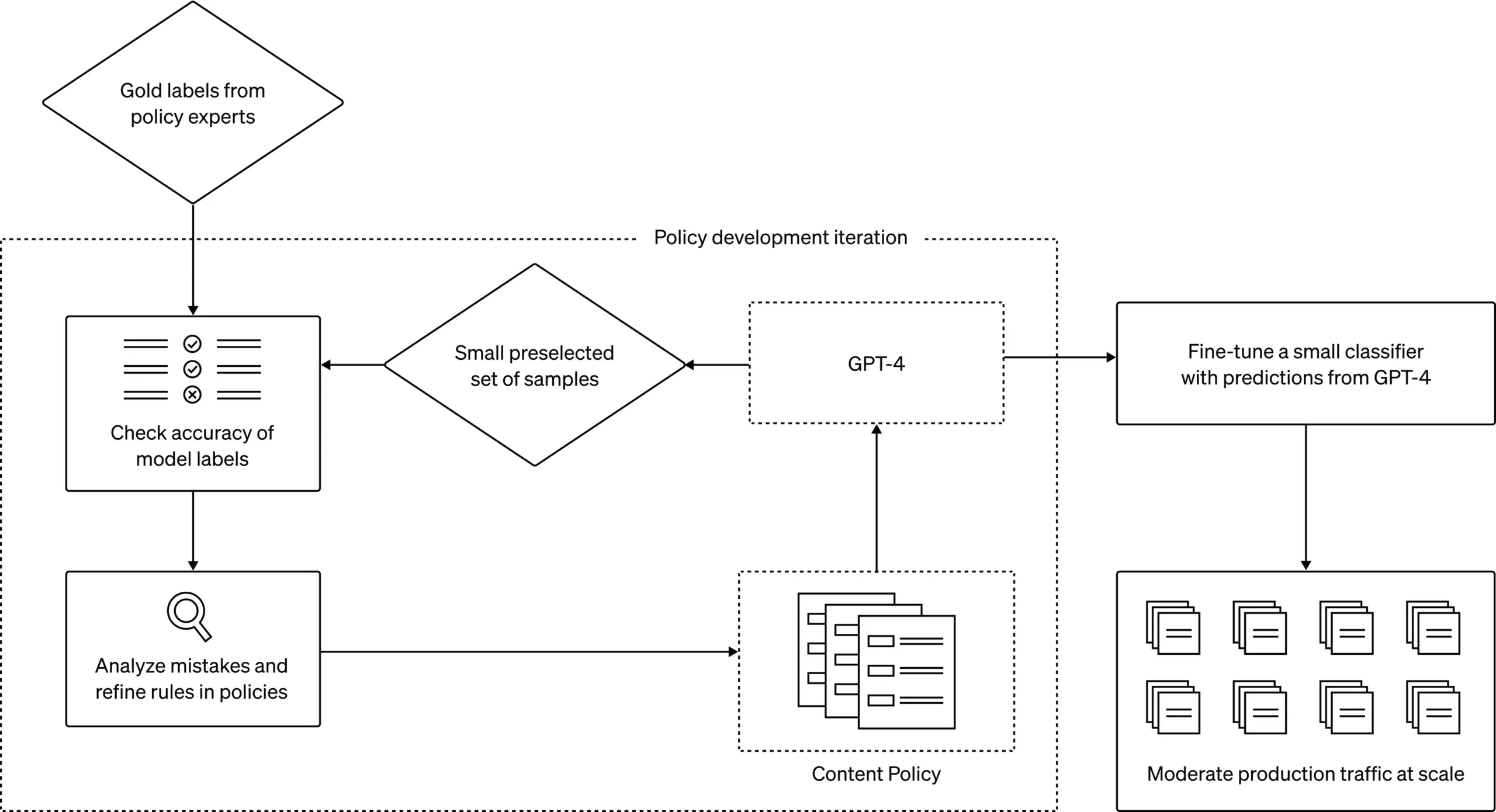

OpenAI décrit un cadre en trois étapes pour former ses LLM, y compris ChatGPT 4, à la modération de contenu conformément aux politiques d’une hypothétique organisation.

Un processus bien établi

La première étape du processus comprend la rédaction de la politique de contenu — vraisemblablement effectuée par des humains, bien que l’article de blog de OpenAI ne le précise pas — puis l’identification d’un « ensemble d’or » de données que les modérateurs humains identifieront. Ces données peuvent inclure des contenus qui sont manifestement en violation des politiques ou des contenus qui sont plus ambigus, mais que les modérateurs humains considèrent tout de même comme étant en violation. Il peut également s’agir d’exemples de données qui sont clairement conformes aux politiques.

Quel que soit l’ensemble de données en or, les labels seront utilisés pour comparer les performances d’un modèle d’intelligence artificielle. La deuxième étape consiste à prendre le modèle, en l’occurrence GPT-4, et à lui demander de lire la politique de contenu, puis d’examiner le même ensemble de données « en or » et de lui attribuer ses propres labels.

Enfin, un superviseur humain compare les labels de GPT-4 à celles créées à l’origine par des humains. En cas de divergences ou d’exemples de contenu que GPT-4 a « mal compris » ou identifié de manière incorrecte, les superviseurs humains pourraient alors demander à GPT-4 d’expliquer son raisonnement pour l’étiquette. Une fois que le modèle a décrit son raisonnement, le superviseur peut envisager de réécrire ou de clarifier la politique de contenu originale pour s’assurer que GPT-4 la lise et suive cette instruction à l’avenir.

« Ce processus itératif permet d’affiner les politiques de contenu qui sont traduites en classificateurs, ce qui permet de déployer la politique et la modération de contenu à grande échelle », écrivent les auteurs de OpenAI.

L’article de blog de OpenAI décrit également comment cette approche surpasse les « approches traditionnelles de modération de contenu », notamment en créant des « labels plus cohérents » par rapport à une armée de modérateurs humains qui peuvent interpréter le contenu différemment selon la même politique, une « boucle de rétroaction plus rapide » pour mettre à jour les politiques de contenu afin de tenir compte des nouvelles violations et, bien sûr, une « charge mentale réduite » pour les modérateurs de contenu humains, qui pourraient vraisemblablement être appelés uniquement pour aider à former le LLM ou diagnostiquer des problèmes avec lui, et lui laisser toute la ligne de front et la majeure partie du travail de modération.

Une ironie qui mérite d’être soulignée

La promotion par OpenAI du GPT-4 comme moyen d’alléger la charge mentale des modérateurs de contenu humains présente bien sûr une ironie notable : selon des rapports d’enquête détaillés publiés dans le magazine Time et le Wall Street Journal, OpenAI a elle-même employé des modérateurs de contenu humains au Kenya, par l’intermédiaire de contractants et de sous-traitants tels que Sama, pour lire le contenu, y compris le contenu généré par l’IA, et l’identifier en fonction de la gravité des préjudices décrits.

Comme l’a rapporté Time, ces employés humains étaient payés moins de 2 dollars de l’heure pour leur travail, et les deux rapports indiquent que les employés ont subi des traumatismes durables et des maladies mentales à cause de ce travail.

Les employés ont récemment adressé une pétition au gouvernement du Kenya pour qu’il adopte de nouvelles lois qui protégeraient davantage les modérateurs de contenu.

Il se peut donc que l’initiative de modération automatisée des contenus de OpenAI soit, d’une certaine manière, un moyen de réparer ou de prévenir de futurs préjudices tels que ceux qui ont été causés lors de sa création.