Faire tourner des modèles d’IA géants sans cloud, sans data center et sans facture énergétique délirante : c’est la promesse audacieuse de Tiiny AI, qui vient de dévoiler un appareil officiellement reconnu par le Guinness World Records comme le plus petit supercalculateur personnel d’intelligence artificielle au monde.

Son nom : Tiiny AI Pocket Lab. Son format : celui d’une batterie externe. Son ambition : remettre l’IA entre les mains des utilisateurs.

Quand l’IA quitte les data centers

Alors que les mini-supercalculateurs personnels existants — comme NVIDIA Project Digits (~3 000 dollars) ou DGX Spark (~4 000 dollars) — restent hors de portée du grand public, Tiiny AI adopte une approche radicalement différente.

Pour la startup américaine, le véritable goulot d’étranglement de l’IA moderne n’est plus la puissance de calcul, mais la dépendance au cloud. « L’intelligence ne devrait pas appartenir aux data centers, mais aux individus », résume Samar Bhoj, directeur GTM de Tiiny AI.

Le Pocket Lab est pensé pour exécuter des modèles massifs entièrement en local, améliorant à la fois la confidentialité, la latence et la souveraineté des données, tout en rendant l’IA plus personnelle et moins abstraite.

Un supercalculateur de 300 grammes

Les chiffres donnent le vertige, surtout au regard du format :

- Dimensions : 14,2 × 8 × 2,53 cm

- Poids : 300 g

- Puissance IA : jusqu’à 190 TOPS

- Mémoire : 80 Go de LPDDR5X

- Stockage : 1 To SSD

- Consommation : 30 W (TDP), ~65 W en charge système

Tiiny AI affirme que le Pocket Lab peut faire tourner des modèles de langage allant jusqu’à 120 milliards de paramètres, un niveau habituellement réservé aux racks serveurs ou aux GPU professionnels haut de gamme.

Cette prouesse lui a valu une certification Guinness officielle : « Smallest MiniPC capable d’exécuter localement un LLM de 100B+ paramètres ».

Une architecture pensée pour l’IA locale

Sous le capot, le Pocket Lab repose sur un CPU ARM v9.2 à 12 cœurs, une NPU discrète sur mesure, délivrant l’essentiel de la puissance IA, et une architecture optimisée pour l’inférence massive hors ligne.

L’appareil prend en charge la plupart des grands modèles open source du moment :

Llama, Qwen, Mistral, DeepSeek, Phi, GPT-OSS, ainsi que des frameworks agents et outils comme ComfyUI, Flowise ou SillyTavern.

Le tout fonctionne sans connexion Internet, avec un stockage local chiffré de niveau bancaire.

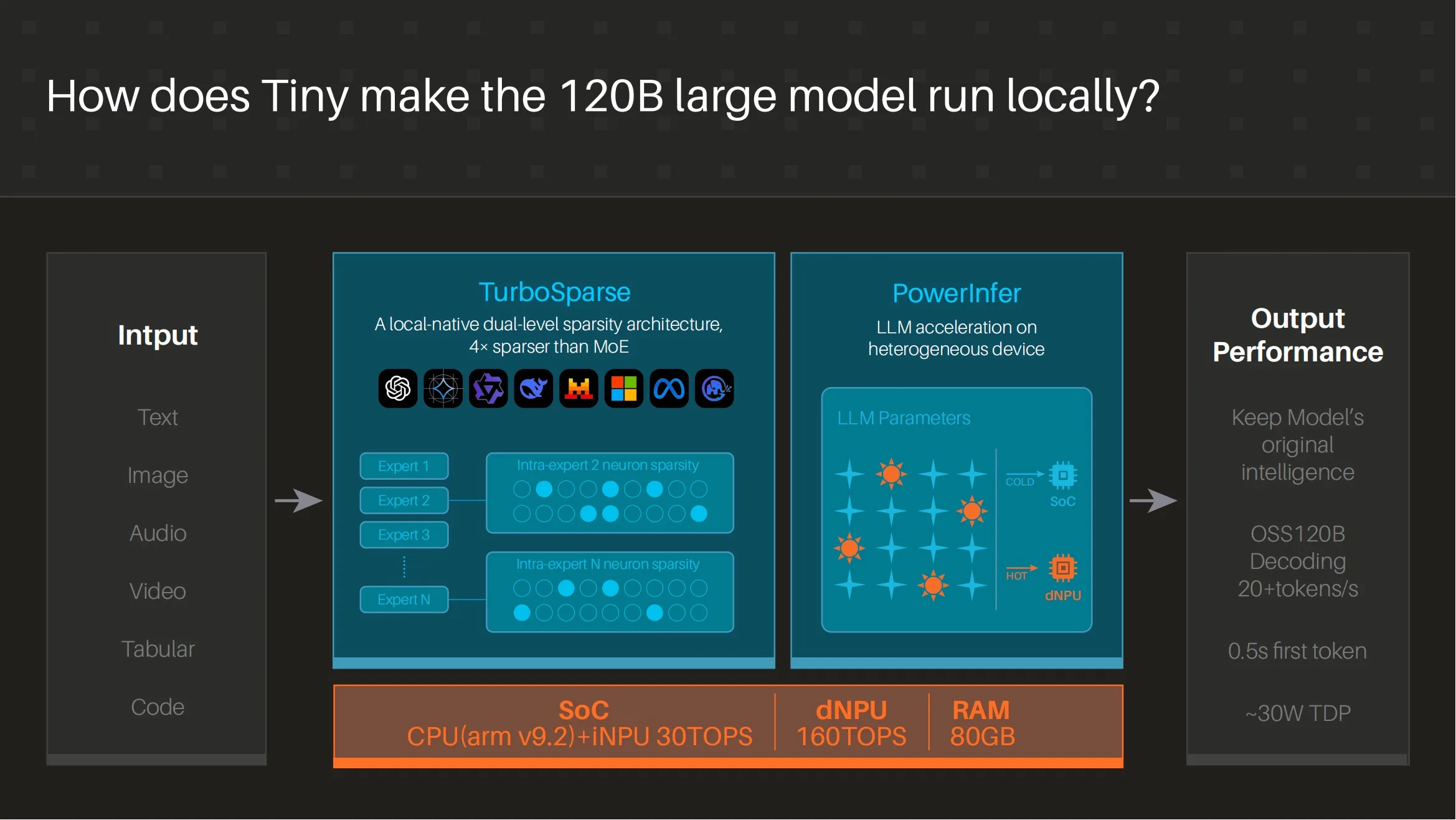

TurboSparse et PowerInfer : les deux armes secrètes

Pour atteindre ces performances dans un format aussi contraint, Tiiny AI s’appuie sur deux technologies clés :

- TurboSparse, un système d’activation neuronale parcimonieuse qui améliore l’efficacité de l’inférence sans dégrader l’intelligence du modèle.

- PowerInfer, un moteur d’inférence hétérogène qui répartit intelligemment les charges entre CPU et NPU.

Résultat : des performances proches du serveur, mais avec une consommation et une dissipation thermique compatibles avec un usage portable.

À qui s’adresse le Pocket Lab ?

Tiiny AI cible clairement les développeurs IA, les chercheurs, les professionnels soucieux de la confidentialité, les étudiants, et les projets en robotique, agents autonomes ou raisonnement avancé.

Selon l’entreprise, les modèles compris entre 10B et 100B de paramètres couvrent plus de 80 % des besoins réels en IA aujourd’hui — exactement le terrain de jeu du Pocket Lab.

Présentation attendue au CES 2026

Le Tiiny AI Pocket Lab sera présenté officiellement au CES 2026.

Le prix et la date de commercialisation n’ont pas encore été dévoilés, mais l’industrie surveille de près ce produit qui pourrait redéfinir la notion même de supercalculateur personnel.

Si les promesses sont tenues, Tiiny AI pourrait bien ouvrir une nouvelle ère : celle d’une IA puissante, privée et réellement personnelle, qui ne vit plus dans le cloud, mais dans la poche.