Dans la course effrénée à l’intelligence artificielle, la startup chinoise basée à Hangzhou, DeepSeek, fait une percée remarquée avec le lancement de DeepSeek-V3.2-Exp, un nouveau modèle de langage expérimental intégrant une technologie encore peu exploitée : l’attention éparse (sparse attention).

DeepSeek-V3.2-Exp : Une IA plus intelligente… et surtout plus économe

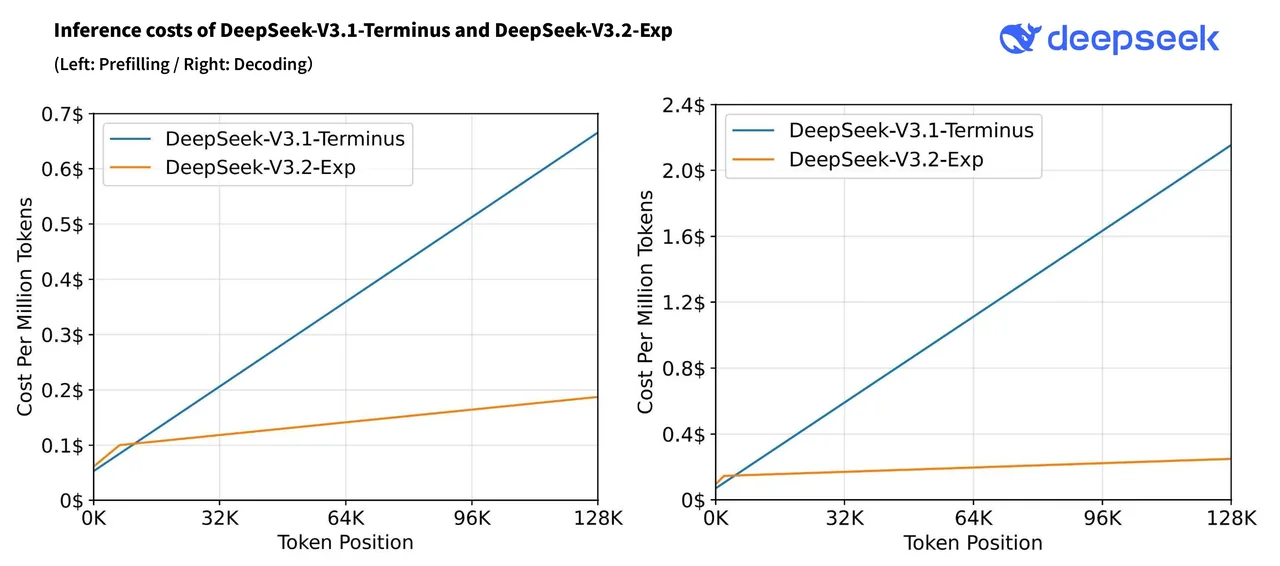

Le concept d’attention éparse permet au modèle de concentrer ses ressources de calcul uniquement sur certaines parties pertinentes d’un long texte, plutôt que de traiter chaque mot dans toutes les combinaisons possibles. Résultat : des performances comparables aux meilleurs modèles actuels… mais avec un coût d’inférence divisé par deux, notamment pour les cas d’usage longs comme l’analyse documentaire ou les conversations multi-tours.

Selon TechCrunch, ce nouveau paradigme d’attention permettrait de réduire les coûts API à moins de 3 centimes par million de tokens, contre 6 à 10 centimes en moyenne avec les modèles traditionnels.

Des performances solides… avec quelques compromis

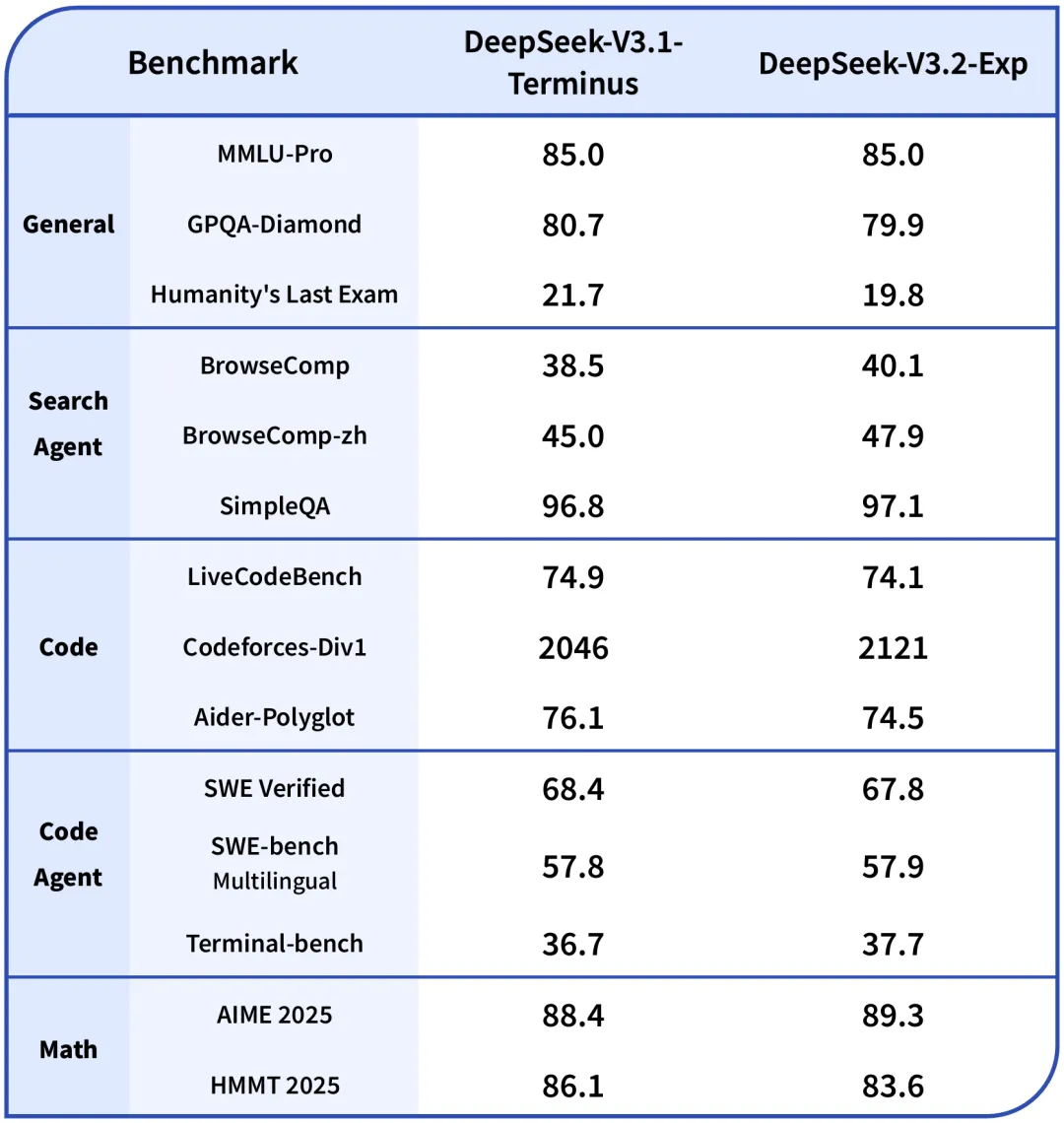

D’après les benchmarks relayés par VentureBeat, DeepSeek-V3.2-Exp surpasse son prédécesseur V3.1-Terminus dans plusieurs domaines :

- Score Codeforces (programmation) : 2121 (vs 2046)

- BrowseComp (navigation et recherche) : 40.1 (vs 38.5)

Cependant, certains tests plus axés sur le raisonnement montrent une légère baisse :

- GPQA-Diamond : 79.9 (vs 80.7)

Une preuve que l’adoption de l’attention éparse implique des choix d’optimisation ciblés, visant à maximiser l’efficacité sans sacrifier les performances essentielles.

Une approche open source pour accélérer l’adoption

Fidèle à sa philosophie d’ouverture, DeepSeek a publié ce nouveau modèle sur Hugging Face, permettant à la communauté mondiale de l’expérimenter, de le tester et de l’intégrer à divers projets. Un geste stratégique pour favoriser l’adoption dans les environnements à budget limité, comme les PME ou les laboratoires de recherche universitaires.

Vers une IA plus accessible ?

DeepSeek affirme que DeepSeek-V3.2-Exp peut gérer jusqu’à 160 000 tokens de contexte via les serveurs Huawei Cloud. Dans des secteurs comme la finance, la santé ou le juridique, où les documents longs sont la norme, ce modèle pourrait permettre une démocratisation réelle de l’IA générative.

Un rapport de Reuters suggère d’ailleurs que cette version expérimentale n’est qu’une étape intermédiaire vers une nouvelle architecture encore plus ambitieuse.

Les limites d’un modèle expérimental

Malgré ses atouts, tout n’est pas parfait. Comme le souligne WinBuzzer, DeepSeek-V3.2-Exp reste un prototype. Sa scalabilité en environnement de production n’a pas encore été prouvée à grande échelle. L’accès mondial est également limité, l’essentiel de l’infrastructure étant pour l’instant basé en Chine.

Avec cette avancée, DeepSeek met une pression bienvenue sur les géants du secteur, de Meta à OpenAI, en rappelant que l’efficacité énergétique et financière est tout aussi importante que la puissance brute. Si l’attention éparse tient ses promesses, elle pourrait bien devenir un nouveau standard de l’IA générative.

En résumé, DeepSeek-V3.2-Exp est plus qu’un simple modèle expérimental. C’est un signal fort : l’ère des IA ultra-coûteuses pourrait toucher à sa fin. Et la Chine, avec son approche open source et ses optimisations pragmatiques, entend bien jouer les trouble-fête dans le paysage mondial de l’intelligence artificielle.