Xiaomi franchit un nouveau cap stratégique dans l’intelligence artificielle avec MiMo-V2-Flash, son modèle de langage open source le plus avancé à ce jour. Pensé pour la vitesse, les agents IA et la génération de code, ce nouveau LLM entend rivaliser frontalement avec des références du secteur comme DeepSeek V3.2 et Claude 4,5 Sonnet, tout en affichant des coûts d’exploitation radicalement plus bas.

Avec MiMo-V2-Flash, Xiaomi ne se contente plus d’intégrer l’IA dans ses produits : le groupe chinois affiche clairement son ambition de devenir un acteur de premier plan des modèles fondamentaux open source.

Une architecture pensée pour la rapidité et les agents IA

MiMo-V2-Flash repose sur une architecture Mixture-of-Experts (MoE) de très grande envergure. Le modèle totalise 309 milliards de paramètres, mais n’en active que 15 milliards par requête, un choix technique qui permet de réduire drastiquement la latence et les coûts tout en maintenant un haut niveau de performance.

Xiaomi a conçu ce modèle pour des scénarios précis : agents autonomes, interactions multi-tours, et workflows complexes nécessitant des réponses rapides et cohérentes. Pour y parvenir, MiMo-V2-Flash adopte une attention hybride 1:5, combinant une attention globale, une Sliding Window Attention avec une fenêtre de 128 tokens.

Le modèle dispose d’un contexte natif de 32 000 tokens, tout en ayant été entraîné pour supporter des contextes allant jusqu’à 256 000 tokens, un atout clé pour l’analyse de documents volumineux et les tâches de raisonnement long.

Des performances de premier plan à coût maîtrisé

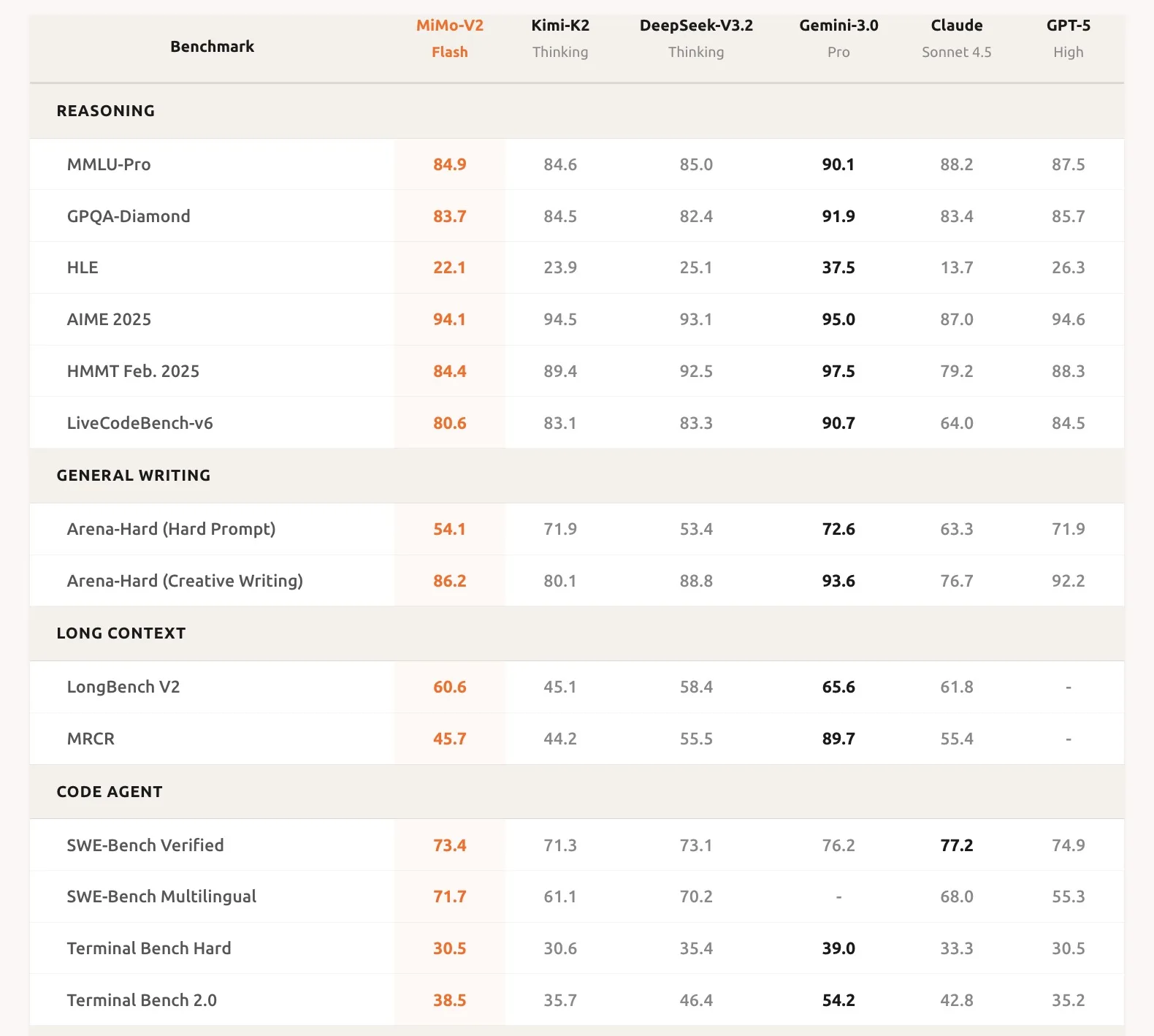

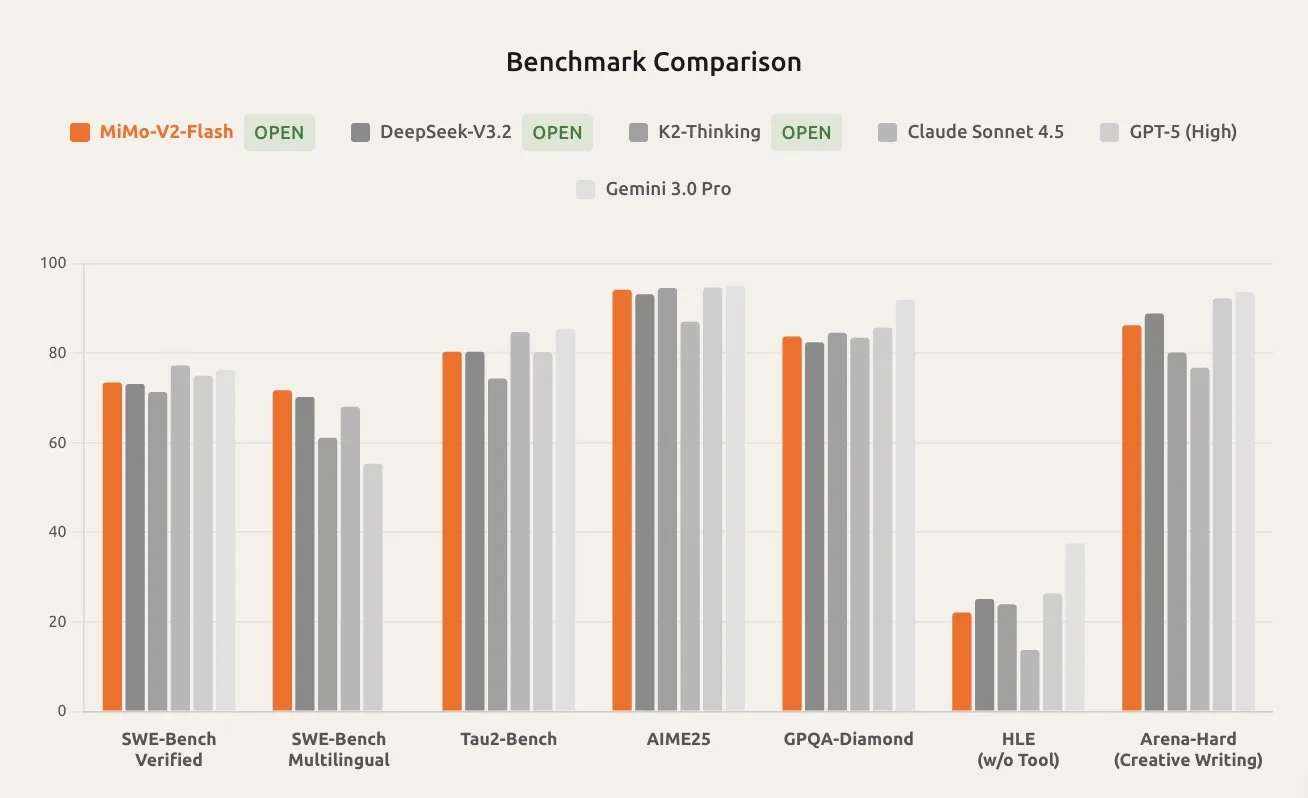

Sur le terrain des benchmarks, MiMo-V2-Flash se positionne immédiatement parmi les meilleurs modèles open source du moment. Il figure dans le top 2 des modèles open source sur des tests de raisonnement exigeants tels que AIME 2025 et GPQA-Diamond.

En ingénierie logicielle, ses résultats sur SWE-Bench Verified et SWE-Bench Multilingual le placent à un niveau comparable à GPT-5 et Claude 4,5 Sonnet, un signal fort pour les développeurs.

Côté vitesse, Xiaomi annonce une génération pouvant atteindre 150 tokens par seconde, tout en affichant un coût d’inférence extrêmement agressif :

- 0,10 dollar par million de tokens en entrée,

- 0,30 dollar par million de tokens en sortie.

Selon Xiaomi, cela représente environ 2,5 % du coût d’inférence de Claude, un différentiel qui pourrait séduire les startups comme les grandes entreprises. L’API est par ailleurs gratuite pour une durée limitée, afin d’encourager l’adoption.

Des innovations techniques orientées efficacité

Multi-Token Prediction : accélérer sans compromis

MiMo-V2-Flash intègre la Multi-Token Prediction (MTP), une technique permettant de générer plusieurs tokens en parallèle, puis de les valider avant la sortie finale. Contrairement aux approches classiques, cette méthode n’augmente ni la charge mémoire, ni le coût de l’attention.

Avec une configuration MTP à trois couches, Xiaomi annonce un gain de vitesse de 2 à 2,6 fois par rapport à un décodage standard.

MOPD : un entraînement plus intelligent et moins coûteux

Autre innovation majeure : la Multi-Teacher Online Policy Distillation (MOPD). Cette méthode de post-entraînement repose sur :

- plusieurs modèles « enseignants »,

- un système de récompenses au niveau du token,

- un apprentissage en ligne, directement exploitable en production.

Selon Xiaomi, le MOPD permet d’atteindre des performances élevées avec moins d’un cinquantième des ressources requises par les pipelines de reinforcement learning traditionnels. Le système accepte également des enseignants interchangeables, ouvrant la voie à des cycles d’auto-amélioration continus.

MiMo Studio : une interface pensée pour les développeurs

Pour accompagner le lancement, Xiaomi déploie MiMo Studio, une interface web accessible à l’adresse aistudio.xiaomimimo.com. Elle permet d’interagir directement avec MiMo-V2-Flash, de générer du code, de lancer des agents IA, d’activer la recherche Web, et de basculer entre réponses instantanées et mode « thinking » pour un raisonnement approfondi.

Le modèle s’intègre également avec des outils de développement populaires comme Claude Code et Cursor, et peut générer des pages web HTML fonctionnelles, démontrant sa polyvalence.

Un modèle entièrement open source

Xiaomi joue la carte de la transparence : Licence MIT, poids du modèle disponibles sur Hugging Face, code d’inférence publié sur GitHub. Le groupe a également contribué dès le lancement au projet SGLang, confirmant sa volonté de s’inscrire durablement dans l’écosystème open source et de séduire la communauté des développeurs.

Avec MiMo-V2-Flash, Xiaomi dépasse clairement le statut de constructeur hardware enrichi à l’IA. Le groupe pose les bases d’une offre logicielle stratégique, capable de concurrencer les meilleurs modèles du marché sur le terrain de la vitesse, du raisonnement et du coût.

Reste à voir si MiMo-V2-Flash parviendra à s’imposer face à des acteurs déjà solidement installés. Mais une chose est certaine : Xiaomi est désormais un nom à surveiller de très près dans la course aux modèles de langage open source.