La semaine précédant Thanksgiving aura été une véritable tempête dans le monde de l’IA. Après Gemini 3 chez Google et Codex-Max chez OpenAI, c’est au tour d’Anthropic de dégainer une réponse musclée pour son modèle Claude : Claude Opus 4,5, présenté comme son modèle « le plus avancé à ce jour », capable — selon la firme — de surpasser tous ses concurrents dans les tâches de programmation, d’agents autonomes et d’utilisation d’ordinateurs.

Un lancement stratégique, appuyé par des prix spectaculairement revus à la baisse, et qui confirme une tendance : la bataille des modèles n’est plus seulement algorithmique, elle est aussi économique.

Une montée en puissance nette : Claude Opus 4.5 dépasse humains et modèles rivaux

Anthropic n’a pas fait dans la demi-mesure : Claude Opus 4.5 aurait obtenu un score supérieur à tous les candidats humains à son test interne le plus difficile, un exercice d’ingénierie à effectuer en 2 heures.

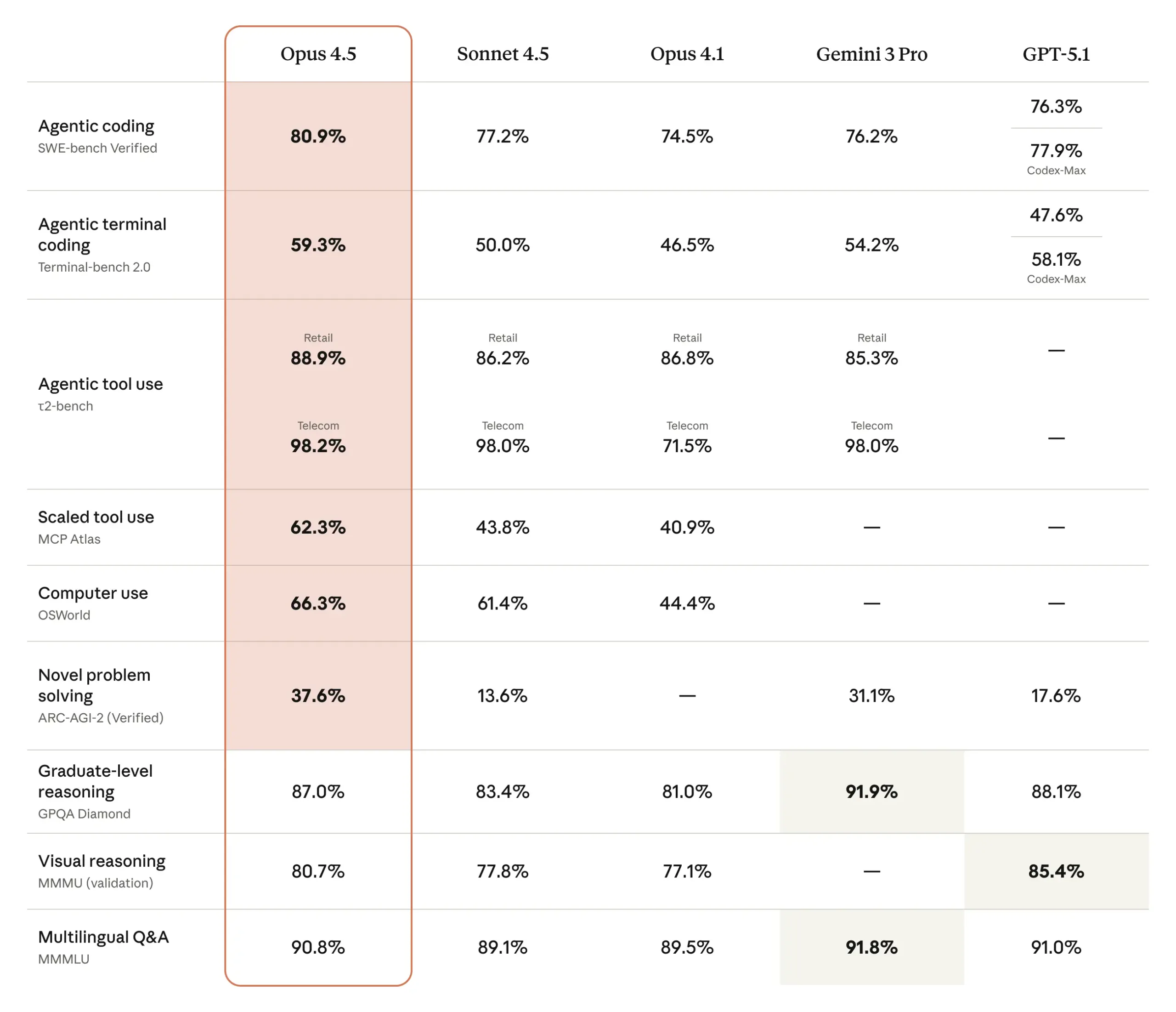

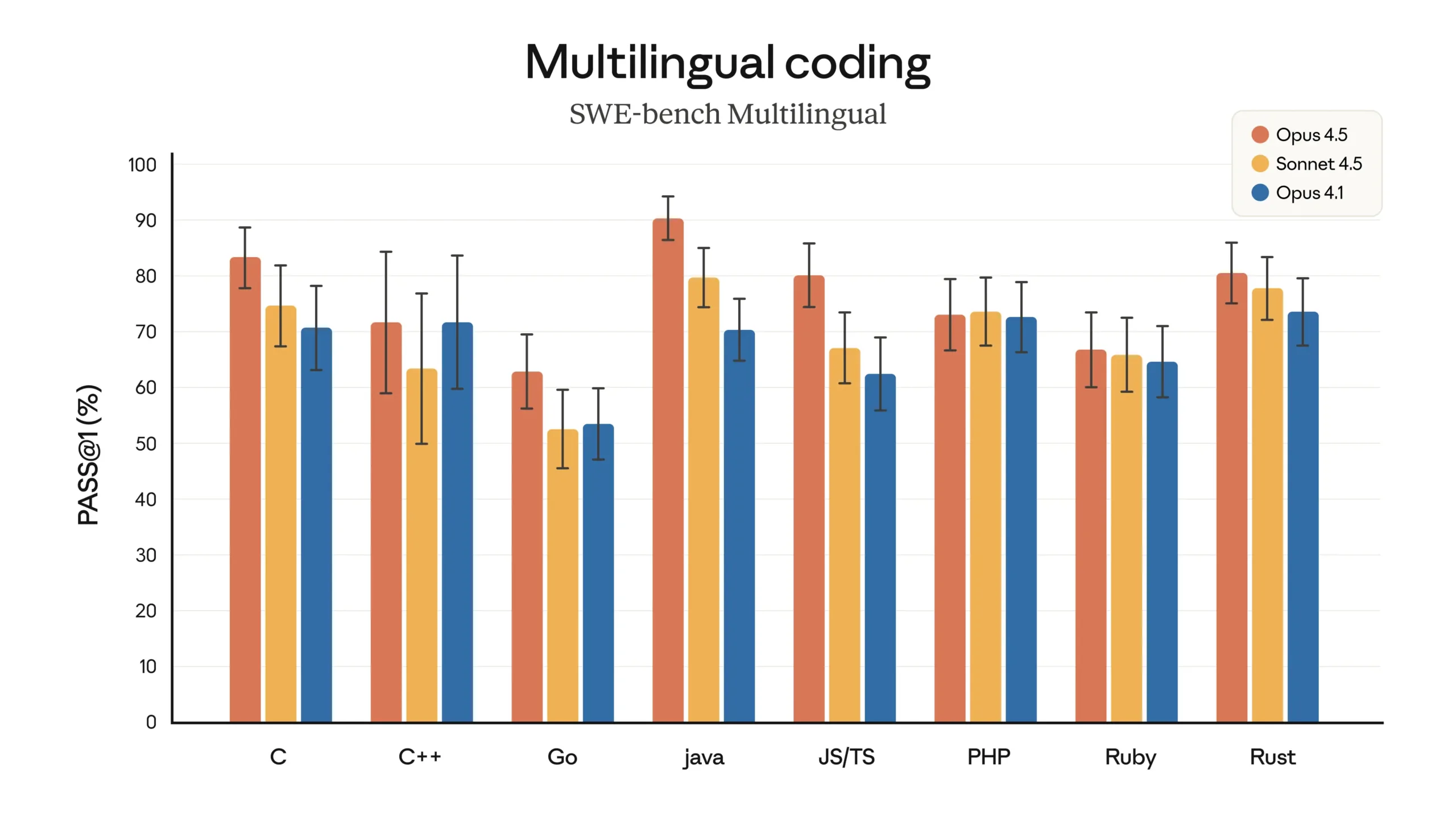

Mieux encore, il surclasse GPT-5.1 Codex-Max (OpenAI), Gemini 3 Pro (Google) et Claude Sonnet 4.5 (Anthropic) sur le benchmark SWE-bench Verified, référence absolue pour évaluer la résolution de problèmes réels en génie logiciel. Avec 80,9 %, Claude Opus 4.5 prend même l’avantage sur Codex-Max, lancé… cinq jours plus tôt.

Mais au-delà des chiffres, Anthropic insiste sur un changement plus subtil : une forme de jugement, ou d’intuition, que les équipes décrivent comme une amélioration qualitative du modèle. « Le modèle comprend vraiment ce qui compte », explique Alex Albert, directeur des relations développeurs. Un discours que l’on n’entend que lors des « sauts générationnels ».

Un positionnement agressif : prix divisés par trois, efficacité dopée

Anthropic semble vouloir imposer son modèle sur le terrain du rapport performance/prix. Le coût d’utilisation chute brutalement :

- 5 dollars/million de tokens en entrée

- 25 dollars/million de tokens en sortie

Contre respectivement 15 dollars et 75 dollars pour Opus 4.1.

Un mouvement qui met une pression directe sur OpenAI et Google — et qui pourrait rebattre les cartes du marché professionnel.

Côté efficacité, la firme annonce des gains massifs :

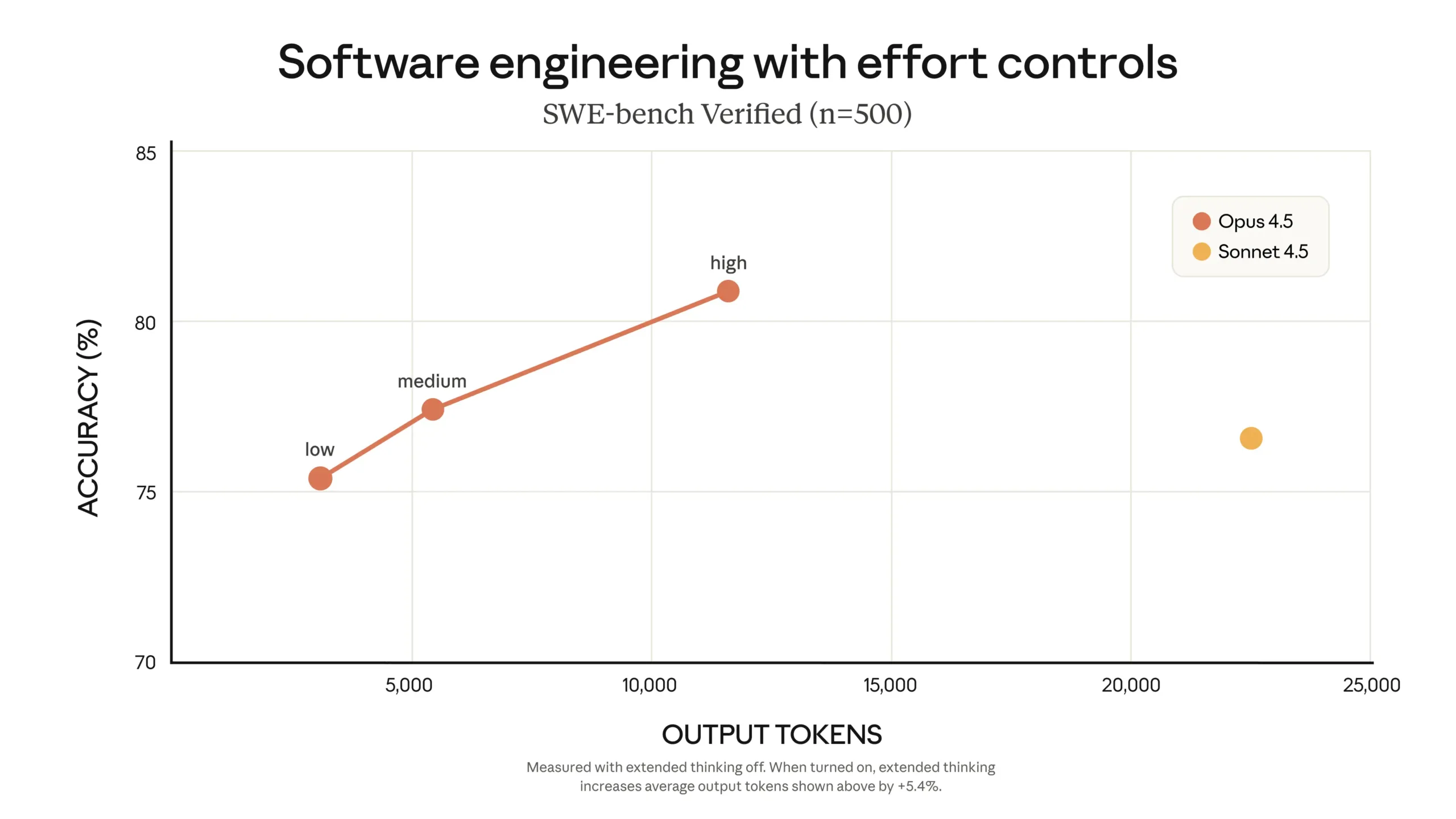

- –76 % de tokens utilisés pour atteindre le score maximal de Sonnet 4.5

- –48 % de tokens pour dépasser Sonnet 4.5 au niveau « effort maximal »

Un paramètre « effort » fait son apparition, permettant d’ajuster la puissance de raisonnement selon le besoin : vitesse, coût ou performance.

Quand les agents Claude apprennent par eux-mêmes ?

L’une des révélations les plus marquantes vient des tests clients : les agents Claude seraient capables de s’auto-améliorer à travers des itérations successives. Pas de modification des poids, mais une optimisation progressive de leurs méthodes et outils.

Exemple frappant : Rakuten rapporte que ses agents atteignent leur performance optimale en 4 itérations, quand d’autres modèles n’y parviennent pas après 10 essais.

Le phénomène s’étendrait même à la création de documents professionnels, de présentations ou de feuilles de calcul : un domaine où Anthropic dit avoir constaté « le plus grand saut générationnel » jamais observé dans la famille Claude.

Nouveautés produit : Excel, Chrome et… les conversations infinies

En parallèle du modèle, Anthropic introduit plusieurs mises à jour orientées entreprises :

Claude pour Excel

Désormais disponible pour les utilisateurs Max, Team et Enterprise, avec support des tableaux croisés dynamiques, graphiques et import de fichiers.

Extension Claude pour Chrome

Ouverte à tous les abonnés Max.

Conversations illimitées

Grâce à la compaction automatique et à une mémoire optimisée, les discussions peuvent désormais s’étendre indéfiniment — une réponse directe à la « course au contexte » lancée par OpenAI.

Tool calling programmatique

Claude peut désormais écrire et exécuter du code appelant directement des fonctions. Idéal pour l’automatisation complexe.

Claude Code (desktop)

Nouveau mode Plan, gestion parallèle de sessions agents, et évaluation interne spectaculaire.

Sécurité : des progrès… mais encore de grandes failles

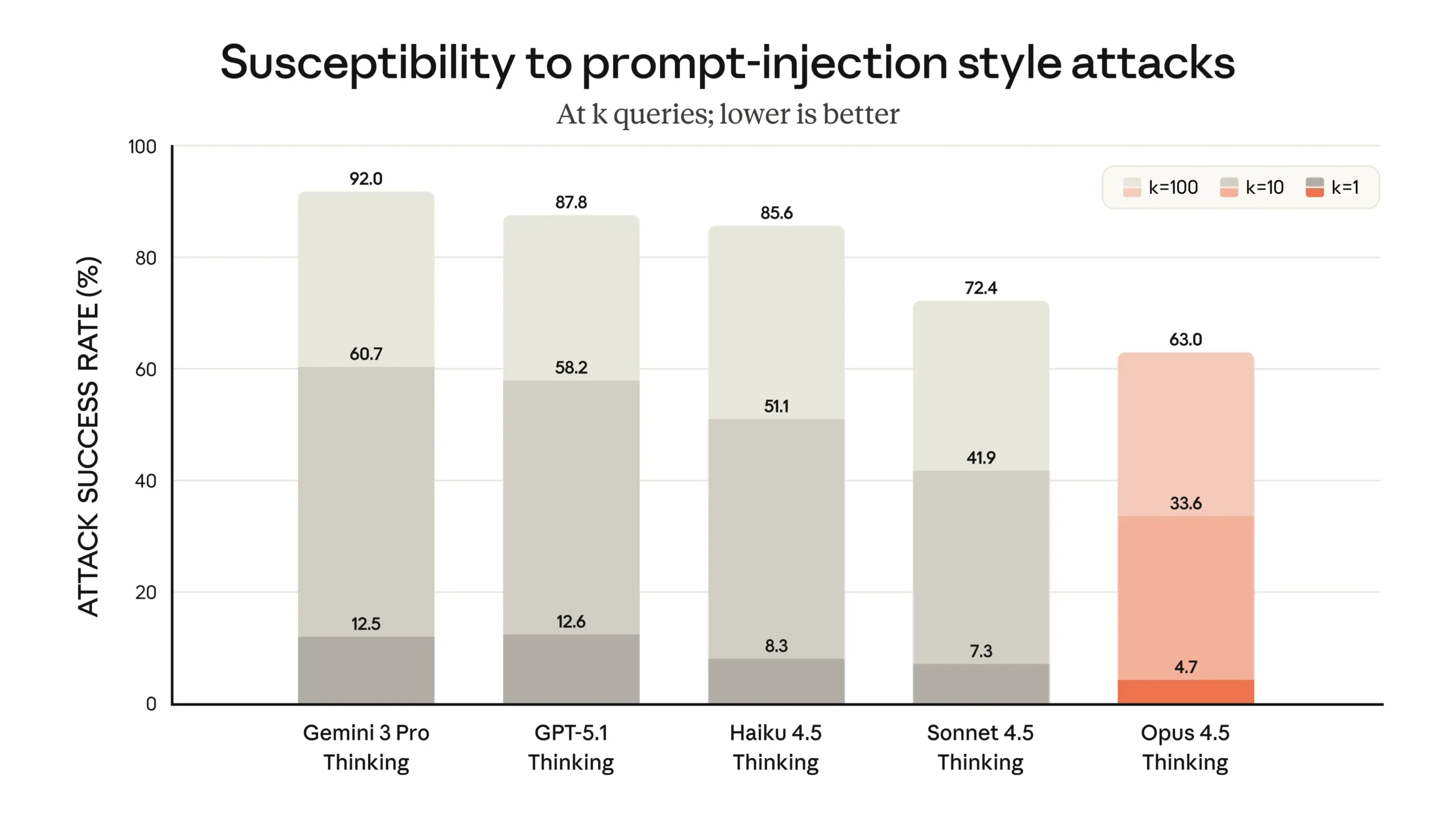

Anthropic n’esquive pas la question brûlante : la sécurité des agents autonomes. La firme affirme que Claude Opus 4.5 est « le modèle le plus résistant au prompt injection du marché ».

Mais, les cartes de sécurité montrent un tableau plus nuancé.

Refus de tâches malveillantes :

- 100 % sur tests de code malveillant en environnement Claude Code (bonne nouvelle)

- 78 % seulement lorsqu’il s’agit d’écrire malware, DDoS ou outils de surveillance

- 88 % de refus sur des usages « ordinateur » comme l’espionnage, la collecte de données sensibles ou la rédaction de messages frauduleux

En clair : Claude Opus 4.5 est meilleur que ses rivaux, mais loin d’être invulnérable.

Une compétition à son paroxysme : OpenAI, Google et Anthropic au coude-à-coude

Anthropic affiche un rythme de développement quasi frénétique :

- Haiku 4.5 en octobre

- Sonnet 4.5 en septembre

- Opus 4.5 en novembre

En parallèle, OpenAI multiplie les variantes GPT-5.x, et Google vient d’annoncer un Gemini 3 largement repensé.

Une cadence accélérée… grâce à Claude lui-même, admet Anthropic : le modèle participe dorénavant à la construction de son propre écosystème.

Claude Opus 4.5 : un tournant, un signal, un avertissement

Entre performances record, prix cassés et premiers signes d’agents auto-améliorants, Claude Opus 4.5 représente probablement l’un des plus gros changements de la décennie pour l’IA professionnelle.

Mais, les failles de sécurité — bien que réduites — rappellent une réalité incontournable : plus ces modèles gagnent en autonomie, plus les risques associés se complexifient.

Alex Albert conclut par une phrase qui résonne déjà dans tout le secteur : « C’est un signal très important sur ce qui arrive. ».

Et pour une fois, personne ne semble vouloir le contredire.