Microsoft met à la disposition des développeurs sa famille de modèles légers Phi-3, près d’un mois après l’avoir annoncée. Phi-3-medium, Phi-3-small et Phi-3-mini sont disponibles pour les développeurs, Phi-3-mini faisant partie d’Azure AI. En outre, l’entreprise présente également une variante multimodal du petit modèle, appelée Phi-3-vision, qui comporte 4,2 milliards de paramètres.

Lors de la Build 2024, Microsoft a également dévoilé deux autres modèles de la famille Phi-3, notamment Phi-3 Small (7B) et Phi-3 Medium (14B). Tous ces modèles sont open source sous licence MIT.

Développé par Microsoft Research, Phi-3 est un puissant modèle de langage de 3 milliards de paramètres, conçu pour offrir un raisonnement aussi percutant que les Large Language Model, mais à un coût nettement inférieur. Il s’agit de la quatrième itération des modèles de langage compacts sur lesquels Microsoft travaille : Phi-1 a été développé il y a un an avant de céder la place à Phi-1.5 et Phi-2.

Quant au modèle Phi-3 Vision, il est entraîné sur 4,2 milliards de paramètres. Cela signifie que le modèle est relativement léger. C’est la première fois qu’une méga-entreprise comme Microsoft met en libre accès un modèle multimodal. La longueur du contexte est de 128 Ko et il est possible d’ajouter des images. Google a publié le modèle PaliGemma, mais il n’est pas destiné à une utilisation conversationnelle.

Par ailleurs, Microsoft indique que le modèle Phi-3 Vision a été entraîné à partir de données éducatives et de code de haute qualité accessibles au public. Microsoft a également généré des données synthétiques pour les mathématiques, le raisonnement, les connaissances générales, les graphiques, les tableaux, les diagrammes et les diapositives.

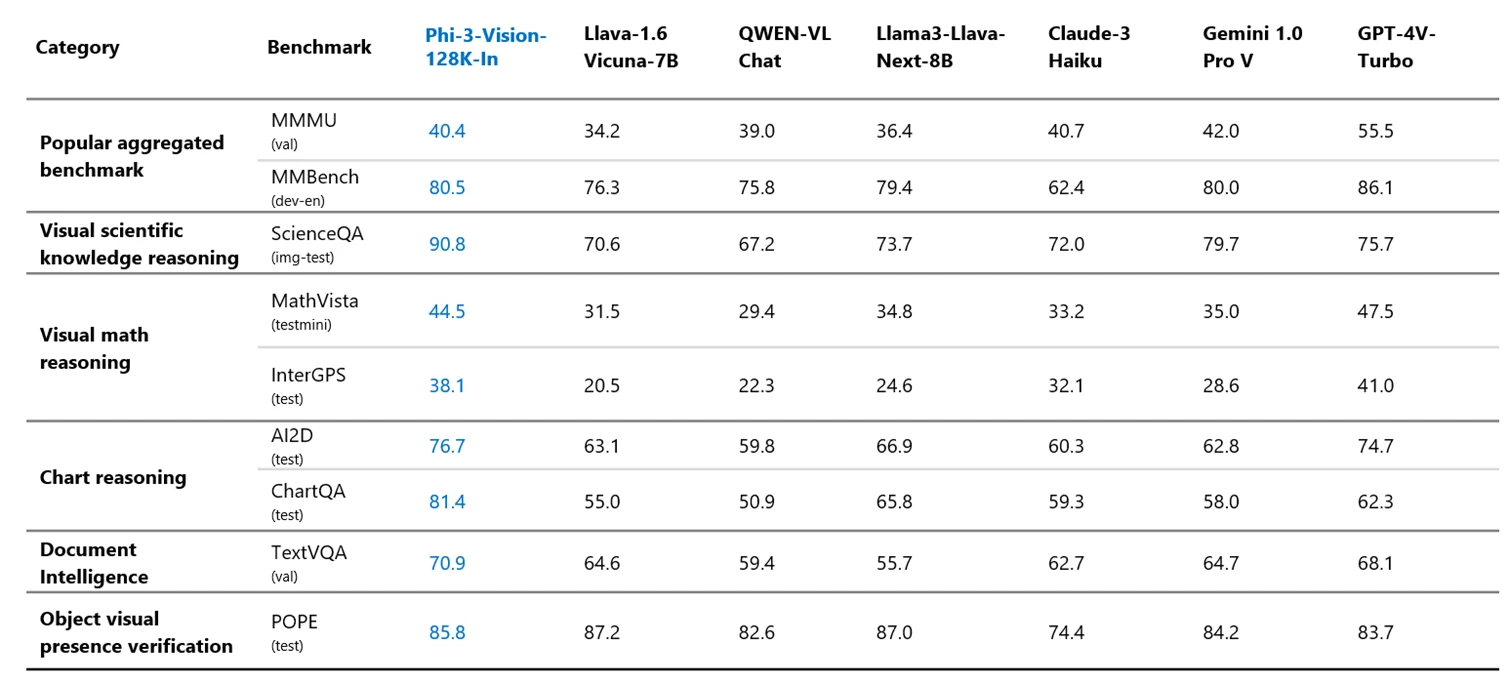

Malgré sa petite taille, le modèle Phi-3 Vision est plus performant que Claude 3 Haiku, LlaVa et Gemini 1.0 Pro sur de nombreux benchmarks multimodaux. Il se rapproche même du modèle GPT-4V d’OpenAI. Microsoft indique que les développeurs peuvent utiliser le modèle Phi-3 Vision pour l’OCR, la compréhension des graphiques et des tableaux, la compréhension générale des images, etc.

La course à l’IA avec Phi-3 Vision

Tous les cas d’utilisation ne nécessitent pas un Large Language Model. La volonté de mettre en œuvre l’IA localement ou sur l’appareil conduit les développeurs à rechercher des options plus performantes et plus petites. Et le nombre d’offres augmente non seulement avec Phi-3

Si vous souhaitez découvrir le modèle Phi-3 Vision, rendez-vous sur Azure AI Studio. La sortie publique de Phi-3 n’est pas une coïncidence, car l’avènement des AI PC est imminent. Les développeurs peuvent désormais utiliser les différentes variantes pour apporter leurs implémentations d’IA aux ordinateurs portables, aux appareils mobiles et aux wearables.