Meta, le géant des réseaux sociaux anciennement connu sous le nom de Facebook, est un pionnier de l’intelligence artificielle (IA) depuis plus d’une décennie, l’utilisant pour alimenter ses produits et services tels que le fil d’actualité, les publicités Facebook, Messenger et la réalité virtuelle. Mais à mesure que la demande de solutions d’IA plus avancées et plus évolutives augmente, le besoin d’une infrastructure d’IA plus innovante et plus efficace se fait également sentir.

Lors de l’événement AI Infra @ Scale qui s’est tenu hier — une conférence virtuelle d’une journée organisée par les équipes d’ingénierie et d’infrastructure de Meta — la société a annoncé une série de nouveaux projets matériels et logiciels visant à soutenir la prochaine génération d’applications d’IA. L’événement a réuni des intervenants de Meta qui ont partagé leurs idées et leurs expériences sur la construction et le déploiement de systèmes d’IA à grande échelle.

Meta construit sa première puce personnalisée spécifiquement pour exécuter des modèles d’IA, a annoncé la société jeudi. Alors que Meta intensifie ses efforts en matière d’IA — le PDG Mark Zuckerberg a récemment déclaré que l’entreprise voyait « une opportunité de présenter des agents d’IA à des milliards de personnes de manière utile et significative » — la puce et d’autres plans d’infrastructure révélés jeudi pourraient être des outils critiques pour

Meta afin de concurrencer d’autres géants de la technologie qui investissent également d’importantes ressources dans l’IA.

Ce que le nouvel accélérateur d’inférence IA de Meta apporte

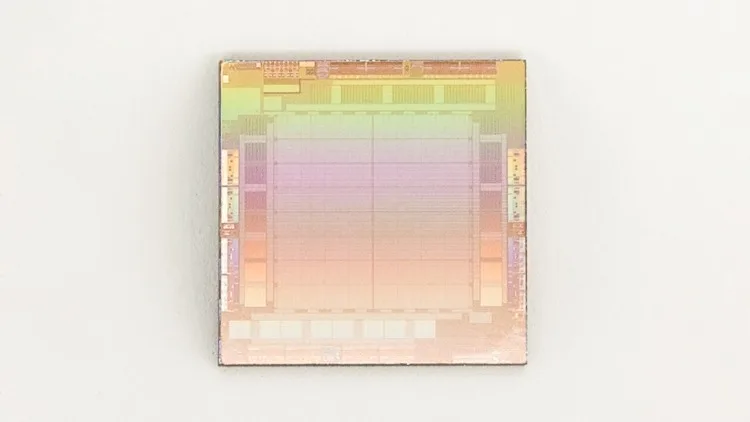

La nouvelle puce MTIA de Meta, qui signifie Meta Training and Inference Accelerator, est sa « famille interne de puces d’accélération personnalisées ciblant les charges de travail d’inférence », a écrit Santosh Janardhan, vice-président de Meta et responsable de l’infrastructure, dans un article de blog. La puce fournit apparemment « une puissance de calcul et une efficacité supérieures » à celles des CPU et est « personnalisée pour nos charges de travail internes ». Les puces d’inférence d’IA construites sur mesure ne sont pas une nouveauté. Google développe son unité de traitement tensoriel (TPU) depuis plusieurs années et Amazon dispose de ses propres puces AWS inferentia depuis 2018.

En combinant les puces MTIA et les GPU, Janardhan a déclaré que Meta pensait « offrir de meilleures performances, une latence réduite et une plus grande efficacité pour chaque charge de travail ».

Le MTIA pourrait être une aubaine pour Meta, notamment en raison de la demande croissante de puissance de calcul pour l’IA. Mais, la puce MTIA semble encore loin : elle ne devrait pas sortir avant 2025, rapporte TechCrunch.

En plus de la MTIA, Meta présente également un nouvel ASIC spécialement conçu pour aider au transcodage vidéo, qu’elle appelle le « MSVP », ou Meta Scalable Video Processor (processeur vidéo évolutif). Il est conçu pour prendre en charge à la fois « le transcodage de haute qualité nécessaire pour la VOD ainsi que la faible latence et les temps de traitement plus rapides que le streaming en direct exige », a déclaré Meta dans un billet de blog séparé, et « à l’avenir », il aidera à apporter des éléments tels que le contenu créé par l’IA et le contenu spécifique à l’AR et à la VR dans les applications de Meta.

La construction d’une infrastructure d’IA est un enjeu de taille en 2023

Meta travaille également sur une « conception de centre de données de nouvelle génération » qui sera « optimisée pour l’IA » et « plus rapide et plus rentable à construire », a déclaré Janardhan, et la société a également vanté la puissance de son superordinateur AI Research SuperCluster (RSC), « qui, selon nous, est l’un des superordinateurs AI les plus rapides au monde ». Le supercalculateur d’IA qui intègre 16 000 GPU pour aider à former de grands modèles de langage (LLM) comme le projet LLaMA, que Meta a annoncé à la fin du mois de février. « Nous construisons une infrastructure avancée pour l’IA depuis des années maintenant, et ce travail reflète des efforts à long terme qui permettront encore plus d’avancées et une meilleure utilisation de cette technologie dans tout ce que nous faisons », a déclaré Mark Zuckerberg, PDG de Meta, dans un communiqué.

Là encore, Meta est loin d’être le seul hyperscaler ou grand fournisseur informatique à réfléchir à une infrastructure d’IA spécifique. En novembre, Microsoft et NVIDIA ont annoncé un partenariat pour un supercalculateur d’IA dans le cloud. Le système bénéficie (sans surprise) des GPU NVIDIA, connectés à la technologie de réseau InfiniBand Quantum 2 de NVIDIA.

Quelques mois plus tard, en février, IBM a présenté les détails de son supercalculateur d’IA, dont le nom de code est Vela. Le système d’IBM utilise du silicium x86, des GPU NVIDIA et un réseau Ethernet. Chaque nœud du système Vela est équipé de 8 GPU A100 de 80 Go. L’objectif d’IBM est d’élaborer de nouveaux modèles de base pour répondre aux besoins des entreprises en matière d’intelligence artificielle.

Pour ne pas être en reste, Google s’est également lancé dans la course aux superordinateurs d’IA en annonçant son projet le 10 mai. Le système de Google utilise des GPU NVIDIA ainsi que des unités de traitement d’infrastructure (IPU) conçues sur mesure pour permettre un flux de données rapide.