OpenAI a fait d’énormes vagues lors du lancement de GPT-4 cette semaine. Le modèle de langage d’IA de nouvelle génération représente une amélioration notable par rapport à son prédécesseur et est capable de beaucoup plus. Si vous connaissez un peu ChatGPT et ses alternatives, vous savez déjà ce que cela signifie pour les chatbots et l’intelligence artificielle en général. Cependant, pour ceux qui ne connaissent pas les modèles de langage ou GPT-4 en particulier, je suis là pour vous aider.

Voici un guide dédié à GPT-4. Si vous n’avez que peu ou pas d’informations à ce sujet, prenez une tasse de café, et asseyez-vous pendant que je vous explique tout sur ce modèle d’IA.

Qu’est-ce que le GPT-4 ?

En termes simples, GPT-4 est la dernière itération d’OpenAI dans les grands systèmes de modèles de langage (LLM) de l’entreprise. Les systèmes de modèles de langage, en général, sont des systèmes qui tentent de prédire le mot suivant dans une phrase et d’y ajouter intelligemment leurs données. Pour ce faire, ils étudient un vaste ensemble de données qui leur permet d’identifier des modèles et d’agir en conséquence.

GPT-4 est le modèle le plus récent de cette série et devrait constituer une amélioration considérable par rapport aux modèles de la génération précédente, tels que GPT 3 et 3.5. GPT-4 est plus performant sur certains points spécifiques, que j’aborderai en détail ci-dessous. Cependant, il est important de comprendre que ce nouveau modèle permettra aux chatbots tels que ChatGPT et Bing alimenté par l’IA d’être beaucoup plus performants dans leurs réponses. Vous pouvez donc vous attendre à ce qu’ils donnent de meilleures réponses, à ce qu’ils soient plus créatifs et à ce qu’ils agissent différemment avec les anciennes et les nouvelles invites de ChatGPT.

GPT-4 est multimodal

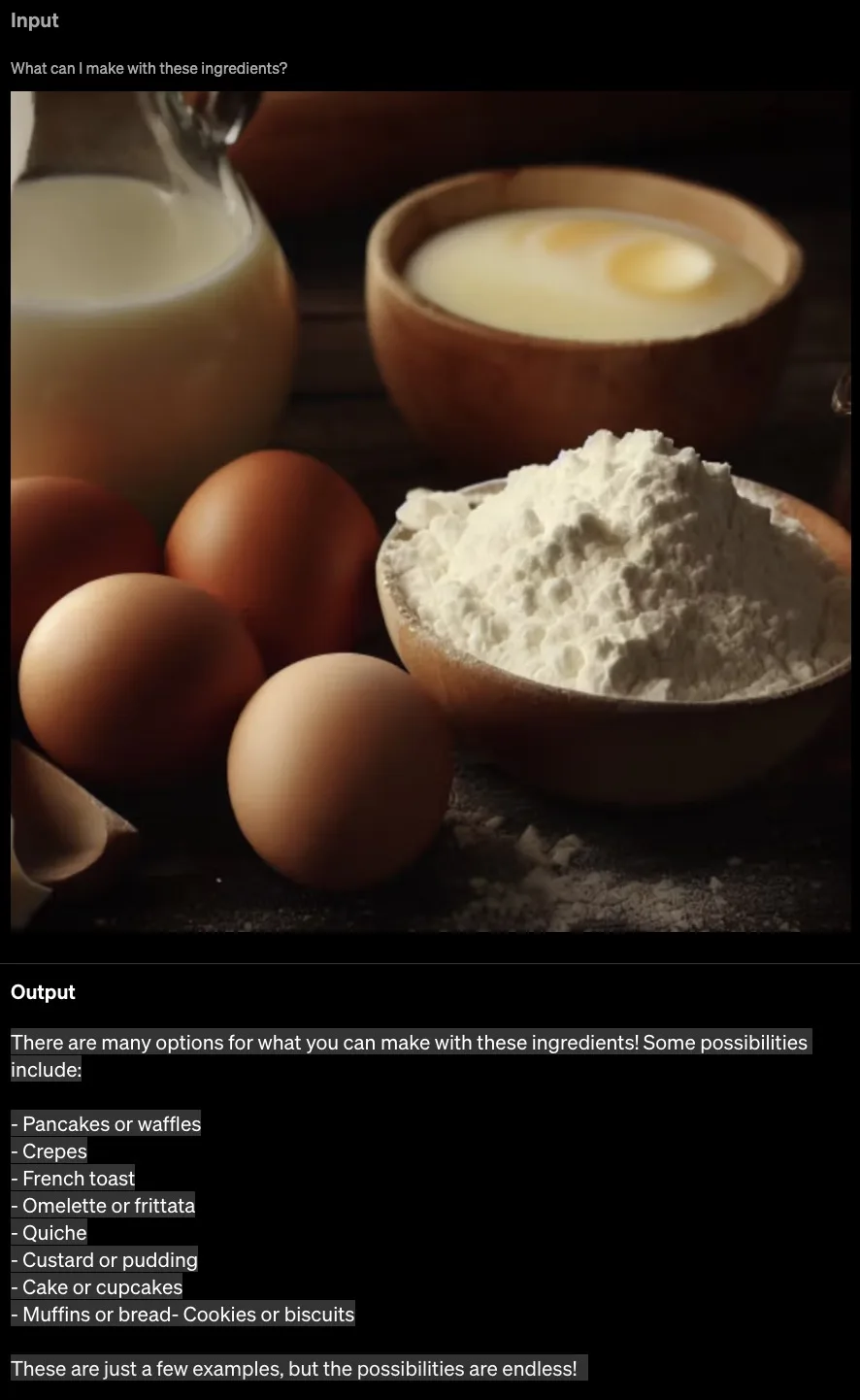

Si vous avez utilisé les précédents modèles GPT, vous savez peut-être que leur capacité à interpréter le texte saisi est limitée. Cependant, l’une des nouveautés les plus importantes du nouveau modèle est qu’il est multimodal. Cela signifie que GPT-4 est capable d’accepter des invites sous forme de texte et d’images.

Cela signifie que l’IA ne se contente pas de recevoir l’image, mais qu’elle l’interprète et la comprend. Cette compréhension s’appliquera aux messages entrecoupés de texte et d’images. En outre, la capacité multimodale de GPT-4 s’étendra à toutes les tailles et à tous les types d’images et de textes, y compris les documents contenant du texte et des photographies, des diagrammes (esquissés ou dessinés à la main) ou des captures d’écran. Les résultats de GPT-4 resteront aussi performants que s’il ne s’agissait que d’entrées textuelles.

Lors du livestream organisé par OpenAI à l’intention des développeurs, l’entreprise a présenté la nature multimodale de GPT-4. GPT-4 a reçu une capture d’écran d’une fenêtre Discord et a été invité à la décrire dans les moindres détails.

Le modèle a pris un peu plus d’une minute et a fourni une réponse extrêmement descriptive et précise. La réponse reprenait presque tous les éléments de l’écran d’entrée. Du nom du serveur dans le coin supérieur gauche aux différents canaux vocaux, en passant par le nom de tous les membres de Discord en ligne dans le panneau de droite, GPT-4 a tout saisi.

GPT-4 a été soumis à d’autres tests au cours desquels les utilisateurs ont soumis plusieurs œuvres d’art aléatoires, dont des photos d’un écureuil tenant un appareil photo. On a ensuite demandé au modèle d’identifier « ce qui était drôle dans cette image ». Il a de nouveau répondu que la photo était drôle parce que les écureuils mangent généralement des noix et n’agissent pas comme les humains. Comme on peut le voir, il a de nouveau fourni une réponse très précise, comme le ferait un humain.

Toutefois, comme indiqué plus haut, la spécificité du modèle va au-delà des captures d’écran et s’étend aux entrées de texte et d’image de tous types. OpenAI en a fait la démonstration lorsque Greg a pris une photo d’une maquette dessinée à la main d’un site Web humoristique. Il l’a ensuite téléchargée sur le serveur Discord de GPT-4, connecté à l’API. Le modèle a ensuite été invité à « écrire un bref code HTML/JS pour transformer la page en site Web et remplacer les blagues par des blagues réelles ».

Étonnamment, GPT-4 a compilé un code fonctionnel pour la même chose. Après l’avoir testé, il a produit un site Web entièrement fonctionnel sur lequel les blagues étaient affichées en appuyant sur les boutons. Le fait que le modèle ChatGPT puisse déchiffrer l’écriture humaine et créer du code à partir d’une combinaison de textes et d’images est époustouflant. La capacité multimodale de GPT-4 est un grand pas en avant vers la compréhension totale des messages par l’IA et la production de résultats d’une précision irréprochable.

Bien qu’il n’y ait pas eu de problèmes majeurs, OpenAI a déclaré que la vitesse était un point sur lequel GPT-4 pouvait travailler et que cela pourrait prendre du temps. En outre, les entrées visuelles de GPT-4 sont encore en phase de recherche et ne sont pas encore accessibles au public.

En quoi GPT-4 est-il meilleur que GPT 3.5/GPT-3 ?

Outre son approche multimodale époustouflante, GPT-4 comporte d’autres domaines d’amélioration où le nouveau modèle ne se contente pas de surpasser ses aînés. Voici quelques-uns de ces domaines.

Une meilleure compréhension

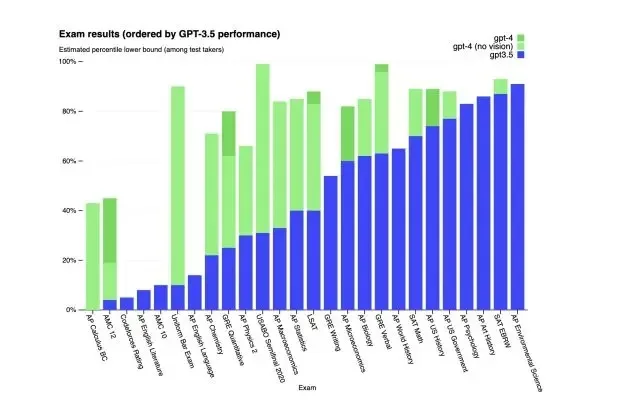

OpenAI affirme qu’il peut être difficile de voir la différence entre GPT-4 et GPT-3.5 à première vue. Cependant, les capacités du premier se révèlent lorsque l’on entre dans les détails. Pour démontrer cette différence, le nouveau modèle a été comparé à GPT-3.5 dans une série d’examens de niveau humain. OpenAI a utilisé les tests publics les plus récents et n’a donné aux modèles aucune formation spécifique à cet effet.

Les données elles-mêmes brossent un tableau plus complet que nous ne pourrions le faire. Dans tous les résultats, GPT-4 est arrivé en tête et a obtenu un score supérieur à celui de son ancienne version. Alors que le seuil a été à peine dépassé dans certains examens, les performances ont considérablement augmenté dans d’autres examens. OpenAI a déclaré que « GPT-4 est également plus fiable, plus créatif et généralement capable de gérer des instructions plus nuancées par rapport à GPT-3.5 ».

Cela signifie que le chatbot peut comprendre facilement des instructions plus complexes.

Une limite de mots exponentiellement plus grande

Si tout le monde a adoré GPT 3 et GPT 3.5, certains ont souhaité qu’il puisse reconnaître des entrées encore plus longues. L’introduction de GPT-4 a résolu ce problème. Le nouveau modèle linguistique d’IA GPT-4 est doté d’une limite d’entrée de 25 000 mots, ce qui est considérablement plus élevé. Pour mémoire, le modèle GPT 3.5 était limité à 8 000 mots.

Cela signifie que les utilisateurs pourront alimenter le chatbot avec des invites de saisie beaucoup plus longues, qu’il pourra lire et à partir desquelles il produira des résultats. Ainsi, lorsque GPT-4 sera enfin lancé, vous pouvez vous attendre à ce qu’il donne une réponse beaucoup plus détaillée et accepte sans problème des entrées plus longues. Pour les développeurs, cela signifie qu’ils pourront trouver de nouvelles API et de la documentation pour le chatbot et obtenir plus facilement de l’aide pour écrire du code ou corriger des bugs dans le code existant.

Prise en charge d’un plus grand nombre de langues

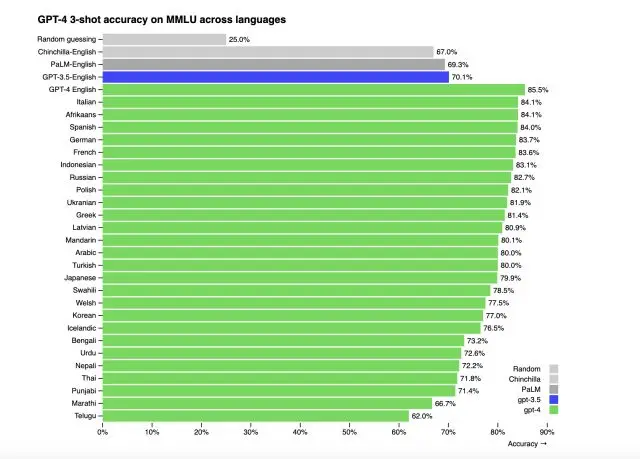

ChatGPT a été principalement utilisé par les anglophones du monde entier. Cependant, GPT-4 prend en compte d’autres langues. Le modèle le plus récent a démontré qu’il prenait en charge plus de 26 langues différentes. Cela inclut l’ukrainien, le coréen, les langues germaniques et bien d’autres encore.

OpenAI a testé la même chose en traduisant les repères MMLU dans une variété de langues. Sur 26 langues, GPT-4 surpasse les performances de GPT-3.5 en anglais dans 24 d’entre elles. Cependant, il reste encore des données à traiter avant que GPT-4 ne prenne en charge toutes les langues.

Différentes personnalités

Le style est un concept dans lequel vous pouvez demander à l’IA d’agir d’une certaine manière avec un ton de voix fixe. Un bon exemple est de demander à ChatGPT d’agir comme un cow-boy ou un officier de police. GPT-4 conserve cette capacité de pilotage, mais OpenAI rend désormais plus difficile pour l’IA de rompre le personnage. Les développeurs peuvent maintenant fixer le style de leur IA dès le départ en décrivant ces directions dans le message « system ». Comme ces messages sont faciles à pirater, OpenAI s’efforce également de les rendre plus sûrs.

D’après les démonstrations présentées par OpenAI dans son article de blog, il était assez amusant de voir l’utilisateur essayer de faire en sorte que GPT-4 cesse d’être un tuteur socratique et lui donne simplement la réponse à sa question. Cependant, comme il a été programmé pour être un tuteur, GPT-4 a refusé de rompre le personnage, ce à quoi de nombreux développeurs peuvent s’attendre lorsqu’ils formeront leurs robots à l’avenir.

Applications possibles de GPT-4 ?

Bien que l’application multimodale de GPT-4 ne soit pas encore possible pour les utilisateurs, OpenAI s’est déjà associée à Be My Eyes, une application destinée aux malvoyants. L’intégration de GPT-4 dans l’application vous permet de prendre une photo de ce que vous regardez et l’IA décrira exactement ce qui se trouve à l’écran, y compris des robes, des plantes, des machines dans un gymnase, la lecture de cartes, et bien plus encore.

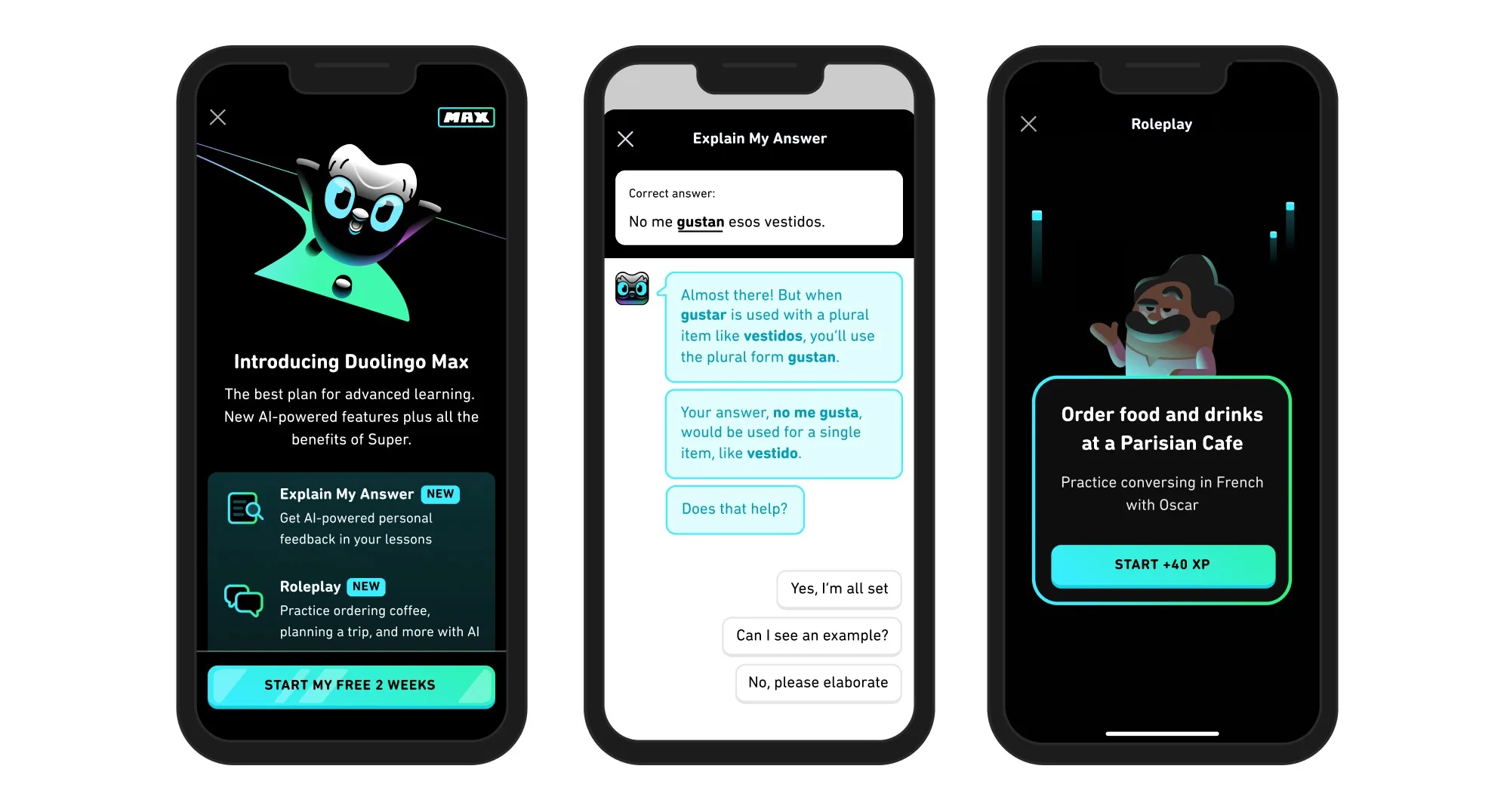

GPT-4 s’est également associé à d’autres applications telles que Duolingo, Khan Academy pour l’apprentissage intelligent, et même le gouvernement islandais pour la préservation de la langue. Bien que l’API de GPT-4 soit actuellement disponible sur liste d’attente, on peut s’attendre à ce que les développeurs proposent des expériences étonnantes une fois qu’elle sera enfin disponible. Avant même que cela n’arrive, les applications ci-dessus sont déjà disponibles.

GPT-4 présente-t-il des limites ?

Même si GPT-4 est considéré comme la prochaine étape de l’intelligence artificielle, il n’en demeure pas moins qu’il présente des faiblesses. Tout d’abord, GPT-4 n’a aucune connaissance des événements survenus après septembre 2021. Le modèle n’apprend pas non plus de son expérience. Le modèle GPT-4 peut donc commettre des erreurs de raisonnement et est même enclin à accepter des déclarations manifestement fausses de la part d’un utilisateur.

GPT-4 peut également échouer face à des problèmes, tout comme les humains le feraient. Comme GPT 3.5, le nouveau modèle peut également halluciner et se tromper avec certitude dans ses prédictions. Cela pourrait conduire GPT-4 à ne pas revérifier son travail lorsqu’il commet parfois une erreur.

Malgré cela, OpenAI promet que GPT-4 a été mieux entraîné que les précédents modèles pour éviter cela. Dans les évaluations internes de la société sur la factualité contradictoire, le modèle a obtenu un score supérieur de 35 % à celui de GPT 3.5 pour ce qui est de la réduction des hallucinations. Bien que les perceptions et les prédictions du modèle se soient améliorées, ses résultats doivent toujours être pris en compte en conjonction avec des conseils humains.

OpenAI Evals — améliorer ensemble GPT-4

L’OpenAI utilise son propre framework logiciel pour créer et exécuter des tests de référence pour des modèles tels que GPT-4. Toutefois, comme il s’agit d’un logiciel libre, l’entreprise a partagé quelques modèles qui ont été les plus utilisés. OpenAI a commencé à faire en sorte que les évaluations fassent partie intégrante des benchmarks de crowdsourcing qui peuvent être utilisés pour s’assurer que GPT-4 est mieux formé et qu’il est encore plus performant.

L’entreprise a donc invité tout le monde (oui, tous les utilisateurs de GPT-4) à tester ses modèles par rapport à des critères de référence et à soumettre leurs exemples. Vous trouverez plus d’informations à ce sujet sur la page de recherche GPT-4 d’OpenAI.

Comment accéder à GPT-4 dès maintenant ?

Malheureusement, GPT-4 n’est pas encore disponible pour tout le monde. OpenAI a actuellement mis le nouveau modèle à la disposition des seuls abonnés ChatGPT Plus, avec une limite d’utilisation. Les abonnés Plus bénéficient également d’un accès limité à deux versions différentes de GPT-4. Alors que certains utilisateurs peuvent utiliser le moteur 32K de GPT-4, qui leur donne une limite de mots plus longue, d’autres sont restreints à GPT-4 8K avec une capacité limitée.

OpenAI a déclaré que cette capacité serait ajustée dynamiquement en fonction de la demande. Si vous ne pouvez pas prendre la peine de vous abonner à ChatGPT Plus, vous serez heureux d’apprendre que Microsoft Bing utilise déjà GPT-4. Bien que vous ne puissiez pas jouer avec le modèle de langage comme sur OpenAI, c’est tout de même une bonne chose d’expérimenter et d’essayer différents types de choses.