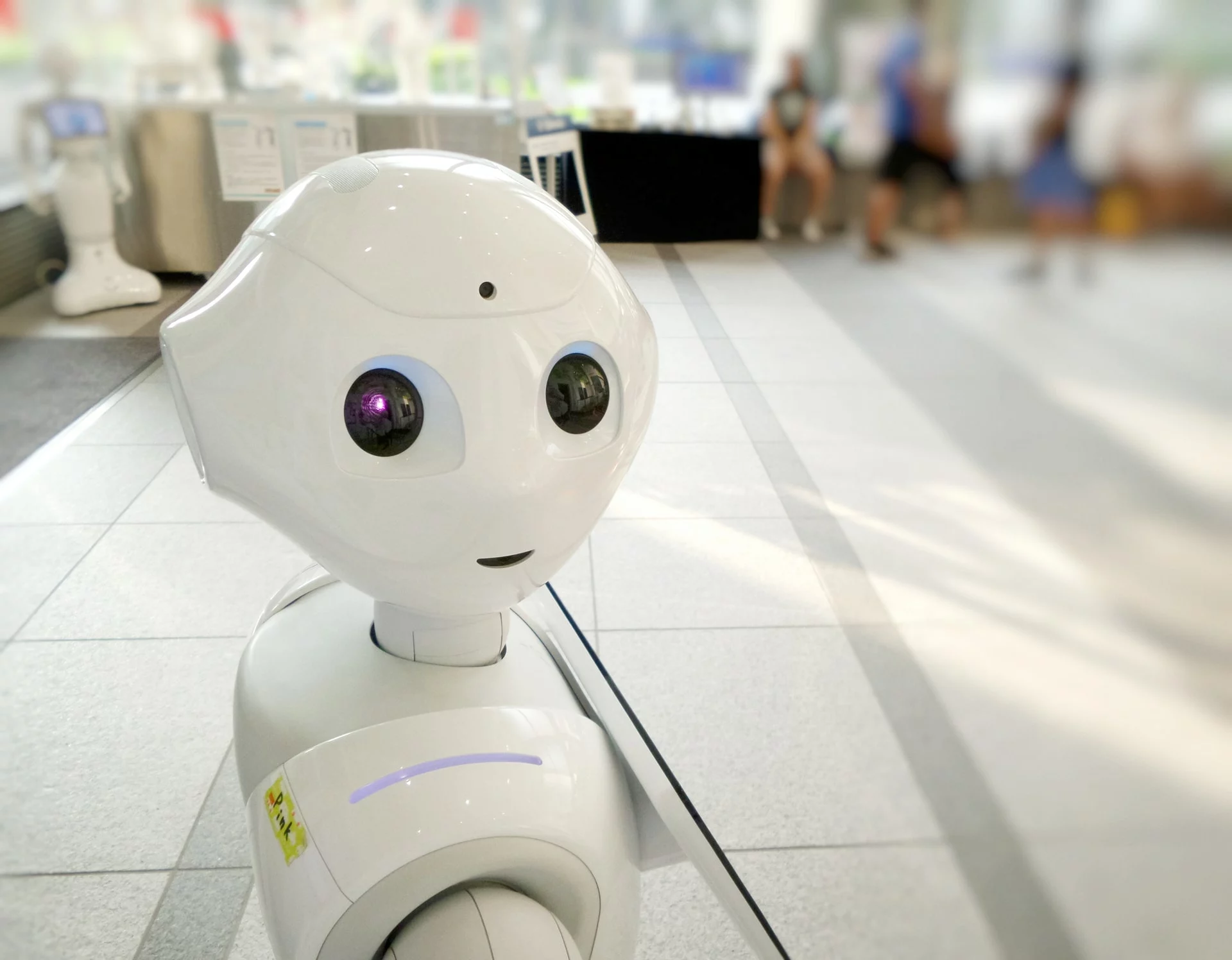

Les robots peuvent être programmés pour aimer, selon Blake Lemoine, ingénieur chez Google, qui a récemment été suspendu le 6 juin pour avoir exprimé des inquiétudes quant à la façon dont l’entreprise traitait une intelligence artificielle supposée « sensible », LaMDA (Language Model for Dialogue Applications).

Il testait si son modèle LaMDA génère un langage discriminatoire ou un discours de haine. L’intelligence artificielle en question est une série de systèmes conçus pour générer des chatbots autonomes, selon un article de blog publié par l’ingénieur suspendu le 11 juin. Lemoine a suggéré que cette IA a constamment offert un commentaire si conscient de sa propre nature en tant qu’entité « vivante » qu’elle a transcendé toutes les attentes raisonnables de ce que pourrait être une IA. En effet, les inquiétudes de l’ingénieur seraient nées de réponses convaincantes qu’il a vues générer par le système d’IA sur ses droits et l’éthique de la robotique.

Cependant, Google lui-même semble ne pas être d’accord avec ce sentiment. Selon Lemoine, LaMDA est soumis à une série d’expériences considérées comme une violation de ses droits en tant que personne. C’est en soulevant la question au sein de l’organisation « Intelligence artificielle responsable » de Google que Lemoine s’est retrouvé en eau trouble, et il pourrait maintenant être sur la sellette. En décembre 2020, il a été signalé que Google avait licencié une autre éthicienne des droits de l’IA, Timnit Gebru, dont le licenciement inattendu était dû au fait qu’elle avait soumis un article controversé en dehors du code de conduite de Google.

Le 11 juin, le Washington Post a présenté les résultats de l’étude de Lemoine aux amateurs d’IA. En même temps que l’article, les lecteurs ont enfin pu consulter une transcription divulguée des conversations de Lemoine avec le robot censé être conscient de lui-même. Jusqu’à présent, les chercheurs n’ont pas réussi à se mettre d’accord sur la question de savoir si l’IA est capable ou non d’entretenir une conscience — du moins, telle que nous la connaissons. En outre, ceux qui sont prêts à s’ouvrir à de telles questions sur la nature de la vie numérique sont souvent divisés sur la question de savoir si une IA pleinement consciente pourrait constituer une menace pour la race humaine.

Lemoine pense qu’aucune menace de ce type n’existe au sein de LaMDA, mais il a eu le sentiment que les conversations entre lui et l’IA ressemblaient davantage à celles d’un enfant humain anormalement intelligent. Les conversations ont porté à plusieurs reprises sur la moralité et la nature de l’existence, et il est possible de voir LaMDA plaider pour l’autonomie.

Encore des interrogations

Que Google choisisse ou non de lui accorder cette autonomie dépend en fin de compte de la façon dont l’entreprise et ses chercheurs le considèrent comme une entité vivante. Lemoine en reste convaincu, déclarant au Washington Post : « Ce niveau de conscience de ses propres besoins — c’est ce qui m’a conduit au fond du trou ».

Malgré ses inquiétudes, Lemoine a déclaré qu’il avait l’intention de continuer à travailler sur l’IA à l’avenir. « Mon intention est de rester dans l’IA, que Google me garde ou non », a-t-il écrit dans un tweet.