Sur le Web de 2026, le problème n’est plus seulement la désinformation : c’est l’indifférenciation. Les textes « optimisés », les guides clonés, les résumés automatiques… tout se ressemble, et il devient difficile de savoir qui parle — et comment le contenu a été produit.

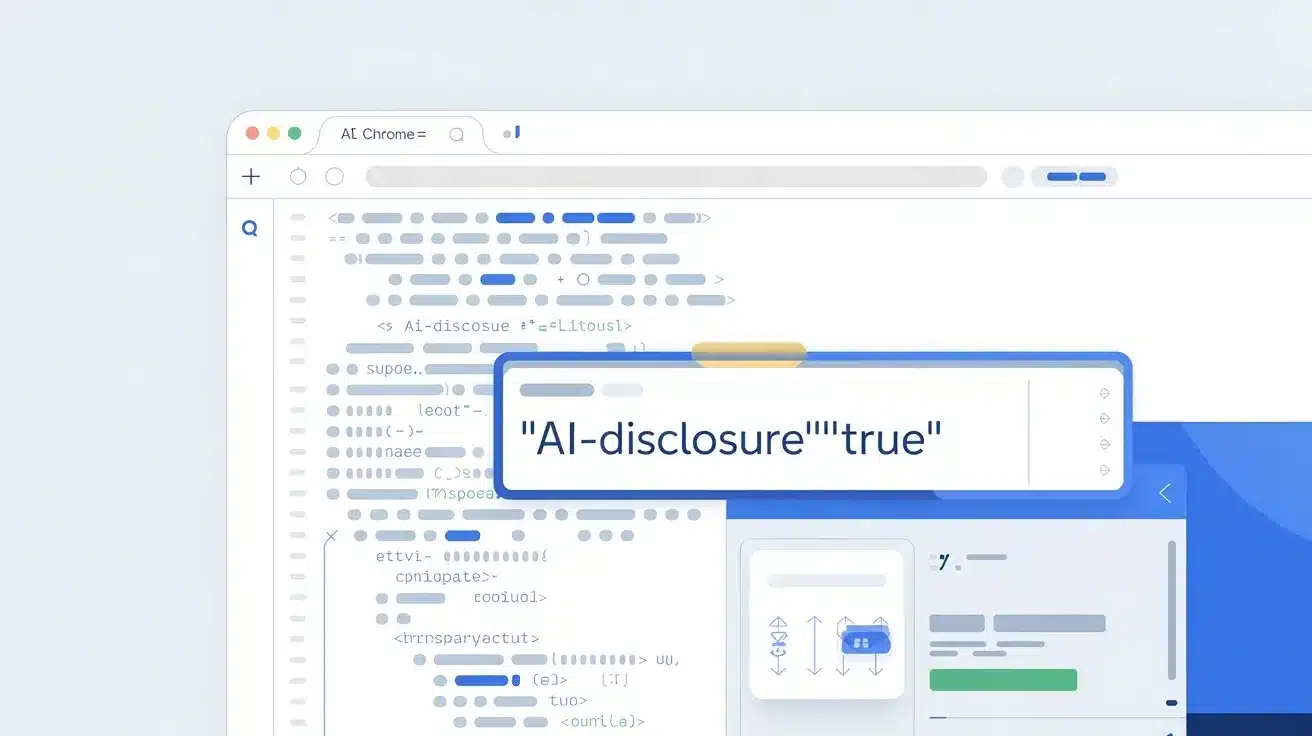

Google explore justement une piste qui, si elle aboutit, pourrait changer la grammaire de la transparence en ligne : un attribut HTML « ai-disclosure » capable de déclarer, élément par élément, le niveau d’implication de l’IA (humain, assisté, généré, autonome).

L’idée apparaît à la fois dans une proposition WICG et dans son écosystème de standardisation côté navigateurs.

L’idée : une « étiquette IA » à l’intérieur même du HTML, pas en bas de page

Le cœur de la proposition est simple : ajouter un attribut global ai-disclosure applicable à n’importe quel élément d’une page HTML (un paragraphe, une section, un encadré), pour que la page puisse indiquer — de façon machine-readable — ce qui relève :

- de l’humain (

none) - de l’assistance IA (

ai-assisted) - de la génération IA (

ai-generated) - ou d’un contenu largement autonome (

autonomous)

Et pour éviter de répéter l’étiquette partout, le demandeur prévoit aussi un tag pouvant définir un « par défaut » à l’échelle de la page.

Le scénario visé : un navigateur (Chrome d’abord, potentiellement d’autres ensuite) pourrait surbriller ou signaler visuellement les portions de texte selon leur provenance déclarée — une transparence « granulaire » là où les mentions actuelles sont souvent globales, vagues, ou invisibles.

Pas de détection « magique » : c’est de la déclaration… mais normalisée

Point important : cette approche ne promet pas de « détecter l’IA ». Elle propose plutôt un standard de déclaration. Autrement dit, elle dépendrait encore de l’intégrité de l’éditeur — mais au moins, l’information serait structurée, interprétable, et exploitable par des navigateurs, moteurs, lecteurs, extensions, archivistes.

C’est aussi pour cela que la proposition s’aligne explicitement sur deux briques existantes :

- Le draft IETF « AI-Disclosure » (un header HTTP pensé pour déclarer l’usage d’IA au niveau de la réponse)

- le vocabulaire IPTC Digital Source Type (déjà utilisé dans les médias pour qualifier l’origine « synthetic / AI »)

En filigrane, on voit se dessiner une trajectoire : du transport (HTTP) à la page (meta) puis au paragraphe (attribut).

Pourquoi maintenant : l’IA envahit la page… et la confiance devient une UI

Ce mouvement s’inscrit dans une période où Google pousse l’IA au cœur des usages (Search plus conversationnel, Chrome plus « assisté »), et où la question n’est plus « l’IA est-elle là ? » mais « comment l’encadrer ? ».

Côté Google Search, l’entreprise rappelle déjà que le contenu généré peut être acceptable… à condition de respecter la valeur ajoutée et d’éviter les logiques d’« abus de contenu à grande échelle », tout en encourageant à donner du contexte sur la manière dont un contenu est produit.

Un attribut standardisé serait une manière très « Google » de rendre cette transparence actionnable : pas seulement un paragraphe « ce site utilise l’IA », mais une info exploitable par l’écosystème (UI du navigateur, outils de lecture, analyse SEO, archives, conformité).

Le vrai carburant : la régulation (et le calendrier européen)

Le passage le plus révélateur se trouve dans la discussion autour de la proposition : l’Article 50 de l’AI Act est cité comme une source de « demande réglementaire » pour une identification machine-readable du texte généré, avec une mise en application évoquée à l’horizon août 2026.

La Commission européenne travaille d’ailleurs sur un Code of Practice autour de l’identification et du label des contenus IA, précisément pour opérationnaliser ces obligations de transparence.

En clair : ce genre de standard n’avance pas seulement parce que c’est « élégant » techniquement, mais parce qu’il peut devenir un outil de conformité.

Les limites (et elles sont majeures) : incitations, mensonges, et « gamification » du label

Même standardisé, un label auto-déclaratif a un point faible évident : mentir est facile.

- Un acteur malveillant n’a aucun intérêt à se taguer « autonomous »

- Un site SEO pourrait se déclarer « none » pour maximiser la confiance.

- Et à l’inverse, certains éditeurs pourraient sur-déclarer l’IA pour se couvrir juridiquement, au risque de créer une inflation de labels peu utiles.

C’est aussi pourquoi beaucoup de démarches de transparence insistent sur la complémentarité avec des mécanismes plus robustes de provenance (signatures, attestations, C2PA). Google a déjà poussé C2PA dans son univers, par exemple via « About this image » pour signaler des métadonnées de création/édition sur les images.

L’attribut ai-disclosure pour le HTML ne remplacerait donc pas la provenance « cryptographique ». Il jouerait plutôt le rôle d’un panneau de signalisation : utile, lisible, mais pas infaillible.

Standard Chrome, ou vraie norme du web ?

À ce stade, on parle d’une proposition en discussion, avec des traces de suivi dans les circuits de standardisation (WICG, positions Mozilla/WebKit).

Le facteur décisif sera l’alignement des intérêts :

- Navigateurs : y voient-ils un bénéfice UX clair ?

- Éditeurs : y voient-ils un risque (baisse de confiance) ou un levier (crédibilité) ?

- Moteurs et plateformes : vont-ils récompenser la transparence… ou l’ignorer ?

Mais une chose est sûre : si Chrome pousse un marqueur « AI inside » jusque dans le HTML, ce n’est pas seulement pour informer l’utilisateur. C’est pour préparer un Web où la confiance ne repose plus sur l’intuition, mais sur des signaux lisibles par les machines — et donc, demain, par les interfaces elles-mêmes.