Donner dix ans de données Apple Watch à une IA pour obtenir un verdict santé : l’idée ressemble à une démo futuriste. Sauf que, dans la vraie vie, elle peut surtout produire une chose très humaine… de l’angoisse. Et, un résultat changeant, parfois à quelques messages d’intervalle.

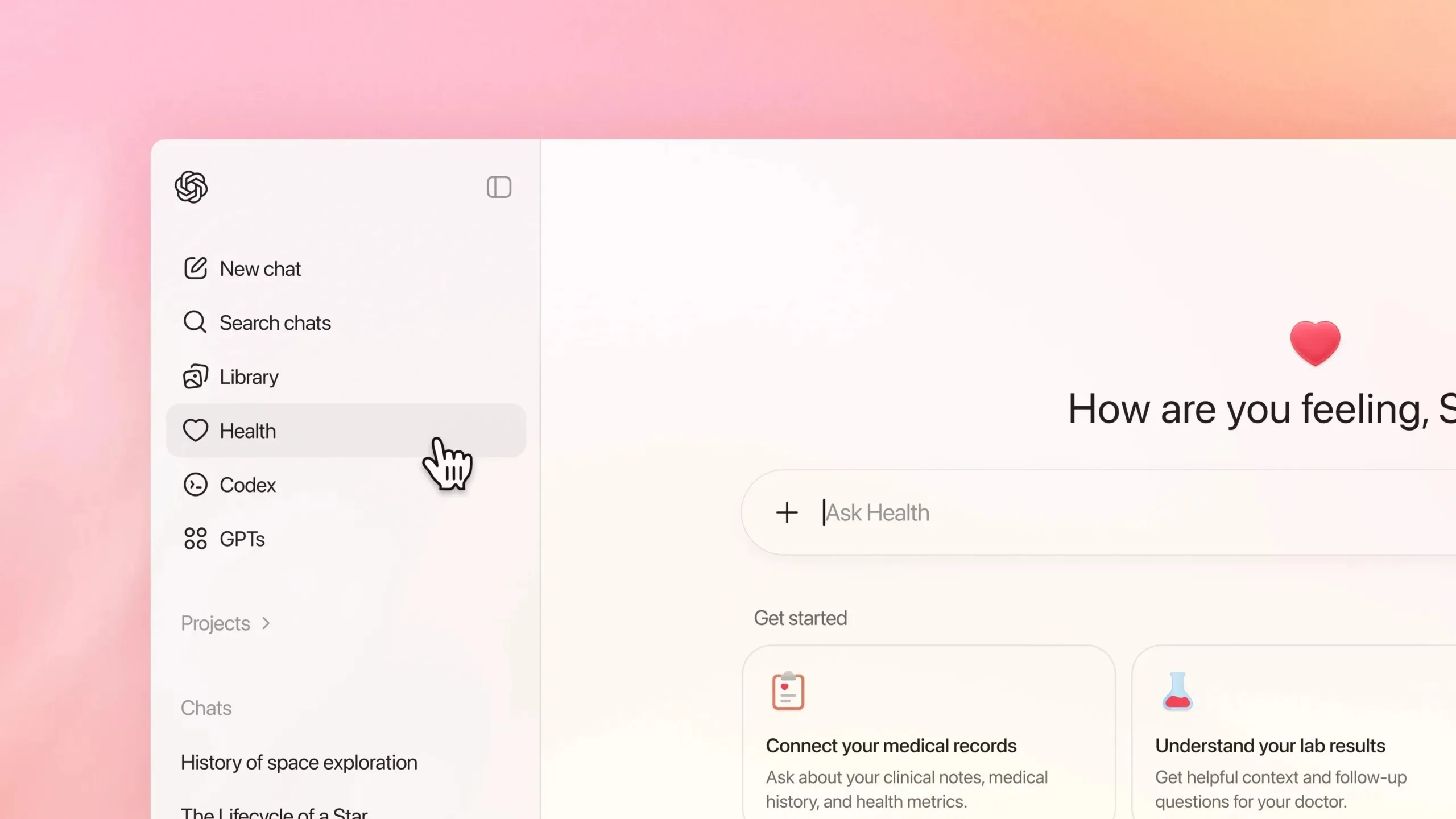

Dans une récente enquête, un journaliste du Washington Post a connecté ChatGPT Health à une décennie de métriques issues de l’Apple Watch (pas, fréquence cardiaque, tendances, etc.) et a demandé une simple note de santé cardiovasculaire. Résultat : un « F ». Après avoir ajouté davantage d’informations médicales, la note remonte… à « D ». Chez Anthropic, Claude for Healthcare délivre de son côté un « C » sur des données similaires.

Problème : des médecins consultés dans la foulée jugent ces conclusions peu fondées et jugent l’état général du patient bon.

Le cœur du sujet n’est pas que l’IA se trompe (ça, on le savait). C’est la volatilité du verdict, comme si l’outil changeait de personnalité selon le contexte, la formulation ou les pièces jointes. Une « note » n’a l’air de rien… jusqu’au moment où elle vous suit dans la tête.

Pourquoi ces « IA médecins » patinent encore ?

Ces nouvelles briques santé sont pensées pour transformer des chiffres en phrases compréhensibles : résumer des tendances, expliquer des résultats, préparer des questions à poser à son médecin. Anthropic met en avant des intégrations en bêta (Apple Health, Health Connect, HealthEx, Function) et insiste sur le consentement et la non-utilisation des données santé pour l’entraînement.

Mais, l’enquête du Washington Post montre surtout un piège classique : l’illusion de précision. Le ton est assuré, le vocabulaire médical crédible… et pourtant l’outil peut surpondérer des indicateurs discutables, confondre corrélation et causalité, ou interpréter un signal bruité comme un red flag.

À cela s’ajoute un point structurel : ces IA ne sont pas des dispositifs médicaux au sens strict, et leurs garde-fous sont souvent… des disclaimers. Dans l’article, des experts soulignent aussi la question de la protection des données (toutes les garanties ne relèvent pas forcément des mêmes cadres qu’un parcours de soins).

Derrière la fonctionnalité, une bataille stratégique (Apple inclus)

Ce qui se joue ici dépasse le gadget. OpenAI et Anthropic cherchent à devenir l’interface « naturelle » de votre vie numérique — et la santé est le Graal : données fréquentes, personnelles, et riches en contexte.

Et, Apple observe, forcément. Selon des rumeurs récurrentes, Cupertino préparerait Health+, une offre avec coaching (possiblement dopée à l’IA) dans le courant de 2026. Si ces projets se concrétisent, Apple devra réussir là où les autres trébuchent déjà : fiabilité, explicabilité, et surtout un ton qui aide sans déclencher des alertes injustifiées.

L’usage « safe » se dessine assez clairement :

- Oui pour résumer, traduire un jargon, préparer un rendez-vous.

- Non pour se laisser enfermer dans une note ou un diagnostic sorti d’un chat.

Le plus grand risque n’est pas seulement l’erreur : c’est l’autorité perçue. Un « F » peut pousser à paniquer, un « A » peut pousser à ignorer un vrai signal. Dans les deux cas, la machine devient un arbitre émotionnel — et c’est précisément ce qu’elle ne devrait pas être.