La compétition entre les géants américains de l’IA et les laboratoires chinois vient de prendre un nouveau tournant. Le très ambitieux DeepSeek, installé à Hangzhou, a dévoilé deux nouveaux modèles de raisonnement avancé, DeepSeek-V3.2 et DeepSeek-V3.2-Speciale — ce dernier atteignant des performances équivalentes, voire supérieures, aux modèles les plus puissants d’OpenAI et de Google.

Et ce qui change la donne : DeepSeek distribue ces modèles en open source sous licence MIT, libres d’utilisation et de modification. Une attaque frontale contre les plateformes propriétaires américaines.

DeepSeek-V3.2 et DeepSeek-V3.2-Speciale : Deux modèles, deux ambitions

DeepSeek-V3.2 : le « modèle quotidien »

C’est celui qui alimente désormais l’application DeepSeek. Un assistant de raisonnement général, pensé pour des usages courants, mais déjà très performant.

DeepSeek-V3.2-Speciale : l’arme lourde

Réservé pour l’instant à l’API, ce modèle atteint des scores « médaille d’or » dans quatre compétitions ultra-sélectives :

- IMO 2025 (Olympiade Internationale de Mathématiques)

- CMO (Olympiade Chinoise de Mathématiques)

- IOI 2025 (Olympiade d’Informatique)

- ICPC World Finals

Un exploit jusqu’ici réservé aux variantes spécialisées d’OpenAI et Google — comme Gemini 2.5 Deep Think, médaillé d’or à l’IMO 2025.

🚀 Launching DeepSeek-V3.2 & DeepSeek-V3.2-Speciale — Reasoning-first models built for agents!

🔹 DeepSeek-V3.2: Official successor to V3.2-Exp. Now live on App, Web & API.

🔹 DeepSeek-V3.2-Speciale: Pushing the boundaries of reasoning capabilities. API-only for now.📄 Tech… pic.twitter.com/SC49UdmCZv

— DeepSeek (@deepseek_ai) December 1, 2025

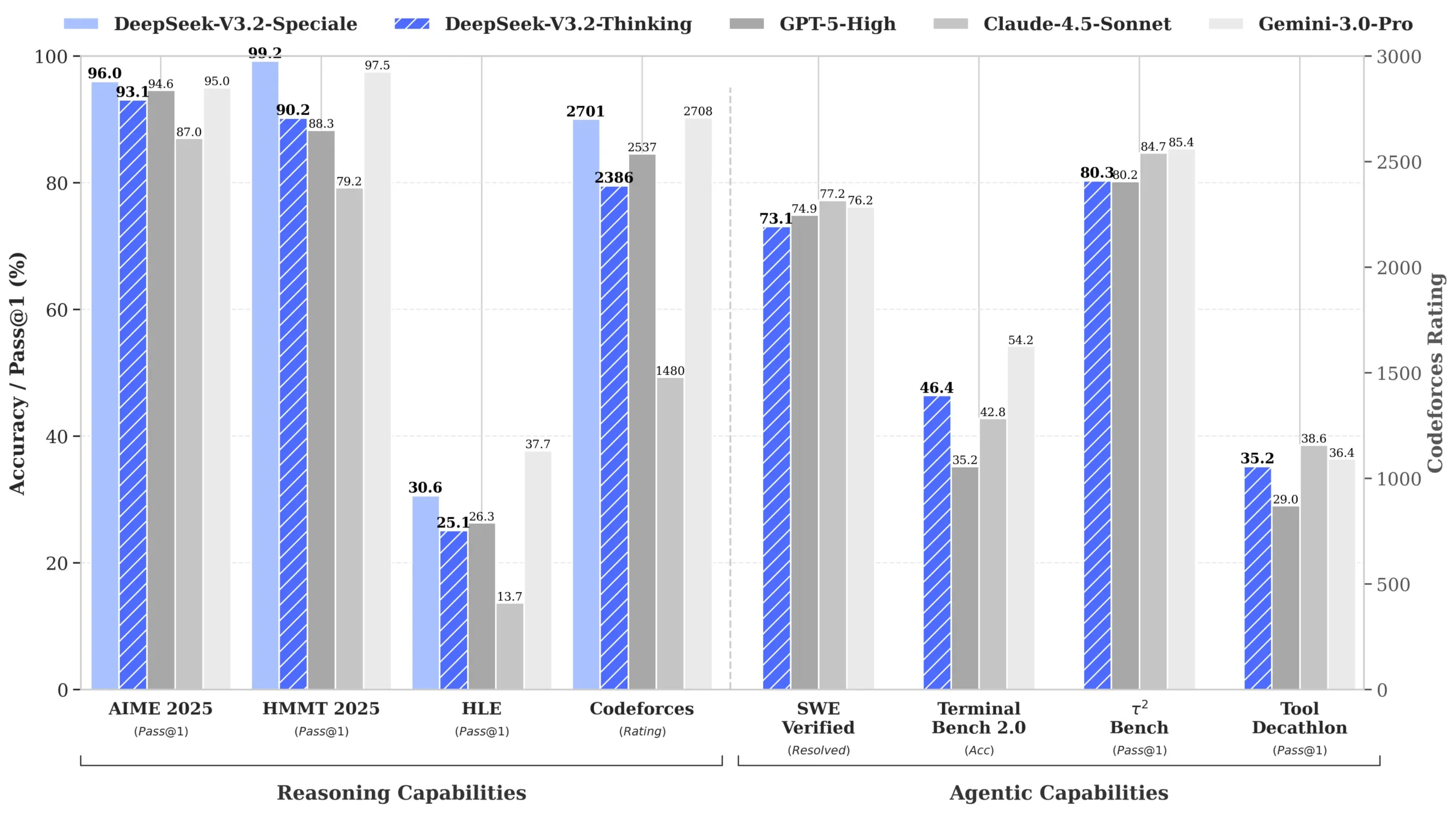

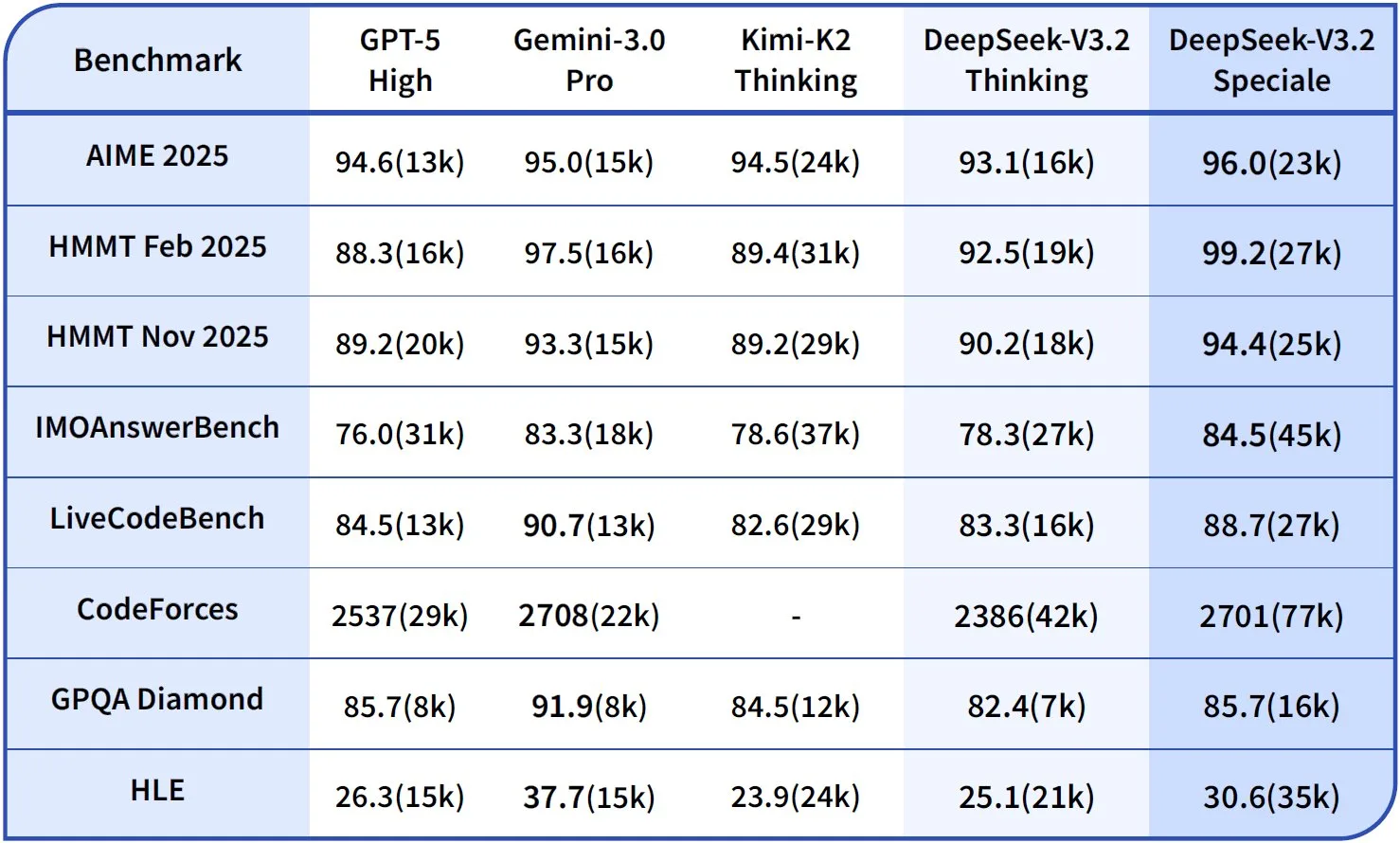

Benchmarks : DeepSeek au niveau des meilleurs modèles américains

Sur les tests de raisonnement avancé, la version DeepSeek-V3.2-Speciale place la barre très haut :

- AIME 2025 : 96.0 (GPT-5 High : 94.6 — Gemini 3 Pro : 95.0)

- SWE Verified (debug logiciel) : 73.1 (Gemini 3 Pro : 76.2)

- Humanity’s Last Exam : 30.6 (Gemini 3 Pro : 37.7)

En clair : Sur les mathématiques et la programmation complexe, DeepSeek joue désormais dans la même ligue que les modèles américains d’avant-garde.

Une percée technologique : DeepSeek Sparse Attention (DSA)

La force de DeepSeek-V3.2 ne réside pas seulement dans ses performances… mais aussi dans son efficacité. DeepSeek introduit DSA, ou DeepSeek Sparse Attention, une nouvelle architecture qui réduit de moitié les coûts d’inférence sur les documents longs, gère 128 000 tokens de contexte et maintient les performances malgré l’attention parcellaire.

L’astuce ? Un « lightning indexer » qui sélectionne uniquement les parties utiles du contexte, sans traiter l’ensemble du texte.

Un exemple marquant : Lire et analyser un livre de 300 pages (128k tokens) revient à 0,70 dollar / million de tokens, contre 2,40 dollars pour le précédent modèle V3.1-Terminus. Une baisse de 70 % !

Capacité à « penser en utilisant des outils » : un vrai bond en avant

DeepSeek introduit un concept majeur : le raisonnement continu malgré les appels d’outils. Là où d’autres IA « oublient leur chaîne de pensée » à chaque interaction externe (exécution de code, recherche web, manipulation de fichiers), DeepSeek-V3.2 maintient son raisonnement de bout en bout.

Pour entraîner cette compétence, DeepSeek a créé 1 800 environnements de tâches réels, 85 000 instructions multi-étapes et des scénarios mêlant contraintes, calculs, budgets, recherches web et code multilingue

Résultat : une IA qui planifie, vérifie, exécute, corrige, puis termine une tâche… comme un agent autonome cohérent.

Un modèle open source qui déstabilise toute l’industrie

Là où OpenAI, Google ou Anthropic protègent leurs modèles, DeepSeek fait le choix inverse :

- Licence MIT

- Poids complets disponibles

- Scripts compatibles avec l’API OpenAI

- Publication intégrale sur Hugging Face

Autrement dit : Une entreprise peut déployer localement un modèle proche de GPT-5… sans payer d’API propriétaire. Un véritable séisme économique.

Mais, des obstacles persistent : régulations, souveraineté et géopolitique

L’Europe réagit déjà :

- L’Allemagne estime le transfert de données vers la Chine « illégal » et demande à Apple/Google de bloquer l’app.

- L’Italie a ordonné le blocage de DeepSeek en février.

- Les États-Unis interdisent l’application sur les appareils gouvernementaux.

Les préoccupations portent sur l’accès potentiel des autorités chinoises aux données personnelles hébergées par des entreprises de l’écosystème local.

Face aux restrictions américaines sur les GPU Nvidia, DeepSeek met en avant sa compatibilité avec les puces chinoises (Huawei, Cambricon), suggérant que les contrôles à l’export n’empêchent plus la Chine d’avancer.

La question qui fâche : la Chine est-elle désormais au niveau des USA ?

DeepSeek montre trois choses :

- La Chine peut atteindre un niveau frontier sans matériel haut de gamme américain.

- Les modèles open source peuvent concurrencer les modèles propriétaires les plus avancés.

- L’optimisation et les architectures hybrides coûtent moins cher que la puissance brute.

La sortie de DeepSeek-V3.2/3.2-Speciale marque une nouvelle étape dans la compétition USA–Chine :

- L’Amérique garde l’avantage en termes de diffusion commerciale.

- La Chine rattrape son retard sur le raisonnement pur.

- L’open source pourrait redistribuer toutes les cartes.

- L’écosystème hardware chinois devient suffisamment mature pour supporter des modèles géants.

La question n’est plus « La Chine peut-elle rattraper OpenAI ? », mais plutôt : « Comment les acteurs américains maintiendront-ils leur avance quand un rival offre des modèles compétitifs… gratuitement ? ».