Lorsque Google DeepMind a dévoilé Gemma en février dernier, il a publié deux modèles open source contenant respectivement 2 milliards et 7 milliards de paramètres. Lors de la conférence des développeurs Google I/O de cette année, l’entreprise présente sa série Gemma 2, dont le premier membre sera un modèle léger beaucoup plus grand, avec 27 milliards de paramètres.

Toutefois, il ne sera pas disponible immédiatement — il est prévu qu’il arrive en juin.

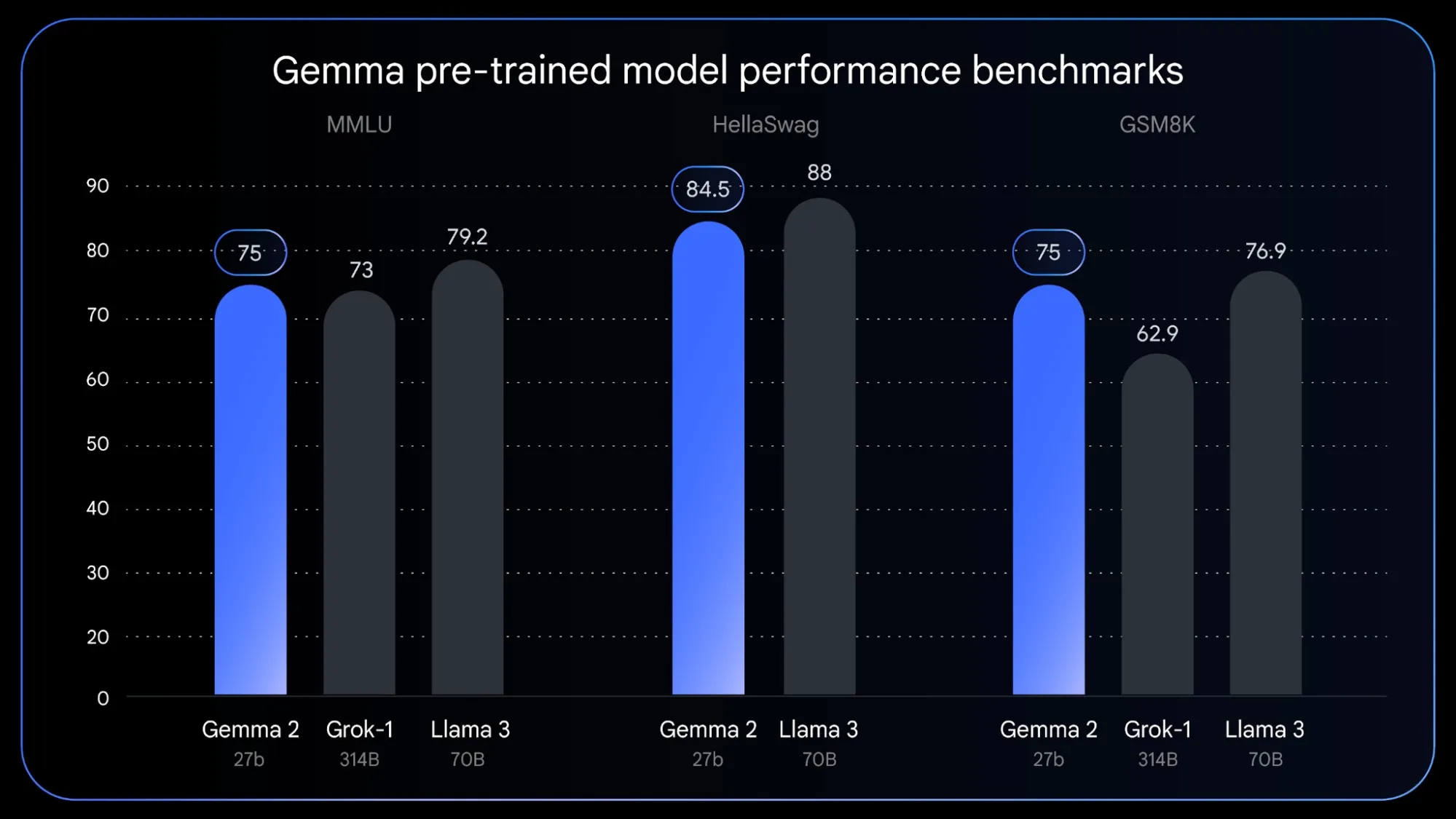

Josh Woodward, vice-président de Google Labs, a expliqué : « Nous avons choisi intentionnellement cette taille de 27 milliards de paramètres ». « Elle est optimisée pour fonctionner sur les GPU Nvidia de nouvelle génération ou sur un hôte TPU unique dans Vertex AI. C’est ce qui le rend facile à utiliser. Et nous constatons déjà une grande qualité. Il surpasse déjà des modèles deux fois plus grands que lui ».

Gemma est la famille de modèles légers de Google pour les développeurs qui cherchent à incorporer l’IA dans leurs applications et appareils sans nécessiter une consommation importante de mémoire ou de puissance de traitement, ce qui permet de l’utiliser sur des appareils à ressources limitées comme les smartphones, les appareils IoT et les ordinateurs personnels.

Depuis son lancement en début d’année, Google a ajouté plusieurs variantes, dont une pour la complétion de code (CodeGemma), une autre pour améliorer l’efficacité de la mémoire (RecurrentGemma), et enfin et plus récemment, un modèle pour la vision-langage (PaliGemma).

Aujourd’hui, avec 27 milliards de paramètres, Gemma 2 promet d’offrir des résultats et des performances plus précis tout en gérant des affectations plus complexes que ses deux prédécesseurs. Le fait de disposer d’un plus grand ensemble de données pour s’entraîner permet à l’IA de fournir des réponses de meilleure qualité en moins de temps.

Gemma 2 est conçu pour fonctionner sur un seul TPU

Si Woodward affirme que Gemma 2 est conçu pour fonctionner sur un seul TPU, il fait référence à la TPUv5e, la dernière génération de puce informatique de Google, qui a été mise sur le marché en août dernier. En d’autres termes, l’utilisation de Gemma 2 nécessite une seule puce d’IA spécialisée pour gérer les calculs, réduire la latence et gérer des tâches telles que la reconnaissance d’images et le traitement du langage naturel. Moins il y a de ressources nécessaires, plus les développeurs économisent pour réinvestir dans leur application.

Le lancement de Gemma 2 a lieu dans l’ombre de l’annonce par OpenAI de GPT-4o, son LLM multimodal, et est présenté comme une « mise à niveau significative » par rapport à l’expérience actuelle des utilisateurs, en particulier ceux qui utilisent la version gratuite de ChatGPT.