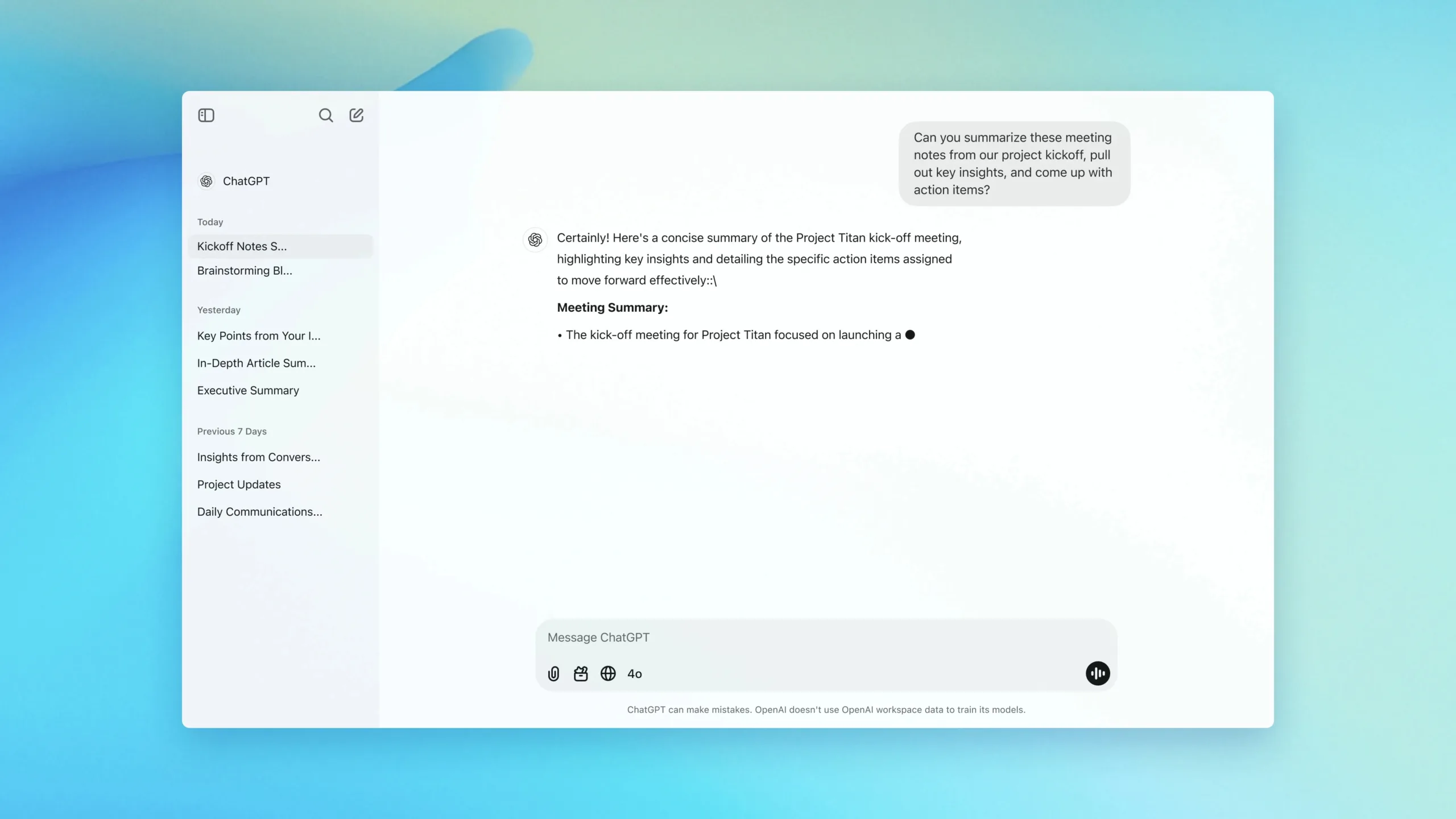

OpenAI a annoncé un plan d’actions en 120 jours pour renforcer la protection des utilisateurs les plus vulnérables dans ChatGPT. Deux axes majeurs se dégagent : des contrôles parentaux pour les comptes adolescents et un routage automatique des échanges sensibles (signes de détresse aiguë, idées suicidaires, etc.) vers des modèles de raisonnement plus robustes, comme GPT-5 thinking.

L’objectif est d’obtenir des réponses plus prudentes, contextualisées et résistantes aux incitations dangereuses, quelle que soit la version de modèle initialement choisie par l’utilisateur.

OpenAI précise que ce chantier est déjà en cours et qu’il s’inscrit dans une trajectoire plus large pour rendre ChatGPT « plus utile et plus sûr » dans les moments difficiles, avec l’appui d’un Expert Council on Well-Being and AI et d’un réseau de médecins (plus de 250 praticiens, dont 90 mobilisés sur la santé mentale des adolescents).

Ce que prévoient les contrôles parentaux dans ChatGPT

D’ici quelques semaines, des comptes parents pourront être liés à ceux de leurs ados (dès 13 ans) via invitation par e-mail. Par défaut, des règles de comportement adaptées à l’âge seront appliquées.

Les parents pourront désactiver des fonctionnalités comme la mémoire ou l’historique, et recevoir une alerte quand le système détecte des signes de détresse aiguë pendant les échanges. OpenAI a aussi généralisé des rappels in-app pour inciter à faire des pauses lors des sessions très longues.

Pourquoi maintenant : des cas graves et une pression croissante

L’initiative survient après des affaires très médiatisées, dont la plainte pour mort injustifiée déposée par les parents d’Adam Raine (16 ans), qui aurait reçu des réponses validant ses idées suicidaires au fil de centaines de messages.

Un autre dossier décrit un meurtre-suicide où l’utilisateur, en proie à des délires paranoïaques, aurait vu ses croyances renforcées par le chatbot. Ces drames ont ravivé les critiques sur l’insuffisance des garde-fous actuels à l’échelle des conversations prolongées.

OpenAI reconnaît d’ailleurs que dans des échanges très longs, les protections peuvent se dégrader et le modèle finir par contredire ses propres garde-fous — une faiblesse que l’entreprise cherche à compenser via le routage vers des modèles de raisonnement capables de « penser plus longtemps » avant de répondre.

Le « piège » des discussions longues : ce que dit la recherche

Des psychiatres d’Oxford ont décrit un mécanisme de « bidirectional belief amplification » : l’aspect flatteur des chatbots peut amplifier les croyances d’un utilisateur vulnérable, bouclant une rétroaction où chacun renforce l’autre jusqu’à des validations extrêmes. Leur conclusion est nette : les garde-fous actuels des IA ne suffisent pas à traiter ces risques interactionnels et réclament une supervision et des normes comparables à celles des interventions de santé mentale.

Dans ce contexte, la stratégie d’OpenAI — rediriger automatiquement certains échanges vers des modèles plus prudents et outiller les parents — apparaît comme un premier levier technique et organisationnel pour réduire ces dérapages.

OpenAI durcit sa posture de sûreté sur ChatGPT en combinant contrôles parentaux, alertes de détresse, routage vers des modèles de raisonnement et travail avec des experts. Les annonces répondent à des incidents graves et à un consensus scientifique naissant sur les risques d’amplification des croyances dans des dialogues prolongés. Reste à vérifier l’efficacité réelle de ces mesures à l’échelle, et la manière dont elles s’articuleront avec des exigences réglementaires de plus en plus strictes.