Il y a des mises à jour qui peaufinent. Et puis il y a celles qui déplacent le produit sur un autre terrain. Avec LM Studio 0.4.0, l’outil fétiche des amateurs de modèles locaux ne se contente plus d’être une belle interface pour discuter avec un LLM sur son GPU : il prend des airs d’infrastructure, pensée pour servir des requêtes en parallèle, s’intégrer à des workflows, et même tourner « headless » sur un serveur.

Un virage clair : de l’appli de bureau à la brique de déploiement

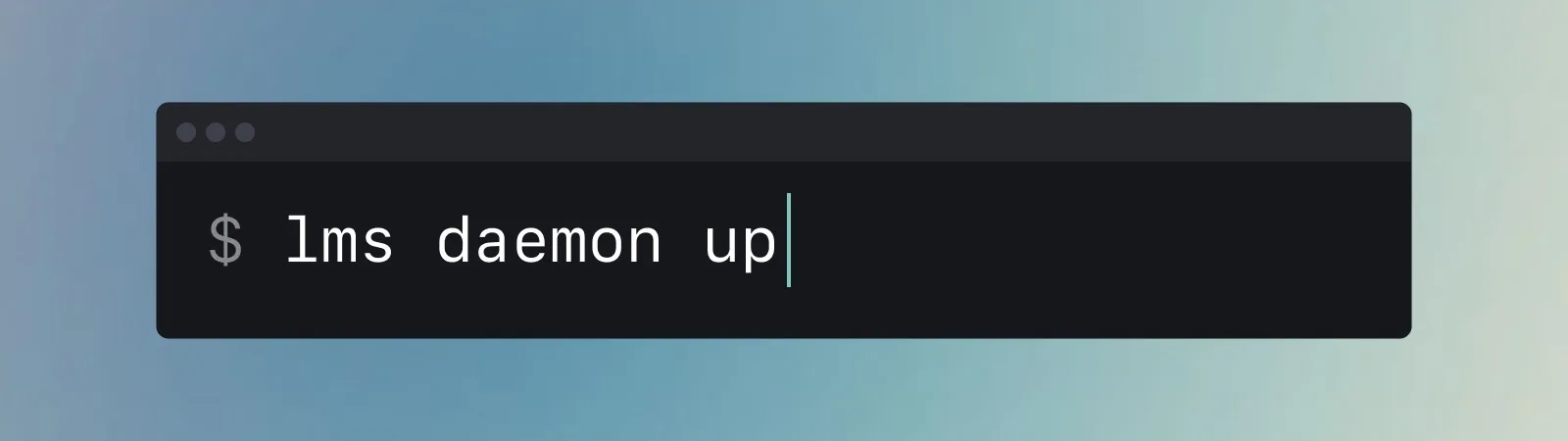

La nouveauté la plus structurante s’appelle llmster : le « cœur » de LM Studio, désormais empaqueté pour fonctionner sans interface graphique, en mode daemon, et se déployer sur une machine Linux, une instance cloud,… voire un Colab. L’équipe explique avoir séparé l’UI de la couche moteur pour rendre ce scénario possible.

Traduction concrète : LM Studio ne vise plus seulement l’utilisateur qui veut lancer un modèle en local « comme ChatGPT », mais aussi le développeur — ou l’équipe — qui veut héberger son propre endpoint et brancher des applications dessus.

Des performances pensées « serveur » : requêtes parallèles et batching continu

LM Studio 0.4.0 introduit la gestion de requêtes concurrentes vers un même modèle via du continuous batching, une approche qui vise le débit et l’efficacité quand plusieurs demandes arrivent en même temps.

Point technique important : LM Studio indique que son moteur llama.cpp « passe » en version 2.0.0, ce qui accompagne l’arrivée de cette concurrence côté inference (avec des réglages comme le nombre maximum de prédictions simultanées et une gestion unifiée du KV cache).

Une API plus « pro » : stateful chat, contrôle d’accès, et endpoints natifs

Autre brique : une API REST native v1 (sur /api/v1/*) et un endpoint de chat étatique permettant d’enchaîner une conversation via des identifiants (response_id, previous_response_id) — pratique pour des workflows multi-étapes sans renvoyer tout le contexte à chaque appel.

LM Studio ajoute aussi une logique de clés de permission (contrôle des clients autorisés) et met en avant le support d’usages outillés (notamment via MCP, selon la documentation).

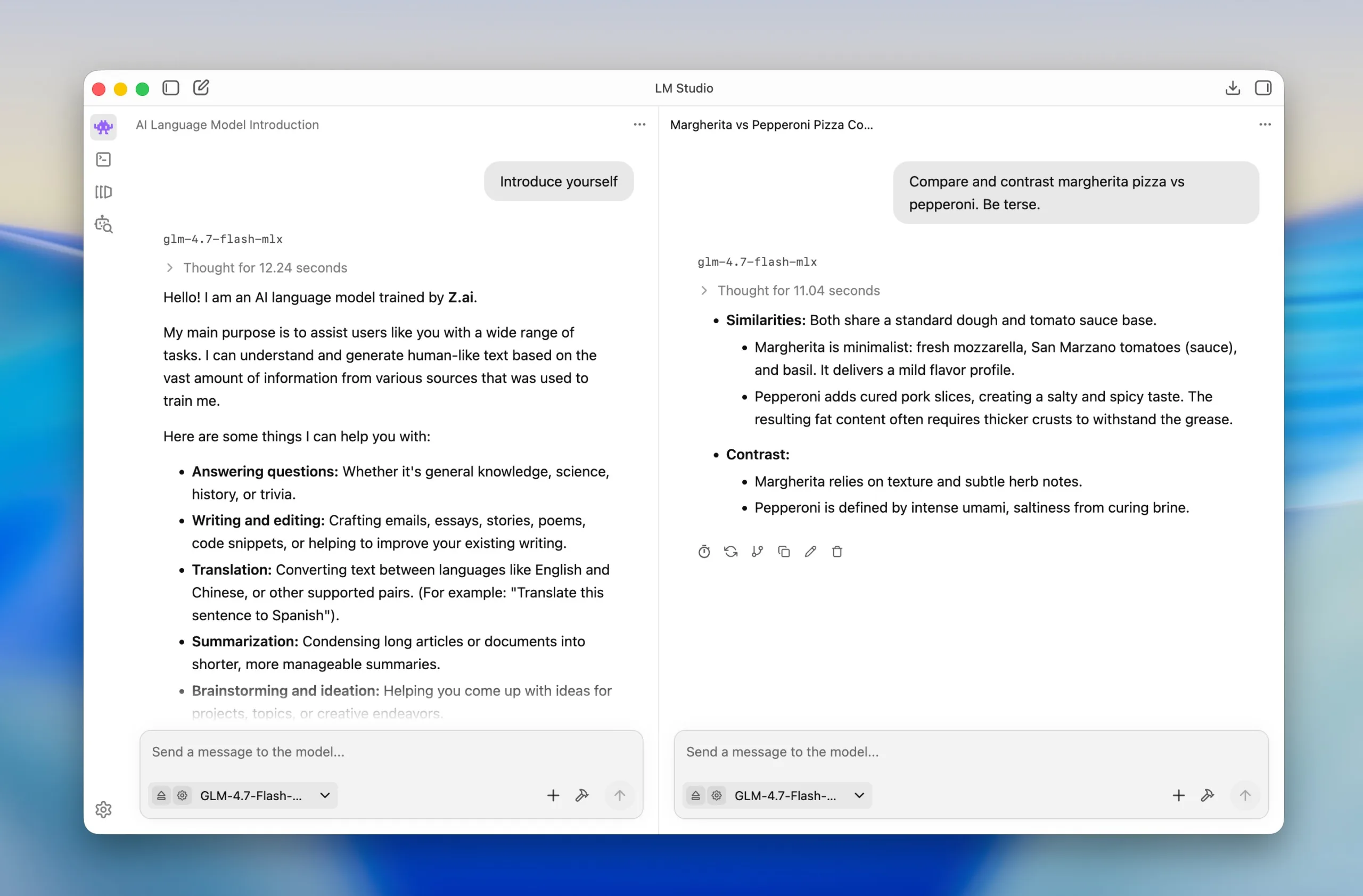

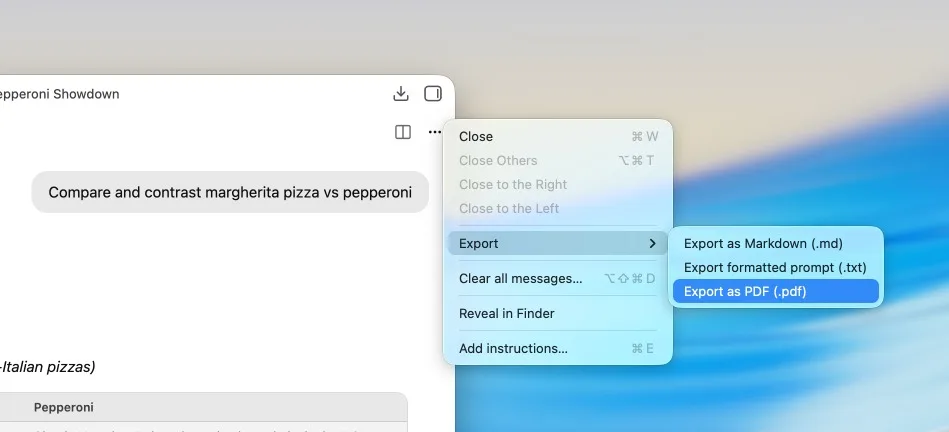

L’expérience utilisateur n’est pas oubliée : UI refondue, export, split view

Ce pivot « infra » aurait pu sacrifier le confort. Au contraire, l’application reçoit une refonte UI et des fonctions qui parlent à tous ceux qui travaillent vraiment avec un LLM au quotidien :

- export des conversations en PDF, Markdown ou texte

- Split View pour ouvrir plusieurs chats côte à côte (utile pour comparer des prompts ou travailler en parallèle)

- Developer Mode et documentation intégrée pour rendre l’outillage plus lisible

- et un nouveau flux CLI, avec lms chat, pour discuter directement depuis le terminal

Pourquoi cette mise à jour compte (vraiment) ?

Derrière la liste de features, LM Studio 0.4.0 illustre un mouvement de fond : la normalisation de l’IA locale comme alternative crédible au cloud, non seulement pour la confidentialité, mais pour l’intégration produit.

Pour les développeurs et responsables produits, c’est un pas de plus vers un « stack » local où le modèle devient un service, consommable comme une API. Pour les équipes, c’est un signal : LM Studio veut être plus qu’un client de chat — un composant que l’on peut mettre en CI, automatiser, sécuriser, monitorer. Enfin, pour l’écosystème, c’est aussi une réponse à la montée des workflows agentiques : l’intérêt n’est plus seulement « parler au modèle », mais orchestrer des appels, en parallèle, et brancher le tout à des outils.

En clair : LM Studio se rapproche d’un territoire historiquement occupé par des solutions plus « dev-first ». Et, il le fait sans renier ce qui a fait son succès : une couche d’interface simple, presque grand public, pour dompter des modèles parfois tout sauf simples.