Microsoft ne se contente plus d’héberger l’IA : il veut désormais la façonner, du silicium jusqu’au service. Avec Maia 200, son nouvel accélérateur IA gravé en 3 nm, le géant de Redmond assume une ambition claire : reprendre la main sur le coût, la disponibilité et la performance de l’inférence — et envoyer un message direct à Amazon et Google.

Un tournant : Microsoft ose la comparaison frontale

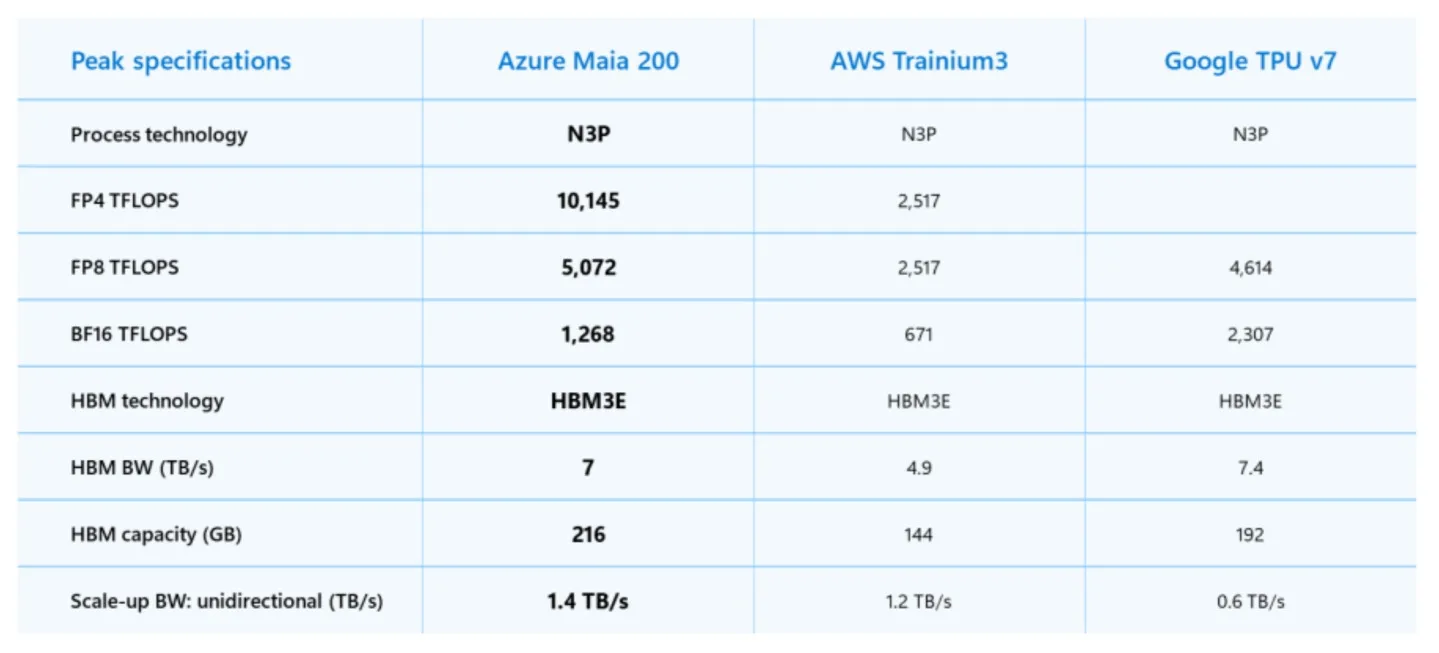

Jusqu’ici, Microsoft avançait prudemment avec Maia 100. Cette fois, le ton change. Maia 200 est présenté comme un accélérateur capable d’offrir 3x la performance FP4 de la 3e génération d’AWS Trainium, et une performance FP8 supérieure à la TPU v7 de Google.

Ce positionnement n’a rien d’anodin : dans la guerre du cloud, les comparaisons publiques sont une forme de diplomatie… et de dissuasion.

Sur le papier, Maia 200 coche toutes les cases d’un accélérateur pensé pour l’ère des grands modèles :

- Gravure TSMC 3 nm et plus de 100 milliards de transistors (certains médias évoquent même ~140 milliards).

- Un sous-système mémoire très musclé : 216 Go de HBM3e et ~7 TB/s de bande passante, épaulé par 272 Mo de SRAM embarquée.

- Un objectif assumé : « dramatically improve the economics of AI token generation », autrement dit, rendre l’inférence moins chère à grande échelle.

La promesse la plus stratégique est peut-être ailleurs : Microsoft affirme obtenir ~30 % de performance par dollar en plus que la génération la plus récente de son parc.

Dans un monde où l’IA se facture à la requête (et où chaque token compte), ce genre de ratio devient une arme commerciale.

L’infrastructure avant tout : l’anti-NVIDIA (sans le dire)

L’autre signal fort, c’est la philosophie système. Là où NVIDIA impose souvent un modèle très intégré autour de ses interconnexions et racks, Microsoft met en avant une approche reposant davantage sur Ethernet et une architecture de réseau « scale-up » maison.

Ce choix raconte une chose : Microsoft veut optimiser son cloud pour ses charges de travail — sans dépendre entièrement du calendrier (ni des marges) d’un fournisseur unique.

Déploiement : d’abord interne, mais avec une porte ouverte aux développeurs

Maia 200 démarre là où ça compte : dans les datacenters Azure, avec une première disponibilité annoncée en Azure US Central, et d’autres régions à suivre.

Microsoft indique aussi que ses équipes « Superintelligence » seront les premières servies — et que Maia 200 doit notamment héberger les modèles GPT-5.2 d’OpenAI au sein de son écosystème.

Enfin, Microsoft évoque un aperçu du SDK Maia 200 pour les développeurs et le monde académique : une manière de créer un minimum d’écosystème, là où NVIDIA règne précisément grâce à CUDA et à son inertie industrielle.

La guerre du cloud se joue désormais au niveau des puces

Ce lancement arrive dans un moment très particulier : Amazon renforce aussi son stack avec Trainium, allant jusqu’à intégrer des technologies NVIDIA (NVLink Fusion) pour muscler l’interconnexion à l’échelle des « AI factories ».

Et, Google pousse TPU v7 (Ironwood) comme une brique d’inférence taillée pour les « reasoning models » à très grande échelle.

Traduction : la compétition ne porte plus seulement sur « qui a le meilleur modèle », mais sur qui contrôle le coût total d’exploitation — du silicium à l’ordonnancement, de la mémoire aux interconnexions, jusqu’au service facturé au client. Maia 200, c’est Microsoft qui tente de verrouiller cette chaîne.

Et si la promesse tient (performance, rendement, disponibilité, software), l’enjeu dépasse la fiche technique : c’est une tentative de faire d’Azure un endroit où l’IA est plus rentable — pas seulement « possible ».