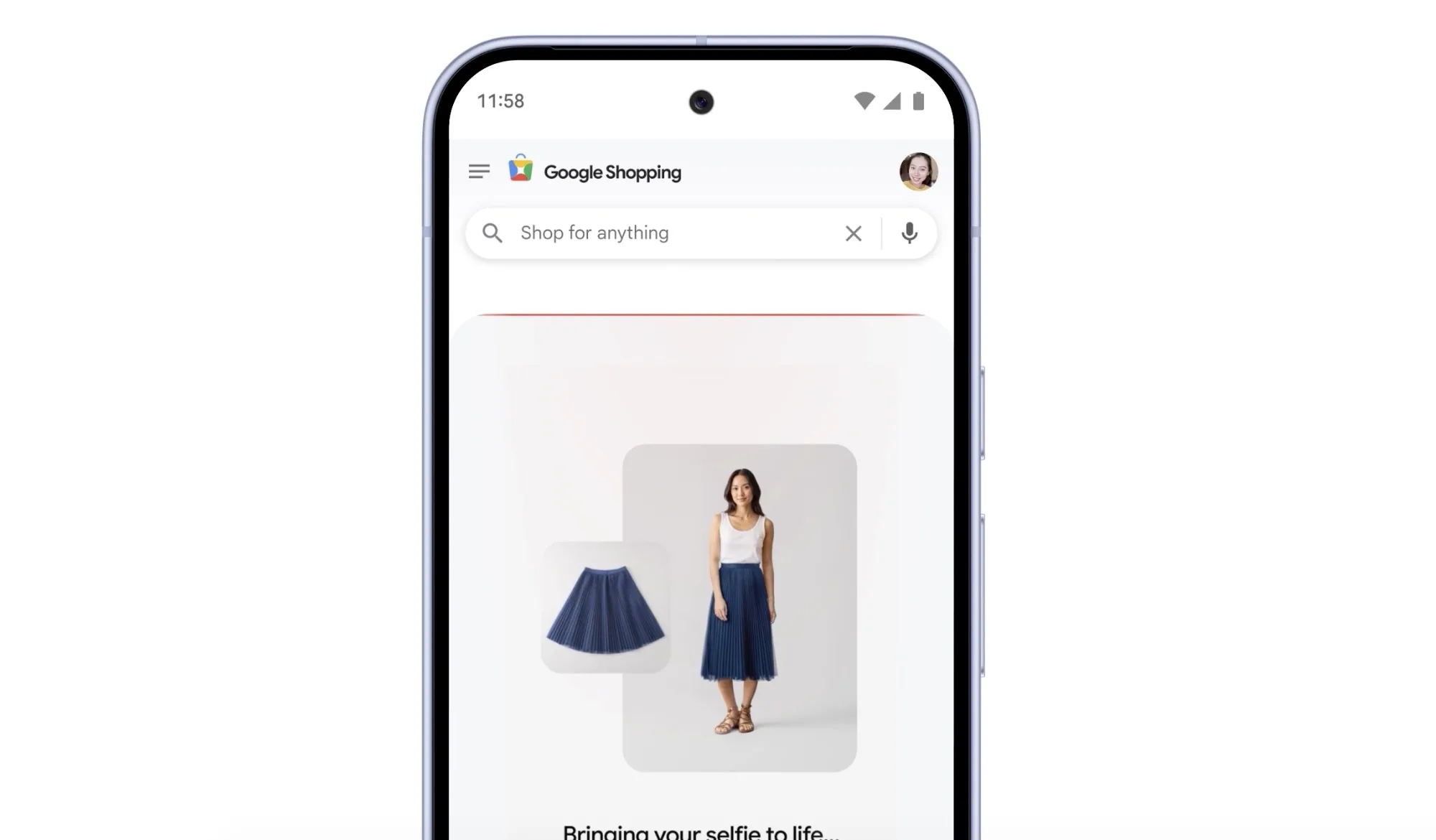

Google continue d’affiner son approche du shopping assisté par intelligence artificielle. La firme de Mountain View déploie une mise à jour majeure de son outil d’essayage virtuel, avec une promesse forte : il n’est désormais plus nécessaire de fournir une photo en pied.

Grâce à Nano Banana, un nouveau modèle issu de la suite Gemini 2.5 Flash Image, Google est capable de transformer un simple selfie en avatar numérique en pied, utilisable directement dans Google Search et Google Shopping.

Un avatar complet généré à partir d’un selfie

Le fonctionnement se veut volontairement simple. L’utilisateur importe une photo de son visage, sélectionne sa taille habituelle, et l’IA se charge du reste. Nano Banana génère alors plusieurs avatars en pied, reconstruisant le corps à partir du visage tout en conservant des proportions cohérentes.

L’utilisateur choisit l’avatar qui lui ressemble le plus, puis peut l’utiliser pour essayer virtuellement : chemises, vestes, robes, et autres vêtements disponibles via Google Shopping.

L’ensemble repose sur une génération personnalisée, et non sur des silhouettes génériques ou des morphologies préconfigurées.

Un gain de temps… et de réalisme

Jusqu’ici, l’outil d’essayage de Google exigeait une photo complète, souvent difficile à trouver ou à capturer correctement. Cette nouvelle approche supprime une étape contraignante et rend la fonctionnalité beaucoup plus accessible.

Surtout, Google insiste sur un point clé : l’avatar n’est pas basé sur un corps standardisé. Le modèle analyse le selfie pour produire une silhouette individualisée, offrant une meilleure perception du rendu des vêtements, tant en matière de coupe que de style.

À terme, cette évolution pourrait réduire les hésitations avant l’achat, les erreurs de taille, et les retours produits, un point sensible du commerce en ligne.

Un shopping plus immersif et plus confiant

Avec cette mise à jour, Google cherche clairement à rendre l’achat de vêtements en ligne plus fluide et plus rassurant. En visualisant le rendu sur un avatar personnel, l’acheteur peut se projeter plus facilement et prendre sa décision plus rapidement.

L’essayage virtuel devient ainsi un outil d’aide à la décision plutôt qu’un simple gadget visuel. Pour les consommateurs réguliers de prêt-à-porter en ligne, cela pourrait signifier moins de frustration et un parcours d’achat raccourci.

Déploiement progressif, sans installation requise

Pour le moment, la fonctionnalité est en cours de déploiement aux États-Unis. Bonne nouvelle : elle est intégrée directement à Google Search et Google Shopping. Aucun téléchargement ni inscription supplémentaire n’est nécessaire pour en profiter.

Google n’a pas encore communiqué de calendrier précis pour un lancement international, mais l’historique de ses déploiements suggère une extension progressive à d’autres marchés.

Et après ? Vers des avatars encore plus réalistes

À plus long terme, Google pourrait aller plus loin. Des améliorations du modèle Nano Banana sont déjà envisagées, avec des avatars encore plus réalistes, des essayages en 3D, et une intégration renforcée avec des applications comme Doppl, dédiée au stylisme et aux idées de tenues.

Reste une zone d’ombre : la capacité de l’IA à estimer la morphologie complète d’une personne à partir de son visage seul. Une approche qui peut susciter un certain scepticisme. Mais même imparfaite, cette technologie pourrait déjà suffire à affiner le choix des tailles et à accélérer le passage en caisse.