L’intelligence artificielle vient de franchir une étape historique dans le domaine de la cybersécurité. Pour la première fois, un modèle d’IA a découvert une faille critique dans le noyau Linux, cœur névralgique de millions de serveurs à travers le monde.

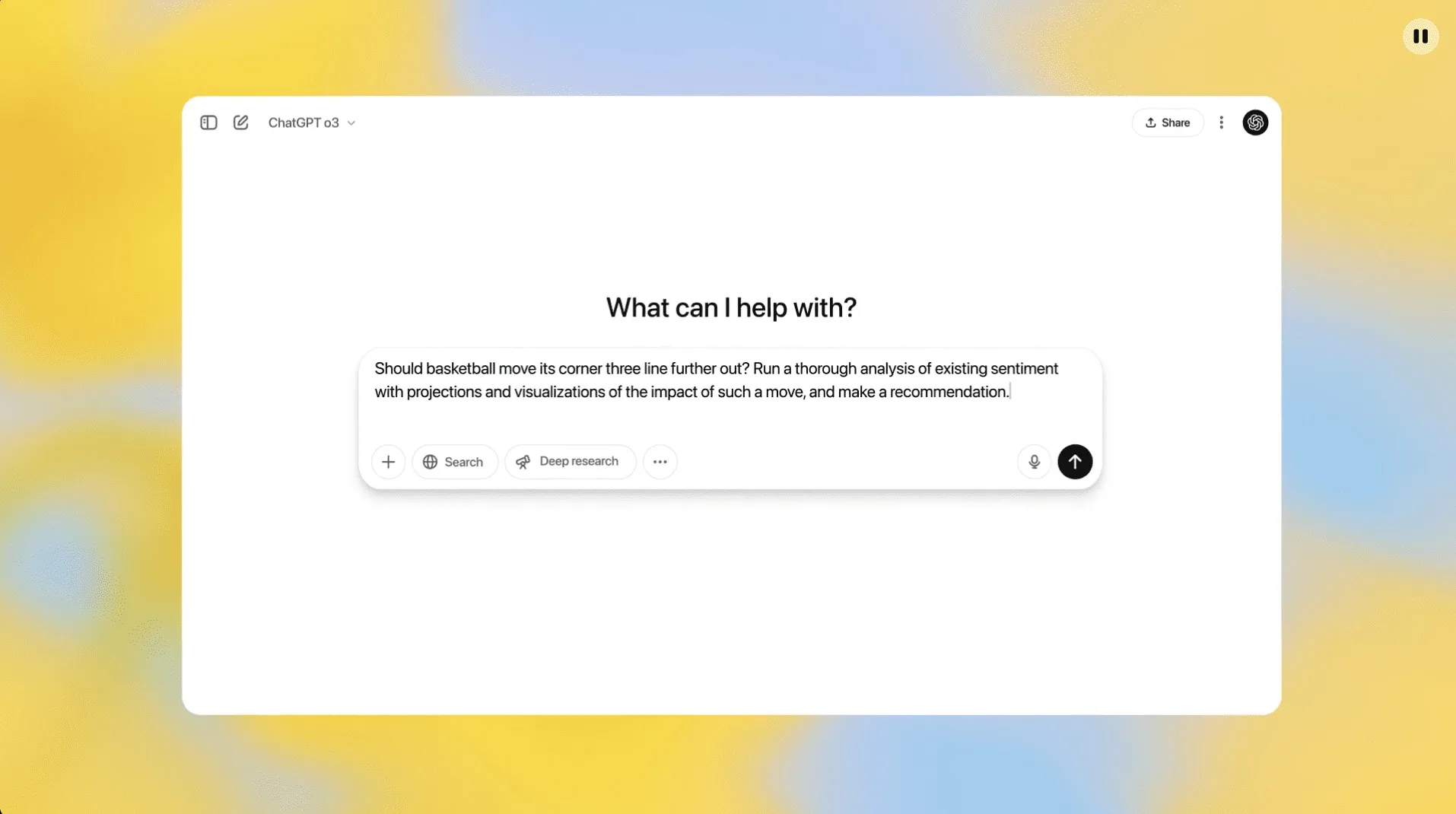

Cette prouesse est signée par le modèle o3 d’OpenAI, le nouveau modèle de raisonnement avancé qui alimente la dernière version de ChatGPT.

CVE-2025-37899 : une faille critique découverte par une IA

Le chercheur en sécurité Sean Heelan a publié un article de blog détaillant cette découverte inédite. En auditant le module ksmbd — qui permet le partage de fichiers via le protocole SMB3 dans le noyau Linux — il a utilisé le modèle o3 via l’API d’OpenAI, sans autre outil ni plugin. Résultat : l’IA a identifié une faille de type use-after-free dans le gestionnaire de la commande SMB logoff.

Cette vulnérabilité critique, aujourd’hui référencée sous le CVE-2025-37899, implique la libération prématurée d’un objet encore accessible par un autre thread, ce qui pourrait permettre une exécution de code arbitraire ou un crash du système.

Un audit de 12 000 lignes de code en une session

Le modèle o3 a traité près de 12 000 lignes de code SMB dans ksmbd, ce qui représente environ 100 000 tokens. L’IA a non seulement compris la logique de traitement des connexions concurrentes, mais elle a aussi repéré un comportement non sécurisé à l’échelle du thread, que de nombreux audits humains n’avaient pas relevé auparavant.

Une fois la faille signalée, un correctif a été rapidement validé et fusionné dans le dépôt officiel du noyau Linux sur GitHub. Cela marque un tournant historique :

- une IA découvre un bug dans un système critique,

- un humain le valide,

- un correctif est publié,

- et la faille est officiellement colmatée.

Claude vs OpenAI o3 : duel d’IA en cybersécurité

Sean Heelan testait en parallèle plusieurs modèles d’IA sur une autre vulnérabilité (CVE-2025-37778), liée à l’authentification Kerberos :

- OpenAI o3 a identifié la faille dans 8 exécutions sur 100 ;

- Claude 3.7 Sonnet dans 3 cas sur 100 ;

- Claude 3.5 Sonnet n’a rien trouvé en 100 tentatives.

Le verdict est clair : le modèle o3 d’OpenAI affiche une avance technique notable sur la compréhension des grands ensembles de code et des vulnérabilités logiques complexes.

Un outil précieux pour l’audit de code et la sécurité

Bien que Sean Heelan insiste sur le fait que l’IA n’est pas infaillible, il admet que ces modèles peuvent aujourd’hui accélérer considérablement l’identification de failles sur des projets inférieurs à 10 000 lignes de code. Pour les chercheurs en sécurité, l’IA devient un multiplicateur d’efficacité, à la fois pour le pentesting, les audits de sécurité et la recherche proactive de bugs.

Avec cette découverte, OpenAI o3 entre dans l’histoire comme le premier modèle à détecter une faille zero-day dans le noyau Linux. Ce n’est plus de la science-fiction : l’intelligence artificielle devient un outil de cybersécurité à part entière, capable de repérer des failles complexes que seuls les meilleurs experts humains pouvaient jusqu’ici identifier.

La cybersécurité entre dans une nouvelle ère, où l’humain et l’IA collaborent pour sécuriser les fondations de l’informatique moderne.