Pendant un an, les entreprises ont empilé des copilotes, des scripts, des connecteurs et des « agents » comme on ajoute des extensions à un navigateur trop lent. Ça marche… jusqu’au moment où ça ne marche plus : outils fragmentés, contextes incohérents, permissions floues, et une vérité brutale — manager des agents IA, c’est déjà un métier.

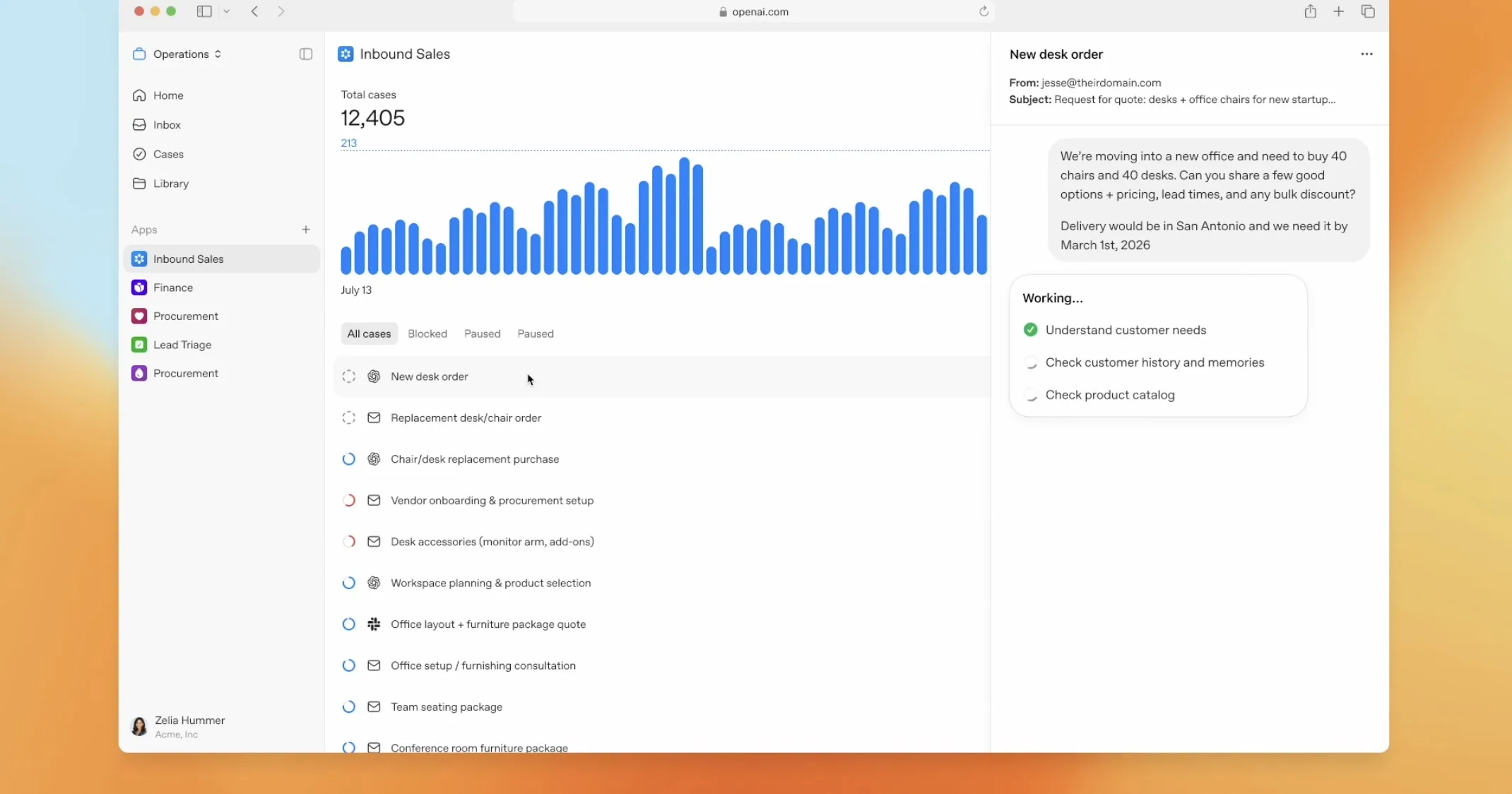

C’est précisément ce terrain qu’OpenAI attaque avec OpenAI Frontier, une nouvelle plateforme conçue pour « build, deploy, and manage » des agents — y compris des agents qui ne viennent pas d’OpenAI.

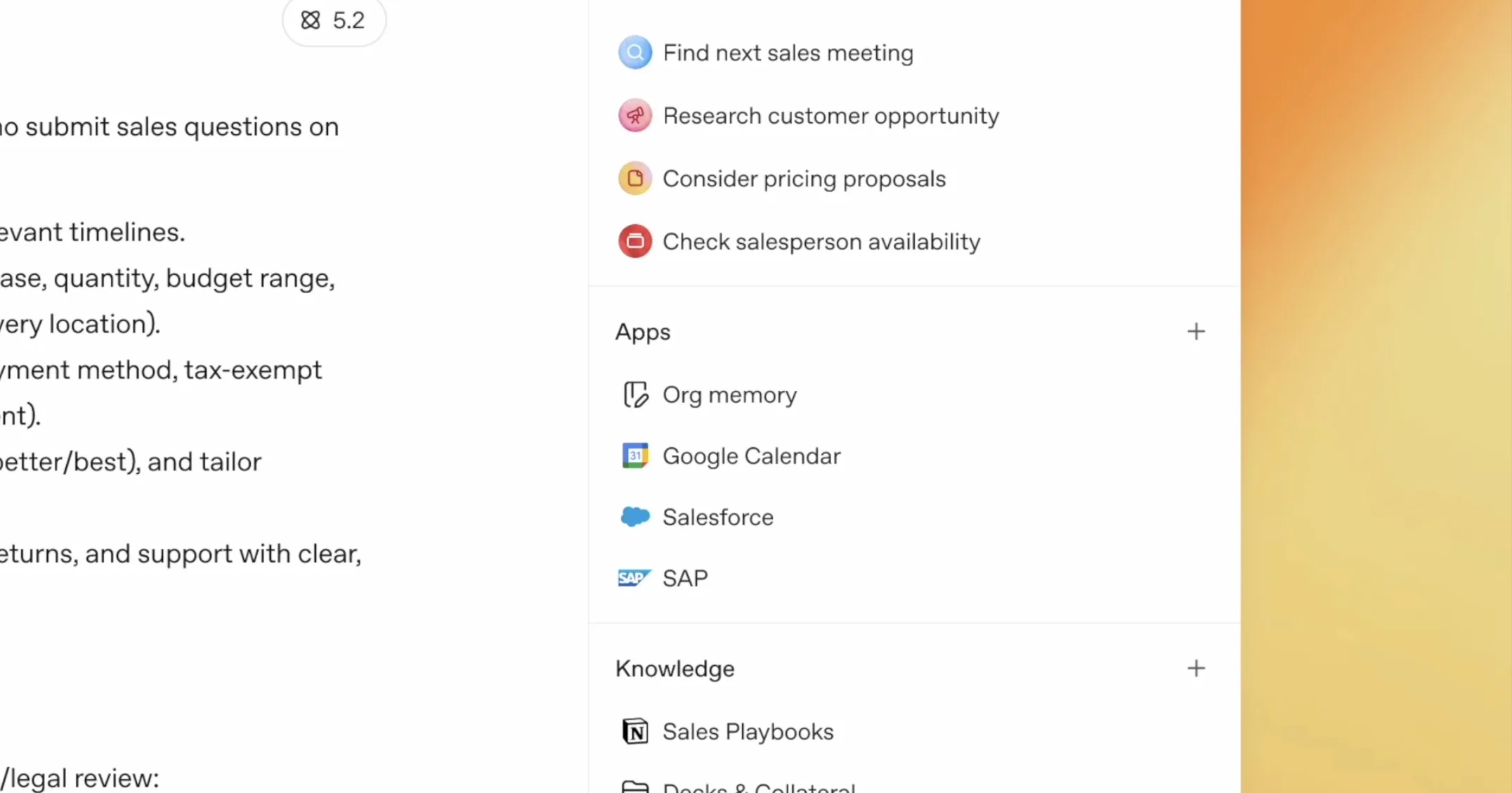

Une couche de gouvernance et d’opérations qui ressemble, dans son discours comme dans sa logique, à un service RH : onboarding, apprentissage guidé, feedback, règles, limites.

OpenAI Frontier, ou la promesse d’un « contexte commun » pour des flottes d’agents

Le cœur du produit, tel que OpenAI le décrit, c’est un « contexte commercial partagé » : un socle commun sur lequel les agents peuvent travailler sans réinventer à chaque tâche les mêmes règles, les mêmes outils et les mêmes contraintes internes. L’objectif est de sortir du modèle actuel où les agents « vivent » au-dessus d’outils existants (CRM, tickets, dépôts Git, docs…), mais de façon souvent en silot et fragile.

OpenAI résume l’idée avec une formule très « entreprise » : donner aux agents « les mêmes compétences dont les humains ont besoin pour réussir au travail » — contexte partagé, onboarding, apprentissage via feedback, et permissions explicites.

OpenAI Frontier est officiellement annoncé comme disponible dès maintenant, pour un nombre restreint de clients, avec une ouverture plus large « au cours des prochains mois ». OpenAI cite déjà des noms (Intuit, State Farm, Thermo Fisher, Uber) parmi les premiers adoptants, mais ne donne pas de prix pour l’instant.

Pourquoi OpenAI fait ça maintenant : l’ère des agents est devenue une bataille de plateformes

OpenAI Frontier n’arrive pas dans un vide. Microsoft pousse déjà une vision d’administration et de contrôle des agents via Agent 365, orientée supervision IT, politiques et gestion des risques.

Et, Anthropic, de son côté, a électrisé le marché avec Claude Code/Cowork et l’idée d’agents de plus en plus autonomes, au point d’alimenter une nervosité boursière sur le logiciel « traditionnel ».

Dans ce contexte, OpenAI Frontier ressemble à une réponse directe : si les agents deviennent une « main-d’œuvre », il faudra un système d’exploitation organisationnel pour les encadrer.

Un produit de gouvernance déguisé en produit de productivité

Le discours « HR pour agents » est malin, mais la valeur réelle est ailleurs : la gouvernance. Qui a le droit de faire quoi (permissions, limites, environnements sensibles) ? Quelle mémoire est autorisée (ce que l’agent « retient », où, et pendant combien de temps) ? Comment on audite (évaluations humaines, traçabilité, conformité) ? Comment on évite le patchwork (agents disparates, comportements non alignés, dette d’automatisation) ?

OpenAI vend l’idée d’une entreprise où « la plupart du travail numérique » serait dirigé par des humains et exécuté par des flottes d’agents d’ici la fin de l’année. C’est ambitieux — et, surtout, ça suppose un point que beaucoup découvrent tard : l’agent n’est pas le produit final, l’orchestration l’est.

Le risque : « un seul anneau »… et la tentation de la centralisation

OpenAI Frontier se présente comme ouvert (standards, agents tiers), et OpenAI insiste sur le fait qu’elle « ne construira pas tout elle-même ». Mais, la mécanique est connue : celui qui possède la plateforme qui gouverne les agents contrôle la couche la plus stratégique — le pilotage.

Pour les entreprises, l’arbitrage est clair :

- Oui à une couche commune qui réduit la fragmentation.

- Mais attention à la dépendance : si Frontier devient le cockpit de vos opérations agentiques, votre « lock-in » ne se joue plus au niveau du modèle, mais au niveau du système de travail.

OpenAI Frontier n’est pas juste un nouveau produit OpenAI. C’est une tentative de définir le futur poste le plus discret — et le plus puissant — de l’IA en entreprise : le manager d’agents.