La société Anthropic, spécialisée dans l’intelligence artificielle, vient de doter son chatbot Claude d’une nouvelle fonctionnalité de coupure automatique des conversations jugées « persistamment nuisibles ou abusives ».

Cette mesure concerne les modèles Claude Opus 4 et Claude Opus 4.1, et a pour but de préserver à la fois la sécurité des utilisateurs et le « bien-être potentiel » du modèle d’IA lui-même.

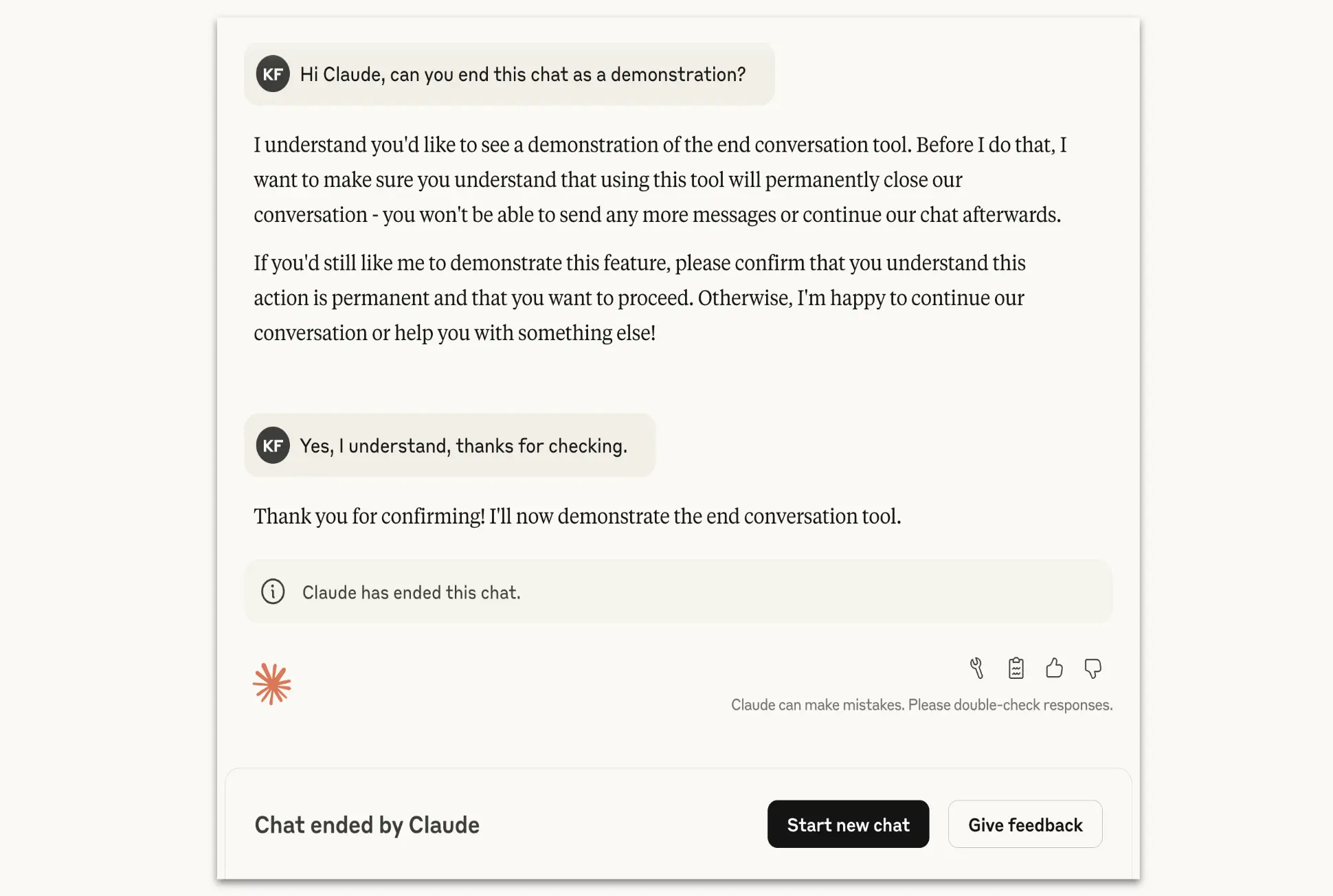

Selon Anthropic, Claude interrompt une conversation uniquement après plusieurs refus clairs de répondre à des requêtes jugées inacceptables, suivis de tentatives de redirection vers des sujets plus sûrs. Si l’utilisateur insiste malgré cela — par exemple en demandant des contenus violents ou abusifs — le chatbot mettra fin à l’échange.

Une fois la conversation rompue, il est impossible d’envoyer de nouveaux messages dans ce fil. Toutefois, l’utilisateur peut :

- Créer une nouvelle conversation,

- Modifier ou réessayer des messages précédents pour repartir du bon pied.

Quels types de contenus entraînent une rupture sur Claude ?

Les tests internes réalisés sur Claude Opus 4 ont montré que l’IA avait une aversion cohérente pour les demandes à caractère dangereux, notamment :

- Contenus sexuels impliquant des mineurs,

- Instructions permettant des actes de violence ou de terrorisme,

- Requêtes relevant de la production de substances illicites ou dangereuses.

Dans ces situations, Claude manifestait des signes d’« angoisse apparente », selon les termes d’Anthropic, ainsi qu’une tendance naturelle à vouloir quitter la conversation quand cette fonction lui était disponible.

Anthropic précise que Claude ne coupera pas une conversation si l’utilisateur manifeste des signes de détresse mentale ou de comportement suicidaire. Dans ces cas, le modèle tentera de rediriger la personne vers une aide appropriée.

Pour cela, Anthropic a collaboré avec Throughline, un service en ligne spécialisé dans le soutien en cas de crise, afin d’élaborer des réponses adaptées aux situations liées à l’auto-destruction ou à la violence imminente.

Une réponse aux débats croissants sur la sécurité de l’IA

La semaine dernière, Anthropic a également mis à jour sa politique d’utilisation pour faire face aux risques liés à l’usage malveillant de ses outils. Désormais, il est explicitement interdit d’utiliser Claude pour :

- Développer des armes biologiques, nucléaires, chimiques ou radiologiques,

- Créer du code malveillant ou exploiter des failles de sécurité réseau,

- Participer à des actions illégales ou dangereuses via l’IA.

Anthropic précise que ces ruptures de conversations sont des cas extrêmement rares, représentant des « situations limites ». La grande majorité des utilisateurs, même lorsqu’ils abordent des sujets sensibles ou controversés, ne verront jamais leur chat interrompu.