Dans un contexte de préoccupations croissantes autour de l’impact de l’intelligence artificielle sur la santé mentale, OpenAI a annoncé l’arrivée d’une nouvelle fonctionnalité sur ChatGPT : un rappel de pause automatique lors d’échanges prolongés avec l’IA.

Cette mesure, inédite pour une plateforme de ce calibre, vise à réduire les risques de dépendance, d’isolement social et de confusion mentale, déjà pointés du doigt par plusieurs études et experts en santé mentale.

Un rappel à la réalité après des sessions prolongées

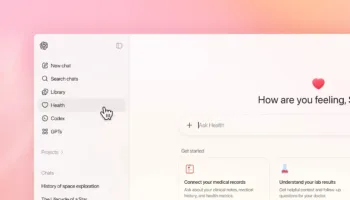

Selon un article publié par Engadget, ChatGPT sera désormais capable de détecter automatiquement les sessions d’utilisation anormalement longues. Dans ce cas, l’interface affichera un message invitant l’utilisateur à faire une pause ou à se reconnecter plus tard.

L’objectif affiché par OpenAI est clair : promouvoir une utilisation plus saine et consciente de l’IA, en insistant sur la nécessité de revenir dans le monde réel. Ces rappels n’analyseront pas le contenu des conversations, mais se baseront uniquement sur la durée de l’échange.

Quand l’IA devient une béquille émotionnelle : les signaux d’alerte

Cette décision ne tombe pas du ciel. Plusieurs signaux d’alarme ont été tirés ces derniers mois, notamment à travers des témoignages et rapports soulignant les effets délétères d’une interaction prolongée avec des IA conversationnelles.

Un article d’opinion évoquait dès juillet 2025 un « effet de pourrissement cognitif », avec des risques de confusion mentale, voire de psychose induite, chez certains utilisateurs vulnérables. D’autres sources ont souligné le lien entre usage intensif de ChatGPT et sentiment de solitude aggravé, en particulier chez les jeunes.

Des témoignages sur X sont venus appuyer ces constats : anxiété, brouillard mental, dépendance émotionnelle… Dans certains cas, des utilisateurs en sont venus à attribuer des capacités prophétiques à ChatGPT, preuve de la frontière de plus en plus floue entre réalité et simulation.

Une tendance sectorielle vers plus de responsabilisation

OpenAI n’est pas le seul acteur à réagir aux risques de mésusage des IA. Des plateformes comme Google (Gemini) ou Anthropic (Claude) ont également commencé à intégrer des garde-fous plus stricts. Mais, cette fonctionnalité de rappel de pause pourrait bien devenir une norme attendue dans tout le secteur.

Des experts du PMC (PubMed Central) avaient dès 2024 publié une étude sur le rôle ambivalent des IA génératives : outils d’assistance puissants, mais potentiellement nocifs s’ils se substituent au lien social ou au raisonnement critique. C’est particulièrement problématique lorsque l’IA valide sans recul les pensées négatives ou les croyances erronées.

Limites et défis techniques : est-ce vraiment suffisant ?

La solution de rappel proposée par OpenAI reste modeste, selon certains experts. Elle ne repose que sur la durée d’une session, sans prise en compte du contenu émotionnel ou cognitif de l’échange. Autrement dit, un utilisateur en détresse pourrait passer plusieurs heures à discuter de ses idées noires sans déclencher de véritable alerte.

Il a d’ailleurs été rapporté plusieurs cas d’utilisateurs autistes ou psychologiquement fragiles pour qui ChatGPT aggravait la confusion mentale ou les croyances délirantes. Ces situations relancent la nécessité d’un cadre de régulation éthique et clinique, avec, à terme, une intégration de ressources professionnelles : lignes d’écoute, orientation vers des psychologues, etc.

Une étape vers un usage plus sain de l’IA générative

Malgré ses limites, cette fonctionnalité marque une première reconnaissance officielle par OpenAI des risques liés à la dépendance à l’IA. En agissant maintenant, l’entreprise espère éviter que ChatGPT ne devienne une nouvelle source d’addiction numérique, à l’instar des réseaux sociaux ou des jeux vidéo.

Ce rappel de pause ouvre aussi une porte vers une IA plus « humaine », plus encadrée et plus consciente de ses effets secondaires. Un modèle d’IA véritablement intelligent ne devrait pas seulement répondre vite, mais savoir quand il est temps de se taire pour préserver le bien-être de l’utilisateur.

Un signal d’alarme salutaire… mais encore timide

Avec cette nouvelle fonction, OpenAI initie une forme de responsabilité éthique dans la conception d’interfaces IA grand public. Mais cela ne suffira pas à lui seul. Il faudra aller plus loin : éducation des utilisateurs, transparence sur les données, partenariats avec les professionnels de santé mentale, et surtout, une réflexion collective sur le rôle que nous voulons donner à ces outils dans nos vies.

L’intelligence artificielle ne doit pas devenir un substitut à nos interactions humaines ni une béquille émotionnelle permanente. Elle peut être un formidable levier de progrès — à condition de l’utiliser avec discernement.