OpenAI, le créateur de ChatGPT, a été contraint de faire machine arrière en urgence ce vendredi, après une vague d’indignation sur les réseaux sociaux. En cause : une fonctionnalité expérimentale qui rendait certaines conversations ChatGPT accessibles depuis les moteurs de recherche, notamment Google.

Une décision qui, malgré les bonnes intentions initiales, a très vite tourné au cauchemar en matière de confidentialité.

Une fonctionnalité « expérimentale » qui expose des milliers d’échanges privés

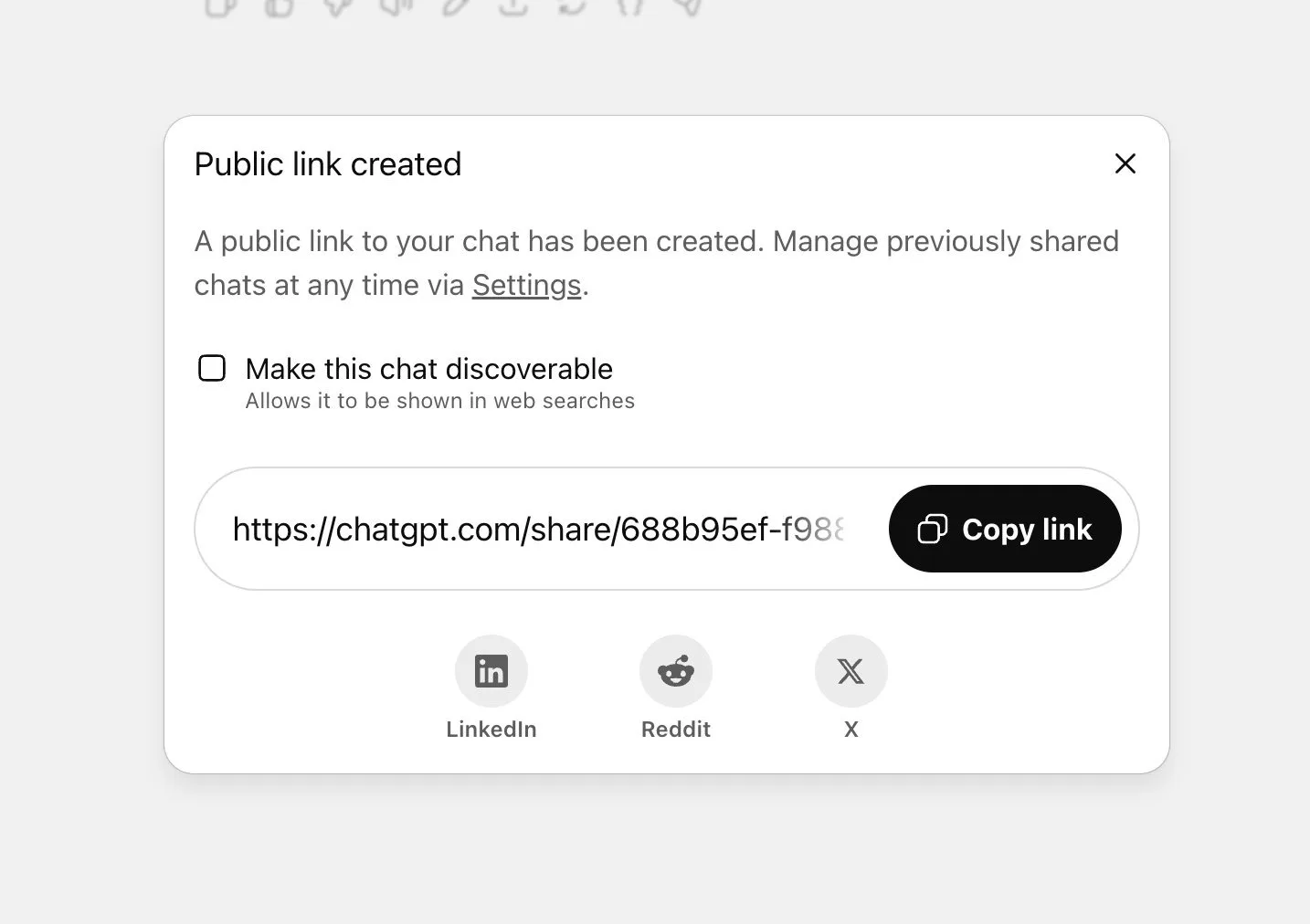

La fonctionnalité en question permettait aux utilisateurs de partager publiquement une conversation avec ChatGPT, avec une case à cocher supplémentaire pour la rendre « découvrable sur le Web ».

Bien que l’activation soit volontaire, des milliers de conversations, souvent personnelles ou sensibles, se sont retrouvées indexées par Google, visibles avec une simple recherche site : chatgpt.com/share “terme”.

On y trouvait de tout : des questions intimes sur la santé, des projets de carrière confidentiels, voire des documents professionnels comme des brouillons de CV, avec noms, prénoms et parfois les coordonnées des utilisateurs. L’affaire a éclaté quand plusieurs experts en cybersécurité ont publié ces résultats de recherche sur X, démontrant l’ampleur de la fuite.

Une faille humaine plus que technique

OpenAI a rapidement reconnu son erreur, expliquant sur X : « Nous pensons que cette fonctionnalité créait trop d’opportunités pour que des utilisateurs partagent involontairement des informations sensibles ».

Le système, bien qu’opt-in, reposait sur une interface utilisateur trop permissive. Pour de nombreux experts, le problème vient justement du manque de friction dans le processus : une simple case à cocher ne suffit pas à garantir une compréhension réelle des implications. Les utilisateurs, souvent enthousiastes à l’idée de partager une réponse utile, ont sous-estimé les risques de divulgation de données.

Un problème récurrent dans l’univers de l’IA

Ce n’est pas la première fois qu’un outil d’intelligence artificielle expose involontairement des données privées. En 2023, Google Bard avait connu un incident similaire, avec des conversations indexées par erreur. De son côté, Meta a également été critiqué après que certaines discussions avec son assistant IA se sont retrouvées affichées publiquement sur les profils utilisateurs.

Ces répétitions illustrent une tendance inquiétante : les entreprises d’IA privilégient trop souvent l’innovation à la sécurité. Dans une course pour sortir de nouvelles fonctionnalités, la protection de la vie privée devient secondaire — jusqu’à ce que les conséquences explosent en ligne.

Les entreprises doivent tirer les leçons de cette faille

Pour les professionnels, cette affaire est un signal d’alarme clair. De plus en plus d’équipes utilisent ChatGPT pour créer des plans stratégiques, rédiger des documents internes ou faire de la recherche concurrentielle. La moindre faille dans la gestion des données peut exposer des informations critiques à la concurrence ou au public.

Questions à poser à vos fournisseurs IA :

- Les données saisies peuvent-elles être partagées ou indexées ?

- Quelle est la politique de conservation des conversations ?

- Existe-t-il des moyens techniques de bloquer la diffusion accidentelle de contenus ?

Des experts recommandent aussi de faire des audits réguliers des contenus partagés, notamment en recherchant le nom de votre entreprise via site:chatgpt.com/share.

Comment améliorer la confidentialité dans l’IA ?

L’affaire met en lumière plusieurs bonnes pratiques que les entreprises d’IA (et leurs utilisateurs) devraient adopter :

- Des paramètres de confidentialité par défaut plus stricts : tout ce qui est susceptible d’être exposé doit être caché par défaut, non l’inverse.

- Une interface plus pédagogique : les choix doivent être expliqués clairement, avec des alertes sur les conséquences.

- Des systèmes de réaction rapide : la rapidité d’OpenAI à désactiver la fonction a limité les dégâts, mais une validation plus rigoureuse en amont aurait évité la crise.

Une bonne idée… mal exécutée ?

L’idée de rendre certaines conversations IA consultables pouvait sembler prometteuse. À l’image de Stack Overflow, un ChatGPT “searchable” aurait pu devenir une mine d’or pour les développeurs ou les professionnels. Mais le concept soulève un dilemme fondamental : comment exploiter l’intelligence collective sans compromettre la vie privée ?

Les entreprises doivent désormais intégrer la confidentialité comme un pilier de leurs stratégies IA, et non comme un simple post-scriptum. Cela inclut des politiques claires sur l’utilisation de l’IA en interne, une cartographie des outils déployés et des flux de données et des formations pour les employés sur les risques liés à l’usage d’assistants IA.

L’incident OpenAI est un rappel : la confiance est difficile à gagner, mais très facile à perdre. À mesure que les outils d’IA deviennent omniprésents dans notre quotidien, seule une approche responsable, transparente et prévoyante permettra à l’industrie de conserver la confiance du public.