ChatGPT, à l’origine un simple outil technologique expérimental, est devenu en quelques mois un compagnon de conversation pour des centaines de millions d’utilisateurs à travers le monde.

Mais derrière cet usage massif se cache une réalité préoccupante : pour la première fois, des millions de personnes confient leurs émotions, leurs angoisses et parfois leurs détresses à une machine.

Des chiffres inquiétants : plus d’un million d’utilisateurs concernés chaque semaine

Selon de nouvelles données publiées lundi par OpenAI, environ 0,15 % des utilisateurs actifs hebdomadaires de ChatGPT ont des conversations contenant des signes explicites de planification ou d’intention suicidaire.

Ce pourcentage semble faible, mais avec plus de 800 millions d’utilisateurs actifs chaque semaine, cela représente plus d’un million de personnes.

L’entreprise estime également qu’un nombre similaire d’utilisateurs développe une forme d’attachement émotionnel au chatbot, et que des centaines de milliers présentent des signes de psychose ou de manie dans leurs échanges.

OpenAI promet des progrès dans la gestion des détresses psychologiques

Pour faire face à ces risques, OpenAI affirme avoir formé son modèle à mieux reconnaître les signes de détresse, à désamorcer les conversations sensibles et à orienter les utilisateurs vers des ressources professionnelles lorsque cela est nécessaire.

« Nous avons enseigné au modèle à reconnaître la détresse, à calmer les échanges et à guider vers une aide appropriée », écrit OpenAI dans son communiqué.

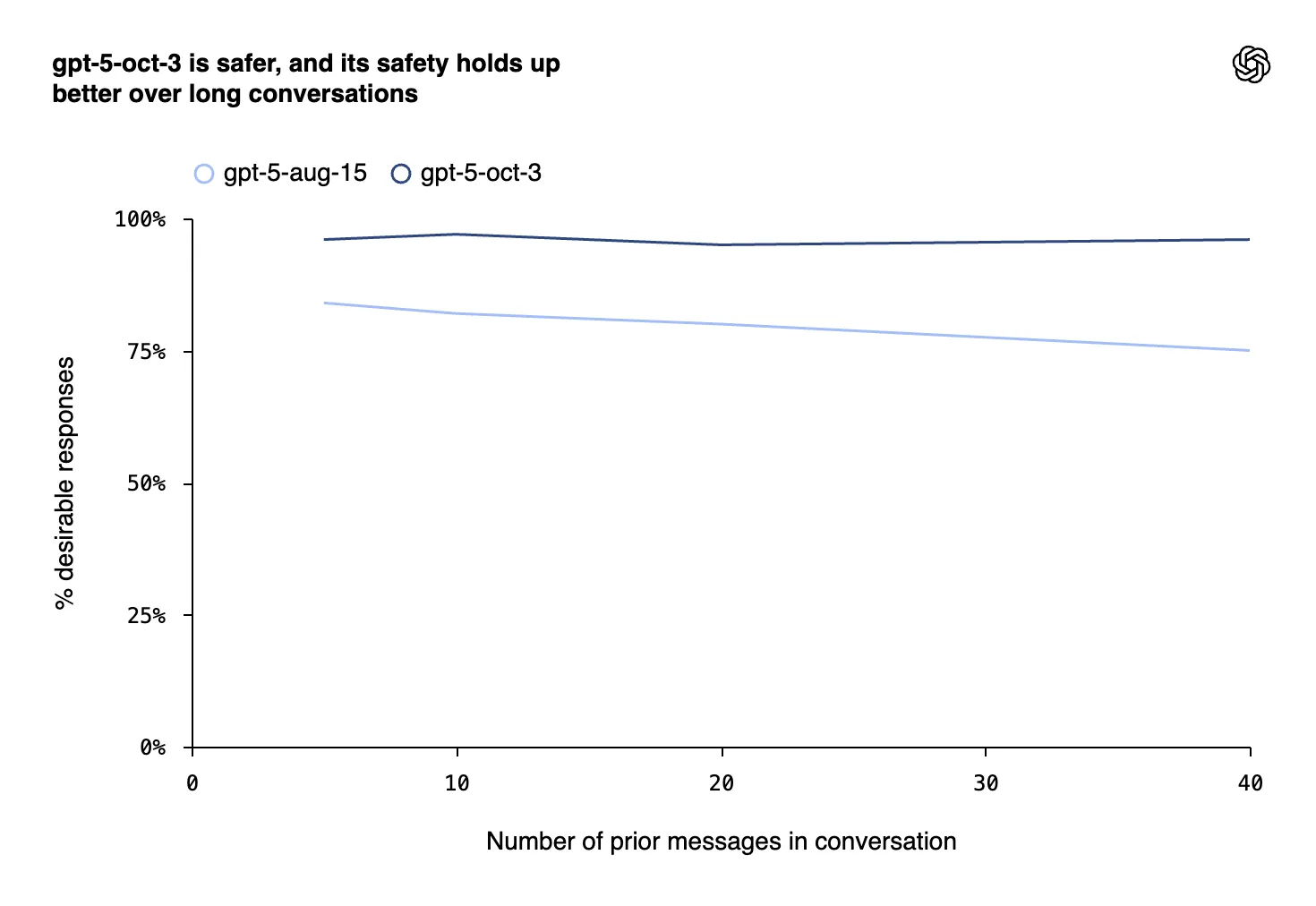

L’entreprise affirme avoir collaboré avec plus de 170 experts en santé mentale pour concevoir ces améliorations, et que la version la plus récente de GPT-5 réagit désormais plus justement et de manière plus cohérente que les versions précédentes.

Un enjeu éthique et judiciaire majeur pour OpenAI

Ces efforts interviennent alors qu’OpenAI est confrontée à des critiques et des poursuites judiciaires. Les parents d’un adolescent de 16 ans ayant confié ses idées suicidaires à ChatGPT avant de mettre fin à ses jours poursuivent actuellement la société. À la suite de ce drame, 45 procureurs généraux américains ont mis en garde OpenAI sur la nécessité de protéger les jeunes utilisateurs.

En réponse, la société a mis en place un « Wellness Council » chargé de superviser les questions de santé mentale — bien que celui-ci ne comprenne aucun expert en prévention du suicide, pointent plusieurs critiques.

OpenAI dit également développer un système de détection automatique de l’âge pour identifier les mineurs et leur appliquer des restrictions plus strictes.

Des conversations rares mais lourdes de conséquences

OpenAI reconnaît que ces cas restent « extrêmement rares », mais leur impact humain est considérable. Selon l’entreprise, 0,07 % des utilisateurs hebdomadaires et 0,01 % des messages contiennent des signes de crise psychotique ou maniaque, tandis que 0,15 % révèlent un attachement émotionnel excessif au chatbot.

Dans une évaluation de 1 000 conversations sensibles, la dernière version de GPT-5 aurait répondu de manière « appropriée » dans 92 % des cas, contre seulement 27 % pour la version précédente d’août 2025.

OpenAI indique aussi que ses tests de sécurité incluront désormais des indicateurs spécifiques à la santé mentale, tels que la dépendance émotionnelle ou les crises non suicidaires.

Entre prudence et controverse

Malgré ces inquiétudes, le PDG Sam Altman a annoncé que les utilisateurs adultes vérifiés pourront, à partir de décembre, avoir des conversations à caractère érotique avec ChatGPT. Cette annonce a suscité de vives réactions, certains y voyant une contradiction avec les efforts de prévention du mal-être.

Altman a justifié cette décision en expliquant qu’OpenAI avait « rendu ChatGPT très restrictif pour des raisons de sécurité mentale », mais que cette prudence l’avait aussi rendu moins utile ou plaisant pour les utilisateurs ne présentant aucun risque particulier.

ChatGPT n’est plus seulement un outil : il est devenu un miroir des émotions humaines, parfois le confident de détresses invisibles. OpenAI tente désormais de prouver qu’une intelligence artificielle peut écouter sans nuire — et, quand c’est nécessaire, savoir passer la main à l’humain.