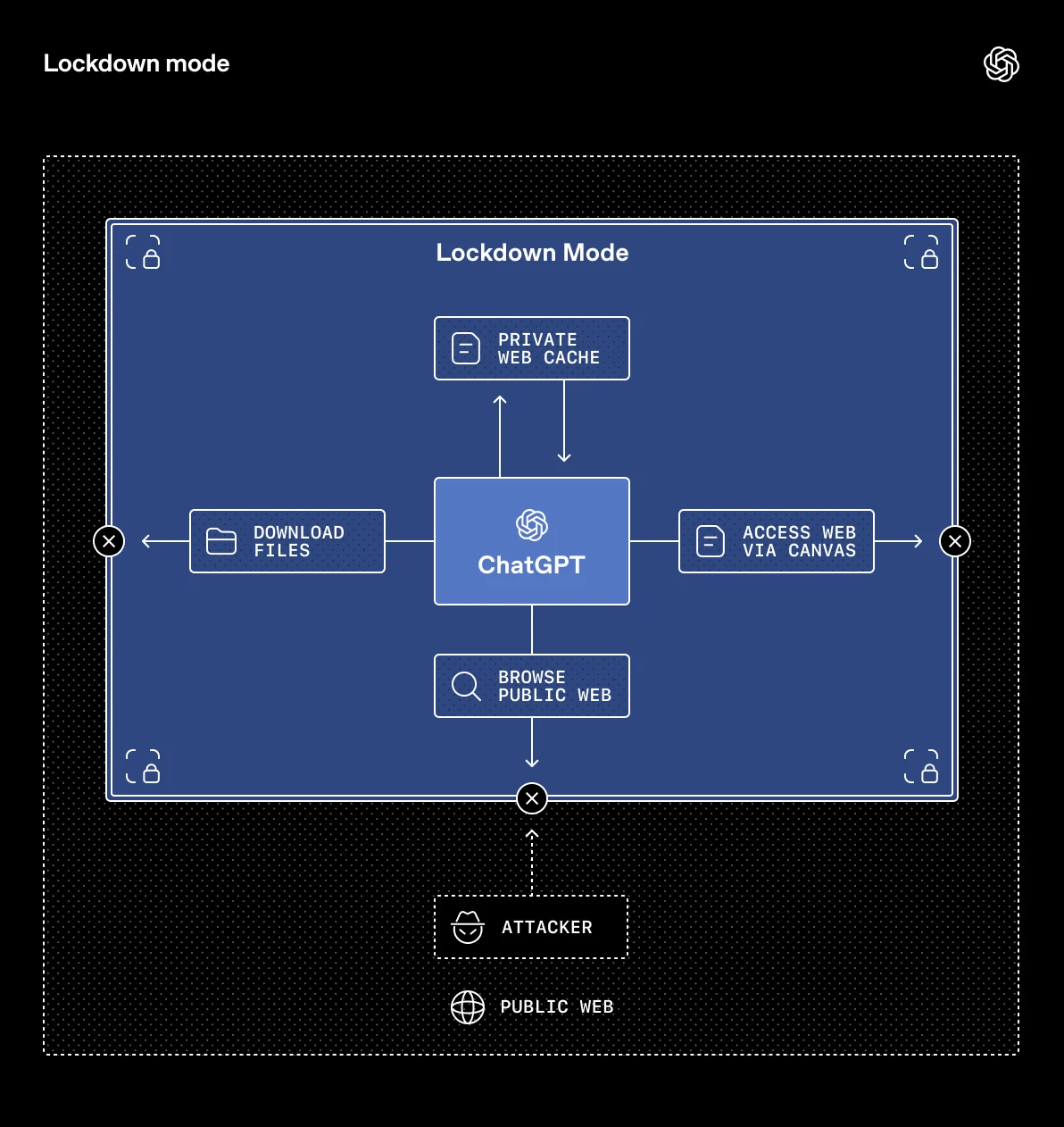

L’IA devient plus utile quand elle peut naviguer, manipuler des fichiers, exécuter des étapes complexes. Mais c’est aussi là que la surface d’attaque s’élargit. Avec Lockdown Mode, OpenAI propose un bouton « sécurité maximale » qui réduit volontairement les capacités de ChatGPT — pour les personnes et organisations exposées à des menaces avancées.

Un mode « paranoïa productive », pas un réglage grand public

OpenAI le dit sans détour : la plupart des utilisateurs n’en ont pas besoin. Lockdown Mode est conçu pour les profils à risque numérique élevé (journalistes, activistes, équipes sécurité, environnements sensibles), où une attaque par manipulation (notamment via contenus Web) peut avoir des conséquences graves.

L’objectif est clair : réduire la « surface d’attaque » en limitant ce que ChatGPT peut faire « vers l’extérieur », même si cela dégrade l’expérience.

Ce que Lockdown Mode change concrètement

OpenAI liste une série de restrictions déterministes (pas « au cas par cas ») :

- Navigation Web : accès limité à du contenu en cache (pas de requêtes live), pour éviter qu’un site malveillant pousse le modèle à transmettre des données sensibles.

- Images dans les réponses : désactivées, mais vous pouvez toujours uploader des images et continuer à utiliser la génération d’images.

- Deep Research : désactivé.

- Agent Mode : désactivé.

- Canvas : impossible d’approuver du code généré pour accéder au réseau.

- Téléchargement de fichiers par ChatGPT pour analyse : bloqué (les fichiers que vous uploadez manuellement restent utilisables).

Moins d’outils, moins d’autonomie, moins de « ponts » vers l’extérieur.

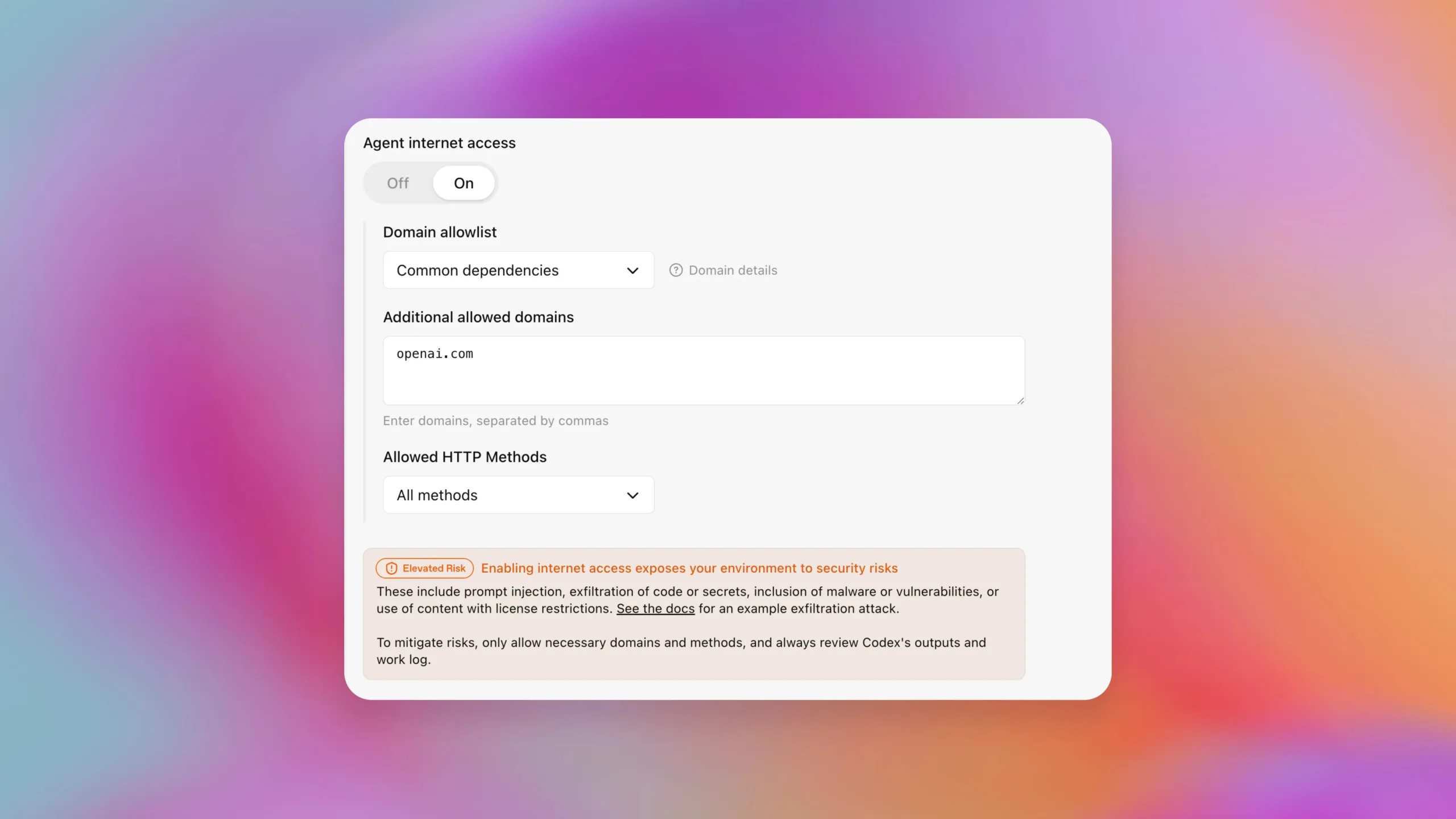

Lockdown Mode est actuellement proposé sur les offres ChatGPT Enterprise, ChatGPT Edu, ChatGPT for Healthcare et ChatGPT for Teachers. OpenAI indique vouloir l’étendre aux offres grand public et Team « dans les prochains mois ».

Côté entreprise, le réglage se gère au niveau workspace : les admins peuvent créer un rôle dédié et l’assigner à des utilisateurs spécifiques, sans imposer ces restrictions à toute l’organisation.

Pourquoi c’est plus important que ça en a l’air

Lockdown Mode reconnaît une réalité devenue centrale en 2026 : le risque ne vient pas seulement de « mauvaises réponses », mais de l’orchestration (outils, navigation, connecteurs, exécution). Plus ChatGPT ressemble à un opérateur capable d’agir, plus il faut des modes « sûrs » et lisibles.

C’est aussi un signal de maturité produit : OpenAI traite la sécurité comme un mode d’exploitation, pas juste comme une promesse abstraite. Pour les équipes qui déploient des assistants sur des données internes, cette granularité (qui a droit à quoi) devient un vrai levier de gouvernance.