En moins d’une semaine, la santé est devenue le nouveau terrain de jeu — et de confrontation — des grands modèles d’IA. Après le lancement de ChatGPT Health le 7 janvier 2026, Anthropic riposte le 11 janvier avec Claude for Healthcare, une déclinaison pensée pour les hôpitaux, les assureurs… et, fait plus rare, les patients.

Claude for Healthcare : Une annonce calée au millimètre dans la bataille du « care »

Côté OpenAI, le message est clair : l’usage santé est déjà massif, avec plus de 230 millions de personnes qui poseraient chaque semaine des questions liées à la santé et au bien-être sur ChatGPT, d’après l’entreprise et plusieurs médias.

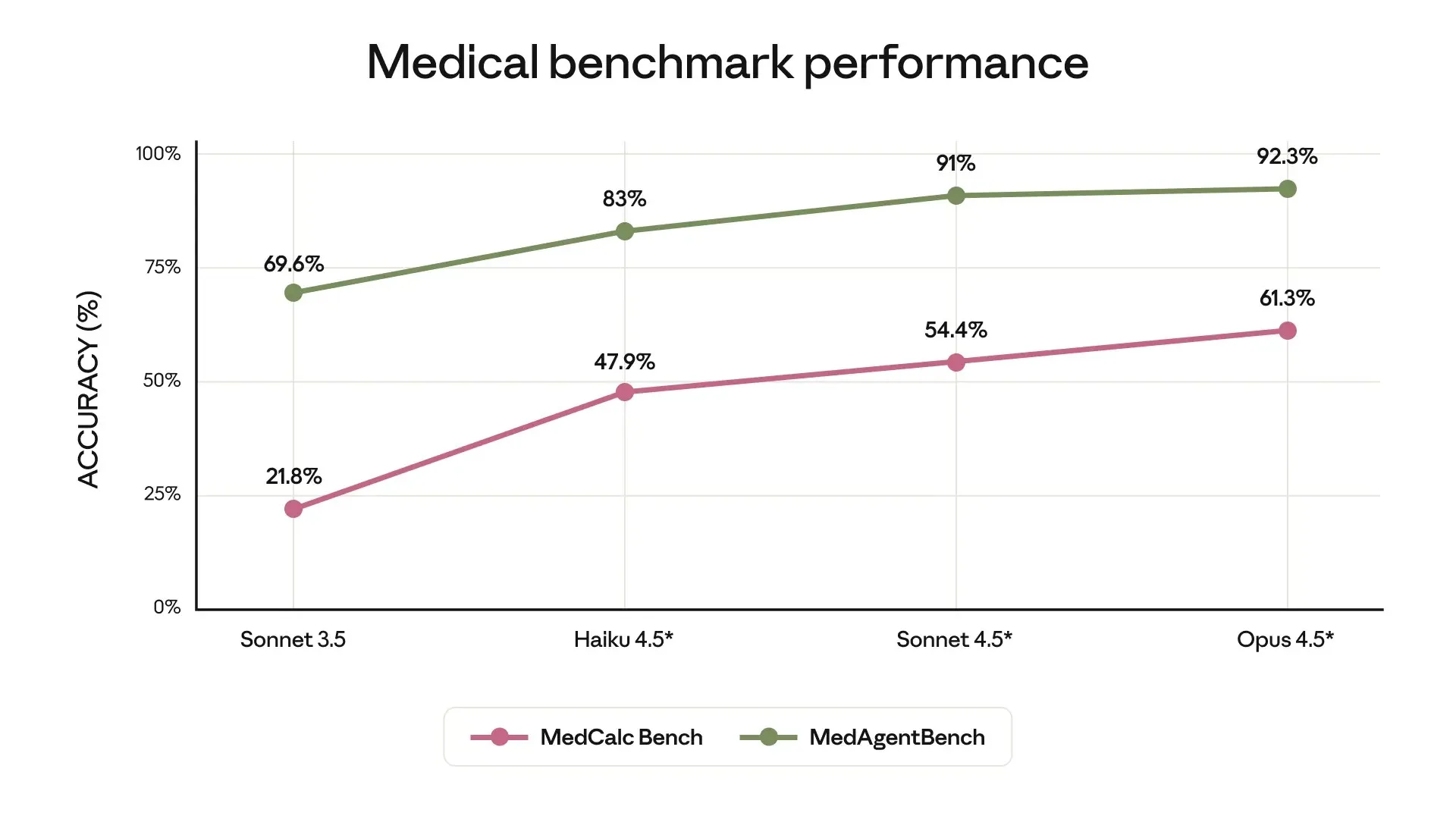

Anthropic arrive avec une promesse différente : moins « assistant grand public qui répond », plus « brique d’infrastructure » pour des organisations où l’erreur et la fuite de données ne pardonnent pas. La société présente Claude for Healthcare comme un ensemble d’outils compatibles HIPAA (Health Insurance Portability and Accountability Act) et connectés à des référentiels médicaux, pour réduire la friction administrative et améliorer l’accès à l’information clinique.

Anthropic parle d’un dispositif en deux étages :

- Entreprise (soignants/payeurs) : accès « prêt pour HIPAA », connecteurs vers des bases comme CIM-10, PubMed, ou des ressources liées à CMS, et des « Agent Skills » personnalisables (dont des usages orientés FHIR).

- Côté patient : intégrations permettant de relier des données personnelles via des partenaires — dont HealthEx, mais aussi des ponts vers des apps/plateformes de santé. Anthropic insiste sur le fait que ces données ne seraient pas stockées ni utilisées pour entraîner ses modèles dans ce cadre.

En face, ChatGPT Health mise d’abord sur l’expérience : un espace dédié dans ChatGPT pour connecter dossiers médicaux et apps de bien-être (ex. Apple Health, MyFitnessPal…), interpréter des résultats, préparer un rendez-vous, ou comparer des options d’assurance — tout en promettant des contrôles de confidentialité renforcés et un cloisonnement des données santé.

À noter : au lancement, l’accès a été annoncé comme limité et non disponible dans l’EEE (donc la France), en Suisse et au Royaume-Uni dans l’immédiat.

Deux stratégies, un même nerf de la guerre — la confiance

La différence la plus structurante est presque philosophique :

-

- OpenAI cherche à « canaliser » un usage déjà existant, très grand public, et à le rendre plus contextualisé via des connexions de données. C’est une logique de produit, portée par la volumétrie et l’interface conversationnelle.

- Anthropic cible le cœur dur des organisations : conformité, intégration, workflows. En santé, cela veut dire autorisation préalable, comptes rendus, accès à des référentiels, et branchements propres sur l’écosystème de DME.

En filigrane, un mot hante tous les DSI hospitaliers : responsabilité. Les modèles génératifs « hallucinent » — pas toujours, pas toujours gravement, mais suffisamment pour que la santé exige des garde-fous procéduraux (incertitude explicitée, traçabilité, escalade vers un clinicien). Les deux acteurs martèlent donc la même promesse : privacy by design et limites d’usage.

L’autre champ de bataille : l’interopérabilité (et la politique des données)

Si l’IA veut « aider » la santé, elle doit d’abord parler aux systèmes. Et, c’est précisément ce que reflète la dynamique autour de CMS : Anthropic a signé en 2025 un engagement lié au Health Tech Ecosystem pour pousser l’interopérabilité et le partage de données, dans un cadre public-privé.

Dans le réel, on voit déjà des déploiements : Banner Health, par exemple, met en avant l’assistant BannerWise basé sur Claude, déployé à grande échelle en interne, et présenté comme une rampe d’accès à des usages plus larges (opérations, supply chain, etc.).

Et au-dessus de la mêlée, il y a la question des moyens : Reuters rapporte que Anthropic préparerait une levée pouvant atteindre 10 milliards de dollars pour une valorisation d’environ 350 milliards, signe que l’industrie parie sur une monétisation massive… notamment via les secteurs régulés comme la santé.