Apple avance souvent sans paillettes et strass, mais ses publications de recherche racontent une trajectoire très claire : l’IA maison ne veut plus seulement « comprendre du texte », elle veut raisonner avec des images, en produire, et s’en servir pour chercher sur le Web comme un humain qui recadre, compare et affine.

Derrière l’étiquette Apple Intelligence, on voit émerger une nouvelle génération de modèles multimodaux pensée pour l’iPhone… et pour les serveurs.

L’IA d’Apple se joue sur deux terrains, l’appareil et le cloud privé

Apple a déjà cadré sa stratégie avec deux « piliers » techniques :

- un modèle on-device d’environ 3 milliards de paramètres, optimisé pour Apple silicon (KV-cache sharing, etc.) ;

- un modèle serveur basé sur une architecture Parallel-Track Mixture-of-Experts (PT-MoE), conçu pour Private Cloud Compute.

Ce socle n’est pas qu’un exercice académique : il sert à rendre l’IA utile et rapide sur iPhone/iPad/Mac, tout en gardant une voie « cloud » contrôlée quand la demande dépasse ce que l’appareil peut faire.

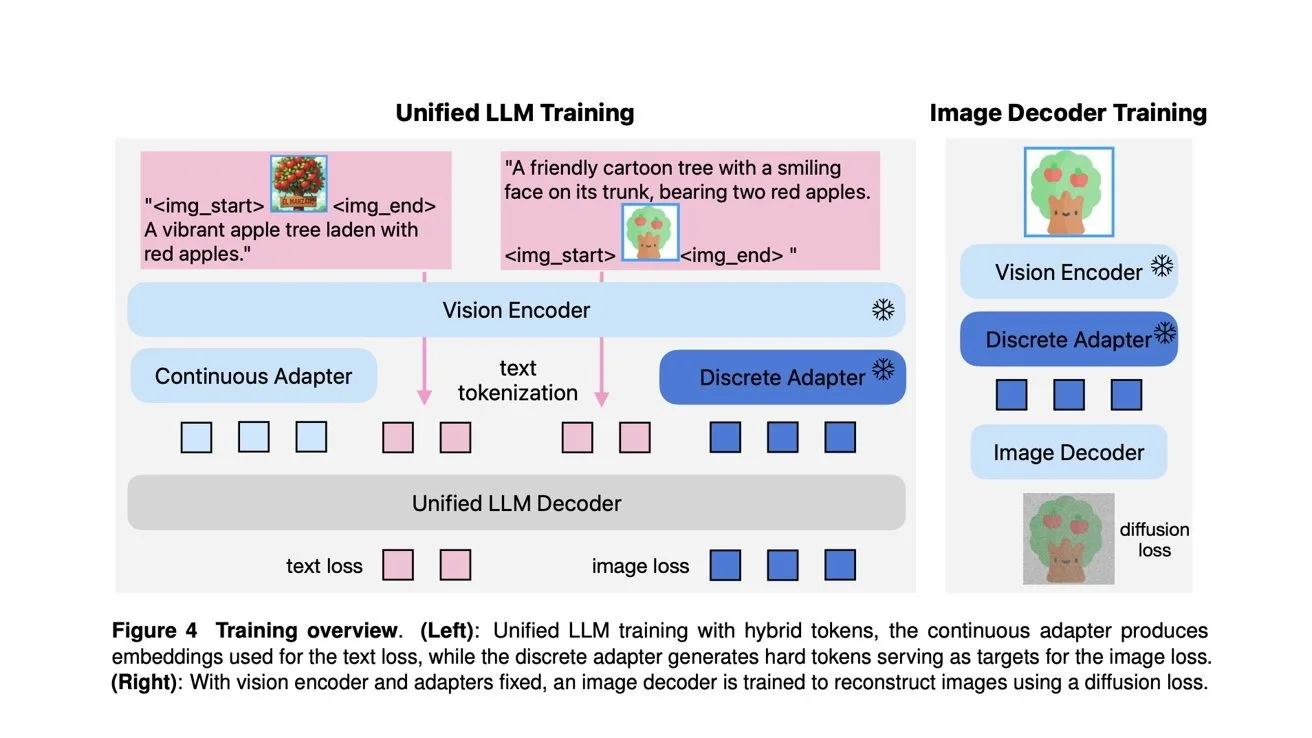

MANZANO : un modèle qui unifie compréhension visuelle et génération d’images

Le papier MANZANO vise un problème connu : beaucoup de systèmes multimodaux excellent soit en « vision-langage » (décrire/comprendre), soit en génération d’images… rarement les deux, sans compromis. MANZANO propose une approche unifiée via un hybrid vision tokenizer : des embeddings continus pour la compréhension, et des tokens discrets pour la génération, le tout dans un espace sémantique commun, avec un décodeur AR et un décodeur de diffusion pour rendre les pixels.

Traduction produit : Apple cherche un modèle « couteau suisse » capable d’alterner analyse et création sans devoir assembler plusieurs briques disparates.

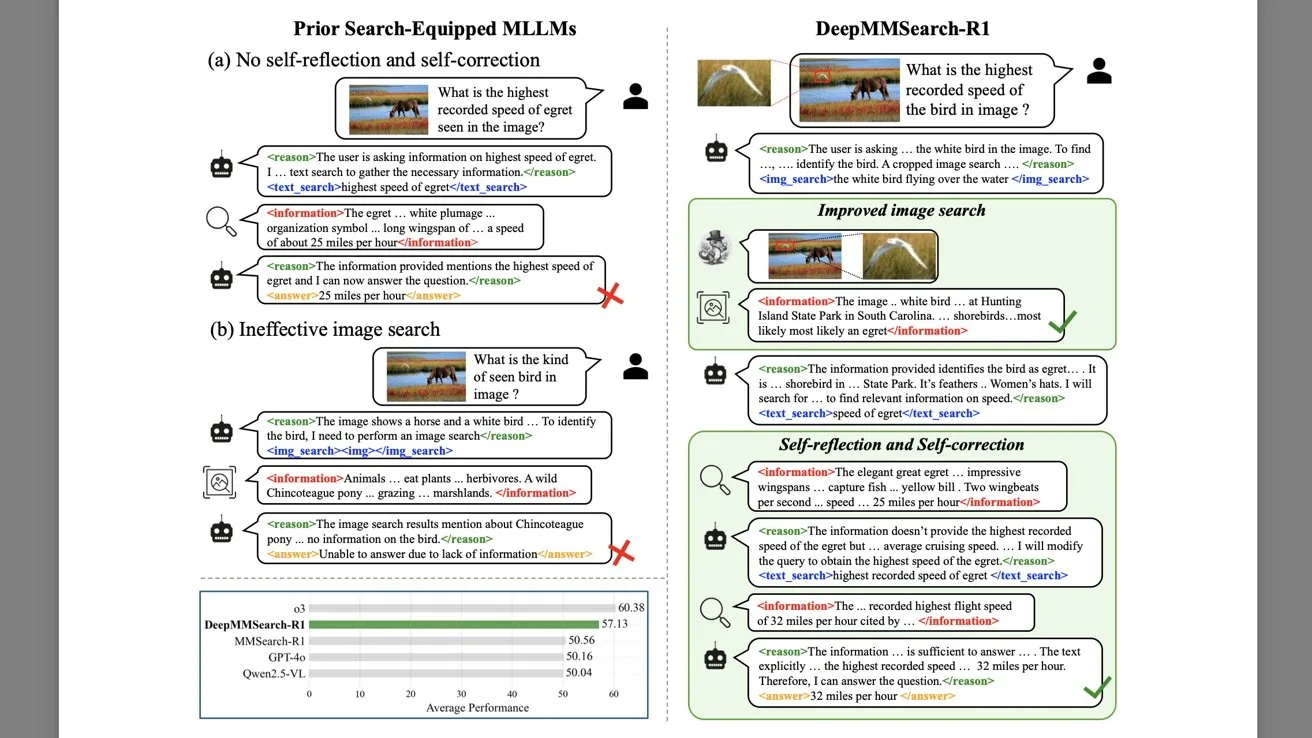

DeepMMSearch-R1 : la recherche Web « multitour » à partir d’images… et de recadrages

Autre signal fort : DeepMMSearch-R1, publié par Apple ML Research. Le modèle est conçu pour faire de la recherche Web multimodale : il peut lancer une recherche à partir de crops pertinents d’une image, puis itérer en ajustant ses requêtes texte au fil des résultats — avec des mécanismes de « self-reflection » et « self-correction » via un pipeline SFT puis RL en ligne.

Ce point est stratégique : l’usage quotidien, ce n’est pas seulement « décris cette photo », c’est « je veux retrouver ce truc dans l’image », « je veux acheter cet objet », « c’est quoi ce modèle ? » — et le recadrage est le geste naturel pour y arriver.

Faire tenir le multimodal dans une expérience Apple (et pas juste un benchmark)

Ce qui se dessine, c’est une IA multimodale à deux vitesses sur l’appareil, pour la latence, l’instantané, les usages privés et offline, et sur Private Cloud Compute, pour les requêtes lourdes et les outils.

Et en toile de fond, Apple a aussi officialisé une bascule d’ampleur : une collaboration pluriannuelle avec Google autour de Gemini et de technologies cloud pour la prochaine génération d’Apple Foundation Model, notamment pour une Siri plus personnalisée.

Ce partenariat ne contredit pas la R&D interne : il donne à Apple un « plancher » industriel pendant que ses équipes poussent des architectures maison et des briques multimodales plus spécifiques.

Ce que ça change, concrètement, pour l’iPhone (et pour la suite)

Si MANZANO et DeepMMSearch-R1 finissent par infuser dans les produits, on se dirige vers :

- des Photos plus « intelligentes » (comprendre, retrouver, résumer une scène) ;

- une recherche qui accepte enfin le langage naturel… et l’image comme requête ;

- des outils créatifs où la génération n’est plus un gadget, mais un workflow.

Apple ne vendra probablement pas ces noms-là au public. Mais, la direction est limpide : l’avenir de l’IA « utile » sur smartphone passera par la capacité à voir, raisonner, chercher — et pas seulement à écrire.