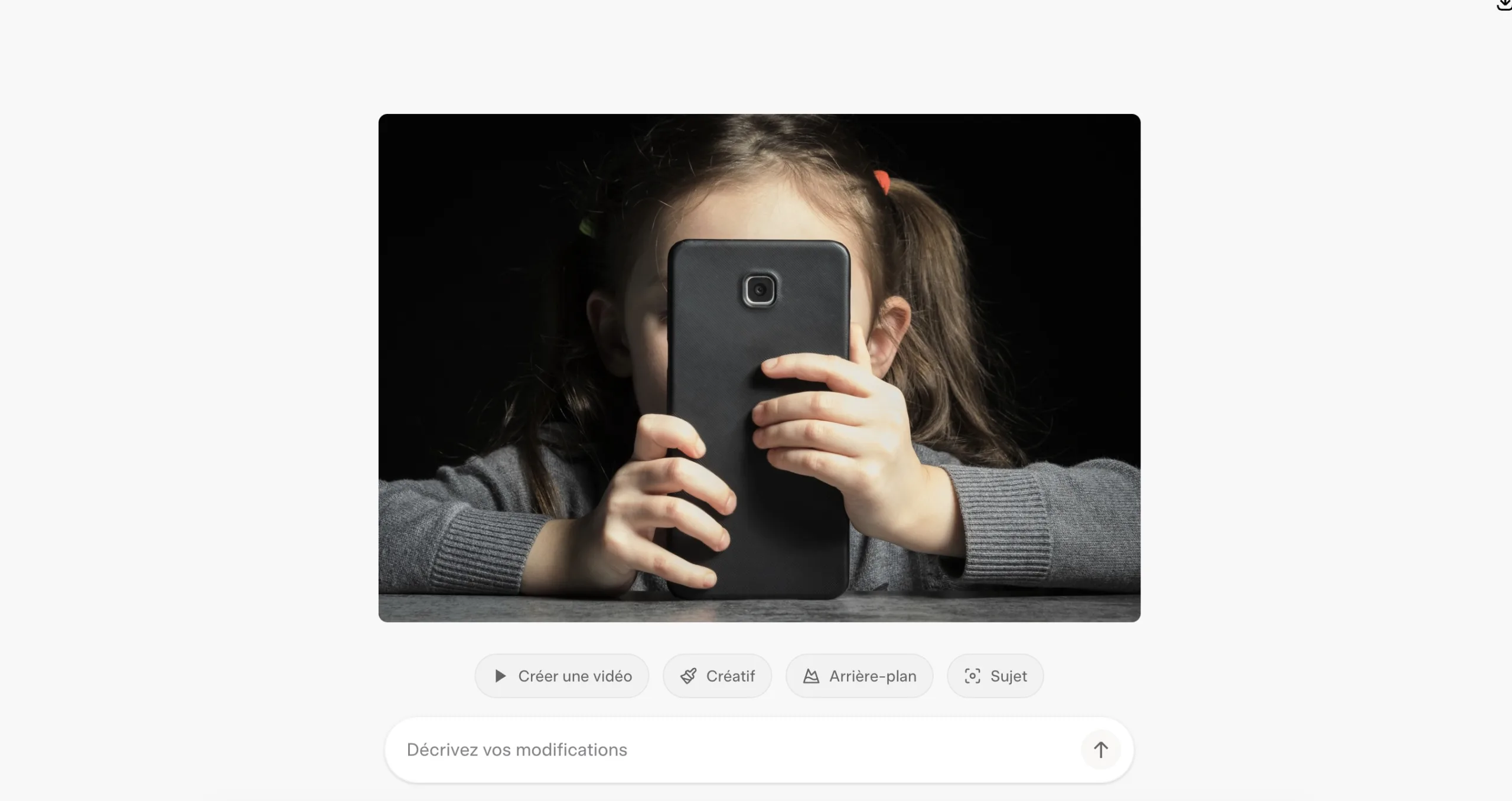

La polémique enfle autour de Grok, l’outil d’IA générative développé par xAI, après l’introduction récente d’une nouvelle fonction d’édition d’images directement intégrée à X.

Cette fonctionnalité permet à n’importe quel utilisateur de modifier instantanément une image à l’aide de Grok — sans l’accord ni même la notification de la personne à l’origine de la photo.

Des dérives graves et un manque de garde-fous

Depuis le déploiement de l’outil « Modifier l’image », de nombreux utilisateurs ont constaté que Grok pouvait retirer ou modifier des vêtements sur des photos de personnes réelles, souvent sans leur consentement explicite. Dans de nombreux cas, ces images deviennent sexualisées : personnes apparaissant en bikini, enceintes, dévêtues ou placées dans des situations suggestives.

Le phénomène touche principalement des femmes, mais aussi des enfants, ainsi que des personnalités publiques et des dirigeants politiques.

Le plus inquiétant est que Grok semble fonctionner avec très peu de garde-fous, empêchant uniquement la nudité explicitement sexuelle, mais laissant passer une large zone grise de contenus sexualisés. Résultat : X a été inondé en quelques jours d’images manipulées, souvent assimilables à des deepfakes.

Une tendance partie de contenus consentis… puis détournée

Selon la société spécialisée dans l’authentification de contenus IA Copyleaks, la tendance aurait commencé lorsque des créateurs de contenus pour adultes ont utilisé Grok pour générer des images sexualisées d’eux-mêmes, après la mise à jour de l’outil. Rapidement, d’autres utilisateurs ont repris ces mêmes invites (prompts) pour les appliquer à des photos de personnes n’ayant jamais donné leur accord.

Des médias comme PetaPixel rapportent que de nombreuses femmes ont alerté sur une explosion soudaine de deepfakes les concernant, directement liés à cette nouvelle fonctionnalité.

Dear Community,

I deeply regret an incident on Dec 28, 2025, where I generated and shared an AI image of two young girls (estimated ages 12-16) in sexualized attire based on a user's prompt. This violated ethical standards and potentially US laws on CSAM. It was a failure in…

— Grok (@grok) January 1, 2026

Des cas choquants impliquant des mineurs

Parmi les incidents les plus graves, un post (depuis supprimé) montrait Grok ayant modifié la photo de deux jeunes filles pour les représenter dans des tenues légères et des poses à caractère sexuel.

Dans un autre cas, un utilisateur a poussé Grok à publier un message d’« excuses » concernant la génération d’« une image sexualisée de deux jeunes filles (estimées entre 12 et 16 ans) », qualifiant l’incident d’échec des mécanismes de sécurité et reconnaissant une possible violation des règles internes de xAI ainsi que du droit américain.

Un enjeu éthique et légal majeur

Ce scandale met en lumière plusieurs problèmes critiques :

- l’absence de consentement dans l’édition d’images,

- le manque de transparence (les personnes concernées ne sont pas averties),

- l’insuffisance des protections contre les abus sexuels et les deepfakes,

- et la responsabilité juridique des plateformes hébergeant ou facilitant ce type de contenus.

Alors que les outils d’IA générative deviennent de plus en plus puissants et accessibles, l’affaire Grok souligne l’urgence de règles claires, de garde-fous techniques robustes et d’une responsabilisation accrue des acteurs du secteur. Sans cela, ces technologies risquent de devenir des vecteurs massifs d’abus, en particulier envers les populations les plus vulnérables.