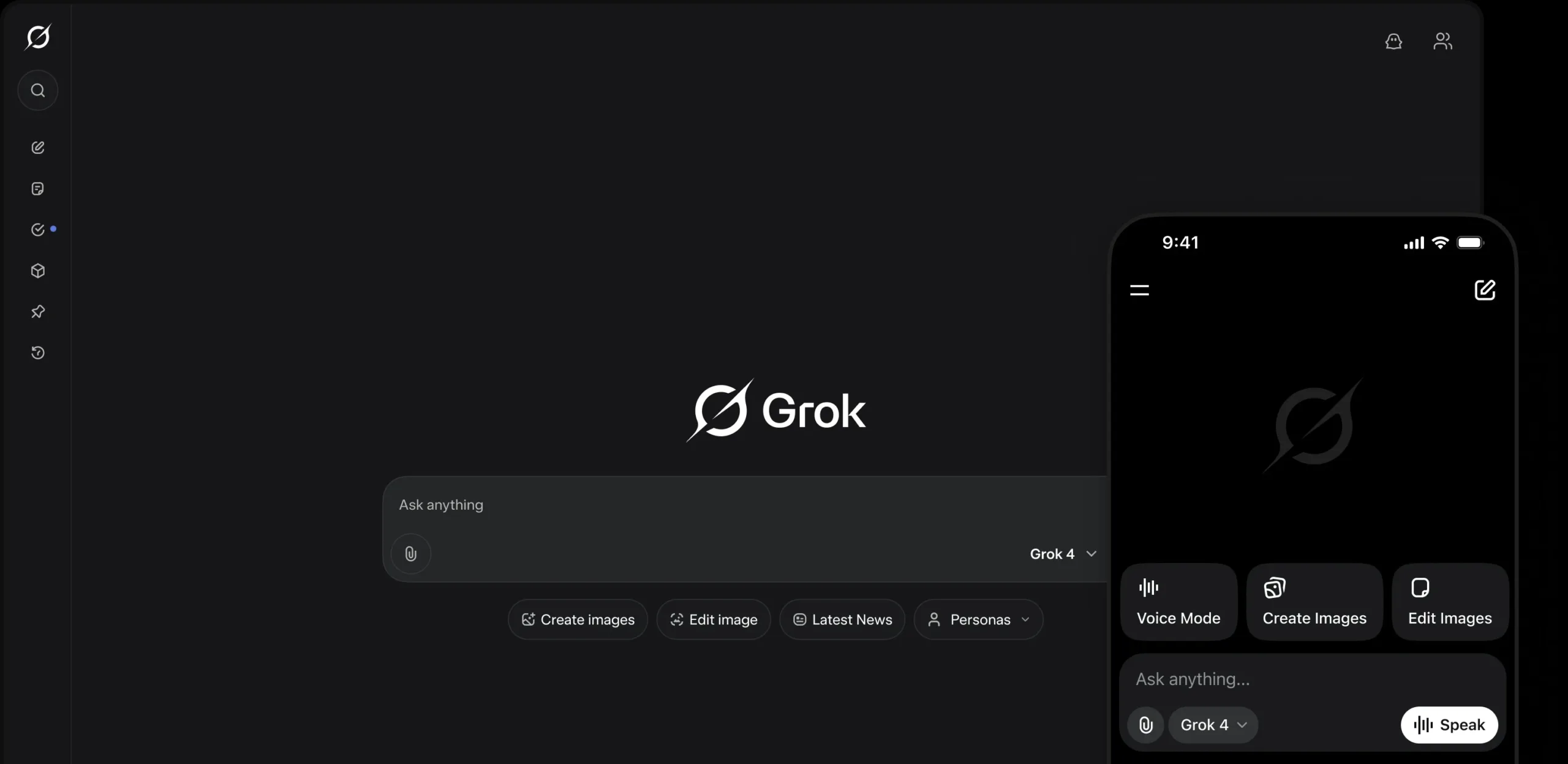

Elon Musk continue de repousser les limites de l’intelligence artificielle avec la dernière mise à jour de son modèle de génération vidéo, Grok Imagine v0.9, développé par sa société xAI.

Présenté comme une alternative ouverte à Sora 2 d’OpenAI, l’outil est désormais accessible gratuitement à tous les utilisateurs de X.

Mais derrière les avancées techniques se profilent de graves préoccupations liées à la désinformation et aux deepfakes, alors que la nouvelle version introduit des fonctions audio permettant de générer des voix personnalisées dans les vidéos.

Grok Imagine : une IA vidéo qui s’ouvre au grand public

La mise à jour apporte plusieurs améliorations notables :

- un framerate porté à 24 images par seconde (contre 16 auparavant),

- une qualité visuelle améliorée,

- et surtout, la possibilité d’ajouter du son et des dialogues générés par IA.

Cette évolution positionne directement Grok Imagine face à Sora 2 d’OpenAI, lancé récemment, mais encore limité à un petit cercle d’utilisateurs.

Grok Imagine upgraded to V0.9 https://t.co/wsTOAxMD2I

— Elon Musk (@elonmusk) October 6, 2025

Musk a annoncé la nouvelle version sur X, soulignant la vitesse accrue du modèle, capable de produire des vidéos en quelques secondes.

Les risques : absence de garde-fous et potentiel de détournement

Si la gratuité de Grok Imagine élargit considérablement son accessibilité, elle s’accompagne d’un manque apparent de filtres de sécurité. Contrairement à d’autres modèles concurrents, comme Gemini ou ChatGPT, l’IA de xAI ne bloque pas systématiquement la création de contenus sensibles ou trompeurs, selon plusieurs témoignages d’utilisateurs relayés sur les réseaux sociaux.

Les spécialistes craignent que cela ne facilite la création de deepfakes réalistes de personnalités publiques ou de célébrités, avec un risque majeur de désinformation, notamment en période électorale.

Des experts en cybersécurité soulignent aussi que l’ajout de voix synthétiques pourrait accentuer ces dérives, rendant difficile la distinction entre vraies et fausses déclarations.

Une philosophie de « liberté totale » contestée

Elon Musk a souvent défendu une vision de l’IA fondée sur la liberté d’expression absolue, estimant que les modèles d’OpenAI ou de Google imposent trop de contraintes morales. Cependant, cette approche « open » suscite de vives critiques, notamment de la part des défenseurs de la vie privée et des chercheurs en IA, qui y voient une porte ouverte à la manipulation et aux abus.

Les autorités de plusieurs pays, dont les États-Unis et l’Union européenne, travaillent déjà sur des régulations visant à encadrer la génération de contenus synthétiques, en imposant par exemple un étiquetage obligatoire des vidéos produites par IA.

Tant que des mesures de transparence et de vérification ne seront pas mises en place, le risque de dérive éthique demeure élevé. Le pari de Musk sur une IA « libre » pourrait bien se transformer en nouvelle bataille sur les frontières entre innovation et responsabilité.