Les Large Language Model (LLM) sont souvent critiqués pour leur tendance à « mémoriser » des données sensibles issues de leur entraînement. P

our contrer ce risque, une équipe de Google Research a publié un nouveau modèle expérimental baptisé VaultGemma, conçu pour intégrer la confidentialité différentielle directement dans son processus d’apprentissage.

Pourquoi la confidentialité différentielle est cruciale ?

Lorsqu’un LLM restitue mot pour mot un extrait de ses données d’entraînement, cela peut poser deux types de problèmes :

- Vie privée : si les données incluaient des informations personnelles.

- Droits d’auteur : si du contenu protégé est régurgité tel quel.

La confidentialité différentielle permet de réduire ce risque en injectant un « bruit calibré » pendant l’entraînement. L’objectif : empêcher le modèle de retenir fidèlement une donnée sensible tout en continuant à générer du texte pertinent.

Des lois d’échelle adaptées aux modèles privés

Le défi majeur, c’est que plus de bruit = moins de précision. Les chercheurs ont donc cherché à établir de nouvelles scaling laws (lois d’échelle) pour les modèles privés, en fonction de trois budgets :

- Budget de données (nombre de tokens).

- Budget de calcul (FLOPs).

- Budget de confidentialité (quantité de bruit injectée).

Résultat : il est possible d’équilibrer bruit et précision en ajustant la puissance de calcul ou la taille du dataset, afin d’entraîner un modèle privé sans trop sacrifier ses performances.

VaultGemma : un modèle ouvert et expérimental

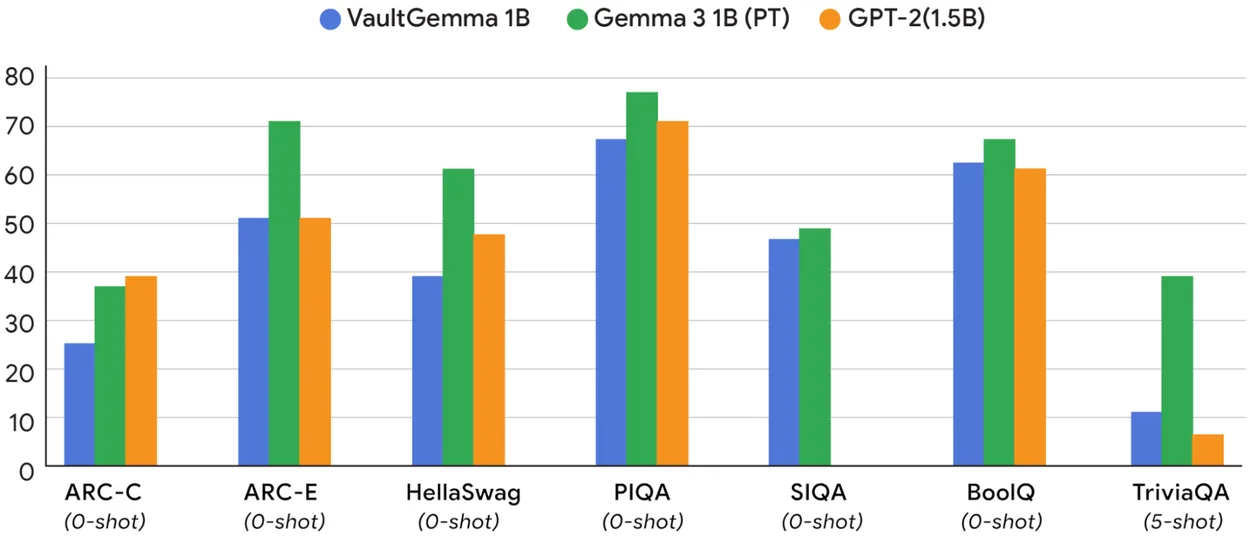

VaultGemma est basé sur la famille Gemma 2 (une génération en arrière par rapport aux derniers modèles Google), et dispose de 1 milliard de paramètres : un petit modèle comparé aux géants actuels, mais optimisé pour tester la confidentialité différentielle.

Côté performances, celles-ci sont proches d’un modèle non privé de taille équivalente, ce qui démontre l’efficacité des nouvelles lois d’échelle.

VaultGemma est disponible en poids ouverts sur Hugging Face et Kaggle. Comme les autres Gemma, il n’est pas totalement open source : il est possible de le modifier et le redistribuer, mais uniquement sous la licence Gemma, interdisant notamment les usages malveillants.

Un impact plus fort pour les petits modèles spécialisés

Cette approche ne remplacera pas les techniques actuelles des très grands LLM, où la performance brute reste prioritaire. Mais pour des modèles plus petits et spécialisés — assistants embarqués, fonctionnalités IA ciblées —, la confidentialité différentielle pourrait devenir un standard.

En clair, VaultGemma ouvre la voie à une nouvelle génération d’IA plus respectueuse de la vie privée, sans sacrifier totalement l’efficacité.