Dans un paysage dominé par les services cloud comme ChatGPT, Ollama s’impose comme une alternative open source puissante pour exécuter des modèles d’IA générative en local, directement sur votre ordinateur.

La dernière mise à jour, Ollama 0.10, introduit des améliorations de performances significatives, de nouvelles fonctionnalités utiles et, pour la première fois, une interface graphique officielle compatible macOS, Windows et Linux.

Qu’est-ce que Ollama ?

Ollama est une application en ligne de commande qui permet d’exécuter localement certains des modèles d’IA les plus performants du moment. Cela inclut :

- Meta LLaMA 3

- Google Gemma 3

- Microsoft Phi-4 et Phi-4 Mini

- DeepSeek-R1

- LLaVA (multimodal)

Les utilisateurs peuvent interagir avec ces modèles en mode conversationnel, comme avec ChatGPT, mais aussi intégrer l’IA dans des scripts et des automatisations locales, sans avoir à envoyer leurs données sur le cloud.

Ollama 0.10 : ce qui change

Cette nouvelle version apporte plusieurs nouveautés techniques, tout en rendant le projet plus accessible à un public non-développeur grâce à sa première interface graphique officielle.

Nouvelles fonctionnalités

La commande ollama ps fait son apparition. Elle permet de consulter en temps réel la longueur de contexte utilisée par chaque modèle actif, un paramètre crucial pour comprendre jusqu’où un modèle peut « se souvenir » dans une conversation.

Le support d’images au format WebP est désormais intégré à l’API compatible OpenAI, en plus des formats JPEG et PNG, ce qui facilite les traitements d’images avec des modèles multimodaux.

Performances en nette hausse

Les utilisateurs de modèles Gemma 3n bénéficieront d’une amélioration spectaculaire des performances : jusqu’à 3x plus rapide. Quant à ceux qui utilisent plusieurs GPU en parallèle, ils peuvent désormais attendre un gain de 10 à 30 % selon les configurations.

Plusieurs bugs ont aussi été corrigés, notamment liés à l’appel de fonctions (« tool calling ») dans certains modèles, comme Granite 3.3 ou Mistral-Nemo, et à la gestion des noms d’outils ambigus.

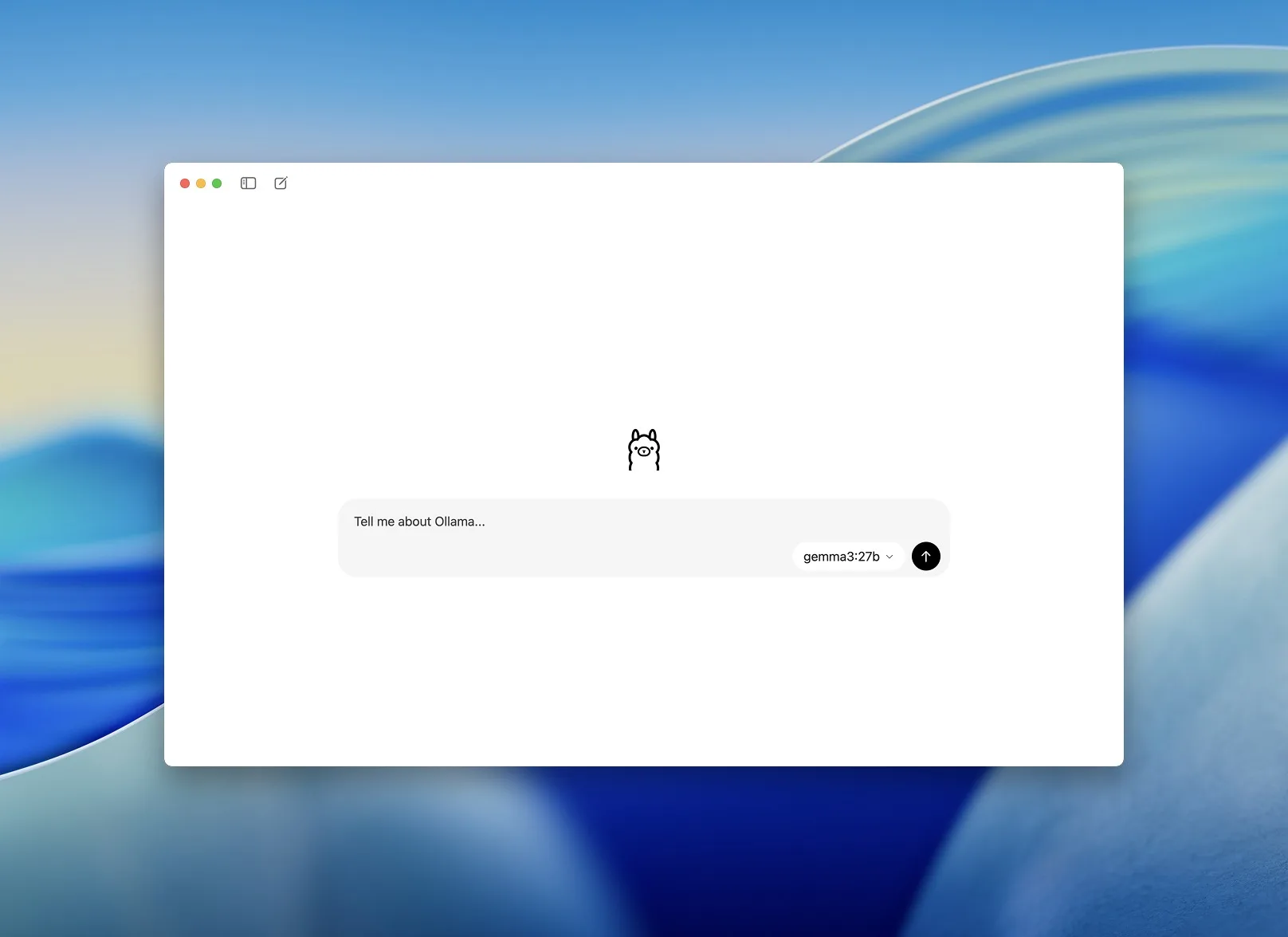

Une application de bureau simple, efficace et enfin officielle

Jusqu’ici, les utilisateurs d’Ollama devaient se tourner vers des interfaces tierces comme Open WebUI ou macLlama pour bénéficier d’un usage en mode chat. Désormais, l’équipe derrière Ollama propose sa propre interface graphique, compatible Windows, macOS et Linux.

Cette application reprend tous les fondamentaux :

- Interface de discussion simple et fluide

- Prise en charge du Markdown et des images

- Support multimodal selon le modèle utilisé

- Sélection des modèles directement depuis l’interface

Elle est pensée par des développeurs, pour des développeurs.

Pourquoi exécuter l’IA en local ?

Contrairement aux solutions cloud, Ollama permet de :

- Contrôler totalement les données traitées, un atout majeur en termes de confidentialité

- Éviter les coûts d’abonnement ou les limitations de jetons des plateformes cloud

- Exploiter les ressources matérielles disponibles (CPU, GPU) sans dépendre d’une connexion Internet

- Automatiser localement des traitements IA dans des projets personnels ou professionnels

Avec la version 0.10 et son application desktop, Ollama devient une alternative crédible aux solutions cloud d’OpenAI, Google ou Anthropic, en permettant à chacun d’exploiter la puissance de l’intelligence artificielle sur son propre PC.

Pour les développeurs, les chercheurs ou les utilisateurs avancés qui veulent garder la main sur leurs modèles, leurs données et leurs performances, Ollama est sans doute l’un des outils open source les plus prometteurs de l’année.

Vous pouvez télécharger l’application Ollama depuis le site Web du projet. La version en ligne de commande est disponible dans des dépôts de logiciels comme Homebrew et Docker Hub.