Il y a des annonces qui parlent de puissance brute, et d’autres qui trahissent une obsession plus subtile : le temps de réponse. Jeudi, OpenAI a dévoilé GPT-5.3-Codex-Spark, une variante « allégée » de son modèle de code, pensée pour des boucles d’édition quasi instantanées — et surtout, servie sur l’infrastructure de Cerebras, un partenaire inédit hors du monopole de fait des GPU Nvidia.

GPT-5.3-Codex-Spark : un modèle taillé pour l’itération en temps réel

OpenAI présente GPT-5.3-Codex-Spark comme son premier modèle explicitement conçu pour le « codage en temps réel » : moins de lourdeur, plus de fluidité, pour que l’assistant suive le rythme d’un développeur qui itère vite. La promesse est spectaculaire : 15× plus rapide, avec une sensation « quasi instantané ». OpenAI va même jusqu’à évoquer plus de 1 000 tokens/seconde dans ses conditions optimales.

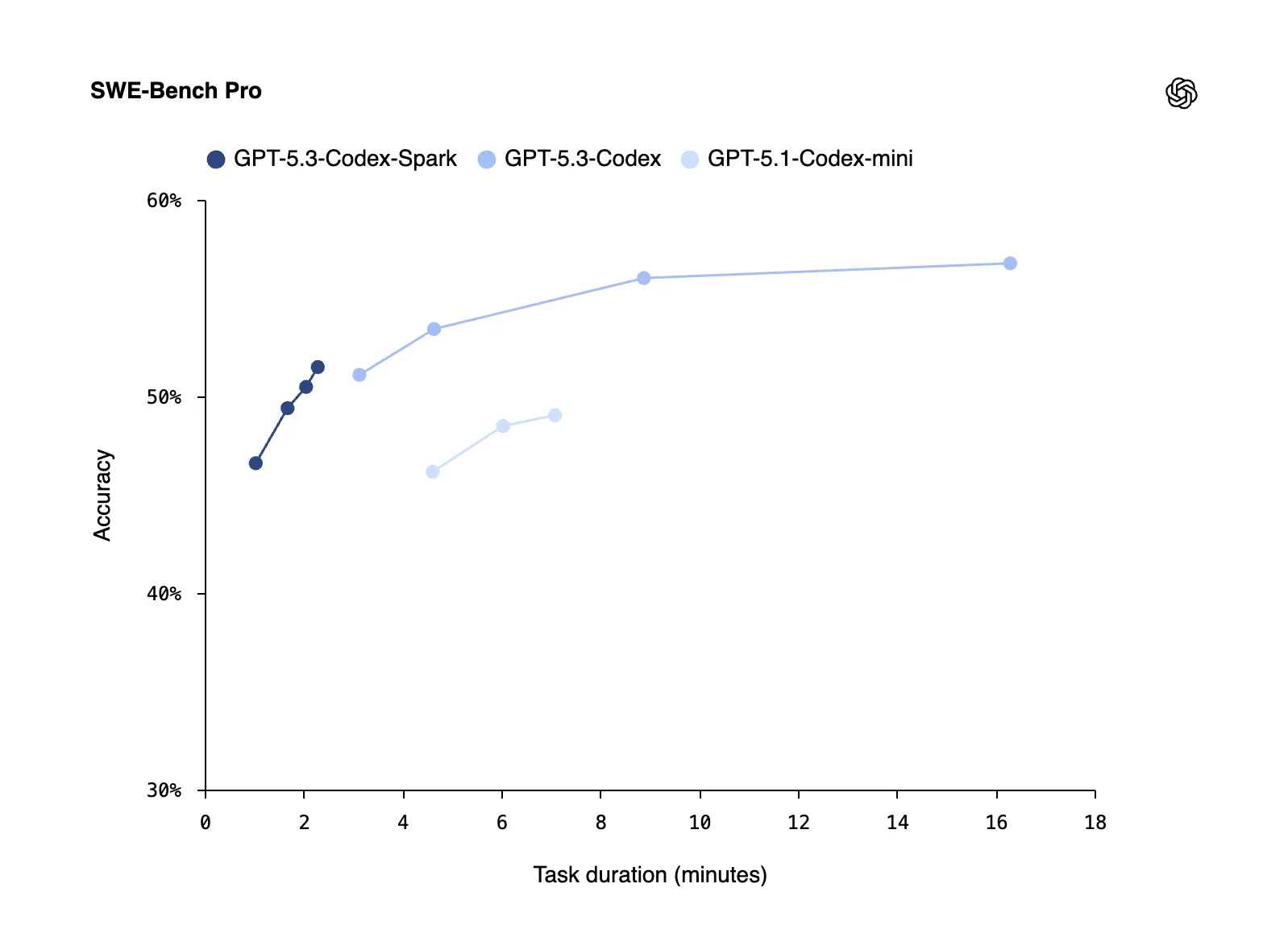

Le revers est assumé : sur des benchmarks comme SWE-Bench Pro et Terminal-Bench 2.0, Codex-Spark fait moins bien que le GPT-5.3-Codex complet. Autrement dit, il sera moins à l’aise pour des tâches longues, multi-étapes, très « agentiques », mais plus efficace pour la collaboration interactive (corrections, refactorisation, tests rapides, dialogues de code).

À l’usage, le modèle arrive avec un contexte 128 000 tokens et reste seulement en mode texte (pas d’image, pas de multimodal). Il est proposé en research preview aux abonnés ChatGPT Pro via l’app Codex, le CLI et l’extension VS Code, tandis que l’API est réservée à un petit groupe de « design partners » au départ.

Pourquoi Cerebras : casser les goulets d’étranglement de l’inférence ?

Ce lancement n’est pas qu’une histoire de modèle : c’est une histoire de silicium. Cerebras vend une thèse simple : pour l’inférence à faible latence, ses systèmes « wafer-scale » réduisent les coûts cachés de la distribution sur clusters GPU (communication inter-puces, orchestration, overhead).

La WSE-3 (Wafer-Scale Engine 3) — la vitrine technologique de Cerebras — revendique 4 000 milliards de transistors et une logique « simplicité d’un seul appareil » qui vise précisément ces workflows où chaque milliseconde compte.

Dans la narration officielle, OpenAI marche sur un fil : « les GPU restent fondamentaux », mais Cerebras « complète » l’ensemble pour les cas d’usage ultra-réactifs. Une formulation prudente… qui ressemble à de la diplomatie industrielle.

OpenAI dit aussi avoir accéléré toute sa pile d’inférence — même hors Cerebras

Autre détail révélateur : OpenAI ne limite pas sa « chasse à la latence » au matériel. Sur la même annonce, l’entreprise affirme avoir optimisé sa stack (sessions, streaming, transport) via WebSocket persistent et optimisations dans la Responses API :

- -80 % d’overhead par aller-retour client/serveur

- -30 % d’overhead par token

- -50 % sur le time-to-first-token

Ainsi, GPT-5.3-Codex-Spark est le produit-vitrine, mais l’objectif est plus large — rendre l’expérience Codex plus « temps réel » partout, y compris sur l’infra GPU classique.

Le vrai sous-texte : OpenAI diversifie ses puces au moment où l’axe Nvidia se refroidit

Si cette alliance compte, c’est parce qu’elle arrive après un gros mouvement stratégique : OpenAI et Cerebras ont annoncé en janvier un accord pluriannuel portant sur jusqu’à 750 MW de capacité « ultra low-latency », déployée en plusieurs phases.

Et ce virage se lit aussi en creux côté Nvidia. Fin janvier, Reuters rapportait que le projet d’investissement Nvidia « jusqu’à 100 milliards de dollars » dans OpenAI aurait ralenti/calé, avant que Jensen Huang ne minimise publiquement tout « drama ».

Ajoutez à cela les partenariats annoncés avec AMD (déploiements de GPU à partir de 2026) et les travaux avec Broadcom sur des accélérateurs custom, et la trajectoire devient limpide : OpenAI veut éviter la dépendance à un seul fournisseur, surtout sur l’inférence.

Dans un contexte électrique : pubs, Pentagone, et remous internes

Ce lancement technique se produit aussi au milieu d’une séquence politique et réputationnelle chargée.

OpenAI vient de démarrer un test de publicités dans ChatGPT (Free et Go, aux États-Unis), avec la promesse que les annonces n’influencent pas les réponses. La société a également officialisé le déploiement d’une version de ChatGPT sur GenAI.mil pour des usages non classifiés du Département de la Défense.

Dans ce décor, GPT-5.3-Codex-Spark ressemble autant à une innovation produit qu’à un message : OpenAI veut reprendre l’initiative sur l’expérience — et prouver que la compétition se jouera désormais sur la sensation d’usage, pas uniquement sur la taille des modèles.

Ce que ça change pour les développeurs (si la promesse tient)

La question finale est presque prosaïque : est-ce que « plus rapide » veut dire « plus productif » ? OpenAI parie que oui : quand la latence s’effondre, l’assistant cesse d’être une « requête » et devient un partenaire d’itération — un co-pilote qui suit la cadence du clavier.

Si l’inférence ultra-faible latence se généralise, le gagnant ne sera pas forcément celui qui écrit le meilleur code « en une fois », mais celui qui rend l’aller-retour humain-IA addictivement fluide. Et, dans cette course, Cerebras vient d’obtenir son premier rôle grand public.