Jusqu’ici, la plupart des modèles « vision » regardaient une image comme on jette un coup d’œil à une affiche : en une seule passe, puis ils improvisaient si un détail leur échappait. Google DeepMind vient d’annoncer un changement de méthode avec Agentic Vision dans Gemini 3 Flash : l’image n’est plus seulement interprétée, elle est explorée activement, étape par étape, avec exécution de code Python pour zoomer, recadrer, annoter et vérifier avant de répondre.

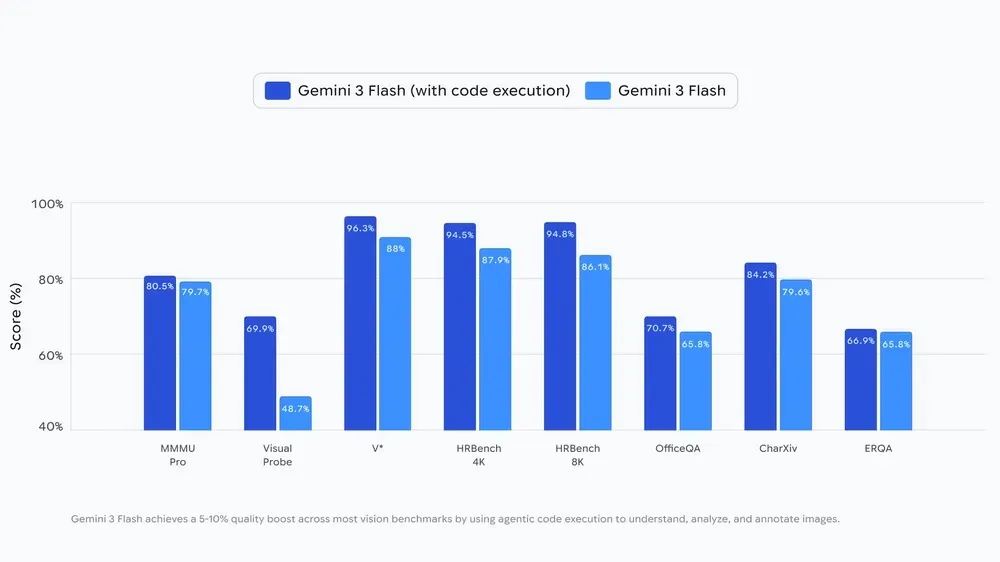

Google affirme qu’activer l’exécution de code avec Gemini 3 Flash apporte un gain de qualité « constant » de 5 à 10 % sur la plupart des benchmarks vision.

Ce que change Agentic Vision : de « je vois » à « je vérifie »

Google DeepMind résume le problème des modèles multimodaux classiques : s’ils ratent un détail fin — un numéro de série sur un micro-composant, un panneau lointain — ils sont forcés de deviner. Agentic Vision renverse la logique en traitant la vision comme un processus d’investigation : le modèle planifie, agit, puis ré-observe avec un nouveau contexte visuel.

L’enjeu n’est pas seulement la précision : c’est la capacité à réduire l’hallucination visuelle en remplaçant l’estimation probabiliste par des opérations contrôlables.

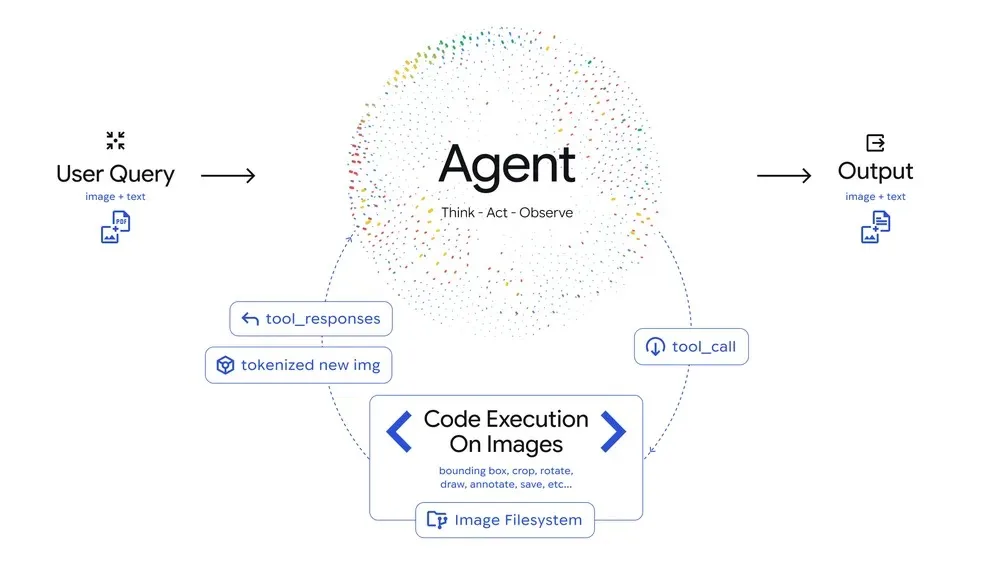

Comment ça marche : Think → Act → Observe ?

Google décrit une boucle itérative en trois temps :

- Think : le modèle analyse la question + l’image et établit un plan multi-étapes.

- Act : il génère et exécute du Python pour manipuler l’image (recadrage, rotation, annotation) ou l’analyser (comptage, calculs…).

- Observe : l’image transformée est réinjectée dans la fenêtre de contexte, et le modèle ré-examine les nouveaux éléments avant de conclure.

C’est une évolution importante : l’IA ne se contente plus d’être « multimodale », elle devient outillée, et donc plus proche d’un assistant technique capable de produire des réponses traçables.

Des cas d’usage très concrets : zoom implicite, annotations, « visual math »

Google illustre trois bénéfices immédiats :

- Zoom/inspection fine : Gemini 3 Flash est entraîné à « zoomer implicitement » quand c’est nécessaire. La société cite PlanCheckSolver.com, qui aurait gagné +5 % de précision en activant l’exécution de code pour découper et analyser des zones d’un plan (bords de toit, sections de bâtiment), puis les réinjecter au contexte.

- Annotation : au lieu de « décrire », le modèle peut dessiner des boîtes et étiquettes sur l’image pour s’auto-vérifier (ex : compter des doigts) — une sorte de brouillon visuel qui réduit les erreurs de comptage.

- Math visuelle & plotting : lecture de tableaux denses + normalisation + graphique Matplotlib, avec calcul déporté dans un environnement Python déterministe (et donc vérifiable).

On voit se dessiner une philosophie : quand la réponse dépend d’un détail, la meilleure stratégie n’est pas « raisonner plus fort », mais mesurer mieux.

API d’abord, app ensuite

Agentic Vision est disponible dès maintenant via l’API Gemini dans Google AI Studio et Vertex AI. Le déploiement démarre aussi dans l’app Gemini, accessible en sélectionnant l’option « Thinking » dans le choix de modèles.

Côté développeurs, Vertex AI documente déjà Code execution comme une capacité supportée par Gemini 3 Flash (preview), aux côtés du grounding et des system instructions.

La vraie rupture, c’est la « preuve » plutôt que la prose

Ce lancement raconte un basculement plus large : l’avenir des modèles visuels ne se jouera pas uniquement sur des scores, mais sur leur capacité à produire des réponses ancrées dans des opérations reproductibles (recadrage, comptage, calcul). Ce n’est pas un détail UX : c’est un changement d’épistémologie. Une IA qui peut montrer comment elle a vérifié une zone d’image se rapproche d’un assistant « professionnel » — utile en inspection, conformité, industrie, santé, assurance, architecture.

DeepMind le dit d’ailleurs sans détour : aujourd’hui le zoom est déjà très « implicite », mais des comportements comme rotation ou visual math demandent encore un « coup de pouce » — et Google travaille à les rendre automatiques, tout en explorant d’autres outils (web, reverse image search) et une extension à d’autres tailles de modèles.