Il y a des annonces qui ressemblent à des « produits ». Et puis il y a celles qui ressemblent à des mouvements d’échecs, joués en direct devant toute l’industrie. Ce 5 février, OpenAI a dégainé GPT-5.3-Codex, un nouveau modèle pensé pour doper Codex — son outil de « coding agent » — quelques minutes seulement après la sortie du nouveau Claude Opus d’Anthropic.

Le détail est savoureux : selon TechCrunch, les deux labs devaient publier à la même heure, mais Anthropic aurait avancé son annonce de 15 minutes.

Derrière l’anecdote, le signal est clair : la bataille n’est plus « qui code le mieux », mais qui construit la meilleure usine à agents.

GPT-5.3-Codex : Une promesse : passer de « copilote » à « opérateur »

OpenAI présente GPT-5.3-Codex comme un saut qualitatif : Codex ne se limiterait plus à « écrire et relire du code », mais pourrait s’approcher de ce que font les professionnels « sur un ordinateur » — une manière d’insister sur la dimension agentique, c’est-à-dire la capacité à enchaîner des actions, utiliser des outils, et tenir une tâche dans la durée.

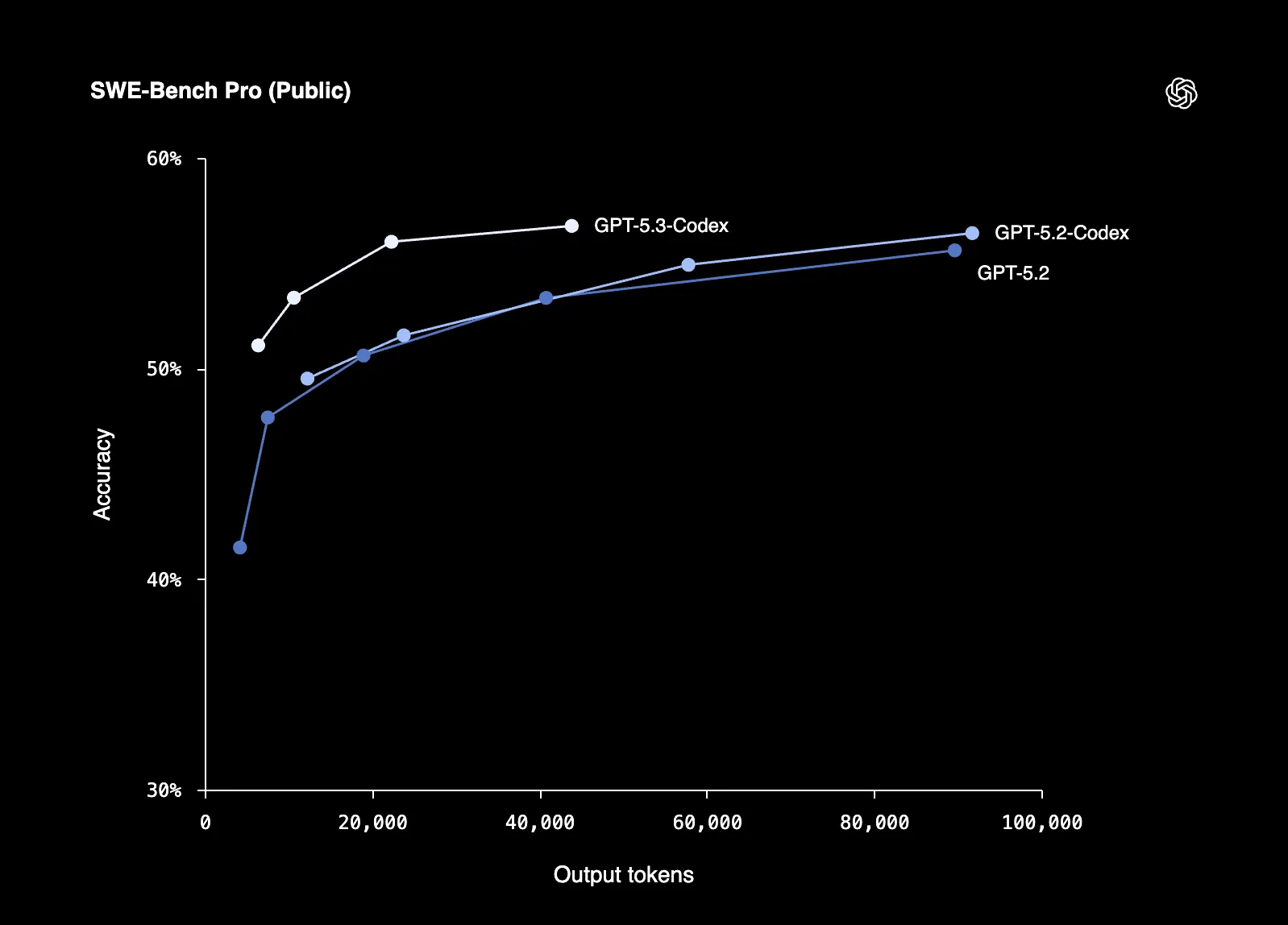

Dans son article officiel, OpenAI résume l’objectif : combiner la performance « coding » de GPT-5.2-Codex avec davantage de raisonnement et de connaissances pro… tout en étant 25 % plus rapide pour les utilisateurs Codex.

La page « changelog » développe la philosophie : davantage de réactivité pendant l’exécution, plus de retours de progression, et une meilleure capacité à se laisser « piloter » en temps réel.

Le vrai marqueur : vitesse + endurance, plutôt que « qualité brute »

Le nerf de la guerre, c’est le temps.

Là où les assistants classiques brillent en micro-tâches (autocomplétion, snippet, refactor ciblé), OpenAI veut faire basculer le workflow vers une logique de délégation : on confie un module, une feature, voire un mini-produit, et on supervise. Cest une logique déjà entendu lors du lancement de l’application Codex sur macOS, pensé comme un « command center » pour faire tourner plusieurs agents en parallèle.

GPT-5.3-Codex s’inscrit exactement dans cette trajectoire : moins de friction, plus de parallélisation, et surtout une promesse implicite — transformer le développeur en manager d’agents plutôt qu’en exécutant.

« Instrumental in creating itself » : la phrase qui cherche à frapper fort

TechCrunch relève un autre élément très « Silicon Valley » : OpenAI affirme que GPT-5.3-Codex est le premier modèle qui a été « instrumental » dans sa propre création, via des versions internes utilisées pour le debug et l’évaluation.

Il faut lire ça pour ce que c’est : un marqueur de maturité (l’outil devient assez fiable pour participer au cycle de dev), mais aussi un message marketing destiné à l’écosystème enterprise : ce modèle n’est pas un prototype, c’est déjà une machine de production.

Face à Anthropic : deux visions, un même terrain

Anthropic, de son côté, pousse Claude Opus 4.6 vers la polyvalence knowledge work (docs, tableurs, présentations) et surtout vers le multi-agent via ses « agent teams », avec un contexte pouvant monter à 1 million de tokens (en bêta).

OpenAI répond moins par un « concept » que par un upgrade de cadence : plus rapide, plus endurant, mieux intégré au pilotage (app, workflows). On sent une course qui se déplace : du modèle au produit, puis du produit à la plateforme.

La vérité, c’est que cette guerre se joue comme une guerre de systèmes d’exploitation : celui qui rend les agents naturels dans le flux de travail gagne — même avec un modèle « simplement très bon ».